- 1如何使用 pyinstaller 将 python3 文件打包成可以执行的 exe 程序_pyinstaller - f - ntest _ exetest . py ",

- 2基于Python爬虫广东广州水酒店宾馆数据可视化系统设计与实现(Django框架) 研究背景与意义、国内外研究现状

- 32018年人工智能之自动驾驶研究报告_navlab-5

- 4NLP实战:基于Pytorch的文本分类入门实战_build_vocab_from_iterator

- 5最近学习的一点感想(关于 Flask、Django、SpringBoot)_flask和springboot哪个难

- 6NLP(六十六)使用HuggingFace中的Trainer进行BERT模型微调

- 7AWS-EKS 给其他IAM赋予集群管理权限

- 8用chatglm实现code interpreter_self.model = automodel.from_pretrained(model_path

- 9每次看到她写的代码,我都感到自己无比平庸_justine tunney

- 10GPT-4强到离谱,OpenAI首席科学家:开源并不明智,我们错了!

计算机视觉是否已经进入瓶颈期?_计算机视觉瓶颈

赞

踩

作者:周博磊

链接:https://www.zhihu.com/question/51863955/answer/127888709

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

其实这个问题也是我近段时间一直在思考的问题. 昨天刚在组里做了个ECCV'16 Recap, 整理一下思路, 来尝试抛砖引玉.

我的观点是:计算机视觉在人工智能和深度学习的大背景下方兴未艾.

这里进入瓶颈期的,可能是一些计算机视觉的经典问题,如物体识别和检测(人脸,行人,物体,场景 etc).但是如果能死磕这些经典问题,往往能带来质的突破,比如说对于ImageNet物体识别GoogLeNet之后,大部分人应该都不会想到还有ResNet这种牛逼网络的出现:).计算机视觉这个领域本身,我觉得是正在蓬勃发展, 经典问题得到了更好的解决, 新的问题也不断涌现.

如果把Deep Learning进入CV的2012年作为新时代的开始,我自己是从旧时代来的人.对于从旧时代过来的人,现在无疑是CV以及AI最好的时代.我自己当年是看着Dahua Lin的blog,以及

和

在SJTU饮水思源AI版的论战进入CV和AI研究圈子的(这里特别感谢三位师兄当年的分享),那时候大家讨论的东西都是graphical model, sparse coding, bag of SIFT, spatial pyramid 啥的,也没有工作抢着放arXiv的传统,也没有满大街的open source libraries. 每年CVPR接收的论文到现在的1/2都不到. 每次开会前proceeding放出来的时候都会沐浴更衣把大部分感兴趣的论文扫一遍.

现在的CV和AI研究其实是变得越来越扁平快了.随手可得的open source libraries和pretrained models, 互联网上各种分享的学习资料和经, 便宜的GPU计算资源, 以及百花齐放的研究方向,都使得新入行的生猛年轻人能很快倒腾出新东西. 发表CVPR, NIPS, AAAI等顶会文章也不再是难事. 论文数量和研究方向也是繁多. 已经很难follow.

现在很多时候, 我觉得做CV的研究更像是在拼工程能力, 而不是拼insight和积累了. 后来的人也许并没有多少动力和精力去学习和了解之前的经典. 这也是我担忧的地方. 但时代造人, 这些也是无可厚非的, 毕竟我们希望更多有闯劲的年轻人进入CV和AI圈子, 一起大炼钢:). 争先放arXiv, 开源code等无疑加速了研究的迭代速度, 有更大的可能性激发出新的研究方向和成果. 大公司们(Google, Facebook, Amazon)以及诸多startup们, 也都虎视眈眈地渴望着更多更好的研究工作出现.

另外, 如果硬要我说几个CV目前有肉容易啃的方向, 那我就大致提提(注:这些方向大致都偏纯学术,有什么商业价值我并不是怎么关心):

1. Robotics (or Simulation Graphics)+Vision. Robotics那边的人普遍比较保守, 更执着于传统template matching之类的传统方法. 这里有个段子, 我们MIT机械工程系robotics方向的大牛教授John Leonard很久以前评论Computer vision, 直接说你们'CVPR'里面的各种论文, 就是Computer Vision and Precision Recall. 什么意思大家应该能理解:). 不过在deep learning开始真正work的时代, 他这句话应该不太适用了(笑). 回到正题, Robitics本身是块非常大的饼, 很多问题和方法都可以用deep learning (CNN + Deep Reinforcement learning) 重新解决. 偏Robotics的话, 大家可以留意一下Berkeley的大红人Sergey Levine最近的工作(Sergey Levine). 偏Vision的话,可以看看CMU的大红人Abinav Gupta的ECCV paper Curious Robot (https://arxiv.org/pdf/1604.01360v2.pdf). Jianxiong Xiao之前主打的3D deep learning (http://robots.princeton.edu/talks/2016_MIT/RobotPerception.pdf)也可以算在这个里面,他们团队和MIT团队最近搞了个Amazon Pick challenge, 模型和方法还有点意思(MIT-Princeton Vision Dataset for the APC 2016). 不过Xiao已经下海经商, 不知道还会不会actively publish. 现在各大公司和startup猛搞的autonomous drive, 也可以放在这个方向之下.

最近我还留意到一个非常有潜力的方向Simulation+Vision. 我觉得有两个具体方向,一个是利用graphics里面的rendering仿真技术,生成大量数据.这些数据因为是生成出来的,任何ground-truth都有,而且要多少有多少, 是获取训练数据的一个捷径.CVPR'16有篇做synthetic image dataset for semantic segmentation of urban scene(http://www.cv-foundation.org/openaccess/content_cvpr_2016/papers/Ros_The_SYNTHIA_Dataset_CVPR_2016_paper.pdf).另外一个方向是结合graphics中的simulation,利用deep reinforcement learning等active learning的算法可以无监督/弱监督训练出agent model,这里就不仅限于纯CV了.DeepMind和OpenAI在猛搞这个方向.偏vision的话大家可以参考下Allen Institute这篇(https://arxiv.org/pdf/1609.05143v1.pdf).

2. Generative visual models. 目前大部分的模型都是discrminative model, 给定input, 然后识别label. 但这个故事的另外一半其实是generative model, 给定label, 然后生成图片. generative models是一个很有潜力的大方向. 这里的最新进展一方面是基于GAN (https://arxiv.org/pdf/1511.06434v2.pdf) 所带来的一种训练图片生成的新思路, 也包括一些基于传统image model, 如MRF和CRF在deep learning的新思路下面进行重新理解. DeepMind的这篇PixelCNN(https://arxiv.org/pdf/1606.05328v2.pdf), 最近Zhirong和Dahua的挺不错的ECCV论文(http://dahua.me/papers/dhlin_deepmrf.pdf). 个人觉得Varionational Autoencoder也是个蛮漂亮的模型, 这里有篇关于VAE的最新的tutorial还不错(https://arxiv.org/pdf/1606.05908v2.pdf). 以后deep learning跟bayesian model的结合也会是个颇具潜力的方向.

3. Multimedia Computer Vision. 其实人的感知系统本身就是多模态的, 视频和声音共同结合.Video analysis不再局限于action recognition, 对内容本身有更深的理解. 比如说最近的MoiveQA (MovieQA), Visual Anticipation prediction (http://web.mit.edu/vondrick/prediction.pdf

). 另外, sound也是一个大家普遍忽略掉的一个东西. 大家可以看看我们组Andrew Owen的两个蛮有意思的工作ECCV'16 Ambient Sound Provides Supervision for Visual Learning (https://arxiv.org/pdf/1608.07017.pdf), CVPR'16 Visually Indicated Sounds (Visually Indicated Sounds). 多模态来研究vision是个大趋势.

作者:文刀叉点

链接:https://www.zhihu.com/question/51863955/answer/336990485

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

2018年再重新来看这个问题,其实离瓶颈还早得很

你说的瓶颈,拆分成两方面,一是说技术上暂时找不到新突破口,一是说应用上没啥可做的

CV其他领域我不清楚,但光是视频这一个子分支,都是大有可做的东西。

应用领域不多说,视频目标的检测、视频内容的识别、视频摘要、视频预测、还有视频分割等等非常多的领域。

现在视频方面,无论是应用还是技术其实潜力都非常大。

其实单说静帧图像,都还存在挺多的技术问题没有彻底攻破

当从静态RGB维度上升一维到了时空域的时候,面临的问题指数级上升。

而且,视频的东西,处理起来其实很有实际意义的。

从安全角度说,在海量视频里想要高精度的检测出某人或是某种特定模式

从一般视频网站角度说,希望可以更精准的对用户进行推送。

其实一般用户打的tag是根本不够用的。

最理想的情况是在语义级别分析出视频里面具体的内容,然后再从语义级别建模推送,而不仅仅只是tag之间的关联。

我个人感觉网易云音乐的推送其实做的还行,但那毕竟处理的只是音频波形的信号。

视频里,音频都只是它数据的一个小部分。

当然,从实际处理技术上来说,深度学习主要在视频上发挥作用的应该是多路cnn和lstm以及两者结合。

即便2014年two-stream提出来过了这么多年了

现在最有效的方法始终离不开dense trajectory以及hof、mbf这几个描述子。

~

当然,未来视频应用这一块还有一个很大的分支就是检索。

如何高效的利用几张图片或者gif去检索视频文件,这些也都是可以做并且有实际意义的东西。

~

我印象中,应该也有国际团队在做语义模糊搜索之类的东西。

就比如说你根本不是输入关键词比如“赛车、拳击”去检索一个视频文件。

而是输入一段模糊的短句,比如“某人和某人打了一架,然后某人被警察带走了”,以此去检索视频。

这个其实就是跨领域的视频相关的工作了

需要将文字(语音)以及图像的特征投射到一个统一的域去进行处理。

~

从我看的这几年的情况来看

视频方面,尤其是远机位的视频处理上,始终都还是使用范围比较有限的dataset,一旦跨库之后非常不鲁棒

然后基于视频质量的一些工作也可以做(质量评价、低码率处理),基于视频处理的一些工作也可以做(风格转换、去雾、去模糊)

~

注意我说了这么一大圈,其实这还只是视频这个子分类。

CV的范围远比这个大。

我记得在2017年NV的黄老板开的一次开发者大会的时候

他就说他们把DL也应用到了计算机图形学的领域里面去

利用gan网络,在一些渲染区域里可以减少渲染的运算量,但是达到人眼难以分辨的效果。

相信未来,joint这一个分支相关的一些视频工作,也可以和计算机图形学挂钩,输出成果或者逆输出成果。

其实最近两三年,我就看过好几篇用3d建模生成360度样本去做数据增广的工作了。

~

东拉西扯了好多,我感觉应用的瓶颈是不存在的,科学家很贪心的,他们什么都想实现。

但是技术的瓶颈,其实目前前沿科学里也远没有真的把硬件以及算法做到做不下去。

只不过随着一些行业巨鳄的进入,有些研究可能会变得不那么平易近人了。这倒是真的

"Once you solve cameras for vision, autonomy is solved; if you don't solve vision, it's not solved… You can absolutely be superhuman with just cameras." - Elon Musk

---

先说同意的部分:

长远来看,未来(作为落地的产品的)自动驾驶、机器人等等,camera 应该是其上层感知主导。而现在距此阶段可能还有一定距离。

再说不同意的部分:

即使上层的感知完全解决了,autonomy (如自动驾驶、机器人等)也还是有非常多的其它问题的,包括中层决策层的问题,以及下层执行层的(新)问题;而且很多问题需要把感知层和决策层乃至执行层一起考量。只不过这些问题现在可能被上层感知的问题掩盖了。

一己之见,仅供参考~

作者:小心假设

链接:https://www.zhihu.com/question/51863955/answer/531002861

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

作者:Jacky Yang

链接:https://www.zhihu.com/question/51863955/answer/157495559

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

关于计算机视觉的前景,尤其是算法层面上,

已经讲得挺好了。这里我只想从应用和产品的角度补充一下。

先说结论:由于近几年深度学习的发展,计算机视觉应用的前景广阔。而且越来越多的应用场景被挖掘出来。

要说瓶颈,计算机视觉其实已经有过好几轮了,关于这一点,各位有时间的话,可以看看去年我在将门创业加速器的一个分享:

视频点播:

ppt:

https://pan.baidu.com/s/1bptDykZ

我分享的所有内容,都是我自己原创,觉得不错的话,麻烦回来点个赞哈:)

这里也很推荐大家看看将门其他嘉宾的分享,干货还是很多的:

加入将门技术社群,与5000位CV、机器人、NLP、机器学习领域的专业人士切磋交流 - 知乎专栏

回到正题,由于算法准确度和理论的不断提高,很多垂直领域的需求也逐渐被提出来,有很多甚至是比较”奇葩”的应用。举个例子:前一阵子有人提了一个需求:通过图像自动识别下图中木材的数量。这样车辆每次经过,就不用那么费劲用人工去数了。

目前来看,要做到高准确度,难度依然不小,但至少还是很有希望的。这要放在几年前,可能大家都不敢想象。

其实我举这个例子,就是想说明一点,计算机视觉的应用非常多,远没达到饱和的地步,算法在提高的同时,更具挑战性的应用也会被提出来,这是相辅相成的。人脸,车牌/车型以及物体分类跟踪是当前比较受关注的应用,包括很多明星企业,也主要是做这个领域,但其实这只是一小部分而已。还有其他更有价值的领域,比如产品缺陷检测,雷达图像分析,医学图像分析(比如癌细胞早期筛查)等等,太多了就不展开细讲了。即便是大家耳熟能详的人脸识别,其实也有很多细分领域的应用等着去挖掘。

如果说2012年到现在的五年当中,计算机视觉进入了技术快车道的话。那么接下来,很显然重点应该是如何让飘在半空的计算机视觉技术与需求落地了。

作者:卢策吾

链接:https://www.zhihu.com/question/51863955/answer/127982867

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

我很同意博磊的看法,计算机视觉在人工智能和深度学习的大背景下方兴未艾。如果我们站在人工智能的big picture上看,在迈向强AI的路上,vision还有太多的东西可以去开拓了。

举个例子:

博磊特别提到的Robotics (or Simulation)+Vision,我见到北美几个组热火朝天地搞起来了(比如我好朋友Yuke做的https://arxiv.org/pdf/1609.05143v1.pdf)。

我感觉这是往强AI方向的升级。以前,vision一直都在做“let machine see like human”。现在,开始思考“let machine act like human”(大家想想,这显然更AI,能干更多的事情啦)。

以前是 “see“这个基础都没有,机器就是一个瞎子,让它“act like human”就很不靠谱了。现在因为深度学习,基本具备“see”这个条件后,自然有一批visioner去琢磨这件事了。这对vision也就提出新的挑战,同时学习perception和how to act。deep reinforcement learning 刚好就是干这个事的,所以关注的人也很多,也很work,我自己也在无人车仿真玩过,效果真不错(当然做到真正强AI, deep RL目前也有自己的缺陷)。

想想baby 的学习过程中 , 学习perception和how to act是相互伴随,互相促进的。这样也会使perception的档次提高,目前的object detection and segmentation,对应到人类语言语义大概是名词级别的语义,是非常浅的,接下来还有动词,短语级别,句子级别 ,故事级别。如果机器完全理解了how to act,会很大程度地帮助我们获得更深层的perception。当然,深语义的perception也帮助了how to act。Deep reinforcement learning 比传统reinforcement learning好,就是因为perception 更好了。

为什么是simulation+vision呢?因为要在真实世界里学习how to act成本太高了(找个机器人来不停试错不现实)。所以一条路就是create strong AI in virtual world, thus apply in real world。从研究角度来讲,simulation+vision to create stronger AI就是成为第一步,后面apply to real world还有一大堆问题可以探索的。要是做好了按在各种机器人上让它自主干活,那就是威力巨大了(从AI角度看,无人车算是简单的机器人吧),估计也是不小的产业。

以上只是一个例子而已(也是一个尝试),我想说的我们在解detection和segmentation这些传统问题同时,作为研究者,不妨也站在整个大AI的背景下看看,想想vision和DL如何面向强AI,迈一小步,再迈一下步,再迈一小步…….

作者:微软亚洲研究院

链接:https://www.zhihu.com/question/51863955/answer/154570691

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

近几十年来,计算机视觉技术从研究领域到工业应用领域,已从最初的冷门发展到今天的炙手可热。在微软亚洲研究院建院之初,计算机视觉应用非常少,很冷门,然而微软亚洲研究院成立的第一个研究小组却是视觉计算组。

视觉计算组由优秀的研究员和工程师组成,他们的专长涵盖了计算机视觉研究领域的整个范畴:从数学理论到现实应用,从物理系统到软件开发,从低层次的图像处理到高层次的图像理解。该组的研究成果已经对许多重要应用产生了深刻影响,例如人脸检测、追踪、识别,图像搜索,物体检测、追踪、识别,以及机器人避障和导航。

关于这个问题,我们很乐于给出自己的见解。

————这里是正式回答的分割线————

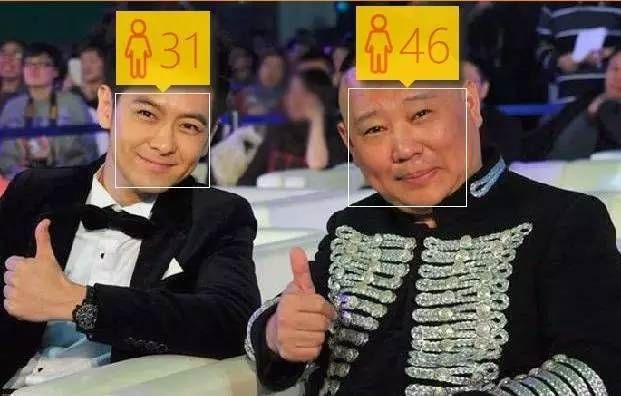

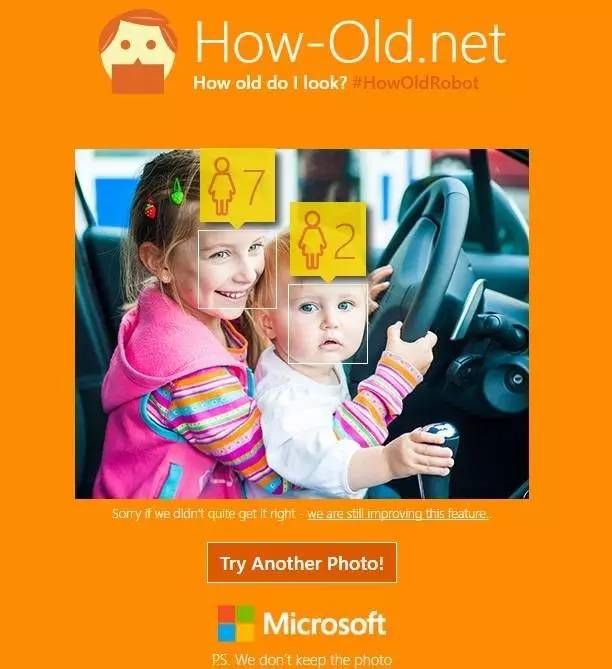

在一个网页上上传自己的照片,让电脑判断自己照片中看起来的年龄,这款名叫http://How-old.net的应用在2015年红爆了社交网络,一时间刷爆了各个社交网络平台,在全球风靡,即使是平常对自己外貌再不关心的人也不介意花上一分钟测测自己照片中显示出来的年纪,虽然结果并没有百分之百的准确,但是科技与诙谐结合带来的新鲜感,让众多网友对这个简单的应用爱不释手,也让不少人对计算机视觉技术产生浓厚的兴趣。

这款应用是微软Build 2015开发者大会的衍生品,据说是两个技能爆表而又闲得无聊的工程师用了两天的时间,基于Azure云里的微软认知服务 Face API 等API识别照片中的人脸和特征,实现了整个应用的功能。

1.从获取图像到读懂图像

计算机视觉是从图像和视频中提出数值或符号信息的计算系统,更形象一点说,计算机视觉是让计算机具备像人类一样的眼睛,看到图像,并理解图像。

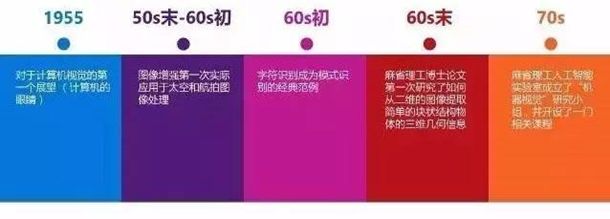

在计算机起步阶段,就有人觉得计算机应该具备“眼睛”,能够看能够理解。20世纪50年代末,图像增强第一次应用在对太空和航拍图像进行处理方面,人们开始发现计算机视觉真的可以应用。60年代初,模式识别在计算机视觉领域得到广泛的应用,例如字符识别等应用成了模式识别的经典应用。到了60年代末,有个麻省理工的博士生第一次从图像中提取出三维信息,把一个实体的物体从二维图像中提出来。随后,麻省理工学院在70年代成立了机器视觉的研究组,并且开设了相关的课程。

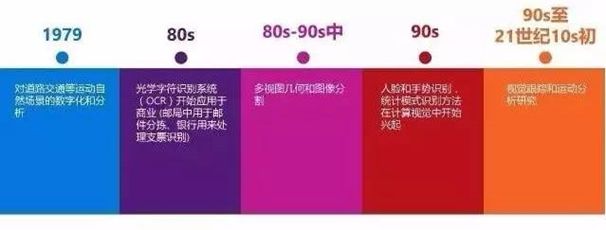

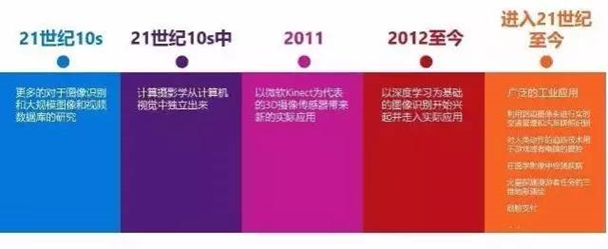

从70年代到现在,40年间计算机视觉得到迅速地发展,许多计算机视觉的应用出现在了生产生活领域,例如对道路交通等自然场景进行数字化分析、OCR应用在邮局分拣信件以及手写体的支票、人脸识别的门禁……期间,多视图几何和图像分割、视觉跟踪和运动分析、大型图像和数据库等研究对计算机视觉起了很大的推进作用。到了2011年,人们才真正发现计算机视觉的巨大商业价值,这一年以Kinect为代表的3D摄像传感器出现在公众的视野内,人们发现计算机不仅能看见,能够理解动作并实时做出反应。

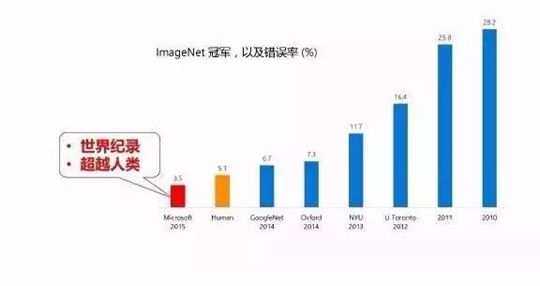

然而,计算机识别的准确性始终是计算机视觉应用的瓶颈,直至2012年,基于深度学习的图像识别技术出现,极大地提高了计算机视觉的识别精确度。这些算法的可靠性促进了工业界的应用,比如车牌识别、游戏中的动作追踪、疾病监测等。

2.深度学习变革图像识别领域

在2012年深度学习技术出现后,识别的错误率有了突变性的改变,但是错误率降到一定阶段之后,再降下去就非常困难了。而且,计算机难以跟上环境变化的节奏,一旦光线和角度等环境因素发生变化,就会误识。以人脸为例,最初研究者试图将人脸想象成一个模板,用机器学习的方法掌握模板的规律,然而人脸虽然看起来很固定,但角度、光线、打扮不同,样子就有差别,令模板难以匹配所有人脸。人脸识别的核心问题在于,如何让计算机忽略同一个人的不同时刻的差异,又能发现两个人之间的差别。人工神经网络技术的引进是计算机视觉超越模板识别的关键。

2006年,有研究者发现多隐层的人工神经网络一方面具备更优异的特征学习能力,另一方面能通过逐层初始化克服机器学习的训练问题。但是,通常神经网络仅能做两三层,深度越深越不稳定,无法算出结果。2012年多伦多大学的研究者在神经网络研究有了一个新突破,将神经网络做到8层。2014年剑桥大学的研究者把深度升级到19层。2015年,微软亚洲研究院的研究员们基于残差学习,将深度提升到152层,凭借深度神经网络带来的准确识别能力,微软在2015的 ImageNet 大规模视觉挑战赛中以绝对优势获得图像分类、图像定位以及图像检测三个主要项目的冠军。

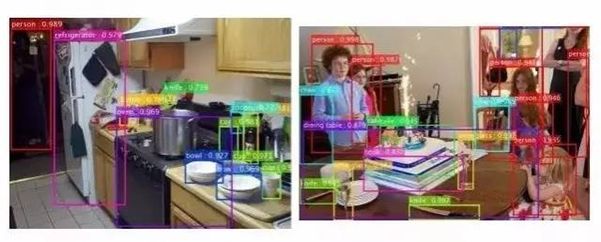

3.物体检测的新突破

在图像识别中,物体检测是人类从做计算机视觉开始便怀揣着的梦想——拿到一张图可以辨别里面有什么东西、在哪里?在微软的识别技术中,不仅能高准确度判断出有没有某件物体,判断出在什么位置,甚至还能达到像素级别的物体分割,将图像中的每一个像素属于哪个物体精确地识别出来。

物体检测=定位+识别

视频中的物体分割

4.未来:计算机视觉触手可及

http://How-old.net应用火爆社交网络之后,微软又推出了一款 “微软我们”应用,用户只要登陆“微软我们”网站,任意上传两张人物照片,就可以获知人脸的相似度。与此同时,更多基于计算机视觉技术的有趣应用也逐渐出现在公众的视野中:可以帮你找到和你长得相似的明星的应用CelebsLike、帮助你鉴别狗狗品种的应用Fetch、识别你的表情并用相应emoji表情代替的应用FaceHero……尖端的计算机视觉技术,正在以诙谐有趣的形象引起公众的兴趣,让公众轻松体验到其中的奇妙。计算机视觉不再是深藏楼阁的技术,而将在生活中随处可见,触手可及。

2015年5月初,微软正式公布了牛津计划(如今已融入微软认知服务中),这是一系列基于云端的与计算机学习相关的智能API、SDK和相关的服务被提供给开发者,开发者不再需要拥有繁复的机器学习等背景也能轻松开发出智能的包括计算机视觉在内的应用,让想法不再只是想法。

萨基博·萨科(Saqib Shaikh)是微软在英国团队的一位软件工程师,7岁就不幸失明,他凭借着自己的不懈努力,成为一位软件工程师。在微软工作时,他参与了微软正在研发阶段的人工智能项目:Seeing AI,这个项目帮助萨科“看见”和“了解”他眼前的世界。在展示视频中,当萨科滑动镜腿时,Seeing AI就可以识别出景象,并通过语音告诉萨科眼前是什么,例如公园中正在玩耍的人,会议室的空位,与会者的年龄、性别以及情绪,帮他读懂餐馆的菜单……这种科幻小说中才有的场景,正在逐渐被实现。这个充满人文关怀的应用,背后正是微软认知服务的开放API提供的强有力的支持。在诙谐之外,微软亚洲研究院的计算机视觉技术数十年的技术积淀已经在生活的方方面面展现出更加实在的价值,而这仅是开始。

————这里是回答结束的分割线————

感谢大家的阅读。

本账号为微软亚洲研究院的官方知乎账号。本账号立足于计算机领域,特别是人工智能相关的前沿研究,旨在为人工智能的相关研究提供范例,从专业的角度促进公众对人工智能的理解,并为研究人员提供讨论和参与的开放平台,从而共建计算机领域的未来。

微软亚洲研究院的每一位专家都是我们的智囊团,你在这个账号可以阅读到来自计算机科学领域各个不同方向的专家们的见解。请大家不要吝惜手里的“邀请”,让我们在分享中共同进步。

也欢迎大家关注我们的微博和微信账号,了解更多我们研究。

http://weixin.qq.com/r/PUliejrEzWeyrX4Z9xwv (二维码自动识别)

作者:优达学城(Udacity)

链接:https://www.zhihu.com/question/51863955/answer/462864383

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

本文作者:

Udacity CM(UBC/同济大学地球物理学博士)

- 利益相关,我已赶赴战场

take away notes!不是!

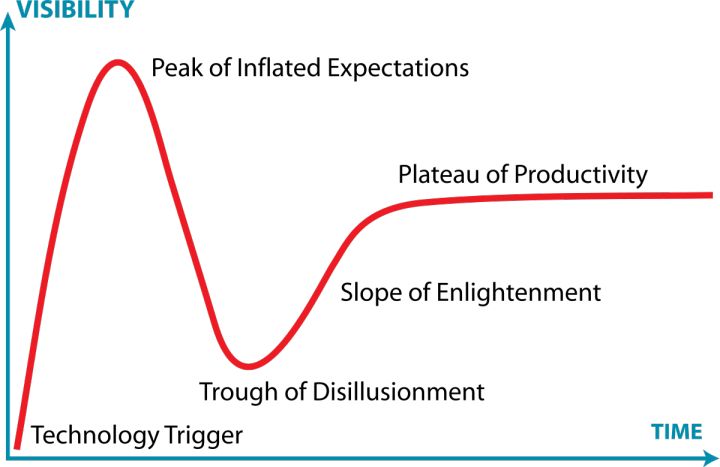

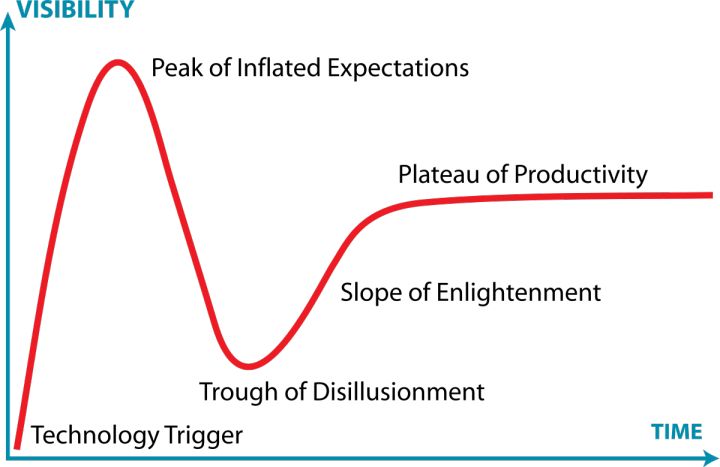

- 先贴一张图,看一下现在的技术发展曲线

技术发展曲线是说,一项技术从诞生到成熟需要经过各个不同的阶段,代表了社会对这项技术的认可情况。现在成功的一些互联网公司都是在这项技术(互联网)开始起步的时候开始建立的,比如 Google,Facebook 等。

如何来理解这个曲线,这个曲线是技术的整体发展历程。从技术的诞生,受到广泛关注,热议,进而被资本追逐、热捧,再经过一系列的发酵、泡沫之后,沉寂/冷却/沉淀,提炼出精髓之后,真正成为成熟、稳定盈利的应用。

Garnter公司是世界著名的咨询公司之一,他们每年7月份都会出一份技术发展评估报告。2017年的时候,Computer Vision还没有上榜(https://www.google.com.tw/search?q=gartner+hype+cycle+2017&source=lnms&tbm=isch&sa=X&ved=0ahUKEwid8omC6dXcAhWbIIgKHfQSDPoQ_AUICigB&biw=1366&bih=803#imgrc=13wttmqBHdaMnM:)。但是2018年的时候,这项技术已经被列为Slide into Trough的区间内(https://www.gartner.com/doc/3883863/hype-cycle-artificial-intelligence)。

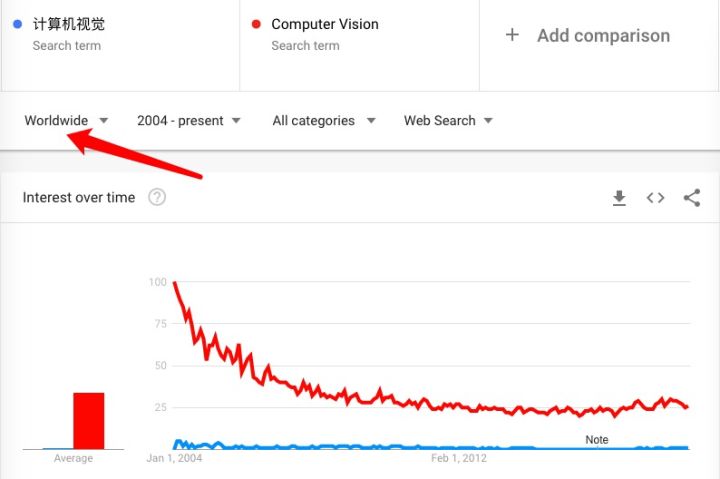

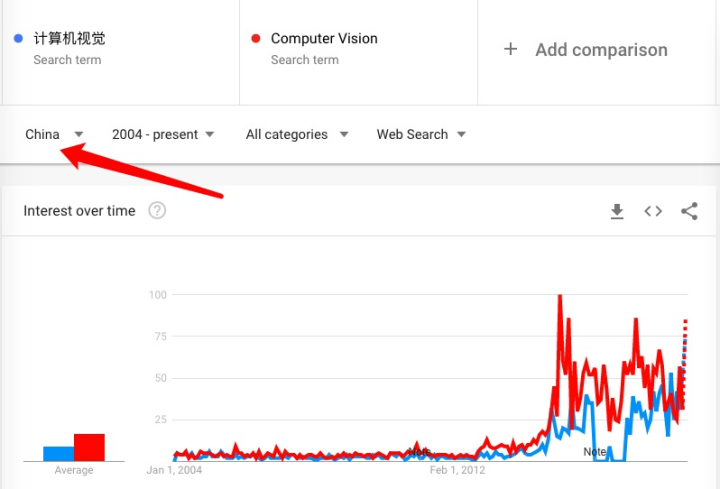

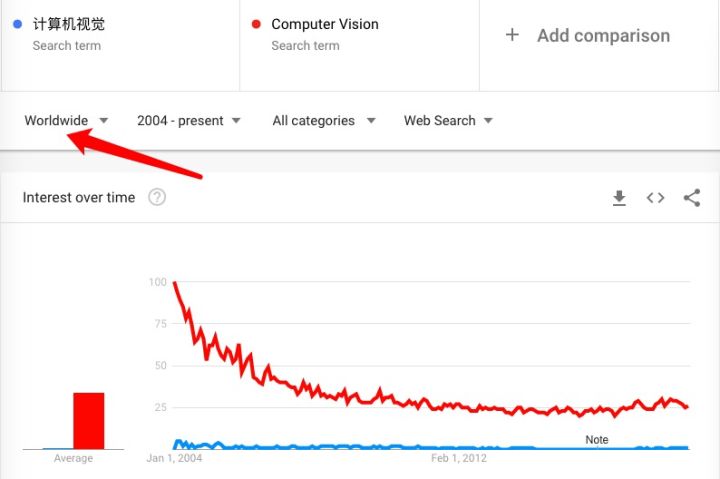

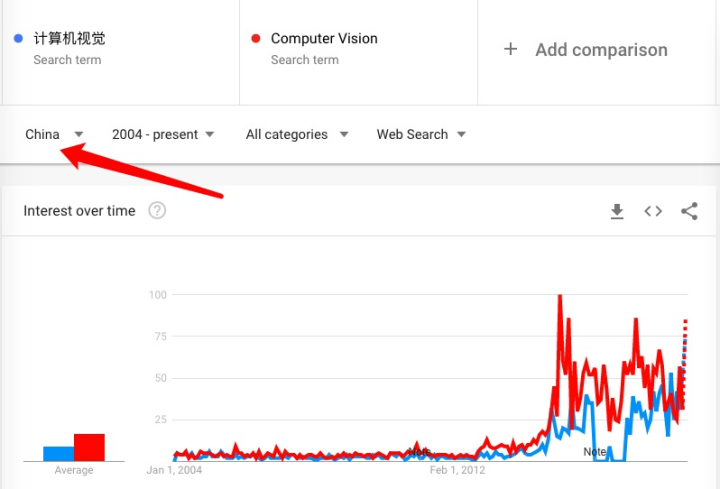

同时,也可以看到这个“计算机视觉”的搜索量在持续下降(来自网络搜索指数)。

但是!需要注意的是!这是 Worldwide,那么把目光投向中国!(同样取自网络搜索量)

OK,首先在中国范围内,计算机视觉(Computer Vision,后文称为CV)的确在持续发展。那接下来解释下全球的关注度下降的情况。

这里需要了解的一个背景是:深度学习拓展了计算机视觉运用的边界。最著名的一件事情是,2012年,Geoff Hinton 的博士生 Alex Krizhevsky、Ilya Sutskever 在 CV 竞赛 ImageNet 上,使用深度学习框架拿了第一名,打败了很多有丰富传统 CV 经验的人!在此之后,基于深度学习的框架层出不穷,如 ALEXNet,GOOGLeNet,RESNet,不断刷新了 CV 可以实现的识别精度。

因此当注意力转向 CV 的时候,需要从深度学习的三要素来看待这项技术,那就是,1)算法;2)算力;3)数据;

一. 算法层面

计算机视觉本身是是对于图像特征的提取,传统计算机视觉的发展从视觉的可视化效果,到颜色的滤波处理,再到后期的特征提取(无论是边界特征,还是阈值特征,或者是不同尺度的特征),都有一段时间的发展历史。

但是深度学习则在这个基础上,增加了算法的鲁棒性。

- (图)展示了跟 CV 有关的论文数量;

目前的 CV 的应用细化到具体的应用,

1)图像识别:ALEXNet,VGGNet,RESNet 等不同网络结构都能用于图像分类,在整个框架上不断深化,并增加互相层数之间的关系,不断提高深度网络的识别力。

2)物体定位:通过特征区域进行快速识别的 R-cnn 发表于 2015 年,2016 年上半年发表了 Fast-CNN,2016 年下半年发表的 Faster-CNN,以及另一个层级快速定位理论为 YOLO,在经过大量训练的基础上也可以快速的搭建起图像与物体对象的关系,目前已经可以快速的识别重叠或者不重叠的物体。

3)图像内容文本描述:CV 近期的发展,开始链接文本类的输出,努力将图像转化为文字说明;图像所承载的内容只有落到具体的文本上,才能转换成更为有效的载体。(因为图像里面所含的信息很难搜索,很难匹配,很难定位)

当把图像和文字间的隔阂打破,这个应用的场景就又拓展了一个层级。现有的应用已经可以把图像中的物体相对位置以及关键信息通过文字输出。

4)连续图像内容文本描述:进一步地,针对连续图像生成的视频信息,AI 可以 track 视屏中同一个物体的连续动作,并进行关键信息的提取。假设是一场足球赛的视频,AI可以直接提取出进球的部分,并可以像新闻播音员一样说出“xx,在 x 点 x 分接 xx 传球,绕过 xx,进行射门,球擦过门柱,守门员扑空,球进了!”

在这个深度挖掘的图像特征的基础上,大量的应用应运而生,催生出各种应用落地的场景。比如无人驾驶、比如人脸识别等。这可能也是 CV 本身的搜索量减少的原因,大家开始纷纷搜索更为细化的技术,而不是大方向的 CV。

二。算力层面

GPU 计算提高了 CPU 的算力,CUDA 等具体部署的实现,也帮助大数据的运算框架能够在不同的平台上运行。

云计算的实现,更是通过网络端使得许多 PC 端的算力大大提升。更不用提雾计算(使用网络边缘的终端设备),当零散的运算单元被重新组合在一起,能局部支持的运算算力也能得到极大的增强。

目前 nVIDIA 等芯片公司,AWS 等云计算公司在这方面不断的研发和进步,不断暗示着这一层面的发展潜力,更是为深度学习及 CV 的发展提供了支持。

(不得不说,硬件不是我的 area,欢迎大家拍砖)

三。数据层面

数据所遭遇的瓶颈其实最为严苛。深度学习/CV 都需要标定的大数据,在所有的数据中,从数字数据-文本数据-图像数据-语音数据,是逐渐减少的,而数据是深度学习/CV 精度的极大保障。可以说,提升数据质量远远比提升算法/算力对最终精度的影响更大。

但是也不需要过于担忧,数据工人/数据平台等创业公司的纷纷起步,其实在努力创造这种大数据的未来,如 Dbrain 等平台,就是通过平台来建立数据工人与数据需求之间的联系。而有极大人力资源的地区,这样的数据搬运也会有极大的市场。

从以上各个角度来说,这个发展趋势都是存在的!

最后的最后,

如果真要说有瓶颈的话,我更倾向于认为这是对于我们“个人”的瓶颈。当上述这些事情只有大公司/顶尖高校才能完成的时候(大公司/顶尖高校能够提供优质前沿资源学习,提供算力来测试及培训,提供数据来训练),计算机视觉本身在大公司/高校的推动下仍然是在不断的前进和发展的。但是,个人能够学习及接触到的门槛就变高了。数据和算力将会成为个人学习时的障碍,这个瓶颈将变成,个人很难触及到这些高精尖的资源。

我希望,教学资源不是象牙塔中的阳春白雪,希望每个人都可以得到公平学习的机会,不会让瓶颈阻挡每个人学习的道路。

#挑战不可能-优达学城

作者:优达学城(Udacity)

链接:https://www.zhihu.com/question/51863955/answer/462864383

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

本文作者:

Udacity CM(UBC/同济大学地球物理学博士)

- 利益相关,我已赶赴战场

take away notes!不是!

- 先贴一张图,看一下现在的技术发展曲线

技术发展曲线是说,一项技术从诞生到成熟需要经过各个不同的阶段,代表了社会对这项技术的认可情况。现在成功的一些互联网公司都是在这项技术(互联网)开始起步的时候开始建立的,比如 Google,Facebook 等。

如何来理解这个曲线,这个曲线是技术的整体发展历程。从技术的诞生,受到广泛关注,热议,进而被资本追逐、热捧,再经过一系列的发酵、泡沫之后,沉寂/冷却/沉淀,提炼出精髓之后,真正成为成熟、稳定盈利的应用。

Garnter公司是世界著名的咨询公司之一,他们每年7月份都会出一份技术发展评估报告。2017年的时候,Computer Vision还没有上榜(https://www.google.com.tw/search?q=gartner+hype+cycle+2017&source=lnms&tbm=isch&sa=X&ved=0ahUKEwid8omC6dXcAhWbIIgKHfQSDPoQ_AUICigB&biw=1366&bih=803#imgrc=13wttmqBHdaMnM:)。但是2018年的时候,这项技术已经被列为Slide into Trough的区间内(https://www.gartner.com/doc/3883863/hype-cycle-artificial-intelligence)。

同时,也可以看到这个“计算机视觉”的搜索量在持续下降(来自网络搜索指数)。

但是!需要注意的是!这是 Worldwide,那么把目光投向中国!(同样取自网络搜索量)

OK,首先在中国范围内,计算机视觉(Computer Vision,后文称为CV)的确在持续发展。那接下来解释下全球的关注度下降的情况。

这里需要了解的一个背景是:深度学习拓展了计算机视觉运用的边界。最著名的一件事情是,2012年,Geoff Hinton 的博士生 Alex Krizhevsky、Ilya Sutskever 在 CV 竞赛 ImageNet 上,使用深度学习框架拿了第一名,打败了很多有丰富传统 CV 经验的人!在此之后,基于深度学习的框架层出不穷,如 ALEXNet,GOOGLeNet,RESNet,不断刷新了 CV 可以实现的识别精度。

因此当注意力转向 CV 的时候,需要从深度学习的三要素来看待这项技术,那就是,1)算法;2)算力;3)数据;

一. 算法层面

计算机视觉本身是是对于图像特征的提取,传统计算机视觉的发展从视觉的可视化效果,到颜色的滤波处理,再到后期的特征提取(无论是边界特征,还是阈值特征,或者是不同尺度的特征),都有一段时间的发展历史。

但是深度学习则在这个基础上,增加了算法的鲁棒性。

- (图)展示了跟 CV 有关的论文数量;

目前的 CV 的应用细化到具体的应用,

1)图像识别:ALEXNet,VGGNet,RESNet 等不同网络结构都能用于图像分类,在整个框架上不断深化,并增加互相层数之间的关系,不断提高深度网络的识别力。

2)物体定位:通过特征区域进行快速识别的 R-cnn 发表于 2015 年,2016 年上半年发表了 Fast-CNN,2016 年下半年发表的 Faster-CNN,以及另一个层级快速定位理论为 YOLO,在经过大量训练的基础上也可以快速的搭建起图像与物体对象的关系,目前已经可以快速的识别重叠或者不重叠的物体。

3)图像内容文本描述:CV 近期的发展,开始链接文本类的输出,努力将图像转化为文字说明;图像所承载的内容只有落到具体的文本上,才能转换成更为有效的载体。(因为图像里面所含的信息很难搜索,很难匹配,很难定位)

当把图像和文字间的隔阂打破,这个应用的场景就又拓展了一个层级。现有的应用已经可以把图像中的物体相对位置以及关键信息通过文字输出。

4)连续图像内容文本描述:进一步地,针对连续图像生成的视频信息,AI 可以 track 视屏中同一个物体的连续动作,并进行关键信息的提取。假设是一场足球赛的视频,AI可以直接提取出进球的部分,并可以像新闻播音员一样说出“xx,在 x 点 x 分接 xx 传球,绕过 xx,进行射门,球擦过门柱,守门员扑空,球进了!”

在这个深度挖掘的图像特征的基础上,大量的应用应运而生,催生出各种应用落地的场景。比如无人驾驶、比如人脸识别等。这可能也是 CV 本身的搜索量减少的原因,大家开始纷纷搜索更为细化的技术,而不是大方向的 CV。

二。算力层面

GPU 计算提高了 CPU 的算力,CUDA 等具体部署的实现,也帮助大数据的运算框架能够在不同的平台上运行。

云计算的实现,更是通过网络端使得许多 PC 端的算力大大提升。更不用提雾计算(使用网络边缘的终端设备),当零散的运算单元被重新组合在一起,能局部支持的运算算力也能得到极大的增强。

目前 nVIDIA 等芯片公司,AWS 等云计算公司在这方面不断的研发和进步,不断暗示着这一层面的发展潜力,更是为深度学习及 CV 的发展提供了支持。

(不得不说,硬件不是我的 area,欢迎大家拍砖)

三。数据层面

数据所遭遇的瓶颈其实最为严苛。深度学习/CV 都需要标定的大数据,在所有的数据中,从数字数据-文本数据-图像数据-语音数据,是逐渐减少的,而数据是深度学习/CV 精度的极大保障。可以说,提升数据质量远远比提升算法/算力对最终精度的影响更大。

但是也不需要过于担忧,数据工人/数据平台等创业公司的纷纷起步,其实在努力创造这种大数据的未来,如 Dbrain 等平台,就是通过平台来建立数据工人与数据需求之间的联系。而有极大人力资源的地区,这样的数据搬运也会有极大的市场。

从以上各个角度来说,这个发展趋势都是存在的!

最后的最后,

如果真要说有瓶颈的话,我更倾向于认为这是对于我们“个人”的瓶颈。当上述这些事情只有大公司/顶尖高校才能完成的时候(大公司/顶尖高校能够提供优质前沿资源学习,提供算力来测试及培训,提供数据来训练),计算机视觉本身在大公司/高校的推动下仍然是在不断的前进和发展的。但是,个人能够学习及接触到的门槛就变高了。数据和算力将会成为个人学习时的障碍,这个瓶颈将变成,个人很难触及到这些高精尖的资源。

我希望,教学资源不是象牙塔中的阳春白雪,希望每个人都可以得到公平学习的机会,不会让瓶颈阻挡每个人学习的道路。

#挑战不可能-优达学城

作者:罗韵

链接:https://www.zhihu.com/question/51863955/answer/129575446

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

前面的几位高票的回答都回答得很好,作为游走在AI研究和CV工业界的青葱少年,还是想来回答一下这个问题,这个问题其实是一个很好的思考题。

瓶颈不在于应用,而在于创新。计算机视觉结合深度学习,在当下,特别是工业界基本上“所向披靡”,但是大部分的应用并没有太大的创新性可言,可以说都是工程问题+tricks,这样的结果就是使得当下计算机视觉的创业和行业发展繁盛,但是深入思考,这样对技术发展却并没有太大的利处。

瓶颈不在计算机视觉,而在人工智能。同意前面答主的观点,CV的未来更多的还是要研究方法,研究如何智能,单单局限于CV,显得过于应用,当下在论文阶段,AI其实有非常多的新进展,众所周知的生成对抗网络,无/半监督学习,迁移学习等等,创新的方法层出,只是还没有到可以成熟应用的阶段。

瓶颈不在于工具,而在于人才。深度学习、机器学习、计算机视觉和人工智能的应用工具和开源工具非常的丰富,基本上编程能力有一点积累的,运用其中的工具都可以完成自己的算法实现,我曾经觉得这个想法是正常的想法。不过在接触了很多国内的同学甚至是研究生之后,莫名的失望,不想说吐槽教育的问题,但是大部分同学只知道现在做CV前景好,发展好(Maybe),但是却没有关注到自己的能力的提升。

总而言之,还是希望CV能继续高歌发展,在工业界为大家解决更多实际的问题,在学术界有更多创新想法层出,毕竟我的工作是为大家创造一个更开阔的CV平台。

作者:OSCHINA

链接:https://www.zhihu.com/question/51863955/answer/1458876702

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

20 世纪 50 年代和 60 年代,计算机视觉并没有被看成重头戏,人们认为视觉系统很容易复制,而教计算机下棋更加困难。

但是现在,AlphaGo 已经击败围棋冠军,IBM Watson 也在 Jeopardy 中击败人类竞赛者,而大多数计算机视觉软件最多只能完成 3 岁儿童的任务……

理论与实践不断证明,人类视觉神经非常复杂,计算机视觉实现并非易事。计算机视觉研究从上世纪 50 年代兴起之后,也历经了狂欢、冷静,又重新燃起希望的阶段。

本篇编译整理自计算机视觉相关文章,介绍计算机视觉各阶段的理论支撑与外部舆论变化。

一、最早的人工智能想象

大多数人都认为,是现代人创造了人工智能的概念,实际上远古祖先也提出了思考型机器人的理论。

大约3000年前,荷马描述了火神赫菲斯托斯(Hephaestus)的故事。赫菲斯托斯用黄金塑造了机械侍女,并赋予她们理性和学习能力。

在无人驾驶汽车问世之前的几个世纪,古希腊作家阿波罗纽斯(Apollonius)用想象力创造了塔洛斯(Talos),这是一个青铜自动机,负责保卫克里特岛。

但这些历史性的叙述并不能准确描述当今正在开发的人工智能的种类。因为尽管现在大多数人工智能程序无法将其目标任务之外的知识概括化,但是对于本身给定的预期,他们已经达到或超过人类水平。

二、人的视觉与计算机视觉

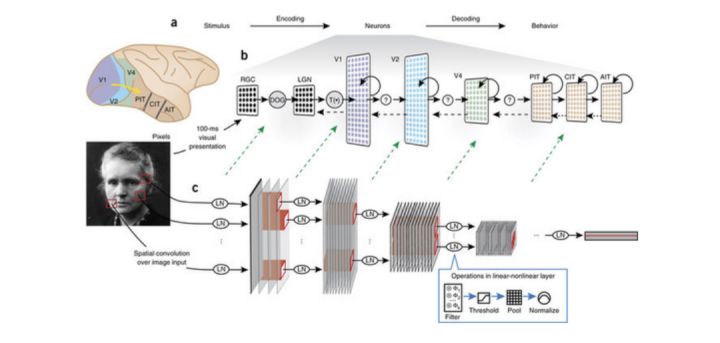

人类视觉系统非常特别,超过50%的神经组织直接或间接地与视觉有关,其中超过66%的神经活动仅为处理视觉。今天人们对视觉、知觉的了解大部分来自1950年代和1960年代对猫进行的神经生理学研究。

上世纪50年代初期,哈佛医学院的两位神经科学家 David Hubel 和 Torsten Wiesel 在猫的视觉皮层上进行了一项实验。通过研究神经元对各种刺激的反应,两位科学家观察到,人类的视觉是分级的。

神经元检测简单的特征,例如边缘,然后输入更复杂的特征,如形状,最后再输入更复杂的视觉表示。基于这些知识,计算机科学家就可以专注于以数字形式重建人类神经结构。

三、早期乐观

人工智能领域成立于1956年在达特茅斯学院举行的夏季研讨会上,来自不同领域的科学家们聚集在一起,以阐明并发展关于“思维机器”的观点。

1960年代,大学开始认真进行计算机视觉研究,并将该项目视为人工智能的奠基石。

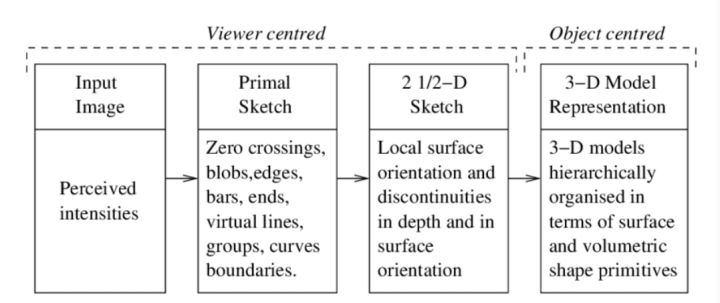

麻省理工学院的神经科学家戴维·马尔(David Marr)在70年代出版了一本《VISION》,汇集了一些方法,作出了可检测的预测,提供解决神经科学问题的框架,并激发一代年轻科学家研究大脑及计算。

该书提出了一种用于研究生物视觉系统的计算范例,并介绍信息处理系统的三个不同分析层次概念,即计算理论层次、表示形式和算法层次、以及实现层次。他们分别指向:计算的目标是什么;解决问题、实现目标的陈述与流程;这些表示和过程的物理实例化,例如如何在神经元中完成特定任务。

这三个层次划分的意义是,研究者从视觉系统的宏观表示出发进行思考,而不是查看如单个神经元式的微观实体。

Marr 建立了视觉表示框架,任何视觉系统感知到的强度,都是四个主要因素的函数:几何形状,意指形状和相对位置;可见表面的反射率和绝对吸附特性,即物理特性;照明,即光源;相机,包含光学。

早期研究人员对相关领域的未来非常乐观,并提倡把人工智能作为一种可以改变世界的技术。

一些人预测,一代人的时间内就会创造出像人类一样聪明的机器,这种炒作为研究人员赢得了数百万美元的公共和私人资金,研究中心在全球涌现。但是由于接下里的发展未能达到人们的高预期,国际上的人工智能开发工作受到了限制。

四、AI 视觉的冬天

研究人员以极大的乐观度,将公众的期望提高到了令人难以置信的高度,却未能体会到他们为自己设定的挑战的难度。当研究人员承诺的预期未能达成时,这个研究领域遭到了猛烈的批评,和严重的财务挫折。

早期的计算资源在技术上无法跟上科学家提出的复杂问题,即使是最令人印象深刻的项目也只能解决微不足道的问题。此外,大多数研究人员都是在孤立的小组内工作,缺乏比较有意义的,可以推进该领域科学进展的方式。

有一则故事可以反映当时研究人员的美好预期、以及预期落空后他们自身及和外界的失落与嘲讽。

1966年,美国计算机科学家、麻省理工学院 AI 实验室联合创始人马文·明斯基(Marvin Minsky)获得了暑期津贴,聘请了一年级的本科生杰拉尔德·苏斯曼(Gerald Sussman),让他花费整个夏天的时间把一台摄像机与计算机连接起来,并让计算机描述它看到了什么。

不用说,苏斯曼没有在截止日期前完成,”Motion Metrics 的机器学习开发人员 Hooman Shariati 曾说,“在接下来的四十年中,视觉成为人工智能领域最困难、最令人沮丧的挑战之一。

正如机器视觉专家贝特霍尔德·霍恩(Berthold Horn)曾经指出的那样,苏斯曼选择不再在视觉领域工作。

到70年代中期,政府和公司对人工智能失去了信心,行业资金枯竭。数学家詹姆斯·莱特希尔(James Lighthill)1973年发表了一篇论文,批评早期人工智能研究,这为后来英国政府撤回对该领域的支持奠定了研究基础。

随后的这段时间被称为“人工智能的冬天”。虽然20世纪80年代和90年代研究还在继续,也有过一些小规模的复兴,但人工智能基本上被被归入了科幻小说的范畴,严肃的计算机科学家都避免使用这个词。

五、卷积神经网络出现与多伦多大学的突破

随着互联网成为主流,计算机科学家有了可以访问更多数据的权限。计算机硬件在继续改进,成本则在下降。80年代到90年代,基本神经网络和算法得到改进。

1998年,Bengio、Le Cun、Bottou 和 Haffner 在一篇论文中首次介绍了第一个卷积神经网络 LeNet-5,能够分类手写数字。

卷积神经网络可以做到平移不变形,即使对象的外观发生某种方式的变化,也可以识别出对象。卷积神经网络通过监督学习和反向传播对输入到卷积网络中的数据做训练,并反复、自我校正。

和同样可以做反向传播的深度神经网络相比,卷积神经网络的特殊之处在于神经元之间的链接结构和独特的隐藏架构的方式,这是由人类视觉皮层内部的视觉数据处理机制启发得来的。此外,CNN 中的图层按照宽度、高度和深度三个维度进行组织。

卷积网络最重要的属性之一就是,不管有多少层,整个 CNN 系统仅由两个部分组成:特征提取和分类。通过对特定特征的选择,以及通过前馈链接增加空间不变性,这也是人工视觉系统如 CNN 非常独特的原因。

(视觉皮层和卷积神经网络有许多相似)

深度神经网络研究应用也有进步,并且使人们信心大增。2012年,人工智能在 ImageNet 大规模视觉识别挑战(ILSVRC)上取得突破。

ILSVRC 是一个年度图像分类比赛,研究团队在给定的数据集上做视觉识别任务,评估算法准确性。2010年和2011年,ILSVRC 获奖者的错误率一直在26%左右。

2012年,来自多伦多大学的团队带来一个名为 AlexNet 的深度神经网络,实现了16.4%的错误率。在接下来的几年中,ILSRVC 的错误率下降到了几个百分点。

六、基于 AI 的计算机视觉的未来

当下,人们已经知道,视觉能力是人类承担的生物学生最复杂的任务之一,对计算机视觉的研究和预期也更加贴近世界。同时,基于对人类视觉能力了解的深入,计算机视觉研究人员也在不断更新算法和理论。

CNN 已经广泛用于需要处理视觉和空间信息的系统中。但随着人工智能需要解决更高级的问题,对计算和电力资源的增长需求成为 CNN 最突出的问题之一。

研究人员的注意力也在逐渐转向尖峰神经网络 SNN,这是一种新型的 ANN ,受大脑神经动力学的启发,具有事件驱动,快速推理和省电的特性,也被认为是第三代神经网络。

接下来 SNN 要优化解决的一个问题是视觉注意 VA 与智力。人类可分散的注意力使得人能同时执行多个任务,注意力转移可以使人快速访问新信息。视觉注意力研究的核心目标是要使处理的视觉信息量最少,以解决复杂的高级任务,例如对象识别。

计算机视觉任务主要涉及处理静态图像,人类眼睛在检测到场景变化向大脑传递信息——这是一个事件,生物视觉系统的这一关键特性允许将注意力选择性地集中在场景的显著部分上,从而大量减少需要处理的信息量。

假设针对一张人在草地上打高尔夫的图像。传统的传感器中,数据以帧的形式传输,图像上的所有内容都要经过处理,而重要的信息是人的运动,以及带动的球杆和球的运动。

这时,基于事件的传感器并不会读取每个像素并且以恒定速率发送帧,而是在检测到像素局部亮度变化是,从每个像素异步发送数据包或事件,从而减少计算、传输的数据和功耗。

研究人员认为,CNN 非常适合静态图像中的对象识别,但它缺乏动态特性来处理基于事件的传感器的实时数据集。因此,SNN 被寄予厚望。

现在人工智能已经无缝集成到日常生活的多方面。研究人员表示,近年来,人工智能在许多研究领域都取得了巨大的成功。

像 AlphaGo 这样的游戏系统已经使用强化学习来自学,助听器使用深度学习算法过滤掉环境噪音,这些技术甚至为自然语言处理与翻译、对象识别以及模式匹配系统提供了动力,我们已经对谷歌、亚马逊、iTunes 等提供的类似服务习以为常。

这种趋势也丝毫没有放慢的迹象,人们可以用计算机自动化执行许多小的重复性任务以节省时间。

尽管人工智能领域取得了令人难以置信的进步,但计算机视觉的应用仍有很长的路要走,因为距离计算机可以像人类一样地去解释图像还需要很长时间。就像文章开头提到的那样,AlphaGo 早已击败了人类围棋冠军,计算机视觉的识图能力仅相当于一个3岁的小孩。

参考链接:

作者:黄翔

链接:https://www.zhihu.com/question/51863955/answer/202768648

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

DNN/CNN把cv往前推了一大步,与其说现在cv到了瓶颈期,不如说是DNN/CNN在cv这个领域到了个瓶颈期,接下来等新理论新算法出来,又能把cv往前推进一大截。有趣的是,因为NN在cv领域的成功引起了很多关注,现在NN的台风刮到了各行各业,在别的领域倒是有巨大的发展。

CNN在一定程度上模拟了假设的生物大脑的视觉处理过程,但远没能达到人脑的视觉处理能力,今年看了几本计算神经学入门的书,人脑与CNN比起来,粗略地说有这么几点差异:

1.人脑中有3D和2D两个认识部分,其中2D部分处理平面形状和平面组合,3D部分处理3D物体和空间关系,目前的CNN只是2D平面像素的处理。

2.人脑对物体认知有尺度一致性,是统一到物理尺度上的,不受分辨率、远近、角度影响,人脑有一个3D与2D之间的映射系统,能把肉眼看到的2D的物体图像投射到脑中的3D虚拟空间中尺度一致地进行识别,而CNN没有,CNN只比对2D像素特征,所以cnn需要海量的各个角度的图片,cnn并不是理解了物体的结构,cnn只是统计上能够对物体投影到2D平面上的图像的像素特征进行标签。

3.人脑内有一个raytrace光照模型,能够推测场景的光照方向和角度,这个光照模型是长时间对光照现象的知识积累出来的,所以人脑可以理解折射、反射、通过阴影推测物体相互关系。人脑还积累着一大堆各种材质BRDF的知识。

4.人脑有一个3D与2D之间的小孔成像模型,人脑能够通过尺度叛变距离,通过距离判别尺度,并在多个物体组成的场景中通过上下文推理从而理解整个场景的空间关系。

现阶段的CNN只比对2D像素特征,这只是人脑的视觉处理过程中很小的一部分,缺失了很多,所以一定不会好。而对于其它的关键部分,例如raytrace model ,一致性 model,3D-2D转化model这些如何用NN来做?数据如何编码?NN如何设计?如何训练?如何与其它模块串成pipeline?我没看到有影响力的论文出来,甚至都没听到有人在做。

我觉得现在很多做NN的都在钻牛角尖,换来换去各种网络,没有人从计算神经学角度看问题,在这些问题解决之前,纯靠微调model、堆网络规模和训练数据来实现对场景的理解我觉得是不可能的。一年前听andrew ng的演讲,他说他们解决NN效果不好的方法就是上更深的model和更多的数据,太简单粗暴了。

而计算神经学的那帮家伙,只会忙着用fMRI标记大脑活动。

我也是一脸懵逼。

update:

书单:

Medicine & Health Science Books @ Amazon.com

这3本我只是跳着看了几个章节,可能看完后会有不同的理解吧,自己胡乱在网上搜到的

作者:SingVision

链接:https://www.zhihu.com/question/51863955/answer/215836812

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

不太经常回答问题,今天才发现消息箱里竟然有个古老的邀请。

我是理论物理半路出家做CV,熟悉的领域是几何算法(全景,3D重建,SLAM等),但关注点并非学术方面,而是现有学术成果的产品化。所以我只能挑我熟悉的领域来说一下现状。

瓶颈期当然不会是现在。深度学习对CV的深远影响应该是最重要的原因,但我只说说几何算法这块。诸如3D VR视频,Hololens等大量的新兴应用已经充分的吊起了大众的胃口,这些新需求将会充分刺激学界和工程界继续开拓,因为释放出来的想象力不太可能就这么关回去。

现有的CV算法,就效果和对场景的鲁棒性上来说,有相当多仍处在只能做个demo的级别上,离能够产品化还相去甚远。这个差距或许来自算法本身,也或许来自实现的缺陷,但克服这些问题,量产出效果一流不挑场景成本低廉的CV产品还是颇有挑战性的问题。在这类问题上,学界和工程界还需要忙活一阵子。

几何算法里,基于Homography的全景拼接应该是最接近上述标准的一个算法了,但即便如此这一简单算法的落地仍然相当辛苦。14年上半年我做了一个实时全景视频拼接算法,基于CUDA的laplacian金字塔融合。当时这块只有零星的需求冒出来,很长一段时间内我们都认为应该放弃缺乏想象力的全景视频,转向3D重建和SLAM方向。但15年春天开始全景拼接的需求如雨后春笋般涌出来,及至15年底,国内一些厂商入海康威视基于全景拼接研发的安防全景摄像机就已经开始走进市场了。好在我们在15年秋天开始安防方面的产品化工作,完全重构了算法并使之满足量产需求,次年春产品化初步完成,开卖。但市面上包括海康在内的全景摄像机/相机基本都相当初级,分辨率、拼缝、功耗、使用体验都问题重重,我们当时则卡在了和旧有安防平台的兼容性上。

这里边的问题,有的是算法本身的问题,比如基于Homography拼接的近景拼缝(安防领域不太关注近景,算法做好了基本可以做到无缝。但消费类这个问题很严峻,这也就是这些年双鱼眼全景相机遍地的一个原因,拼缝小),再如标定算法的场景适应性(没错,的确有不少厂商把标定留给最终用户去做,尽管这是一个出厂时就能完成的事情);也有些是实现的问题,普通码农写算法质量差的不是一点半点,而学界出来的人写程序往往天马行空,不关注代码的工程品质。

16年则是被媒体重彩渲染的所谓VR元年,种种“创业团队”联系过来要一起做VR,简直不能再泡沫。但毕竟泡沫也是一个新技术落地前几乎必须经历的,如今喧嚣渐远,剩下一些思路开阔战斗力较好的年轻团队留在市场上,我觉得局面还是很好的。这一年(当然也包括之前)涌现出了不少消费类全景相机和专业级3D全景摄像机,消费类产品品质差不多是一律的惨不忍睹。惨不忍睹的原因倒不是算法不行,而是工程团队太业余。

这时一些专业的团队开始涌入,比如facebook的surround360,国内的量子视觉,冰立方等,它们致力于用Image-based rendering中一些不平凡的算法来取代传统的Homography拼接,从而完全消除拼缝,实现完美的双目3D全景。这类算法通常需要求解图像帧间dense的匹配(如光流),但这样就为拼接过程引入了相当大的不确定性,有可能会在不好的场景下产生拼接缺陷,同时计算量如何约化也是个制约产品化的问题。

一个领域有炽烈的需求,有亟待解决的问题,必然是朝气蓬勃的。

作者:黄缨宁

链接:https://www.zhihu.com/question/51863955/answer/140628627

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

“CV领域自身的理论”

题主所说的CV自身的理论发展缓慢,我觉得细究起来“CV自身的理论”可能包括成像原理、特征提取等,但这些也不是CV独特的理论。比如成像原理就来自于物理,特征提取也不仅是CV使用,并且,特征提取的方法深度学习可以做的更好更智能。所以其实,CV可能并没有什么所谓的自己的理论。

“那么未来CV的发展会不会因为自身发展的不足而只能依托其他领域发展的支持,计算机视觉领域是否会产生饱和甚至萎缩”?

如果在这个立场上,我们来看看CV的本质,计算机视觉的边界在哪里?计算机视觉就是用机器来模拟人类看这个行为,并获取相应的人脑可以从视觉中获取的信息。CV更像是运用你所能触及的一切工具,使得机器具有类人的视觉。所以,不要担心CV因为没有自己理论系统,只能依托其他领域的支持而发展,本来事物的发展就是各方力量的综合作用。比如LeCun建议深度学习的从业者学习物理,比如模拟退火来自物理、卡尔曼滤波来自航天领域,再比如飞机发明也依赖仿生学。而我们不会担心这些领域停滞不前了,人是运动的,思维是活跃的,一个领域难以带来灵感我去另一个领域看看。就比如人类大脑这个领域目前都是个谜团,我们还没能很好的模仿他,离发展的尽头还有很远的距离。

“不论兴趣,单从时机考虑,现在进入这个领域还来得及吗?”

那么什么叫做具有人类的视觉,视觉只是识别吗?肯定不是,还有理解和分析。也许你看ImageNet错误率这么低了,机器是不是很厉害了,我来这个领域还干嘛,还来得及吗。其实,再in the wild 的数据集和真实环境一比还是个实验环境,太太太单纯了。比如现在你用LFW用cnn判断个性别轻而易举,在老旧的监控下人都糊成一团了,cnn还能识别么?但为啥人一看就可以识别,这里面是不是还有我们没利用起来的信息?我们怎么通过各种方法的交叠左右解决这个实际问题。所以,从算法到产品,从理论到实际,没有想象的那么近,还有很多的问题有待开发和解决。种一棵树最好的时机是十年前,其次是现在。想种树,就来吧。

所谓到达 “瓶颈” 期,并不是“没有东西可做了”, 而是虽然还存在大量问题, 但这些问题要么就是难以解决, 要么就是解决了之后能带来的质的提升太小了。如果你物理更有感觉,你就可以选择微电子,感觉就是天赋的意思。

今后的微电子肯定大部分都在做人工神经元芯片,量子芯片等新型与人工智能直接接轨的芯片。

如果要学微电子,就要去开发不一样的芯片,浮点运算高的芯片,研究方向也应该是器件之类的,这样做到顶尖之后才可以成为电子一霸,这时,硅谷则凝聚了世界上最先进的技术。目前绝大多数深度学习模型,不管神经网络的构建如何复杂,其实都是在做同样一件事:

用大量训练数据去拟合一个目标函数y=f(x)。

不同于传统的机器学习模型相比,深度学习中的模型通常具有两个特点: 模型容量大,参数多 端到端(end-to-end) 借助GPU计算加速,深度学习可以用端到端地优化大容量模型,从而在性能上超越传统方法,这就是深度学习的基本方法论。

作者:知道智慧

链接:https://www.zhihu.com/question/51863955/answer/340366022

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。