- 1大数据Hadoop之——部署hadoop+hive+Mysql环境(window11)_hadoop mysql

- 2【修改huggingface transformers默认缓存文件夹】_transformers_cache

- 3大数据在推荐系统中的作用_推荐系统与大数据安全

- 4android 检测无用资源,一个自动清理Android项目无用资源的工具类及源码

- 5【深度学习】-Imdb数据集情感分析之模型对比(4)- CNN-LSTM 集成模型_cnn-lstm做情感分析的时候需要保证cnn的输出和bilstm的输出维度一致吗

- 6Wireshark 抓包工具与长ping工具pinginfoview使用,安装包_wireshark端口抓包命令

- 7Neo4基础语法学习_neo4j语法教程

- 8注意力机制(Attention)原理详解_attention层

- 9毕业设计 基于单片机的智能盲人头盔系统 - 导盲杖 stm32

- 10基于ZooKeeper的Kafka分布式集群搭建与集群启动停止Shell脚本

Jieba库——中文自然语言处理的利器_jieba库国内

赞

踩

中文作为世界上最广泛使用的语言之一,其复杂的结构和丰富的表达方式给中文文本处理带来了挑战。为了解决这些问题,Python开发者开发了一系列用于处理中文文本的工具和库,其中最受欢迎和广泛应用的就是Jieba库。Jieba是一个开源的中文分词工具,具备高性能、易用性和灵活性等优点,可帮助用户有效地进行中文文本处理和分析。本文将介绍Jieba库的基本原理、功能和使用方法,并通过实例演示如何利用Jieba库进行中文文本处理。

一、Jieba库简介

Jieba是一个流行的开源中文分词工具,它基于Python语言实现,旨在提供一个简单、高效的中文分词解决方案。Jieba库具有优秀的性能和灵活性,支持多种分词模式和算法,并具备广泛的应用场景。无论是中文文本处理、信息检索还是自然语言处理任务,Jieba库都是Python开发者首选的工具之一。

二、基本原理和核心功能

1. 中文分词

中文分词是将连续的中文文本切分成词语的过程,是中文文本处理的基础。Jieba库提供了多种分词模式和算法,包括精确模式、全模式、搜索引擎模式和自定义字典模式等。用户可以根据不同的需求选择合适的分词模式,在处理中文文本时实现准确的分词效果。

2. 关键词提取

除了分词功能,Jieba库还提供了关键词提取的功能。通过基于TF-IDF算法和TextRank算法等方法,Jieba库可以从文本中自动抽取出关键词。这些关键词对于文本摘要、主题提取和信息检索等任务非常有价值。

3. 词性标注

Jieba库还支持中文词性标注,它可以将分词结果进行进一步的词性标注。词性标注可以帮助用户了解每个词语的词性,从而在文本处理和分析中更好地理解中文文本的含义和语法结构。

三、示例应用

为了更好地理解Jieba库的使用方法,我们将通过一个示例来演示其在中文文本处理中的应用。

假设我们有一个中文新闻文章的文本数据集,我们希望对其中的文本进行分词、关键词提取和词性标注。首先,我们可以使用Jieba库的分词功能将文本切分成词语,得到分词结果。然后,我们可以利用Jieba库的关键词提取功能,从每篇文章中抽取出关键词。最后,我们可以对分词结果进行词性标注,了解每个词语的词性信息。

四、总结

本文介绍了Python中强大的中文自然语言处理工具——Jieba库。Jieba库提供了高性能、易用性和灵活性的中文分词、关键词提取和词性标注功能。通过使用Jieba库,我们可以有效地处理和分析中文文本数据,并从中获取有用的信息。希望本文能为读者提供一个入门理解Jieba库的指南,鼓励读者进一步探索和应用Jieba库在中文自然语言处理任务中的潜力。

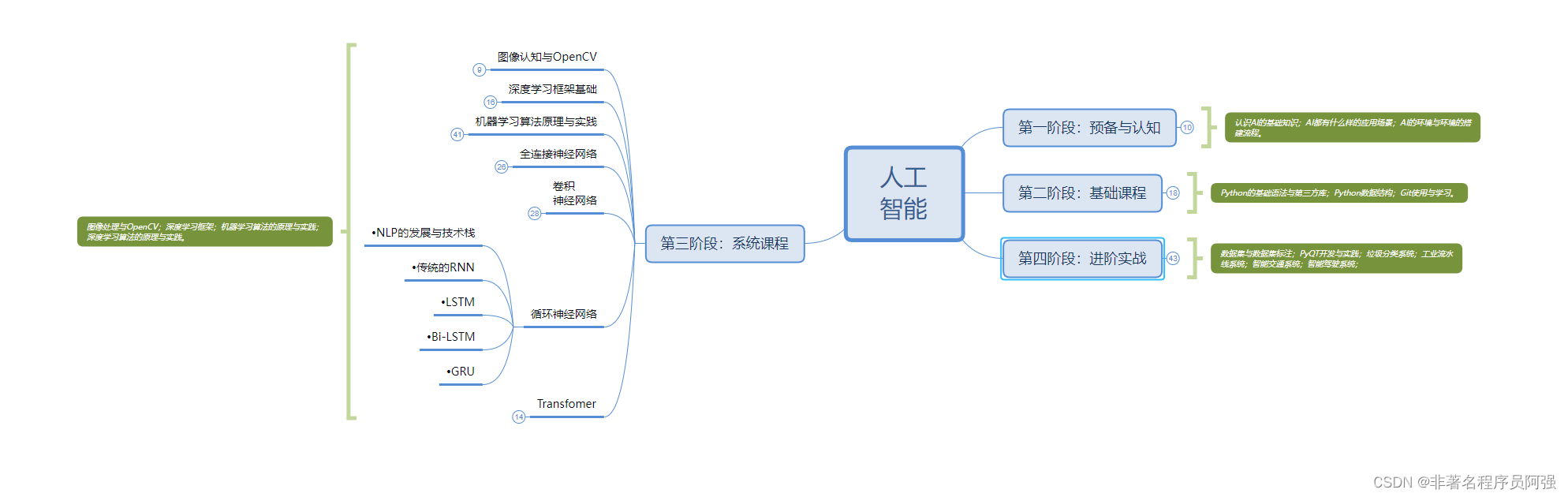

人工智能的学习之路非常漫长,不少人因为学习路线不对或者学习内容不够专业而举步难行。不过别担心,我为大家整理了一份600多G的学习资源,基本上涵盖了人工智能学习的所有内容。点击下方链接,0元进群领取学习资源,让你的学习之路更加顺畅!记得点赞、关注、收藏、转发哦!扫码进群领人工智能资料