- 1Mysql 两表联动更新_将查询结果放中间表,然后中间表跟另一个表关联更新

- 2中国大模型的发展需要不断拓展应用场景、增强模型能力、创新技术手段、促进开放开源以及加强数据安全等方面进行探索和实践_大模型技术验证及应用必要性

- 3python批量运行py 文件

- 4两种方法设置linux环境下禅道开机自启动_禅道如何启动

- 5iOS 15中Swift和SwiftUI的使用情况

- 6深度学习论文: GhostNetV2: Enhance Cheap Operation with Long-Range Attention及其PyTorch实现

- 7MobSF移动安全检测框架简述_mobsf报告解读

- 8删除单词后缀

- 9git fetch - git merge - git pull 指令_git fetch merge

- 1020240418金融读报:银行参考汇丰全球化布局&银行全球化布局现有路径&再读金融助力新型工业化

基于FastChat构建的OpenAPI访问有问题_fastchat.serve.openai_api_server

赞

踩

前言

Fastchat是一个开源的(https://github.com/lm-sys/FastChat)大模型部署框架,能提供兼容OpenAI的APIs给web应用远程访问,也自带Gradio组件直接提供Web UI服务(不过现在一般都用Streamlit前端来构建webui)。

本文主要讨论如何使用fastchat来构建APIs并进行测试和问题汇总。

步骤

第一步安装: pip install fschat

我用的fastchat版本是0.2.35 openai版本为1.9.0

第二步启动整个fastchat的控制程序controller

python3 -m fastchat.serve.controller --host 0.0.0.0 --port 21001第三步构建model_worker将本地模型加载进来,并注册到controller。这里面两个小细节:1)本电脑使用的是CPU加载推理,所以用到了参数--device cpu 缺省的话会使用Nvidia gpu加载;2)由于本电脑内存条只有16G,为了节省内存资源,使用了8bit压缩格式: --load-8bit

python3 -m fastchat.serve.model_worker --model-name 'Qwen-1_8B-Chat' --model-path /work/rag/HuggingFace-Download-Accelerator/Qwen-1_8B-Chat --device cpu --load-8bit第四步 验证模型是否注册到controller里面

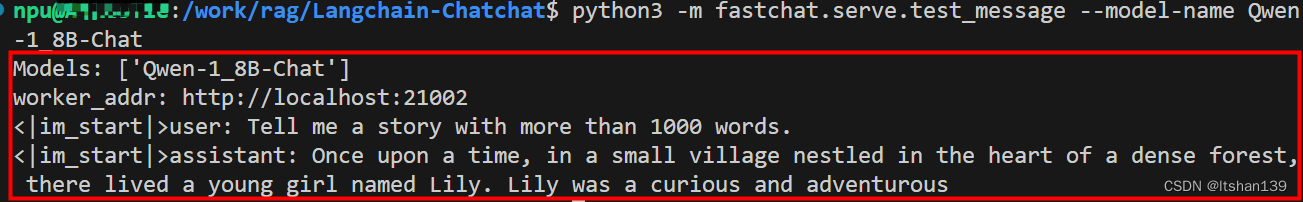

python3 -m fastchat.serve.test_message --model-name Qwen-1_8B-Chat这一步没有问题,结果如下图所示

第五步继续启动fastchat的openai server

python3 -m fastchat.serve.openai_api_server --host localhost --port 8000验证

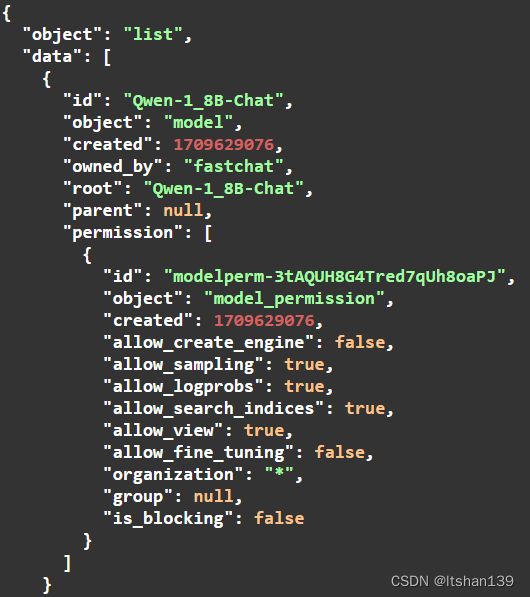

打开链接:http://localhost:8000/docs 如下图所示

GET选项里面点击Try it out和Execute可以查询到model list情况

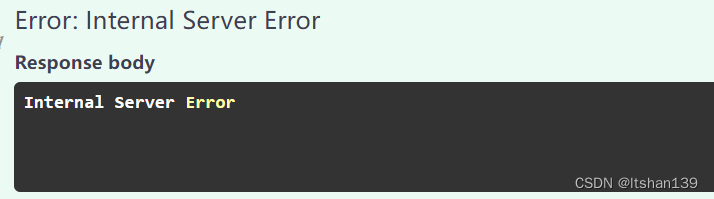

不过在下面POST测试中出现了问题。下面第一个图是message消息,点击execute后遇到第二个图的错误信息。

使用下面curl命令也返回 Internal Server Error.

- curl http://localhost:8000/v1/chat/completions -H "Content-Type: application/json" -d '{

- "model": "Qwen-1_8B-Chat",

- "messages": [{"role": "user", "content": "Hello! What is your name?"}]}'

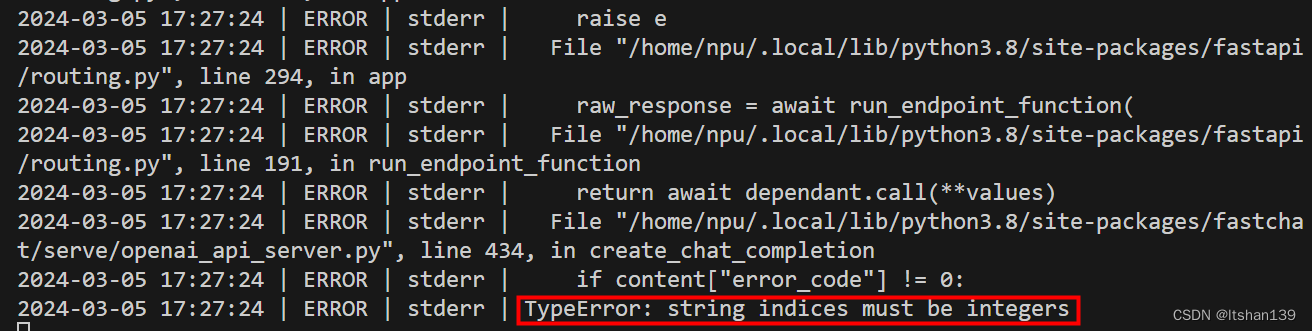

当出现Internal Server Error时,openai_api_server的命令窗口会出现下面的错误

Debug

可能跟相关组件的版本有关系,曾经将openai版本降低但还是会遇到问题。 目前正在debug中。