热门标签

热门文章

- 1多线程设计模式:生产者-消费者_线程生产者消费者模式

- 2git(2)修改文件和版本穿梭_git 穿梭版本后再提交会修改原来的文件吗

- 3走进Vue2飞入Vue3_vue2 代码应用在 vue3项目中

- 4C语言实现队列_c语言队列

- 5小白数学建模 Mathtype 7.7傻瓜式下载安装嵌入Word/WPS以及深度使用教程_wps怎么安装mathtype插件

- 6STMcubeIDE学习汇总(五)----知识覆盖_单周期乘法和硬件除法是什么意思

- 7C语言.数据结构.单链表

- 8为什么在浏览器的地址栏上输入 url 就能访问到 Web 网页_为什么输入对应的url后能访问对应前端的网页

- 9《护理管理学》习题及答案-考试版_根据具体情况是否采取某种特定行为所做出的规定是

- 10(1)探索 SpringAI - 基本概述_spring ai简介

当前位置: article > 正文

Hadoop的安装与配置_hadoop 3.2.0 windows

作者:小丑西瓜9 | 2024-05-27 22:36:26

赞

踩

hadoop 3.2.0 windows

Hadoop的安装与配置

推荐按照我的博客下载hadoop,spark,pyspark以及scala这样版本搭配更好。

如果觉得自己不会版本搭配可私聊博主。

scala的安装和配置:https://blog.csdn.net/weixin_41957626/article/details/130548174

spark的安装和配置:https://blog.csdn.net/weixin_41957626/article/details/130548275

1.下载

官网:https://archive.apache.org/dist/hadoop/common/

1.下载地址

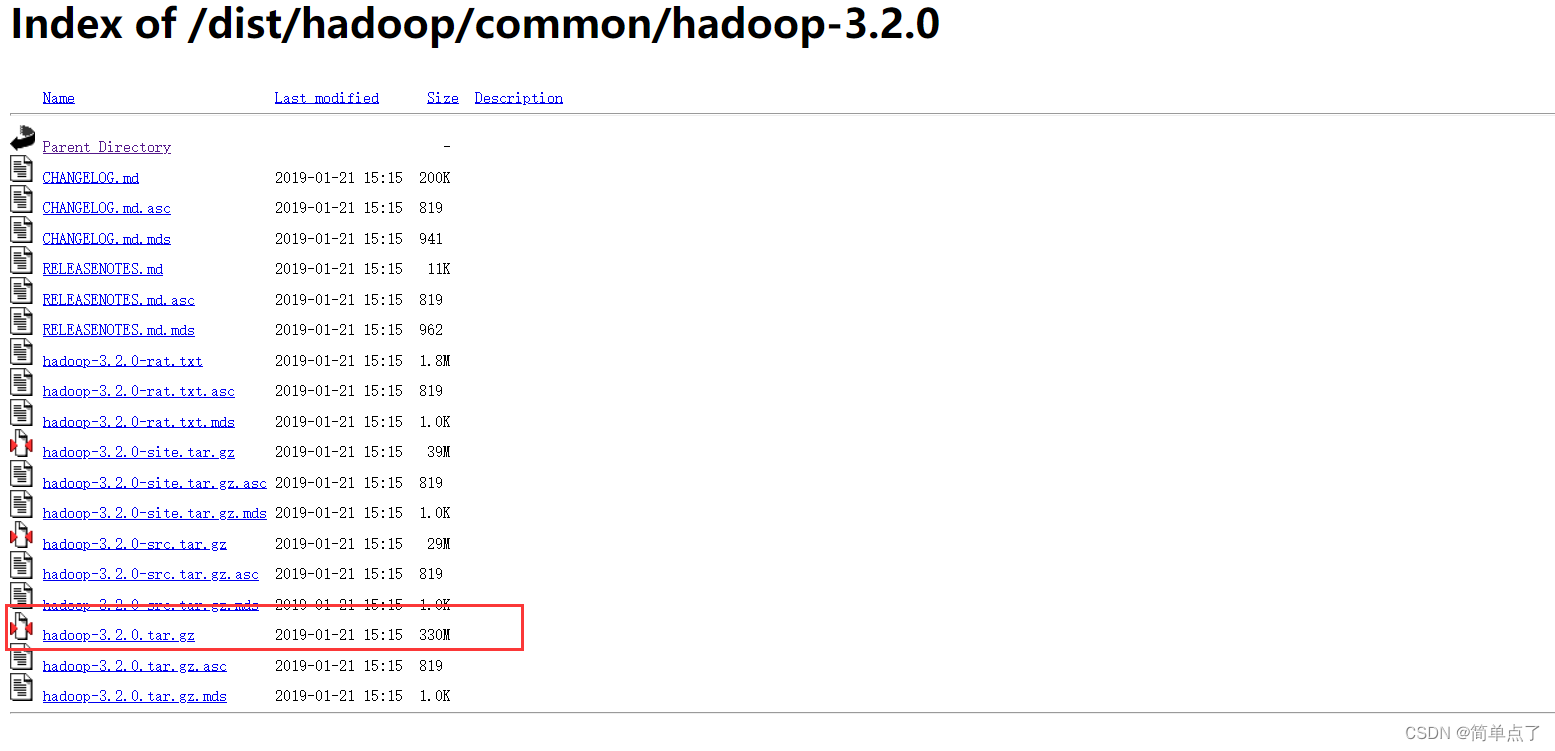

Index of /dist/hadoop/common/hadoop-3.2.0

2.Windows环境推荐下载 msi文件

我下载的是3.2是我的环境最优的配置

3.找一个自己想安装的位置解压。

2.安装和配置

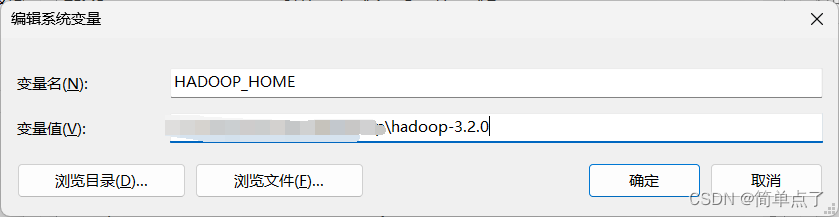

安装需要手动配置环境变量

1.打开系统的环境变量

HADOOP_HOME:安装路径,bin的上一级。

找到你的hadoop\bin目录找下里面有没有winutils.exe文件,如果没有的话,我们需要去下载。

winutils.exe

下载地址

3.测试

需要安装完spark输入spark-shell没有出现任何报错说明配置成功!!!

spark的安装和配置:https://blog.csdn.net/weixin_41957626/article/details/130548275

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小丑西瓜9/article/detail/634385

推荐阅读

相关标签