- 1【uniapp】Vue3版本项目出现Proxy代理对象无法正常取值问题解决_vue3 proxy中的数据为什么拿不到

- 2xxxxxxxxxxxxxxxxxxx

- 3【原创】java+swing+mysql个人日记管理系统设计与实现_个人日志管理系统

- 4【论文精读】OS-Copilot: Towards Generalist Computer Agents with Self-Improvement

- 5axure9.0 工具使用思考

- 615个图像识别模型下载及优缺点分析_图像检测模型推荐

- 7BMC——IPMI原理总结_服务器bmc接口

- 8Layui中table数据表格使用方法渲染 返回的数据不符合规范,正确的成功状态码应为:“code“: 0异常处理_返回的数据不符合规范,正确的成功状态码应为:"code": 0

- 9ipmi kvm要装java环境_Online.net独立服务器通过IPMI(KVM)安装Windows教程

- 10U3D问题总结(实时更新,建议收藏)_unity 如何用空对象改变坐标轴

OpenAI发布具有1750亿个参数的GPT-3 AI语言模型_gpt3参数量

赞

踩

论文地址:https://arxiv.org/abs/2005.14165

guthub:https://github.com/openai/gpt-3

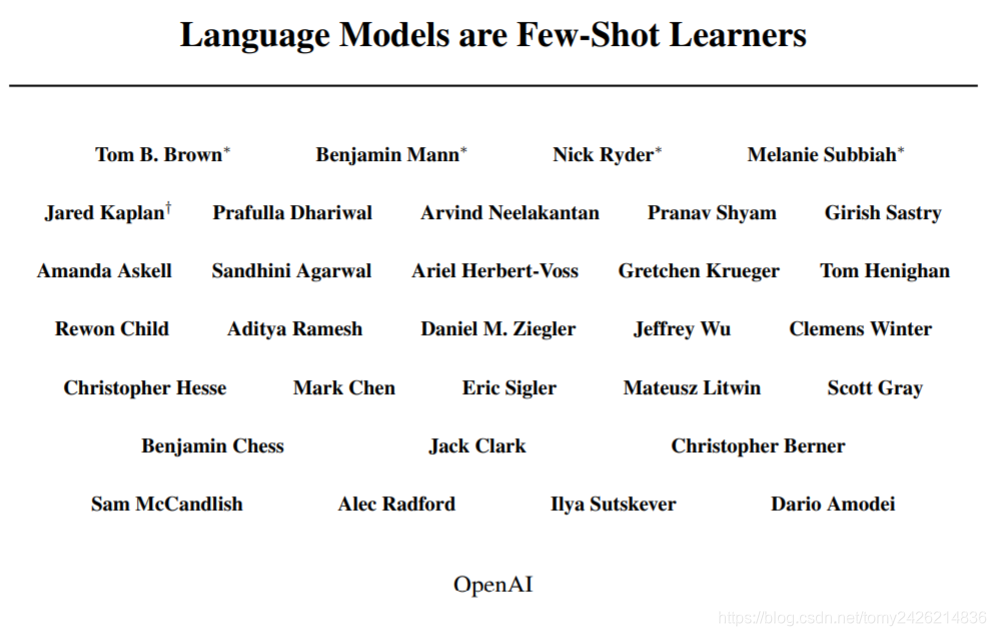

OpenAI的一组研究人员最近发表了一篇论文,描述了GPT-3,这是一种具有1,750亿个参数的自然语言深度学习模型,比以前的版本GPT-2高100倍。该模型经过了将近0.5万亿个单词的预训练,并且在不进行微调的情况下,可以在多个NLP基准上达到最先进的性能。

在arXiv上发表的论文中,由30多位合著者组成的团队描述了该模型和几个实验。研究人员的目标是生产一种NLP系统,该系统可以很好地执行各种任务,而几乎不需要微调,并且以前的工作表明较大的模型可能是解决方案。为了检验该假设,研究小组将其先前模型GPT-2的大小从15亿个参数增加到1750亿个。为了进行培训,团队收集了几个数据集,包括Common Crawl数据集和英语Wikipedia。该模型是根据多个NLP基准进行评估的,匹配了“已关闭”问题解答任务的最新性能,并为LAMBADA创造了新记录 语言建模任务。

OpenAI去年成为GPT-2的头条新闻,由于“对技术的恶意应用的担忧”,他们决定不发布经过训练的模型的15亿参数版本。GPT-2是基于Transformer架构的许多大型NLP模型之一。这些模型 使用自我监督学习在大型文本语料库(例如内容Wikipedia)上进行了预训练。在这种情况下,不是使用包含输入与预期输出配对的数据集的模型,而是为模型提供了带有单词“ masked”的文本序列,并且必须学习根据周围的上下文预测被屏蔽的单词。在进行此预训练之后,然后使用带有标签的基准数据集对模型进行微调,以用于特定的NLP任务,例如问题解答。

但是,研究人员发现,即使不进行微调,预训练的模型也表现良好,特别是对于在大型数据集上进行预训练的大型模型。今年早些时候,OpenAI发表了一篇论文,假定Transformer模型的几个“ 缩放定律 ”。根据来自多个不同基于Transformer的模型的性能数据,OpenAI得出结论,模型性能(在这种情况下,是测试数据集的交叉熵损失)与模型参数的数量,数据集的大小具有幂律关系。 ,以及用于训练的计算量。增加这三个变量将因此提高性能。

为了进行预培训,团队收集了一个由Common Crawl,WebText,英语Wikipedia和两本书集组成的数据集。为了提高数据质量,研究人员过滤了“常见爬网”以消除冗余。由于Common Crawl是从互联网上抓取的,因此它可能包含用于基准评估的实际测试数据,这会“污染”培训。该小组确实试图消除这种污染。但是,他们承认:

不幸的是,过滤中的错误导致我们忽略了一些重叠,并且由于训练的成本,重新训练模型是不可行的。

该团队使用这些数据来训练该模型的八个版本,范围从1.25亿个参数到完整的1,750亿个参数。在许多类别的数十个NLP基准上对模型进行了评估,在许多情况下,其性能均接近或高于最新水平。为了根据新闻文章生成任务评估模型,团队使用了Amazon Mechanical Turk聘请人类法官来猜测一对文章中哪篇是真实的,哪些是由GPT-3生成的。人类仅在52%的时间内选择了真实的商品;从本质上讲,人类在选择真实商品方面并不比硬币翻转更好。该团队还讨论了该模型的一些弱点。例如,在文本合成中,“ GPT-3样本有时仍会在文档级别进行语义上的重复,在足够长的段落中开始失去连贯性,相互矛盾,并偶尔包含非语义的句子或段落。” 该模型还很难解决“常识物理”问题,例如“如果我将奶酪放进冰箱,它会融化吗?”

NLP研究社区的几位成员在Twitter上评论了该模型的大小。Alchemy API创始人艾略特·特纳(Elliot Turner)推测,训练最大模型的成本可能“接近1200万美元”。Mark Riedl教授对模型尺寸与性能之间的联系提出了解释:

一种假设是,GPT-3具有如此众多的参数(训练的令牌数量的一半),以至于它开始像存储网络一样工作。

与GPT-2一样,OpenAI尚未发布经过训练的模型或代码,尽管存在一个GitHub存储库,其中包含一些测试数据集以及该模型生成的文本样本的集合。