热门标签

热门文章

- 1iOS ANCS学习_pcba关闭ios app与ancs

- 2架构_ifar构架

- 3base64 <==> Buffer

- 4Beautiful Soup4库的使用_beautiful soup find class

- 5Python数据分析入门与实践_python数据分析从入门到实践

- 6Python OCR库比较:pyocr、pytesseract和python-tesseract_python ocr库哪个好

- 7pyqt5 qtchart 画出饼图_pyqt饼状图

- 8Jupyter在美团民宿的应用实践

- 9[Python从零到壹] 十四.机器学习之分类算法五万字总结全网首发(决策树、KNN、SVM、分类对比实验)_机器学习—分类算法的对比实验

- 10navicat连接postgresql报错 column “datlastsysoid“ does not exist_navicat error:column "datlastsoid" does not exist

当前位置: article > 正文

chatglm-6B基础环境、模型下载、微调训练详细介绍_chatglm-6b 模型下载

作者:小小林熬夜学编程 | 2024-03-02 06:44:39

赞

踩

chatglm-6b 模型下载

chatgml-6B

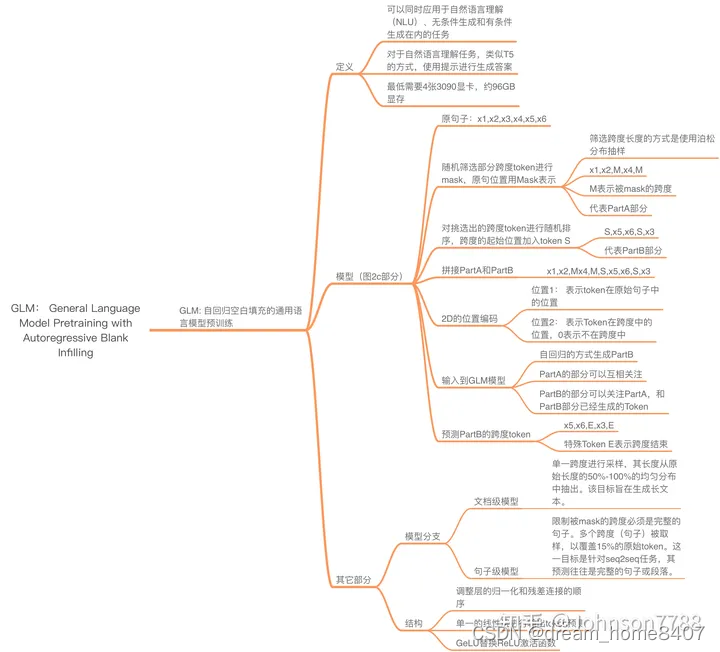

1.GLM预训练介绍

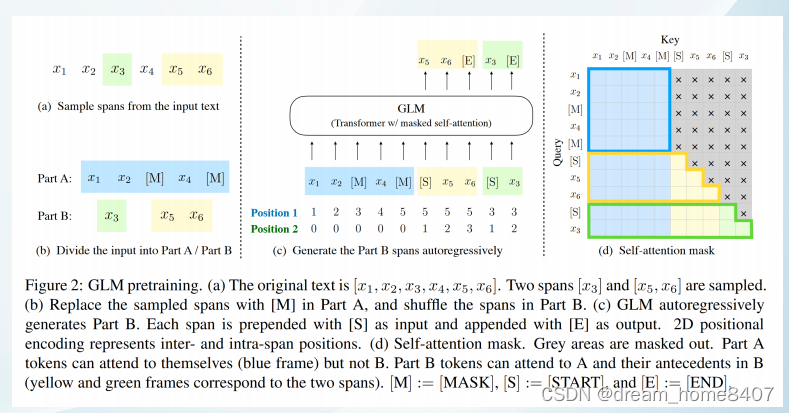

GLM(通用语言模型),基于自回归空白填充假设输入语段是是x1-x6,随机mask掉一部分,模型开始预测被mask的语段是什么,同时随机打乱mask的位置。

链接: GLM Paper

链接: GLM-130B Paper

链接: ChatGLM-6B

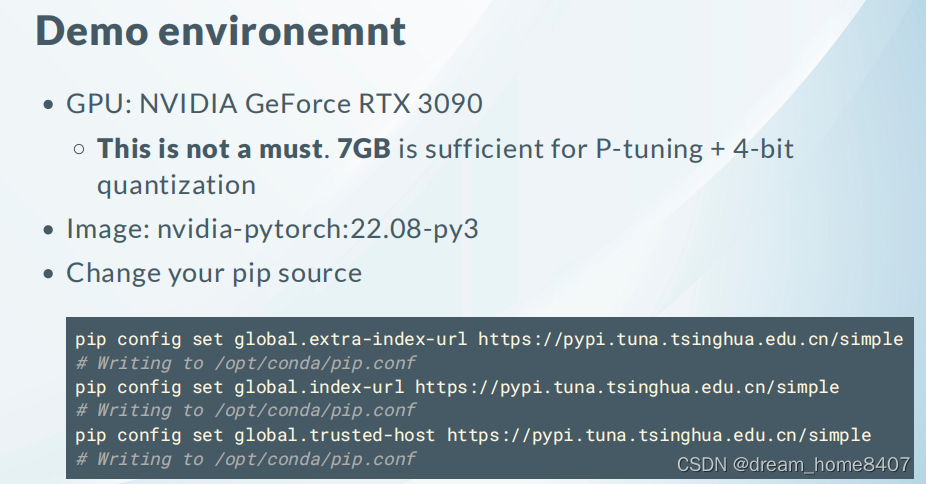

2.基础环境及镜像镜像下载方式

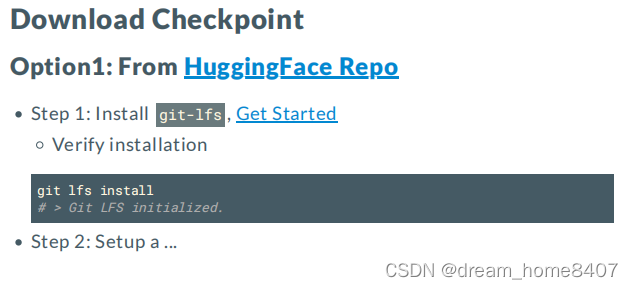

链接: HuggingFace Repo

链接: Get Started

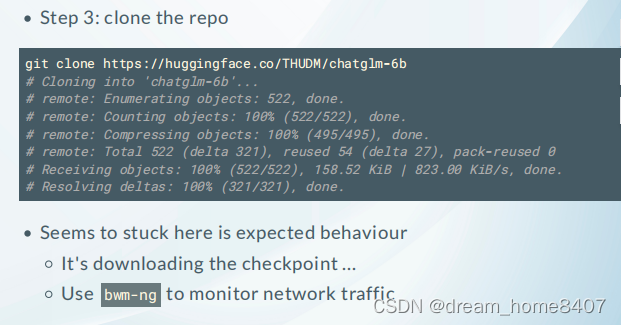

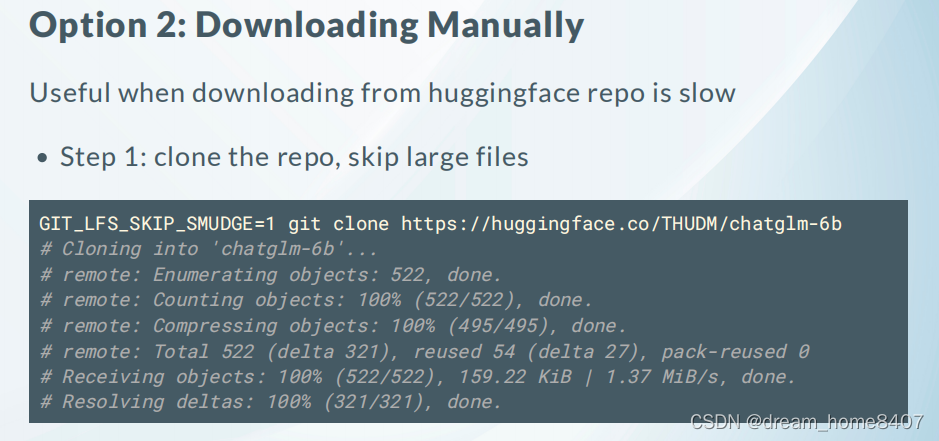

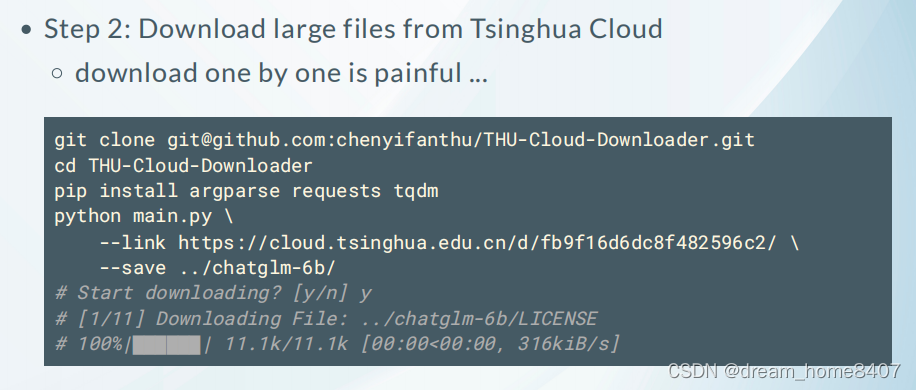

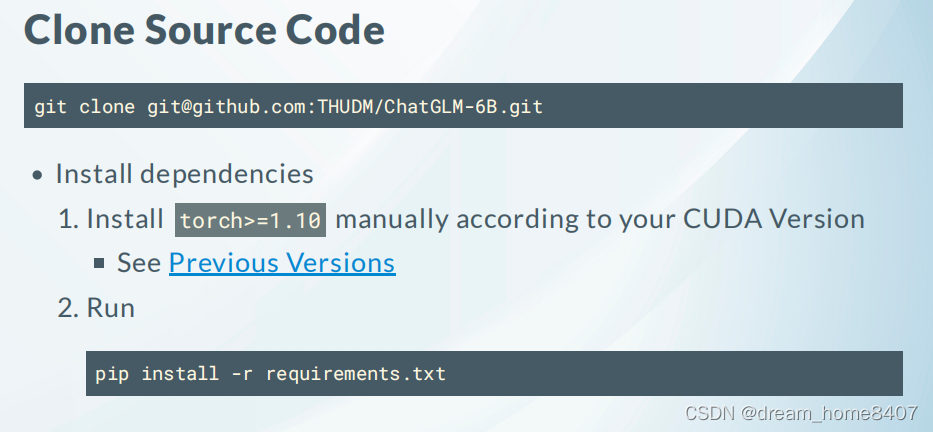

3.模型文件下载

链接: Torch Version

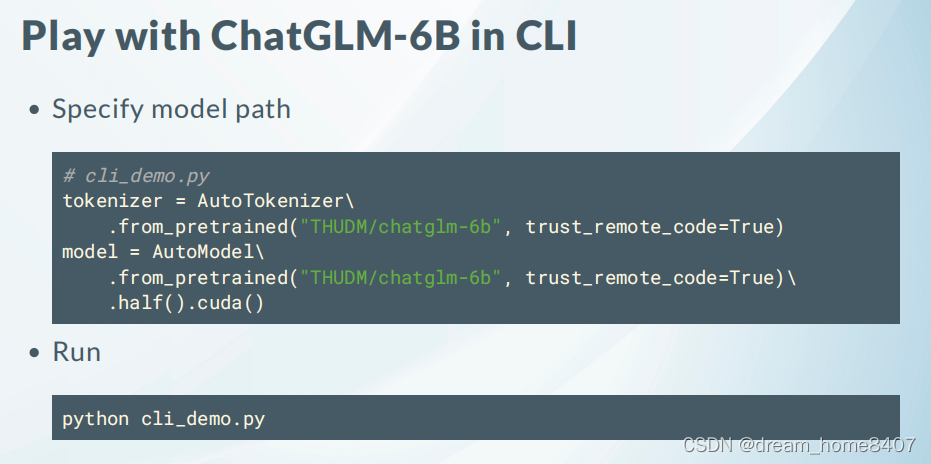

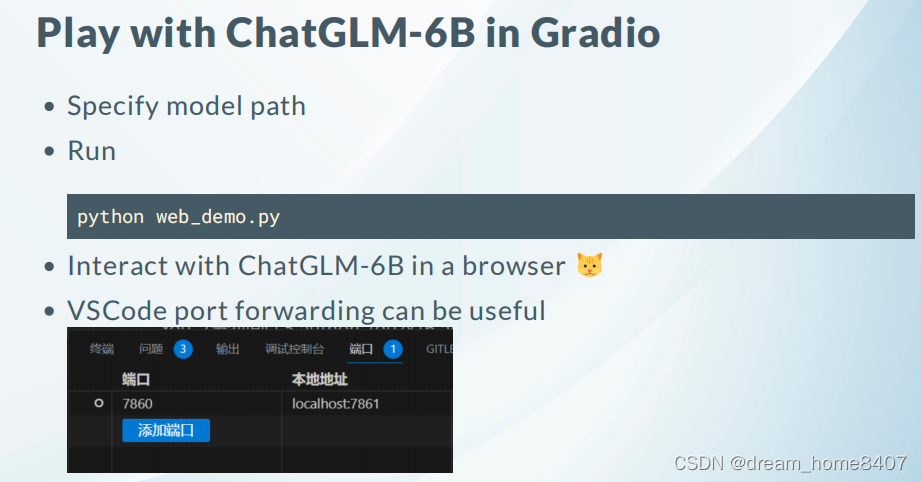

3.1推理

4. Fingtuing

P-Tuning (1 RTX2080 ti *11G)

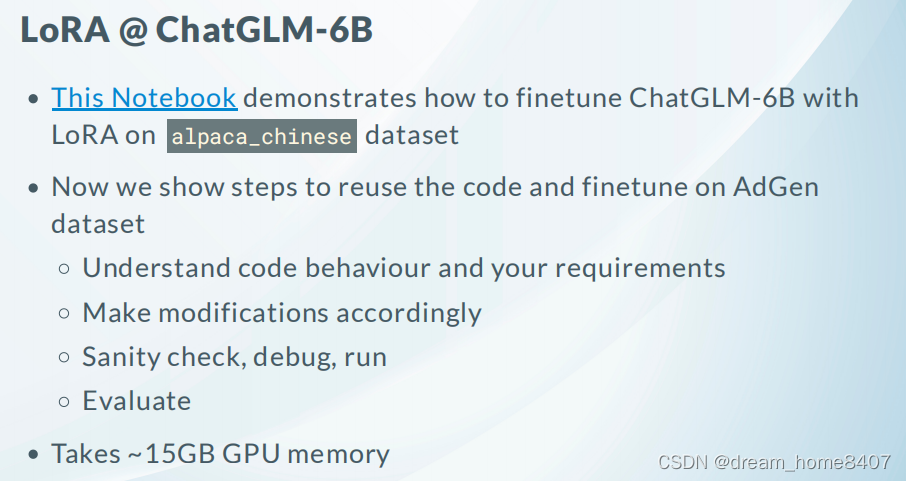

LoRA (1 RTX2080 ti *11G)

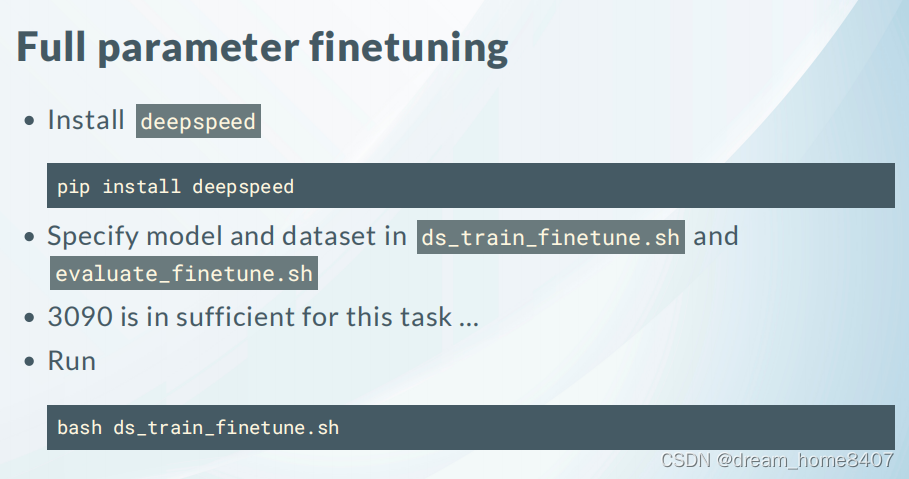

Full Parameter

4.1数据准备

样例数据下载链接

链接: Dataset

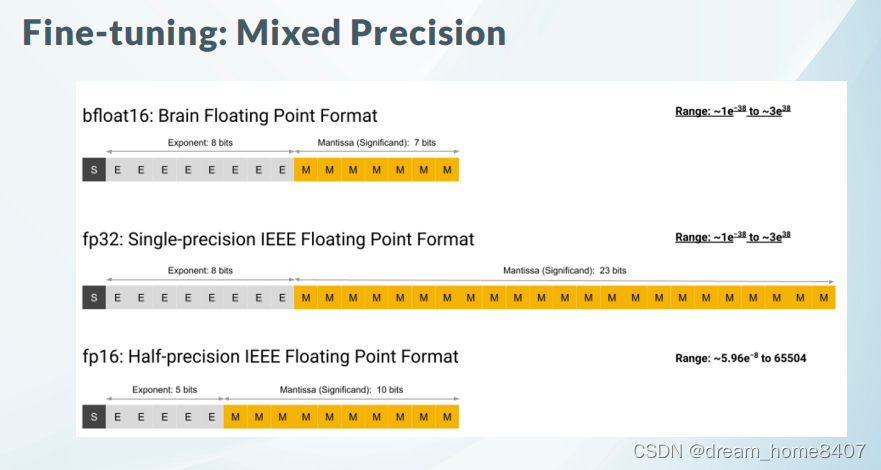

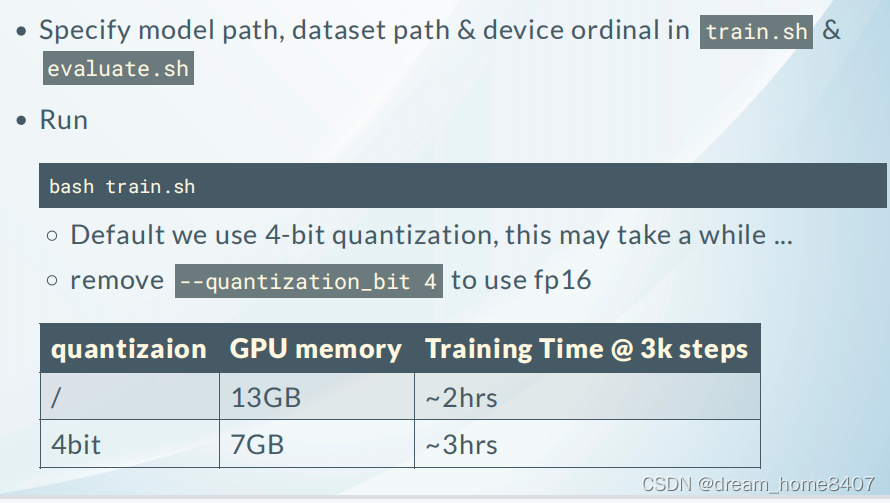

5.有监督训练量化训练

5.1更改全部参数训练方式

5.2 LoRA训练方式

链接: LoRA详细介绍

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小小林熬夜学编程/article/detail/179539

推荐阅读

相关标签