热门标签

热门文章

- 1华为ensp中ospf多区域管理 原理及配置命令(详解)

- 2Python中两种方法求列表的平均数、最小值、最大值_python列表求平均值,最大值,最小值

- 3EasyX实现简易贪吃蛇_easyx游戏

- 4人工智能中数学基础:线性代数,解析几何和微积分_线性代数与解析几何 智能大模型

- 5关于ChatGPT十大功能_chatgpt作用

- 6薛钦亮的python教程(一)从安装Anaconda开始_怎样创建anaconda快捷方式

- 74.1 文本预处理_什么是文本预处理

- 8最新开源ai智能写作机器人系统源码 电脑版+手机版+搭建教程_ai源码

- 9OpenVINO™赋能千元级AI开发板大语言模型_开发板可以部署大模型吗

- 10NeRF必读:Mip-NeRF总结与公式推导_mipnerf

当前位置: article > 正文

详解批量梯度下降法(BGD)、随机梯度下降法(SGD)和小批量梯度下降法(MBGD)

作者:小小林熬夜学编程 | 2024-03-26 19:19:14

赞

踩

批量梯度下降法

在应用机器学习算法时,我们常采用梯度下降法来对才用的算法进行训练。梯度下降法有三种不同的形式:批量梯度下降(Batch Gradient Descent)、随机梯度下降(Stochastic Gradient Descent)以及小批量梯度下降(Mini-Batch Gradient Descent)。接下来,我们将对这三种不同的梯度下降法进行理解。

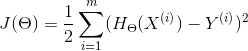

梯度下降算法需要对损失函数求梯度,也就是求导。一般线性函数对应的损失函数为:

一、批量梯度下降(Batch Gradient Descent,BGD)

批量梯度下降法是最原始的形式,它是指在每一次迭代时使用所有样本来进行梯度的更新。从数学上理解如下:

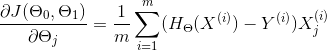

(1)对目标函数求偏导:

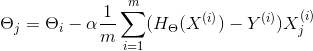

(2)每次迭代对参数进行更新:

我们要不断重复这一步直到算法收敛,也就是参数不断更新,直到梯度为0。但是,我们的每次迭代更新,都要对所有的m个样本数据进行求和。

那么我们如何检测参数是否已经收敛了呢?一种是检验两次迭代,如果两次迭代中,是否改变了很多&#x

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小小林熬夜学编程/article/detail/319139

推荐阅读

相关标签