- 1“PowerInfer:消费级GPU上的高效大语言模型推理引擎“

- 2【阿旭机器学习实战】【8】逻辑斯蒂回归原理及实战_逻辑斯帝怎么做

- 3基于F4/F7/H7飞控硬件和px4飞控固件的廉价自主无人机系统(2)- 外设和固件修改_omnibusf4sd ardupilot

- 4TypeScript学习笔记7-枚举

- 5关于“安全托管”服务,企业应该知道的几件事

- 6Java中实现几种搜索算法一二分法、深度优先、广度优先、插值搜索算法_java 二分法查找算法

- 7stable diffusion推理过程代码梳理_stable diffusion 源码解读

- 8android 开机动画 desc.txt,求安卓开机动画包里desc.txt的格式解释!

- 9《转贴》机器学习 机器视觉 图像处理 牛人牛站_wuwubox.net

- 10快速排序(实现+总结)

【机器学习笔记】误差逆传播_机器学习误差逆传播

赞

踩

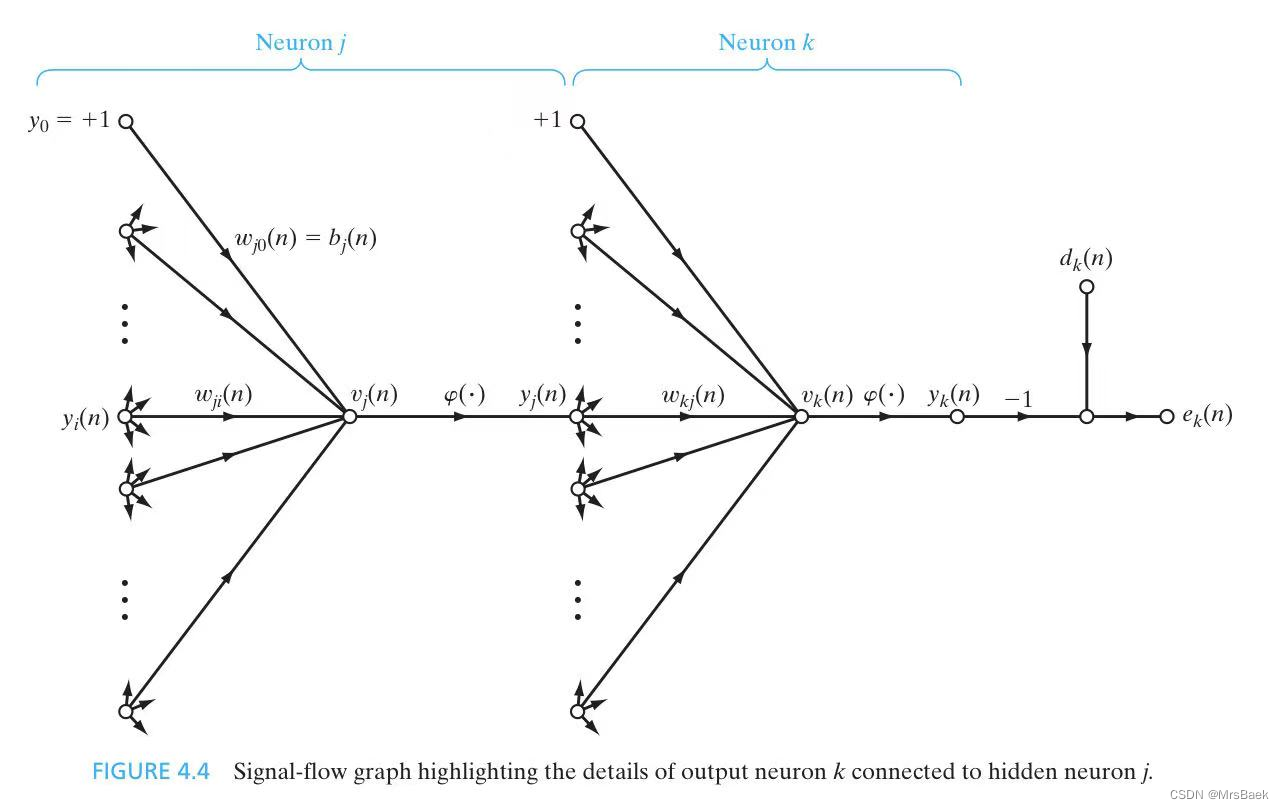

误差逆传播(Error Backpropagation)是一种用于训练神经网络的算法,通过将网络的误差从输出层向输入层传播,更新网络的权重和偏置,从而提高网络的性能。

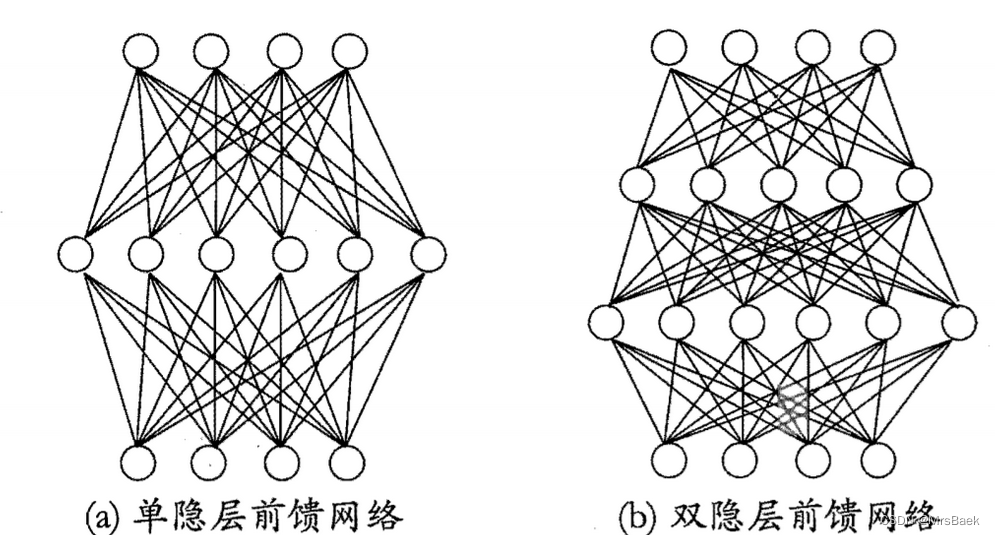

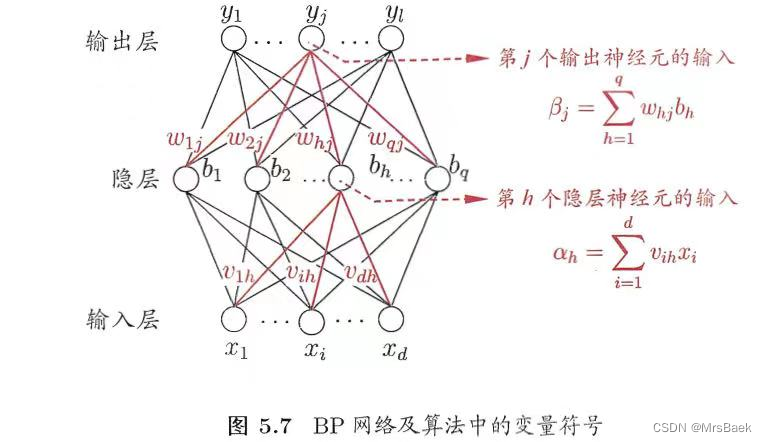

每层神经元与下一层神经元完全互连,神经元之间不存在同层连接,也不存在跨层连接,这样的神经网络结构通常称为"多层前馈神经网络(multi-layer)

feedforward neural networks)。如图5.6所示。

其中输入层神经元接收外界输入,隐层与输出层神经元对信号进行加工,最终结果由输出层神经元输出:换言之,输入层神经元仅是接受输入,不进行函数处理,隐层与输出层包含功能神经元.因此,图

5.6(a) 通常被称为"两层网络"。为避免歧义,称其为"单隐层网络"只需包含隐层,即可称为多层网络。神经网络的学习过程,就是根据训练数据来调整神经元之间的

“连接权” (connection weight) 以及每个功能神经元的阈值;换言之,神经网络"学"到的东西,蕴涵在连接权与阙值中。

“前馈”并不意味着网络中信号不能向后转,而是指神经元之间不存在同层连接也不存在跨层连接,即网络中无环或者回路。

下面是误差逆传播算法的步骤:

1. 初始化:随机初始化网络的权重和偏置。

2. 前向传播:将输入样本通过网络进行前向传播,计算输出结果。

3. 计算误差:根据输出结果和真实标签,计算网络的误差。常用的误差函数包括均方误差(Mean Squared Error)和交叉熵损失函数(Cross-Entropy Loss)等。

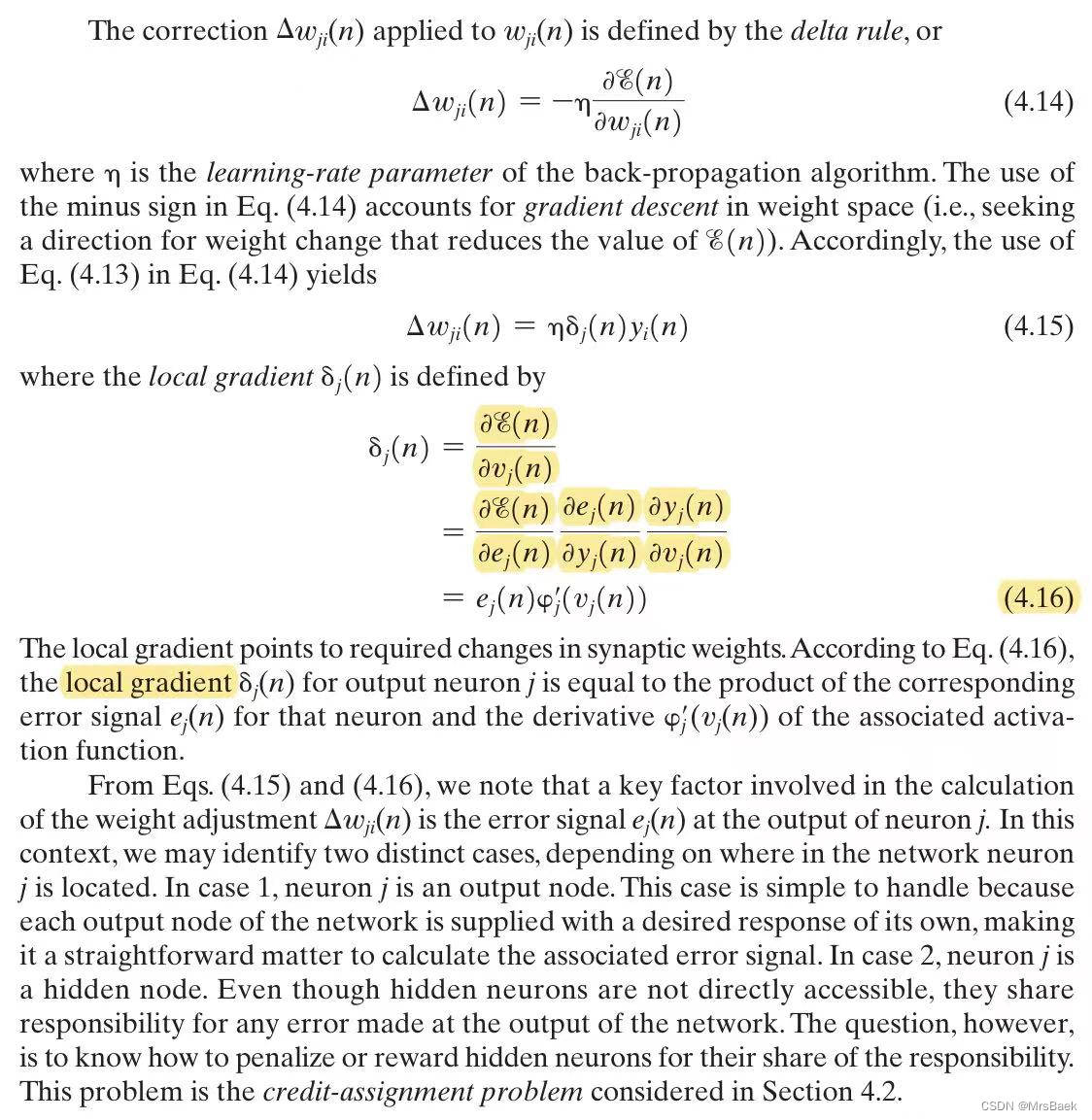

4. 反向传播:从输出层开始,计算每一层的误差贡献,并将误差反向传播到前一层。对于每个节点,根据链式法则计算该节点对权重和偏置的梯度。

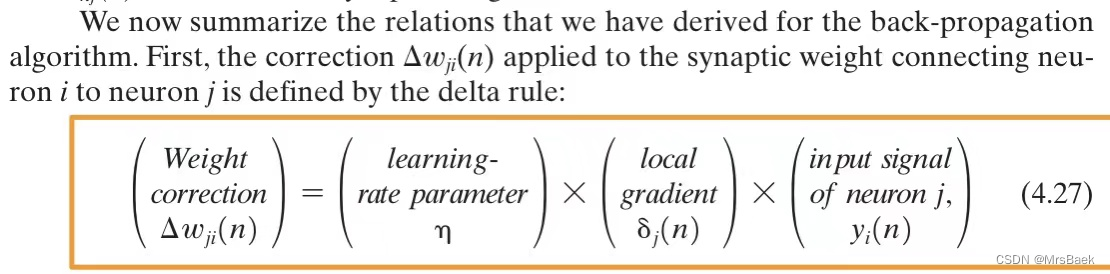

5. 更新参数:使用梯度下降或其他优化算法,根据计算得到的梯度信息更新网络的权重和偏置。

6. 重复步骤2至步骤5,直到达到停止条件(如达到最大迭代次数或误差收敛)。

任意参数v的更新估计式为

误差逆传播算法通过不断地调整网络的权重和偏置,使得网络的输出逐渐接近真实标签,从而实现对训练样本的拟合。它利用了链式法则和梯度下降的思想,高效地计算了网络中每个参数对误差的贡献,从而实现了快速的参数更新。

误差逆传播算法是训练深度神经网络的基础,它为神经网络提供了学习和适应数据的能力,使得网络能够在大规模、复杂的问题上取得优秀的性能。