- 1Mac安装Tesseract的全过程,附带完整的错误和异常的解决办法。Java开源OCR识别_warning: parameter not found: enable_new_segsearch

- 2FPGA - ZYNQ Cache一致性问题

- 3Linux笔记1_虚拟机安装Linux操作系统

- 4『大模型笔记』视觉语言模型解释

- 5Redis的三种限流方法以及代码详解_java redis集群限流

- 6Kubernetes——Kubernetes命令操作集合_k logs -f

- 7【NLP】3 种强大的长文本摘要方法和实例

- 8【深度学习:评估指标】如何在计算机视觉中测量模型性能:综合指南

- 9通过SSH的方式使用Git提交代码_git push提交代码的时候如何调用提交到ssh路径(1)

- 10springboot启动源码分析1——初步初始化_bootstrapregistryinitializer

OpenCV基本图像处理操作(九)——特征匹配

赞

踩

Brute-Force蛮力匹配

Brute-Force蛮力匹配是一种简单直接的模式识别方法,经常用于计算机视觉和数字图像处理领域中的特征匹配。该方法通过逐一比较目标图像中的所有特征点与源图像中的特征点来寻找最佳匹配。这种方法的主要步骤包括:

-

特征提取:首先,从两个待比较的图像中提取关键特征点。这些特征点通常是图像中的角点、边缘或其他显著的图像属性。

-

特征描述:对提取出的每个特征点生成一个描述符,这个描述符捕捉了特征点周围的图像信息,通常是通过一定的算法(如SIFT、SURF或ORB等)来实现。

-

匹配过程:在蛮力匹配中,源图像的每个特征点的描述符都会与目标图像中每个特征点的描述符进行比较。比较通常基于描述符之间的距离度量(如欧氏距离或汉明距离),以找到最相似的匹配对。

-

选择最佳匹配:根据某种标准(如最小距离)从所有可能的匹配中选择最佳匹配。有时也会使用比如比率测试来进一步验证匹配的质量,以排除错误匹配。

虽然Brute-Force匹配方法在小型或中等复杂度的数据集上可以非常有效,但它的计算成本随着特征点数量的增加而显著增加,这可能导致在大规模数据集上的性能问题。因此,它通常被用于那些对实时性要求不是非常高的应用,或者作为复杂匹配算法的初步匹配步骤。

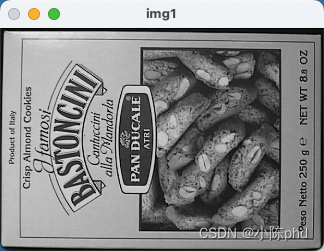

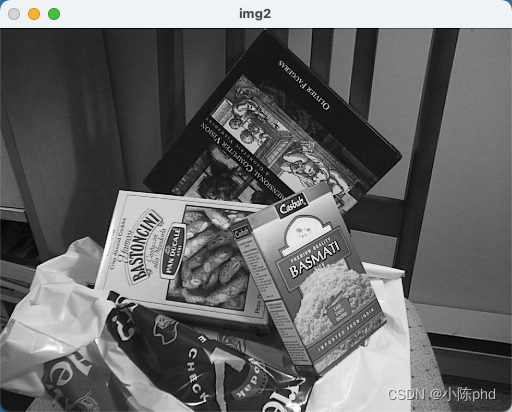

import cv2 import numpy as np import matplotlib.pyplot as plt def cv_show(name,img): cv2.imshow(name, img) cv2.waitKey(0) cv2.destroyAllWindows() img1 = cv2.imread('box.png', 0) img2 = cv2.imread('box_in_scene.png', 0) cv_show('img1',img1) cv_show('img2',img2) sift = cv2.SIFT_create() kp1, des1 = sift.detectAndCompute(img1, None) kp2, des2 = sift.detectAndCompute(img2, None) # crossCheck表示两个特征点要互相匹,例如A中的第i个特征点与B中的第j个特征点最近的,并且B中的第j个特征点到A中的第i个特征点也是 #NORM_L2: 归一化数组的(欧几里德距离),如果其他特征计算方法需要考虑不同的匹配计算方式 bf = cv2.BFMatcher(crossCheck=True)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

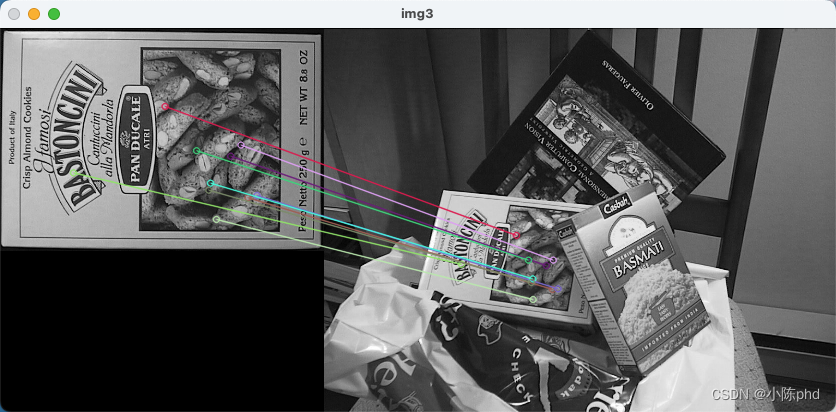

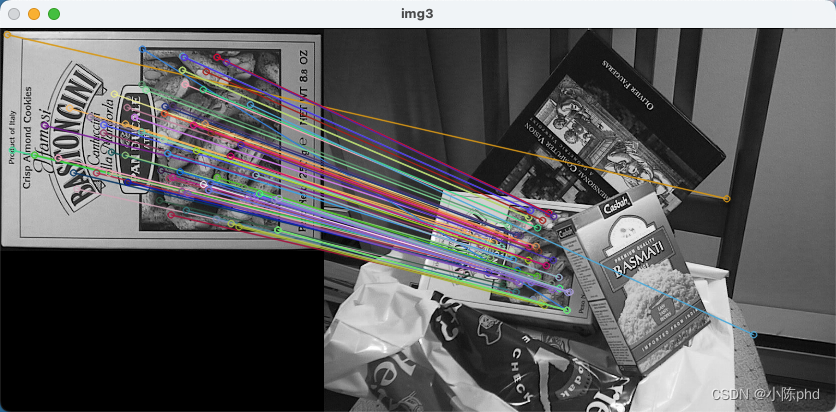

1对1的匹配

matches = bf.match(des1, des2)

matches = sorted(matches, key=lambda x: x.distance)

img3 = cv2.drawMatches(img1, kp1, img2, kp2, matches[:10], None,flags=2)

cv_show('img3',img3)

- 1

- 2

- 3

- 4

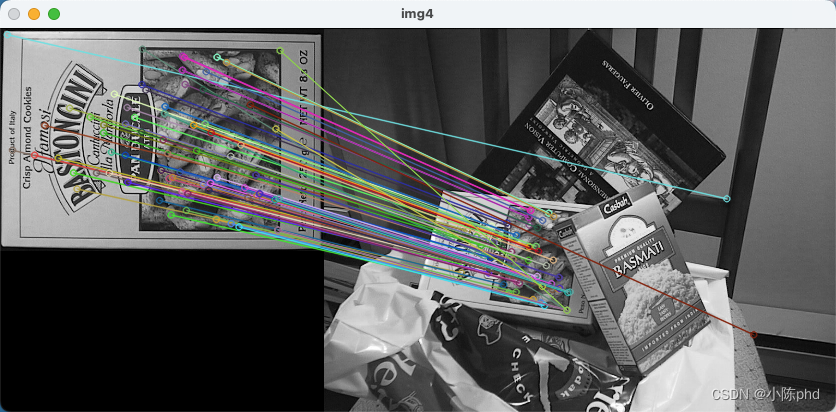

k对最佳匹配

cv2.BFMatcher() 创建一个Brute-Force匹配器对象,该对象可以用来匹配两个图像之间的特征点。Brute-Force匹配是一种在两组特征点之间找到最佳匹配的简单方法,通过计算一个特征点与另一组中所有特征点之间的距离来实现。

然后,knnMatch 方法被用来找到每个描述符的前k个最佳匹配。在这个例子中,k被设为2,这意味着对于第一组描述符中的每个描述符(des1),算法将找到与第二组描述符(des2)中距离最近的两个描述符。这种方法通常用于执行比如SIFT或SURF这类特征描述符的匹配。

返回的matches是一个列表,其中每个元素也是一个列表,包含两个最佳匹配(因为k=2)。这允许进一步的处理,例如使用比率测试来过滤不良匹配。比率测试通常涉及比较两个最佳匹配之间的距离比,如果第一个距离明显小于第二个(例如,小于阈值的50%),那么我们认为这是一个“好”的匹配。这有助于排除错误的匹配,提高匹配质量。

bf = cv2.BFMatcher()

matches = bf.knnMatch(des1, des2, k=2)

good = []

for m, n in matches:

if m.distance < 0.75 * n.distance:

good.append([m])

img3 = cv2.drawMatchesKnn(img1,kp1,img2,kp2,good,None,flags=2)

cv_show('img3',img3)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

如果需要更快速完成操作,可以尝试使用cv2.FlannBasedMatcher

cv2.FlannBasedMatcher() 创建了基于FLANN(Fast Library for Approximate Nearest Neighbors)的匹配器对象。FLANN是一个用于大数据集和高维特征的快速近似最近邻搜索库,通常比Brute-Force匹配在这类情况下执行得更快。

knnMatch 方法同样被用来在两组特征描述符之间找到每个描述符的前k个最佳匹配,这里的 k 设为2。这意味着对于第一组描述符(des1)中的每个描述符,FLANN匹配器将在第二组描述符(des2)中找到两个最近似的匹配。

返回的 matches 是一个列表,每个元素也是一个列表,包含每个描述符的两个最佳匹配。这同样允许进一步的处理,比如通过比率测试来过滤掉那些质量不高的匹配,增强匹配结果的准确性。

bf = cv2.FlannBasedMatcher()

matches = bf.knnMatch(des1, des2, k=2)

good = []

for m, n in matches:

if m.distance < 0.75 * n.distance:

good.append([m])

img4 = cv2.drawMatchesKnn(img1,kp1,img2,kp2,good,None,flags=2)

cv_show('img4',img4)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

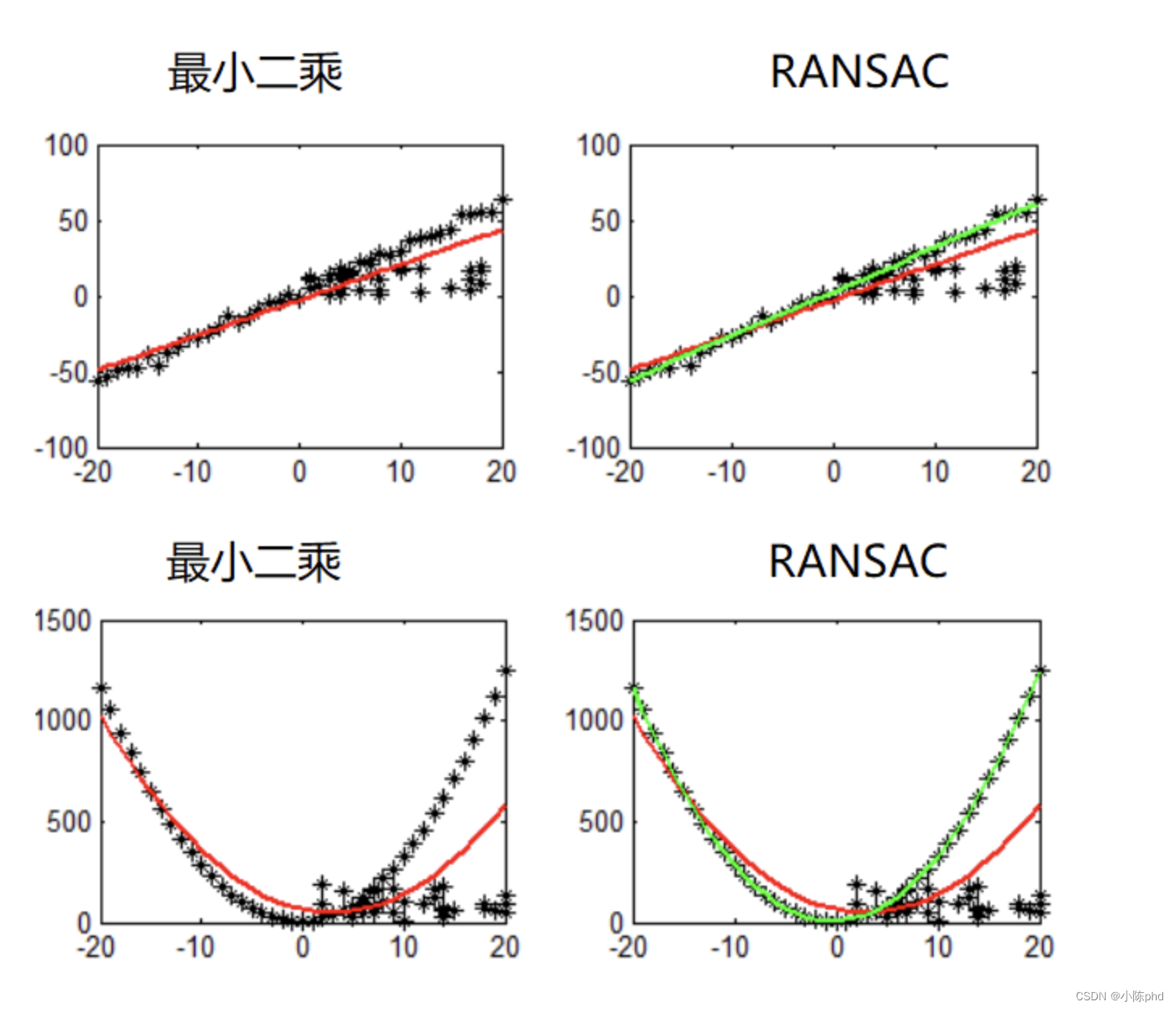

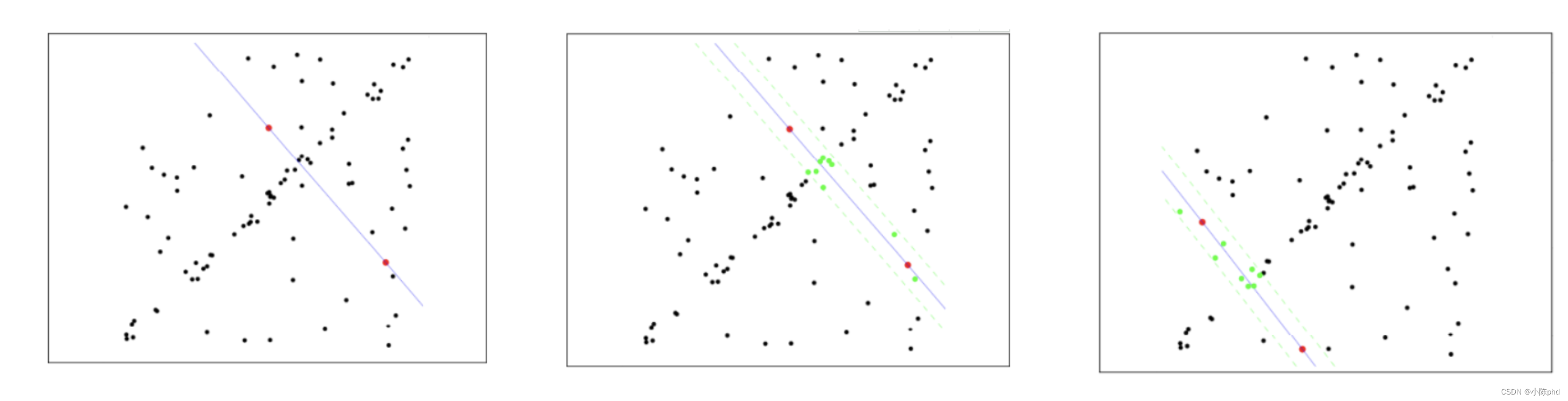

随机抽样一致算法(Random sample consensus,RANSAC)

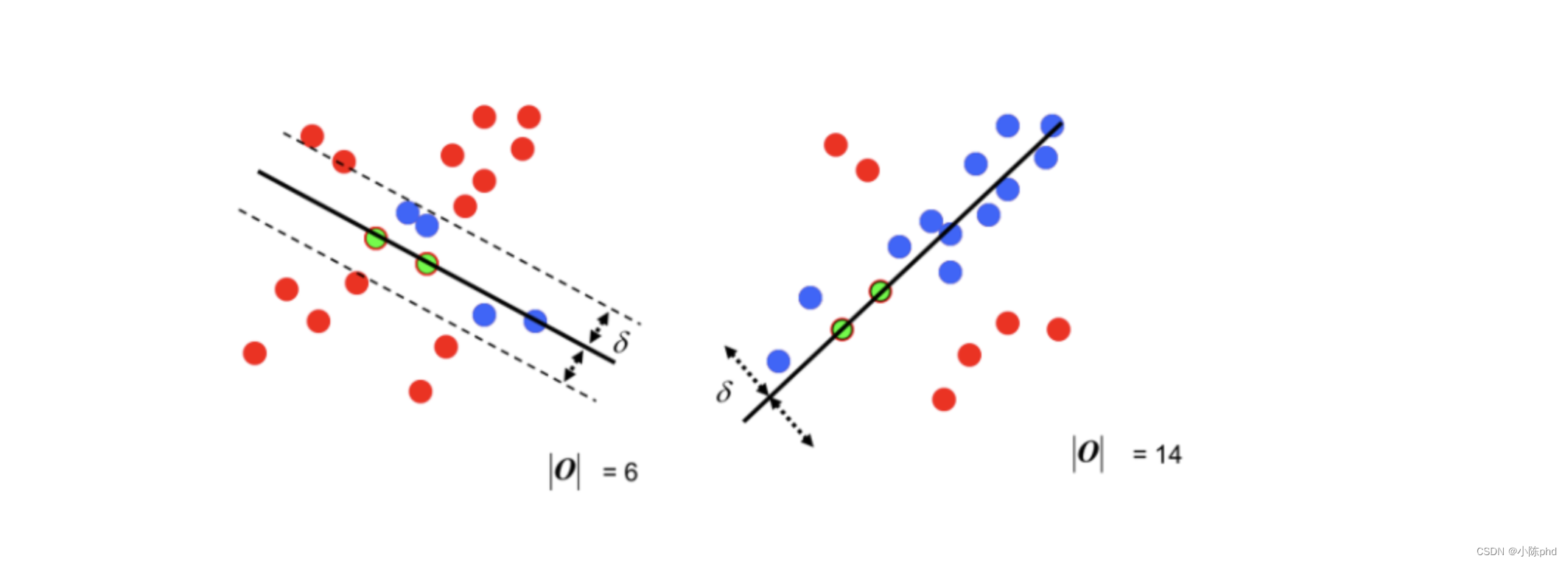

选择初始样本点进行拟合,给定一个容忍范围,不断进行迭代

每一次拟合后,容差范围内都有对应的数据点数,找出数据点个数最多的情况,就是最终的拟合结果

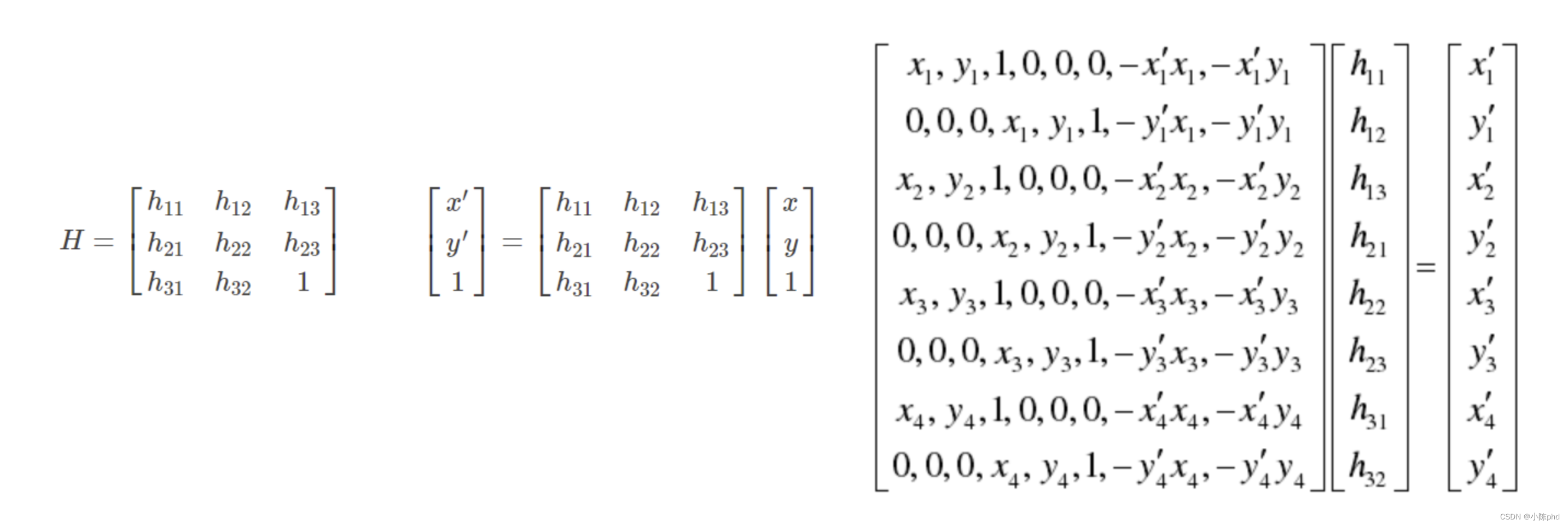

单应性矩阵