- 1python模块gmssl,SM国密算法_python gmssl

- 2HDU 6373(斜面上小球弹跳 运动分解)

- 3C言语哈希表(uthash)简介_c语言uthash

- 4AI平台、AI中台架构

- 5Backend - DRF 序列化(django-rest-framework)

- 6时间复杂度、空间复杂度实践练习(力扣OJ)_时间复杂度和空间复杂度练习

- 7Vscode——运行java项目_vscode 运行java

- 8AdGuard Home 安装使用教程_adguardhome安装教程

- 9极简使用︱Gensim-FastText 词向量训练以及OOV(out-of-word)问题有效解决_glove处理oov

- 10在IntelliJ IDEA社区版中使用 Maven 和 Tomcat 来开发Web应用_smart tomcat maven webapp

Sora 技术报告:作为世界模拟器的视频生成模型_sora实验报告

赞

踩

本文翻译自 OpenAI Sora 技术报告

我们探索在视频数据上开展生成模型的大规模训练。具体来说,我们针对不同时长、分辨率和宽高比的视频及图像,联合训练了基于文本条件的扩散模型。我们采用了对视频和图像潜在编码的时空片段进行操作的 Transformer 架构。我们最大的模型 Sora 能够生成一分钟的高保真视频。结果表明,扩展视频生成模型是构建物理世界通用模拟器的一条有前途的途径。

本技术报告重点关注:

- 我们将所有类型的视觉数据转化为统一表示的方法,从而能够大规模训练生成模型;

- 对 Sora 模型能力和局限性的定性评价。

本报告不包含模型和实施细节。

许多先前的工作已经使用各种方法研究了视频数据的生成建模,包括循环网络1 2 3,生成对抗网络4 5 6 7,自回归 Transformer 8 9和扩散模型10 11 12。这些研究通常关注于特定类别的视觉数据,较短的视频,或是固定尺寸的视频。Sora 是视觉数据的通用模型,它可以生成不同时长、宽高比和分辨率的视频和图像,最多可达一分钟的高清视频。

将视觉数据转化为补片

我们从大语言模型中获得灵感,这些模型通过互联网规模数据的训练来获得通用能力13 14。LLM 范式的成功部分归功于令牌的使用,这些令牌优雅地统一了文本代码、数学和各种自然语言的不同模式。在这项工作中,我们考虑视觉数据的生成模型如何继承这些好处。LLM 有文本标记,而 Sora 有视觉补片(patches)。此前的研究表明,补片是视觉数据模型的有效表示15 16 17 18。我们发现补片是一种高度可扩展且有效的表示形式,可用于在不同类型的视频和图像上训练生成模型。

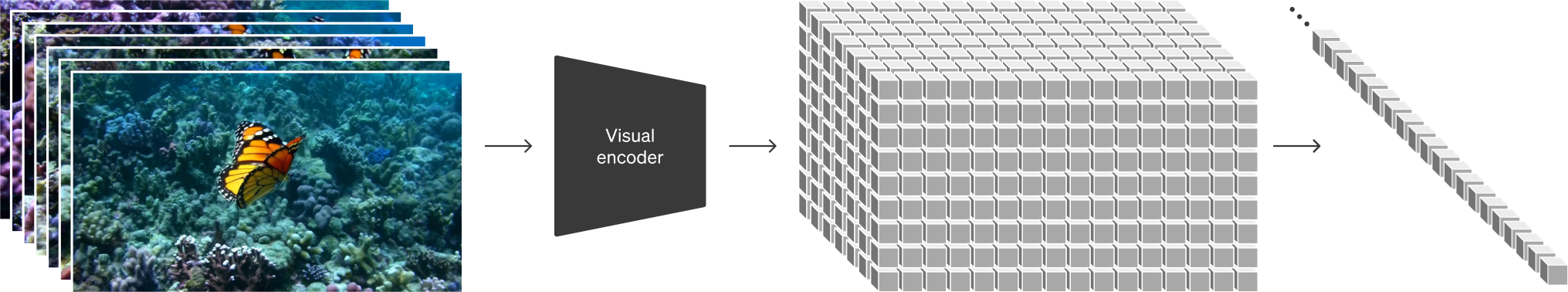

概括地讲,我们首先将视频压缩到低维潜在空间19,然后将表示分解为时空补片,从而将视频转换为补片。

视频压缩网络

我们训练一个降低视觉数据维度的网络20。该网络将原始视频作为输入并输出在时间和空间上压缩的潜在表示。Sora 在这个压缩的潜在空间中接受训练并随后生成视频。我们还训练了相应的解码器模型,将生成的潜在特征映射回像素空间。

时空潜在补片

给定一个压缩的输入视频,我们提取一系列时空补片,充当 Transformer 令牌。该方案也适用于图像,因为图像只是具有单帧的视频。我们基于补片的表示使 Sora 能够对不同分辨率、时长和宽高比的视频和图像进行训练。在推理时,我们可以通过在适当大小的网格中排列随机初始化的补片来控制生成视频的大小。

缩放用于视频生成的 Transformer

Sora 是一种扩散模型21 22 23 24 25;给定输入噪声补片(以及文本提示等调节信息),它被训练来预测原始的“纯净”补片。重要的是,Sora 是一个扩散 Transformer 26。Transformer 在多个领域(包括语言建模13 14、计算机视觉15 16 17 18和图像生成27 28 29)都展示了卓越的缩放特性。

在本研究中,我们发现扩散 Transformer 作为视频模型同样可以有效地缩放。下面,我们比较了训练过程中具有固定种子和输入的视频样本。随着训练计算的增加,样本质量显着提高。

|

基础计算 |

4 倍计算 |

16 倍计算 |

可变时长、分辨率和宽高比

过去的图像和视频生成方法通常会将视频缩放、裁剪或剪辑为标准尺寸,例如 256 × 256 256 \times 256 256×256 分辨率的 4 4 4 秒视频。我们发现,在原始尺寸的数据上进行训练有诸多好处。

灵活的采样能力

Sora 可以采样宽屏 1920 × 1080 1920 \times 1080 1920×1080 视频、垂直 1080 × 1920 1080 \times 1920 1080×1920 视频以及介于两者之间的所有视频。这使得 Sora 可以直接以其原生宽高比为不同设备创建内容。它还使我们能够在以全分辨率生成内容之前快速以较低尺寸制作原型内容 - 所有这些都使用相同的模型。

构图与取景的优化

我们根据经验发现,以原始宽高比对视频进行训练可以改善构图和取景。我们将 Sora 与另一个所有训练视频都裁剪为正方形的模型进行比较,这是训练生成模型时的常见做法。在方形视频上训练的模型(左)有时会生成仅部分可见主体的视频。相比之下,Sora(右)生成的视频能够更好地捕捉完整的场景。

语言理解

训练文本到视频生成系统需要大量带有相应文字说明的视频。我们将 DALL·E 330 中引入的重新标注技术应用于视频。我们首先训练一个高度描述性的文字说明生成器模型,然后使用它为训练集中的所有视频生成文字说明。我们发现,对高度描述性视频文字说明进行训练可以提高文本保真度以及视频的整体质量。

与 DALL·E 3 类似,我们还利用 GPT 将简短的用户提示转换为较长的详细描述,然后再发送到视频模型。这使得 Sora 能够生成准确遵循用户指令的高质量视频。

通过图像和视频进行提示

上文以及首页展示的都是文本到视频的示例。但 Sora 也可以通过其他输入进行提示,例如预先存在的图像或视频。此功能使 Sora 能够执行各种图像和视频编辑任务,包括但不限于创建完美的循环视频、让静态图像动起来、及时向前或向后扩展视频等。

DALL·E 图像动画

Sora 支持以图像和提示作为输入来生成视频。下面我们展示了基于 DALL·E 231 和 DALL·E 330 图像生成的示例视频。

|

一只戴着贝雷帽和黑色高领衫的柴犬。

|

一个包含各种怪物家庭怪物的扁平化设计风格插画。其中包括一个毛茸茸的棕色怪物、一个带有天线的光滑黑色怪物、一个有斑点的绿色怪物和一个小圆点怪物,所有怪物都在一个有趣的环境中互动。

|

写成“SORA”字样的逼真云朵图像。

|

在一座华丽的历史大厅里,巨大的浪潮达到顶峰并开始崩塌。两名冲浪者抓住时机,熟练地驾驭海浪。

扩展生成的视频

Sora 还能够在时间上向前或向后扩展视频。下面是四个视频,它们都是从生成的视频片段开始向后扩展的。因此,这四个视频的开头都不相同,但所有四个视频的结局都是一样的。

我们可以使用此方法向前和向后扩展视频以创造出完美的无限循环。

视频到视频编辑

扩散模型提供了多种根据文本提示编辑图像和视频的方法。下面我们将一种名为 SDEdit32 的方法应用于 Sora。这项技术使 Sora 能够在没有任何示例的情况下改变输入视频的风格和环境。

输入视频

|

将设定更改为郁郁葱葱的丛林。 |

将设定更改为上世纪 20 年代的旧校车,保持车身为红色。 |

|

使其在水下。 |

将视频设定更改为不同于山脉的场景?也许是约书亚树? |

|

将视频放置在太空中,并有一条彩虹路。 |

保持视频相同,但让场景变为冬天。 |

|

用粘土动画风格制作。 |

用炭笔画风格重新创作,确保是黑白的。 |

|

将设定更改为赛博朋克。 |

将视频更改为中世纪主题。 |

|

加入恐龙元素。 |

用像素艺术风格重制视频。 |

视频拼接

我们还可以使用 Sora 在两个输入视频之间逐渐进行插值,从而在具有完全不同主题和场景构成的视频之间创建无缝过渡。在下面的示例中,中间的视频巧妙地融合了左右两侧视频的元素。

图像生成能力

Sora 还能够生成图像。我们通过在时间范围为一帧的空间网格中排列高斯噪声块来实现这一点。该模型可以生成各种尺寸的图像,分辨率高达 2048 × 2048 2048 \times 2048 2048×2048。

秋日中,一位女士的特写肖像,细节惊人,景深浅得令人称奇。 |

一片生机勃勃的珊瑚礁,色彩斑斓的鱼类和海洋生物穿梭其间。 |

苹果树下一只小老虎的数字艺术,采用哑光绘画风格,细节华丽。 |

一座雪山村庄,拥有舒适的小屋和北极光呈现,细节精致,仿佛用 dslr 50mm f/1.2 镜头下拍摄的画面。/p> |

涌现出的模拟能力

我们发现,视频模型在大规模训练时表现出许多引人注目的涌现能力。这些功能使 Sora 能够一定程度上模拟现实世界中人、动物和环境。这种能力的涌现,对 3D、物体等没有任何明确的归纳偏差——它们纯粹是规模现象。

3D 一致性。 Sora 可以生成带有运镜的视频。随着摄像机的移动和旋转,人和场景元素在三维空间中一致移动。

远程相干性和物体持久性。 视频生成系统面临的一个重大挑战是在采样长视频时保持时间一致性。我们发现 Sora 通常(尽管并非总是)能够有效地对短期和长期依赖关系进行建模。例如,我们的模型可以保留人、动物和物体,即使它们被遮挡或移出画面。同样地,它可以在单个样本中生成同一角色的多个镜头,并在整个视频中保持其外观。

与世界互动。 Sora 有时可以用简单的方式模拟影响世界状况的动作。例如,画家可以在画布上留下新的笔触,并随着时间的推移而持续存在,或者一个人吃汉堡可以留下咬痕。

模拟数字世界。 Sora 还能够模拟人工过程——一个例子是视频游戏。Sora 可以通过基本策略控制《我的世界》中的玩家的同时,以高保真度渲染世界及其动态。这些能力可以通过提及“我的世界”的提示让 Sora 在零示例的情况下生成。

这些能力表明,视频模型的持续扩展是开发物理和数字世界以及生活在其中的物体、动物和人物的高性能模拟器的一条有前途的道路。

讨论

Sora 目前作为模拟器表现出许多局限性。例如,它不能准确地模拟许多基本相互作用的物理过程,例如玻璃破碎。其他交互(例如吃食物)并不总会产生对象状态的正确变化。我们在官网首页中列举了模型的其他常见失效模式,例如长时间样本中出现的不连贯性或对象的突然出现。

我们相信,Sora 今天所拥有的能力表明,视频模型的持续扩展是开发物理和数字世界以及生活在其中的物体、动物和人物的强大模拟器的一条有前途的道路。

参考文献

Srivastava, Nitish, Elman Mansimov, and Ruslan Salakhudinov. “Unsupervised learning of video representations using lstms.” International conference on machine learning. PMLR, 2015. ↩︎

Chiappa, Silvia, et al. “Recurrent environment simulators.” arXiv preprint arXiv:1704.02254 (2017). ↩︎

Ha, David, and Jürgen Schmidhuber. “World models.” arXiv preprint arXiv:1803.10122 (2018). ↩︎

Vondrick, Carl, Hamed Pirsiavash, and Antonio Torralba. “Generating videos with scene dynamics.” Advances in neural information processing systems 29 (2016). ↩︎

Tulyakov, Sergey, et al. “Mocogan: Decomposing motion and content for video generation.” Proceedings of the IEEE conference on computer vision and pattern recognition. 2018. ↩︎

Clark, Aidan, Jeff Donahue, and Karen Simonyan. “Adversarial video generation on complex datasets.” arXiv preprint arXiv:1907.06571 (2019). ↩︎

Brooks, Tim, et al. “Generating long videos of dynamic scenes.” Advances in Neural Information Processing Systems 35 (2022): 31769-31781. ↩︎

Yan, Wilson, et al. “Videogpt: Video generation using vq-vae and transformers.” arXiv preprint arXiv:2104.10157 (2021). ↩︎

Wu, Chenfei, et al. “Nüwa: Visual synthesis pre-training for neural visual world creation.” European conference on computer vision. Cham: Springer Nature Switzerland, 2022. ↩︎

Ho, Jonathan, et al. “Imagen video: High definition video generation with diffusion models.” arXiv preprint arXiv:2210.02303 (2022). ↩︎

Blattmann, Andreas, et al. “Align your latents: High-resolution video synthesis with latent diffusion models.” Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2023. ↩︎

Gupta, Agrim, et al. “Photorealistic video generation with diffusion models.” arXiv preprint arXiv:2312.06662 (2023). ↩︎

Vaswani, Ashish, et al. “Attention is all you need.” Advances in neural information processing systems 30 (2017). ↩︎ ↩︎

Brown, Tom, et al. “Language models are few-shot learners.” Advances in neural information processing systems 33 (2020): 1877-1901. ↩︎ ↩︎

Dosovitskiy, Alexey, et al. “An image is worth 16x16 words: Transformers for image recognition at scale.” arXiv preprint arXiv:2010.11929 (2020). ↩︎ ↩︎

Arnab, Anurag, et al. “Vivit: A video vision transformer.” Proceedings of the IEEE/CVF international conference on computer vision. 2021. ↩︎ ↩︎

He, Kaiming, et al. “Masked autoencoders are scalable vision learners.” Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2022. ↩︎ ↩︎

Dehghani, Mostafa, et al. “Patch n’Pack: NaViT, a Vision Transformer for any Aspect Ratio and Resolution.” arXiv preprint arXiv:2307.06304 (2023). ↩︎ ↩︎

Rombach, Robin, et al. “High-resolution image synthesis with latent diffusion models.” Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2022. ↩︎

Kingma, Diederik P., and Max Welling. “Auto-encoding variational bayes.” arXiv preprint arXiv:1312.6114 (2013). ↩︎

Sohl-Dickstein, Jascha, et al. “Deep unsupervised learning using nonequilibrium thermodynamics.” International conference on machine learning. PMLR, 2015. ↩︎

Ho, Jonathan, Ajay Jain, and Pieter Abbeel. “Denoising diffusion probabilistic models.” Advances in neural information processing systems 33 (2020): 6840-6851. ↩︎

Nichol, Alexander Quinn, and Prafulla Dhariwal. “Improved denoising diffusion probabilistic models.” International Conference on Machine Learning. PMLR, 2021. ↩︎

Dhariwal, Prafulla, and Alexander Quinn Nichol. “Diffusion Models Beat GANs on Image Synthesis.” Advances in Neural Information Processing Systems. 2021. ↩︎

Karras, Tero, et al. “Elucidating the design space of diffusion-based generative models.” Advances in Neural Information Processing Systems 35 (2022): 26565-26577. ↩︎

Peebles, William, and Saining Xie. “Scalable diffusion models with transformers.” Proceedings of the IEEE/CVF International Conference on Computer Vision. 2023. ↩︎

Chen, Mark, et al. “Generative pretraining from pixels.” International conference on machine learning. PMLR, 2020. ↩︎

Ramesh, Aditya, et al. “Zero-shot text-to-image generation.” International Conference on Machine Learning. PMLR, 2021. ↩︎

Yu, Jiahui, et al. “Scaling autoregressive models for content-rich text-to-image generation.” arXiv preprint arXiv:2206.10789 2.3 (2022): 5. ↩︎

Betker, James, et al. “Improving image generation with better captions.” Computer Science. https://cdn.openai.com/papers/dall-e-3. pdf 2.3 (2023): 8 ↩︎ ↩︎

Ramesh, Aditya, et al. “Hierarchical text-conditional image generation with clip latents.” arXiv preprint arXiv:2204.06125 1.2 (2022): 3. ↩︎

Meng, Chenlin, et al. “Sdedit: Guided image synthesis and editing with stochastic differential equations.” arXiv preprint arXiv:2108.01073 (2021). ↩︎