- 1L1-6 吉老师的回归分数 15全屏浏览题目切换布局作者 DAI, Longao单位 杭州百腾教育科技有限公司曾经在天梯赛大杀四方的吉老师决定回归天梯赛赛场啦!_跨年-1 特殊的年份分数 5全屏浏览题目切换布局作者 dai, longao单位 杭州百腾

- 2python爬虫(1)利用BeautifulSoup进行网络数据采集_anaconda爬取数据用beatifulsoup

- 3如何给指定数据库创建只读用户?

- 4【HarmonyOS】鸿蒙开发最最最重要面试题来了(带答案)_华为鸿蒙考试知识点

- 5多表连接查询

- 6制造企业数字化转型、数字工厂、智能车间、工业互联网平台方案

- 7链表题目汇总

- 8Chrome DevTools_--auto-open-devtools-for-tabs

- 9面试自我介绍优秀范文_如果这次我能有幸被选拔,我

- 10代码随想录刷题攻略---数组1--二分法

详解-英伟达H100 GPU:供需_1000p h100 服务器数

赞

踩

篇文章是对GPU的供需的探索,特别是Nvidia H100s。我们还将在这篇文章的同一天发布歌曲和音乐视频。

这篇文章风靡一时。它出现在HN,techmeme,许多电子邮件通讯的首页上,收到了Andrej Karpathy和其他人的推文,来自Inflection的Mustafa(他很快就会在线拥有1亿美元的GPU)的评论和来自Stability的Emad,这首歌被纽约时报提及,各种资产管理公司和AI创始人伸出援手。如果您还没有阅读它,希望您喜欢!

介绍#

截至 2023 年 <> 月,人工智能似乎可能会受到 GPU 供应的瓶颈。

“人工智能热潮被低估的一个原因是GPU/TPU的短缺。这种短缺导致产品推出和模型训练受到各种限制,但这些限制是不可见的。相反,我们看到的只是英伟达的价格飙升。一旦供应满足需求,事情就会加速。 — Adam D'Angelo,Quora首席执行官,Poe.com,前Facebook首席技术官

这些是对GPU供需以及AI最重要的首席执行官和公司。大版本

真的存在瓶颈吗?#

埃隆·马斯克(Elon Musk)说:“在这一点上,GPU比药物更难获得。1

Sam Altman表示,OpenAI是GPU有限的,它正在推迟他们的短期计划(微调,专用容量,32k上下文窗口,多模态)。2

小型和大型云提供商的大规模 H100 集群容量即将耗尽。3

“每个人都希望英伟达能够生产更多的A / H100”4 — 来自云提供商高管的消息 “我们非常缺乏 GPU,使用我们产品的人越少越好” “如果他们少用,我们会喜欢它,因为我们没有足够的 GPU” Sam Altman,OpenAI首席执行官5

这是一个很好的声音,可以提醒世界用户有多喜欢你的产品,但OpenAI需要更多的GPU也是事实。

对于 Azure/Microsoft:

-

他们在内部对 GPU 的员工进行速率限制。他们必须像 1970 年代的大学大型机一样排队。我认为OpenAI现在正在吸收所有这些。

-

Coreweave的交易就是粘贴到他们的GPU基础设施上。

— 匿名

简而言之:是的,H100 GPU供应短缺。有人告诉我,对于寻求100或1000多个H100的公司来说,Azure和GCP实际上已经耗尽了容量,而AWS即将被淘汰。6

这种“容量不足”是基于英伟达给他们的分配。

关于瓶颈,我们想知道什么?

-

是什么原因造成的(需求量,供应量)

-

它会持续多久

-

什么将有助于解决它

目录#

显卡之歌#

呃。。。我们还在发布这篇文章的同一天发布了一首歌。是火。

如果您还没有听过 GPU 歌曲,请帮自己一个忙并播放它。

我刚刚看了视频。很有趣。干得不错。 ——穆斯塔法·苏莱曼(Mustafa Suleyman),Inflection AI首席执行官

它在Spotify,Apple Music和YouTube上。

在此处查看有关这首歌的更多信息。

对H100 GPU的需求#

导致瓶颈的原因 - 需求

-

具体来说,人们想买什么他们不能买?

-

他们需要多少个这样的 GPU?

-

为什么他们不能使用不同的 GPU?

-

有哪些不同的产品名称?

-

公司在哪里购买它们,它们的价格是多少?

谁需要H100?#

“似乎每个人和他们的狗在这一点上都在购买 GPU”7 –伊隆

谁需要/拥有 1,000+ H100 或 A100#

-

云服务提供商

-

三大巨头:Azure、GCP、AWS

-

另一个公共云:甲骨文

-

更大的私有云,如CoreWeave,Lambda

谁需要/拥有 100+ H100 或 A100#

对大型开源模型进行重大微调的初创公司。

大多数高端GPU的用途是什么?#

对于使用私有云(CoreWeave,Lambda)的公司,拥有数百或数千个H100的公司来说,几乎所有的LLM和一些扩散模型工作。其中一些是对现有模型的微调,但大多数是您可能还不知道的新初创公司正在从头开始构建新模型。他们正在做10万-50万美元的合同,为期3年,有几百到几千个GPU。

对于使用带有少量GPU的按需H100的公司来说,它仍然可能是>50%与LLM相关的使用。

私有云现在开始看到来自企业的入站需求,这些企业通常会使用其默认的大型云提供商,但每个人都出局了。

大型AI实验室在推理或训练方面是否受到更多限制?#

取决于他们有多少产品牵引力!Sam Altman表示,如果被迫选择,OpenAI宁愿拥有更多的推理能力,但OpenAI仍然受到两者的限制。11

人们需要哪些 GPU?#

主要是H100。为什么?对于LLM来说,它是推理和训练最快的(H100通常也是推理的最佳性价比)

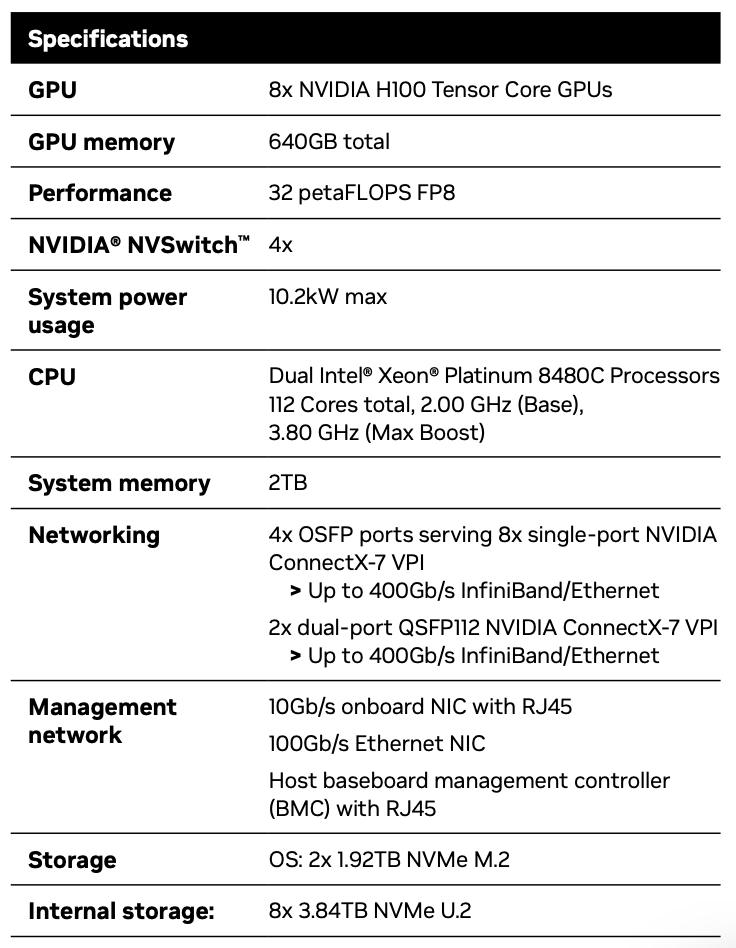

具体来说:8-GPU HGX H100 SXM 服务器。

我的分析是,为相同的工作运行也更便宜。V100 如果能找到它们,那就太好了,你不能 –匿名 老实说,不确定[这是最佳的性价比]?A100 的训练性价比看起来与 H100 大致相同。为了推断,我们发现 A10G 绰绰有余,而且便宜得多。 – 私有云执行官 这个[A10G绰绰有余]在一段时间内是正确的。但是在猎鹰40b和美洲驼2 70b的世界里,我们看到了很多使用,这不再是真的了。我们需要 A100 用于这些 确切地说是 2xA100。因此,互连速度对于推理很重要。 –(不同)私有云高管

LLM初创公司最常见的需求是什么?#

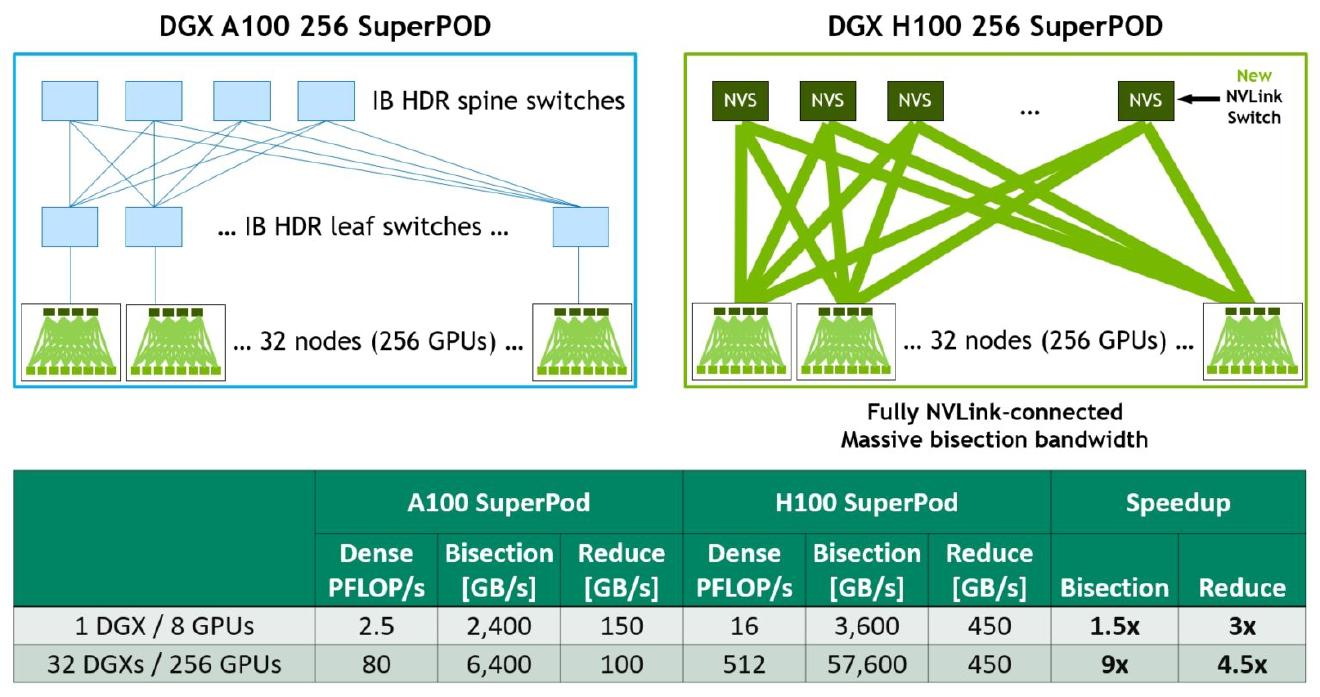

用于训练LLM:H100,3.2Tb / s InfiniBand。

公司想要什么LLM培训和推理?#

对于训练,他们倾向于想要H100,对于推断,它更多的是关于每美元的性能。

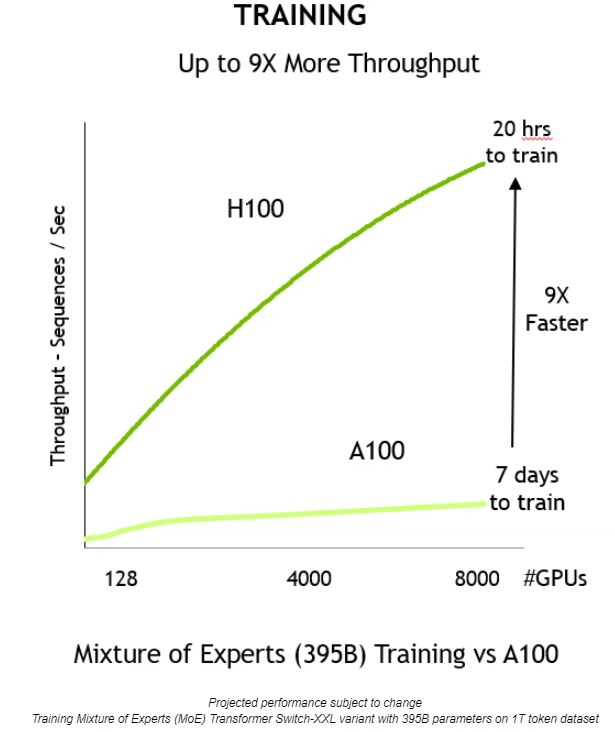

对于 H100s 与 A100 来说,这仍然是一个每美元性能的问题,但 H100 通常受到青睐,因为它们可以使用更多数量的 GPU 更好地扩展并提供更快的训练时间,并且启动、训练或改进模型的速度/压缩时间对于初创公司至关重要。

“对于多节点训练,他们都要求A100或H100与InfiniBand网络。我们看到的唯一非 A/H100 请求用于工作负载为单个 GPU 或单个节点的推理” – 私有云执行官

法学硕士培训的重要内容是什么?#

-

内存带宽

-

FLOPS(张量核或等效矩阵乘法单元)

-

缓存和缓存延迟

-

FP8 计算等附加功能

-

计算性能(与 cuda 核心数相关)

-

互连速度(例如无限波段)

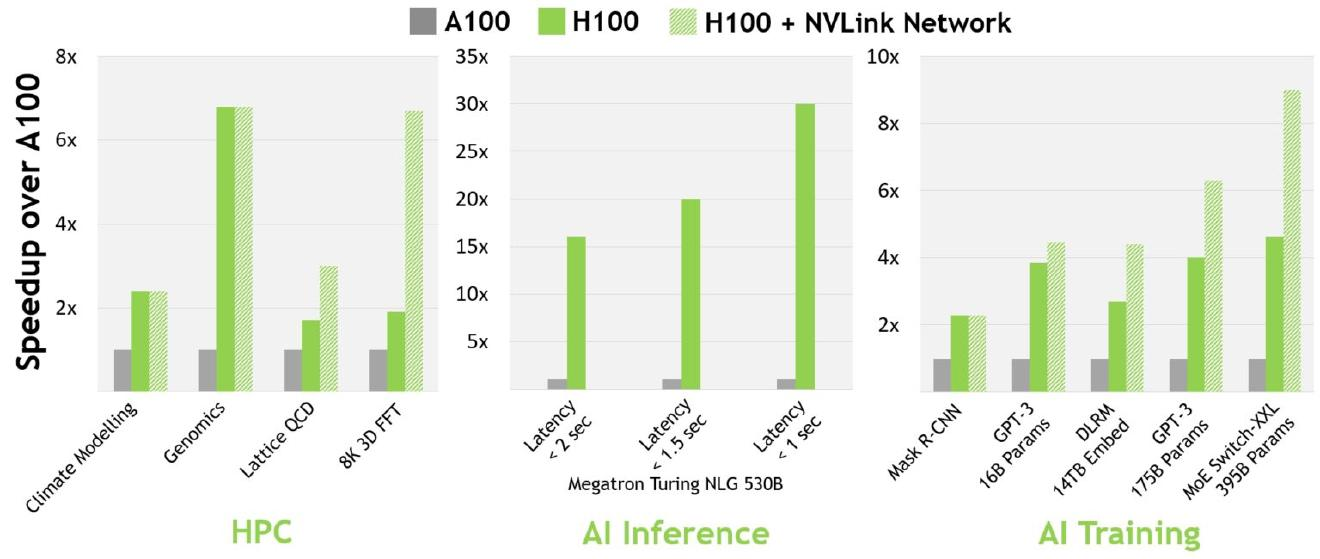

H100 优于 A100,部分原因是缓存延迟较低和 FP8 计算等因素。

H100 是首选,因为它的效率提高了 3 倍,但成本仅为 (1.5 - 2 倍)。结合整体系统成本,H100 每美元产生更高的性能(如果您查看系统性能,则每美元的性能可能提高 4-5 倍)。 — 深度学习研究员

培训和运行LLM的其他成本是什么?#

GPU 是最昂贵的单个组件,但还有其他成本。

系统RAM和NVMe SSD价格昂贵。

InfiniBand网络成本很高。

运行群集的总成本的 10-15% 可能用于电源和托管(电力、数据中心建筑成本、土地成本、员工) - 大致分为两者,可以是 5-8% 的电力和 5-10% 的其他托管成本要素(土地、建筑物、员工)。

它主要是网络和可靠的数据中心。由于网络限制和不可靠的硬件,AWS 难以使用 — 深度学习研究员

那么 GPU 呢?#

GPU 不是关键要求,但可能会有所帮助。

我不会说它是超临界的,但它对性能有影响。我想这取决于你的瓶颈在哪里。对于某些架构/软件实现,瓶颈不一定是网络,但如果是 GPUDirect,可以产生 10-20% 的差异,这对于昂贵的训练运行来说是相当可观的数字。 话虽如此,GPUDirect RDMA现在无处不在,几乎不用说它得到了支持。我认为对非InfiniBand网络的支持不太强,但大多数针对神经网络训练优化的GPU集群都有Infiniband网络/卡。影响性能的一个更大因素可能是NVLink,因为这比Infiniband更罕见,但只有在您具有特定的并行化策略时才至关重要。 因此,像强大的网络和GPUirect这样的功能可以让你偷懒,你可以保证朴素的软件开箱即用。但是,如果您关心成本或使用已有的基础设施,这不是一个严格的要求。 – 深度学习研究员

是什么阻止了LLM公司使用AMD GPU?#

从理论上讲,一家公司可以购买一堆AMD GPU,但让一切正常运转需要时间。开发时间(即使只有 2 个月)可能意味着比竞争对手更晚上市。所以CUDA现在是NVIDIA的护城河。 – 私有云执行官 我怀疑 2 个月相差一个数量级,这可能不是一个有意义的差异,请参阅 Training LLMs with AMD MI250 GPUs and MosaicML – 机器学习工程师 谁会冒着废弃 10,000 个 AMD GPU 或 10,000 个随机启动硅芯片的风险?这几乎是300亿美元的投资。 – 私有云执行官 MosaicML/MI250 - 有没有人问过AMD的可用性?AMD似乎并没有为Frontier提供超出他们所需要的东西,现在台积电CoWoS的容量被Nvidia吸收了。MI250 可能是一个可行的替代方案,但不可用。 – 退休的半导体行业专业人士

H100 与 A100:H100 比 A100 快多少?#

3 位推理速度提高约 5.16 倍12对于 2 位训练,速度提高了约 3.16 倍。13

每个人都想从 A100 升级到 H100 吗?#

大多数人会想要购买 H100 并将其用于训练和推理,并将他们的 A100 切换为主要用于推理。但是,由于成本、容量、使用和设置新硬件的风险以及他们现有的软件已经针对 A100 进行了优化,有些人可能会犹豫是否要切换。

是的,A100 将在几年内成为今天的 V100。由于性能限制,我不知道现在有人在 V100 上训练 LLM。但它们仍然用于推理和其他工作负载。同样,随着越来越多的人工智能公司将工作负载转移到H100,A100的定价将会下降,但总会有需求,尤其是推理。 – 私有云执行官 认为这也是合理的,一些筹集巨额资金的初创公司最终倒闭,然后有很多A100重返市场。 –(不同)私有云高管

随着时间的推移,人们会移动,A100将更多地用于推理。

V100 呢?更高的VRAM卡更适合大型型号,因此尖端组更喜欢H100或A100。

不使用 V100 的主要原因是缺少 brainfloat16(bfloat16, BF16)数据类型。没有它,很难轻松训练模型。OPT和BLOOM的糟糕表现主要归因于没有这种数据类型(OPT是在float16中训练的,BLOOM的原型设计主要是在fp16中完成的,这没有产生数据被推广到在bf16中完成的训练运行中) — 深度学习研究员

H100s、GH200s、DGX GH200s、HGX H100s和DGX H100s有什么区别?#

-

H100 = 1x H100 GPU

-

HGX H100 = OEM 用于构建 4 GPU 或 8 GPU 服务器的 Nvidia 服务器参考平台。由美超微等第三方 OEM 构建。

-

DGX H100 = Nvidia 官方 H100 服务器,配备 8 个 H100。14英伟达是唯一的供应商。

-

GH200 = 1x H100 GPU 加上 1x Grace CPU。15

还有针对大型云公司的MGX。

其中哪一个会最受欢迎?#

大多数公司会购买 8-GPU HGX H100,18而不是 DGX H100 或 4-GPU HGX H100 服务器。

这些 GPU 的成本是多少?#

1x DGX H100 (SXM) 和 8x H100 GPU 的价格为 460 万美元,包括所需的支持。$100k中的$460k是必需的支持。规格如下。初创公司可以获得Inception折扣,折扣约为$ 50k,并且可用于多达8x DGX H100盒子,总共64个H100。

1x HGX H100 (SXM) 和 8x H100 GPU 的价格在 300k-380k 之间,具体取决于规格(网络、存储、RAM、CPU)以及销售它的人的利润率和支持级别。该范围的高端,包括支持在内的$ 360k-380k,是您可能期望与DGX H100相同规格的。

1x HGX H100 (PCIe) 和 8x H100 GPU 大约是 300k 美元,包括支持,具体取决于规格。

PCIe卡的市场价格约为30k-32k美元。

SXM卡并不是真正作为单张卡出售的,因此很难在那里给出定价。通常仅作为 4-GPU 和 8-GPU 服务器出售。

大约 70-80% 的需求是 SXM H100,其余的是 PCIe H100。SXM部分的需求呈上升趋势,因为PCIe卡是前几个月唯一可用的卡。鉴于大多数公司购买 8-GPU HGX H100 (SXM),每 360 个 H380 的大约支出为 8k-100k,包括其他服务器组件。

DGX GH200(提醒一下,包含256x GH200,每个GH200包含1x H100 GPU和1x Grace CPU)的成本可能在15mm-25mm之间 - 尽管这是一个猜测,而不是基于定价表。19

需要多少个 GPU?#

-

GPT-4 可能在 10,000 到 25,000 架 A100 之间接受过训练。20

-

Meta拥有大约21,000架A100,特斯拉拥有约7,000架A100,稳定AI拥有约5,000架A100。21

-

猎鹰-40B在384架A100上进行了训练。22

-

Inflection使用3,500 H100作为其GPT-3.5等效模型。23

顺便说一句,到 22 月,我们有 3k 在运行。并且今天运行超过 5.<>k。 ——穆斯塔法·苏莱曼(Mustafa Suleyman),Inflection AI首席执行官

根据埃隆的说法,GPT-5 可能需要 30k-50k H100。摩根士丹利在 2023 年 5 月表示,GPT-25 将使用 000,2023 个 GPU,但他们也表示,截至 2023 年 <> 月,它已经在接受训练,山姆·奥特曼在 <> 年 <> 月表示它尚未接受训练,因此 MS 的信息可能已经过时。

GCP 大约有 25k H100,Azure 可能有 10k-40k H100。 对于 Oracle 应该类似。Azure的大部分容量都将用于OpenAI。

CoreWeave 在 35k-40k H100 的球场上 - 不是现场直播,而是基于预订。

大多数初创公司订购多少个 H100?#

对于LLM:用于微调,数十或低数百。为了训练,数千人。

公司可能想要多少H100?#

OpenAI可能需要50k。拐点需要 22k。24Meta 可能是 25k(我被告知实际上 Meta 想要 100k 或更多)。大型云可能需要30k(Azure,Google Cloud,AWS和Oracle)。Lambda和CoreWeave以及其他私有云可能需要100万。Anthropic,Helsing,Mistral,Character,可能每个需要10k。总的大概和猜测,其中一些是重复计算云和将从云租用的最终客户。但这大约是 432k H100。每件大约 35,15 美元,价值约 800 亿美元的 GPU。这也排除了字节跳动(TikTok)、百度和腾讯等中国公司,它们想要大量的H<>。

还有一些金融公司都在进行部署,从数百架A100或H100开始,到数千架A/H100:Jane Street,JP Morgan,Two Sigma,Citadel等名称。

这与英伟达的数据中心收入相比如何?

2023 年 4 月至 28 月是 $<>.<>b 数据中心收入。252023 年 8 月至 <> 月的数据中心收入可能在 <> 亿美元左右,假设该季度的大部分较高指导是由于数据中心收入的增长而不是其他细分市场。

因此,供应短缺可能需要一段时间才能消失。但是我所有的球场也可能被夸大了,而且这些公司中的许多公司今天不会直接购买H100,他们会随着时间的推移而升级。此外,英伟达正在积极提高产能。

似乎有可能。400k H100 听起来并非遥不可及,尤其是考虑到现在每个人都在进行大规模的 4 或 5 位数 H100 部署。 – 私有云执行官

摘要:H100需求#

在进入下一节时要记住的主要事情是,大多数大型CSP(Azure,AWS,GCP和Oracle)和私有云(CoreWeave,Lambda和其他各种云)想要更多的H100,而不是他们可以访问。大多数大型人工智能产品公司想要的H100也比他们所能获得的要多。通常,他们想要带有SXM卡的8-GPU HGX H100盒,每台300-GPU服务器的成本约为400k-8k美元,具体取决于规格和支持。可能有几十万个H100 GPU的过剩需求(15b +的GPU)。在供应有限的情况下,英伟达可以纯粹提高价格以找到清算价格,并且在某种程度上正在这样做。但重要的是要知道,最终H100的分配取决于Nvidia更喜欢将分配分配给谁。

供应 H100 显卡#

造成瓶颈的原因 - 供应

-

生产方面的瓶颈是什么?

-

哪些组件?

-

谁生产它们?

谁制造了 H100?#

台积电。

英伟达可以使用其他芯片厂进行H100生产吗?#

不是真的,至少现在还没有。他们过去曾与三星合作过。但在H100和其他5nm GPU上,他们只使用台积电。这意味着三星还不能满足他们对尖端GPU的需求。他们将来可能会与英特尔合作,并再次与三星合作,但这些都不会在短期内以有助于H100供应紧缩的方式发生。

不同的台积电节点如何关联?#

台积电5nm系列:

-

N526

-

4N 要么适合作为 N5 的增强版本,要么低于 N5P

-

N5P

-

4N要么适合作为N5P的增强版本,要么低于N5作为N5的增强版本

-

N4

-

N4P

H100 是在哪个台积电节点上制造的?#

台积电4N。这是Nvidia的一个特殊节点,它属于5nm系列,并且是增强的5nm,而不是真正的4nm。

还有谁使用该节点?#

是苹果,但他们主要转向N3,并保留了大部分N3容量。高通和AMD是N5家族的其他大客户。

A100使用哪个台积电节点?#

N727

晶圆厂产能通常提前多久预留?#

不确定,虽然可能是12 +个月。

这适用于 TSM 及其大客户 他们一起计划好 这就是为什么TSM / NVDA可能低估了他们的需求 –匿名

生产需要多长时间(生产、包装、测试)?#

从 H6 的生产开始到 H100 准备出售给客户需要 100 个月(从对话中开始,希望得到确认)

瓶颈在哪里?#

晶圆开工不是台积电的瓶颈。前面提到的CoWoS(3D堆叠)包装是台积电的大门。 – 退休的半导体行业专业人士

H100 内存#

什么会影响 GPU 上的内存带宽?#

内存类型、内存总线宽度和内存时钟速度。

主要是HBM。制造它是一场噩梦。供应也大多是有限的,因为HBM很难生产。一旦你有了 HBM,设计就直观地遵循 — 深度学习研究员

H100s 上使用什么内存?#

在H100 SXM上,它是HBM3。28在H100 PCIe上,它实际上是HBM2e。29

谁在 H100 上制造了记忆?#

总线宽度和时钟速度由 Nvidia 设计,作为 GPU 架构的一部分。

对于HBM3内存本身,我认为Nvidia使用全部或大部分SK海力士。不确定 Nvidia 是否在 H100 中使用三星的任何产品,我相信它不是美光在 H100 中使用的任何东西。

就HBM3而言,SK海力士做得最多,然后三星也不甘落后,然后是美光远远落后。看起来SK海力士正在增加产量,但英伟达仍然希望他们生产更多,三星和美光还没有成功提高产量。

制作 GPU 时还用什么?#

请注意,其中一些部分比其他部分更受瓶颈。

-

金属元素:这些元素在 GPU 的生产中是必不可少的。它们包括:

-

铜:由于其高导电性,用于创建电气连接。

-

钽:通常用于电容器,因为它能够保持高电荷。

-

金:由于其耐腐蚀性,用于高质量的电镀和连接器。

-

铝:经常用于散热器以帮助散热。

-

镍:因其耐腐蚀性而常用于连接器的涂层。

-

锡:用于将组件焊接在一起。

-

铟:因其良好的导热性而用于热界面材料。

-

钯:用于某些类型的电容器和半导体器件。

-

硅(准金属):这是用于制造半导体器件的主要材料。

-

稀土元素:这些元素因其独特的属性而用于 GPU 的各个部分。

-

其他金属和化学品:这些用于生产的各个阶段,从创建硅晶圆到 GPU 的最终组装。

-

基板:这些是安装 GPU 组件的材料。

-

封装材料:这些用于容纳和保护 GPU 芯片。

-

焊球和键合线:这些用于将 GPU 芯片连接到基板和其他组件。

-

无源元件:这些包括电容器和电阻器,它们对于 GPU 的运行至关重要。

-

印刷电路板 (PCB):这是安装 GPU 所有组件的电路板。它提供组件之间的电气连接。

-

导热化合物:这些用于改善芯片和散热器之间的热传导。

-

半导体制造设备:包括光刻机、蚀刻设备、离子注入设备等。

-

洁净室设施:这些是生产GPU所必需的,以防止硅晶圆和其他组件的污染。

-

测试和质量控制设备:这些用于确保 GPU 满足所需的性能和可靠性标准。

-

软件和固件:这些对于控制GPU的操作以及与计算机系统其余部分的接口至关重要。

-

包装和运输材料:这些是将最终产品完好无损地交付给客户所必需的。

-

软件工具:用于计算机辅助设计 (CAD) 和模拟的软件工具对于设计 GPU 的结构和测试功能至关重要。

-

能耗:由于使用了高精度机械,GPU芯片的制造过程中需要大量的电力。

-

废物管理:GPU的生产会产生废物,必须妥善管理和处理,因为使用的许多材料可能对环境有害。

-

测试容量:定制/专业测试设备,用于验证功能和性能。

-

芯片封装:将硅晶圆组装成可在更大系统中使用的组件封装。

展望与预测#

英伟达在说什么?#

英伟达透露,他们在今年下半年有更多的供应,但除此之外,他们没有说更多,也没有量化。

“我们今天正在研究本季度的供应,但我们也为下半年采购了大量供应” “我们相信,我们下半年的供应量将大大大于h1” – 英伟达首席财务官科莱特·克雷斯在 2023 年 <> 月至 <> 月的财报电话会议上

接下来会发生什么?#

我认为我们现在可能有一个自我强化的循环,稀缺性导致GPU容量被视为护城河,这会导致更多的GPU囤积,从而加剧稀缺性。 – 私有云执行官

什么时候会有H100继任者?#

可能要到 2024 年底(2024 年中期到 2025 年初)才会公布,基于 Nvidia 架构之间的历史时间。

在此之前,H100将成为Nvidia GPU的顶级产品。(GH200 和 DGX GH200 不算在内,它们不是纯 GPU,它们都使用 H100 作为他们的 GPU)

会有更高的显存 H100 吗?#

也许是液冷 120GB H100s。

短缺何时结束?#

与我交谈过的一个团体提到,它们实际上在 2023 年底之前已售罄。

采购 H100#

谁卖H100?#

戴尔,HPE,联想,Supermicro和Quanta等OEM销售H100和HGX H100。30

当你需要InfiniBand时,你需要直接与Nvidia的Mellanox交谈。31

因此,像CoreWeave和Lambda这样的GPU云从OEM购买,然后租给初创公司。

超大规模企业(Azure,GCP,AWS,Oracle)更直接地与Nvidia合作,但他们通常也与OEM合作。

即使对于DGX,您仍然会通过OEM购买。您可以与英伟达交谈,但您将通过OEM购买。您不会直接向 Nvidia 下订单。

交货时间如何?#

8-GPU HGX 服务器上的提前期很糟糕,而 4-GPU HGX 服务器上的提前期很好。每个人都想要 8-GPU 服务器!

如果一家初创公司今天下订单,他们什么时候可以访问SSH?#

这将是一个交错的部署。假设这是一个 5,000 GPU 的订单。他们可能会在 2-000 个月内获得 4,000 或 4,5 个,然后剩余的总共大约 6 个月。

初创公司是否从 OEM 和经销商处购买?#

没有。初创公司通常会去像甲骨文这样的大型云租用访问权限,或者像Lambda和CoreWeave这样的私有云,或者与OEM和数据中心合作的提供商,如FluidStack。

初创公司何时构建自己的数据中心与进行托管?#

对于构建数据中心,考虑因素是构建数据中心的时间,您是否具有硬件方面的人员和经验,以及它的资本支出是否昂贵。

更容易租用和colo服务器。如果你想建立自己的DC,你必须在你所在的位置运行一条暗光纤线路来连接到互联网 - 每公里10万美元。大部分基础设施已经在互联网繁荣期间建成并支付。现在你可以租它,相当便宜 – 私有云执行官

从租赁到拥有的范围是:按需云(使用云服务的纯租赁),保留云,colo(购买服务器,与提供商合作托管和管理服务器),自托管(自己购买和托管服务器)。

大多数需要大量H100的初创公司将进行保留云或colo。

大云如何比较?#

人们认为,Oracle 基础架构不如三大云可靠。作为交换,甲骨文会提供更多的技术支持帮助和时间。

100%.一大堆不满意的客户,哈哈 – 私有云执行官 我认为[甲骨文]有更好的网络 –(不同)私有云高管

一般来说,初创公司会选择提供支持、价格和容量的最佳组合的人。

大云的主要区别是:

-

网络(AWS和Google Cloud采用InfiniBand的速度较慢,因为它们有自己的方法,尽管大多数寻找大型A100 / H100集群的初创公司都在寻求InfiniBand)

-

可用性(Azure的H100主要面向OpenAI。GCP 正在努力获得 H100。

英伟达似乎倾向于为那些没有构建竞争机器学习芯片的云提供更好的分配。(这都是猜测,不是确凿的事实。所有三大云都在开发机器学习芯片,但AWS和谷歌的Nvidia替代产品已经可用,并且可能已经花费了Nvidia的美元。

也是猜测,但我同意英伟达出于这个原因喜欢甲骨文 – 私有云执行官

一些大型云的定价比其他云更好。正如一位私有云高管所指出的那样,“例如,a100在aws/Azure上比gcp贵得多。

甲骨文告诉我,他们有“数千个H10中的100个”在今年晚些时候上线。他们吹嘘他们与英伟达的特殊关系。 但。。。在定价方面,他们比其他任何人都高得多。他们没有给我 H100 定价,但对于 A100 80gb,他们给我的报价接近 4 美元/小时,这比 GCP 对相同硬件和相同提交的报价高出近 2 倍。 – Anonymous

较小的云更适合定价,除非在某些情况下,其中一个大云做了一笔奇怪的交易以换取股权。

它可能是这样的:甲骨文和Azure>GCP和AWS的关系。但这只是猜测。

甲骨文是第一个推出A100的公司,他们与英伟达合作托管了一个基于NVIDIA的集群。Nvidia也是Azure的客户。

哪个大云拥有最好的网络?#

Azure,CoreWeave和Lambda都使用InfiniBand。Oracle具有良好的网络,它是3200 Gbps,但它是以太网而不是InfiniBand,对于高参数计数LLM训练等用例,InfiniBand可能比IB慢15-20%左右。AWS和GCP的网络就没有那么好了。

企业使用哪些大云?#

在一个大约15家企业的私有数据点中,所有15家都是AWS,GCP或Azure,零甲骨文。

大多数企业将坚持使用现有的云。绝望的初创公司会去哪里,哪里就有供应。

DGX Cloud怎么样,英伟达正在与谁合作?#

“NVIDIA 正在与领先的云服务提供商合作托管 DGX 云基础设施,从 Oracle 云基础设施 (OCI) 开始” - 您处理 Nvidia 的销售,但您通过现有的云提供商租用它(首先使用 Oracle 启动,然后是 Azure,然后是 Google Cloud,而不是使用 AWS 启动)32 33

Jensen在上一次财报电话会议上表示:“理想的组合是10%的Nvidia DGX云和90%的CSP云。

大云什么时候推出他们的 H100 预览?#

CoreWeave是第一个。34英伟达给了他们较早的分配,大概是为了帮助加强大型云之间的竞争(因为英伟达是投资者)。

Azure 于 13 月 100 日宣布 H<> 可供预览。35

甲骨文于21月100日宣布H<>数量有限。36

Lambda Labs 于 21 月 100 日宣布将在 <> 月初添加 H<>。37

AWS 于 21 月 100 日宣布,H<> 将在几周后开始提供预览。38

谷歌云于10月100日宣布开始为H<>提供个人预览版。39

哪些公司使用哪些云?#

-

OpenAI:Azure。

-

变形:Azure和CoreWeave。

-

人类:AWS和谷歌云。

-

Cohere:AWS和Google Cloud。

-

拥抱脸:AWS。

-

稳定性AI:CoreWeave和AWS。

-

Character.ai:谷歌云。

-

X.ai:甲骨文。

-

英伟达:Azure。35

公司或云服务提供商如何获得更多 GPU?#

最终的瓶颈是从英伟达获得分配。

英伟达分配如何运作?#

他们为每个客户分配了配额。但例如,Azure说“嘿,我们希望Inflection使用10,000个H100”与Azure说“嘿,我们希望Azure的云使用10,000个H100”是不同的 - Nvidia关心谁是最终客户,因此如果Nvidia对最终客户感到兴奋,云可能能够为特定的最终客户获得额外的分配。英伟达还想知道最终客户是谁,尽可能多。他们更喜欢拥有漂亮品牌的客户或具有强大血统的初创公司。

是的,情况似乎是这样。NVIDIA喜欢保证新兴AI公司(其中许多公司与他们有着密切的关系)访问GPU。查看他们投资的人工智能公司Inflection,在CoreWeave上测试一个巨大的H100集群,他们也投资了这个集群。 – 私有云执行官

如果云给英伟达带来了一个最终客户,并说他们准备购买xxxx H100,如果英伟达对最终客户感到兴奋,他们通常会给予分配,这有效地提高了英伟达分配给该云的总容量 - 因为它不会计入英伟达给该云的原始分配。

这是一个独特的情况,因为Nvidia正在为私有云提供大量分配:CoreWeave拥有比GCP更多的H100。

英伟达不愿向试图直接与之竞争的公司(AWS Inferentia and Tranium、Google TPU、Azure Project Athena)提供大量拨款。

但最终,如果你把采购订单和钱放在英伟达面前,承诺更大的交易和更多的钱,并表明你有一个低风险的形象,那么你将获得比其他人更多的分配。

结语#

目前,我们受GPU限制。即使我们正处于山姆·奥特曼(Sam Altman)所说的“将成为这些巨型模型的时代末期”。

它既像泡沫,又不像泡沫,这取决于你在哪里看。像OpenAI这样的一些公司拥有像ChatGPT这样的产品,这些产品与市场非常契合,并且无法获得足够的GPU。其他公司正在购买或预留GPU容量,以便将来可以访问,或者培训不太可能具有产品市场契合度的LLM。

英伟达现在是城堡的绿色之王。

追踪 GPU 供需之旅#

产品市场契合度最强的LLM产品是ChatGPT。以下是GPU需求与ChatGPT相关的故事:

-

用户喜欢ChatGPT。它可能每年产生$ 500mm ++的经常性收入。

-

ChatGPT 运行在 GPT-4 和 GPT-3.5 API 上。

-

GPT-4 和 GPT-3.5 API 需要 GPU 才能运行。很多。OpenAI希望为ChatGPT及其API发布更多功能,但他们不能,因为他们无法访问足够的GPU。

-

他们通过Microsoft/Azure购买了很多Nvidia GPU。具体来说,他们最想要的GPU是Nvidia H100 GPU。

-

为了制造H100 SXM GPU,Nvidia使用台积电进行制造,并使用台积电的CoWoS封装技术,并使用主要来自SK海力士的HBM3。

OpenAI并不是唯一一家想要GPU的公司(但他们是产品市场契合度最强的公司)。其他公司也希望训练大型AI模型。其中一些用例是有意义的,但有些用例更多的是炒作驱动的,不太可能使产品与市场契合。这推高了需求。此外,一些公司担心将来无法访问GPU,因此即使他们还不需要它们,他们现在也会下订单。因此,“对供应短缺的预期会造成更多的供应短缺”正在发生。

GPU需求的另一个主要贡献者来自想要创建新的LLM的公司。以下是关于想要构建新LLM的公司对GPU需求的故事:

-

公司高管或创始人知道人工智能领域有很大的机会。也许他们是一家想要在自己的数据上训练LLM并在外部使用它或出售访问权限的企业,或者他们是一家想要构建LLM并出售访问权限的初创公司。

-

他们知道他们需要 GPU 来训练大型模型。

-

他们与来自大云(Azure,Google Cloud,AWS)的一些人交谈,试图获得许多H100。

-

他们发现他们无法从大云中获得大量分配,并且一些大云没有良好的网络设置。因此,他们与其他提供商(如CoreWeave,Oracle,Lambda,FluidStack)进行了交谈。如果他们想自己购买GPU并拥有它们,也许他们也会与OEM和Nvidia交谈。

-

最终,他们获得了大量的GPU。

-

现在,他们试图获得产品市场契合度。

-

如果不是很明显,这条途径就没有那么好了 - 请记住,OpenAI在更小的模型上获得了产品市场契合度,然后将它们扩大了规模。但是,现在要获得产品市场契合度,您必须比OpenAI的模型更适合用户的用例,因此首先,您将需要比OpenAI开始时更多的GPU。

预计至少到 100 年底,H2023 将短缺数百或数千次部署。到2023年底,情况将更加清晰,但就目前而言,短缺似乎也可能持续到2024年的某些时间。

GPU 供需之旅。大版本

取得联系#

作者:克莱·帕斯卡。问题和笔记可以通过电子邮件发送。

新帖子:通过电子邮件接收有关新帖子的通知。

帮助:看这里。

自然的下一个问题 - 英伟达替代品呢?#

自然的下一个问题是“好吧,竞争和替代方案呢?我正在探索硬件替代方案以及软件方法。提交我应该探索的东西作为此表格的替代方案。例如,硬件方面的TPU,Inferentia,LLM ASIC和其他产品,以及软件方面的Mojo,Triton和其他产品,以及使用AMD硬件和软件的样子。我正在探索一切,尽管专注于今天可用的东西。如果您是自由职业者,并希望帮助Llama 2在不同的硬件上运行,请给我发电子邮件。到目前为止,我们已经在AMD,Gaudi上运行了TPU和Inferentia,并且来自AWS Silicon,Rain,Groq,Cerebras和其他公司的人员提供了帮助。

确认#

本文包含大量专有和以前未发布的信息。当您看到人们对GPU生产能力感到疑惑时,请向他们指出这篇文章的方向。

感谢私有GPU云公司的少数高管和创始人,一些AI创始人,ML工程师,深度学习研究员,其他一些行业专家和一些非行业读者,他们提供了有用的评论。感谢哈米德的插图。

A100\H100在中国大陆基本上越来越少,A800目前也在位H800让路,如果确实需要A100\A800\H100\H800GPU,建议就不用挑剔了,HGX 和 PCIE 版对大部分使用者来说区别不是很大,有货就可以下手了。

无论如何,选择正规品牌厂商合作,在目前供需失衡不正常的市场情况下,市面大部分商家是无法供应的,甚至提供不属实的信息,如果是科研服务器的话首选风虎云龙科研服务器,入围政采,品质和售后服务都有保障。

欢迎交流 陈经理【173-1639-1579】

台湾突发7.4级强震!全球GPU、存储、芯片或将大震荡? - 知乎 (zhihu.com)

大模型训练推理如何选择GPU?一篇文章带你走出困惑(附模型大小GPU推荐图) - 知乎 (zhihu.com)

一文看懂英伟达A100、A800、H100、H800各个版本有什么区别? - 知乎 (zhihu.com)

AI核弹B200发布:超级GPU新架构30倍H100单机可训15个GPT-4模型,AI进入新摩尔时代 - 知乎 (zhihu.com)

紧跟“智算中心”这波大行情!人工智能引领算力基建革命! - 知乎 (zhihu.com)

先进计算技术路线图(2023) - 知乎 (zhihu.com)

建议收藏!大模型100篇必读论文 - 知乎 (zhihu.com)

马斯克起诉 OpenAI:精彩程度堪比电视剧,马斯克与奥特曼、OpenAI的「爱恨纠缠史」 - 知乎 (zhihu.com)

2023第一性原理科研服务器、量化计算平台推荐 - 知乎 (zhihu.com)

Llama-2 LLM各个版本GPU服务器的配置要求是什么? - 知乎 (zhihu.com)

人工智能训练与推理工作站、服务器、集群硬件配置推荐

整理了一些深度学习,人工智能方面的资料,可以看看

机器学习、深度学习和强化学习的关系和区别是什么? - 知乎 (zhihu.com)

人工智能 (Artificial Intelligence, AI)主要应用领域和三种形态:弱人工智能、强人工智能和超级人工智能。

买硬件服务器划算还是租云服务器划算? - 知乎 (zhihu.com)

深度学习机器学习知识点全面总结 - 知乎 (zhihu.com)

自学机器学习、深度学习、人工智能的网站看这里 - 知乎 (zhihu.com)

2023年深度学习GPU服务器配置推荐参考(3) - 知乎 (zhihu.com)

多年来一直专注于科学计算服务器,入围政采平台,H100、A100、H800、A800、L40、L40S、RTX6000 Ada,RTX A6000,单台双路256核心服务器等。