- 1ChatGLM2-6B! 我跑通啦!本地部署+微调(windows系统)_我跑通了 chatglm windows

- 22019第十届蓝桥杯国赛C组C/C++第I题 胖子走迷宫_蓝桥杯 大胖子走迷宫

- 3【音视频原理】音频编解码原理 ① ( 声音特性 | 声音本质 | 声音频率 | 声音频率和响度本质分析 | 数字音频 |脉冲编码调制 PCM - 采样振幅值 | 奈奎斯特 Nyguist 采样定理 )

- 4机器学习系列(7):目标检测YOLO算法及Python实现以自动驾驶为例_yolo人脸检测python

- 5Dubbo 集群容错_dubbo集群容错

- 6跟着pink老师前端入门教程-day12

- 7iso安装器_封装一个windows10系统 ③常用软件安装,系统优化,系统封装

- 8Unity核心9——3D动画_unity动画

- 9The Coding Bootcamp Primer-一个免费的Web开发课程,可让您准备参加任何Bootcamp

- 10# [NOI2019] 斗主地 洛谷黑题题解

Rethinking Performance Gains in Image Dehazing Networks-gUNet&FFA-Net: Feature Fusion Attention Net~

赞

踩

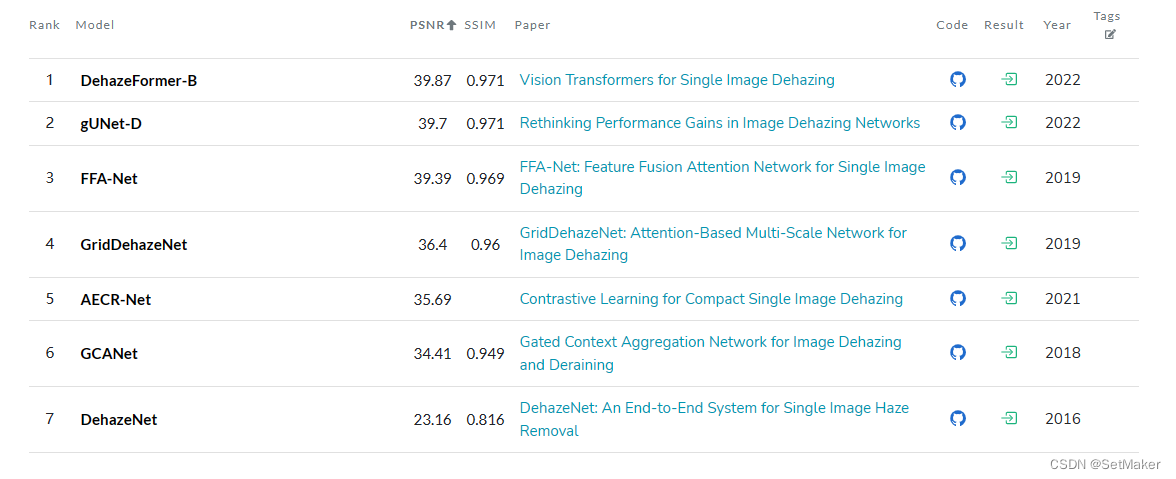

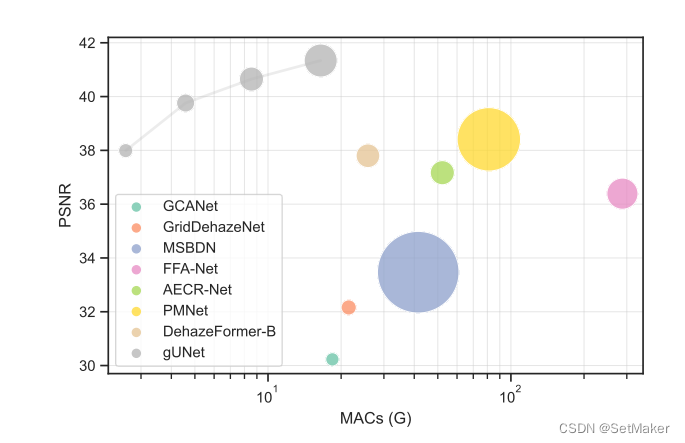

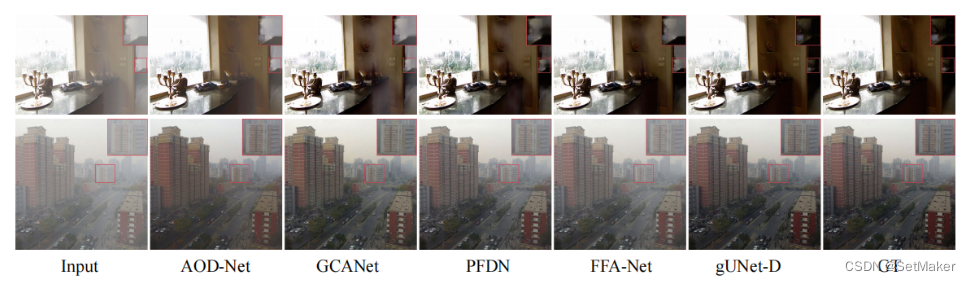

分享连篇去雾领域的TOP3和TOP2,TOP1是基于Transformer的网络,暂时先考虑CNN,且榜一和榜二相差不大,特别是gUNet非常轻量化,UNet结构部署友好。

首先,先分享TOP3的FFA-Net。

GitHub - zhilin007/FFA-Net: FFA-Net: Feature Fusion Attention Network for Single Image Dehazing https://arxiv.org/pdf/1911.07559v2.pdf

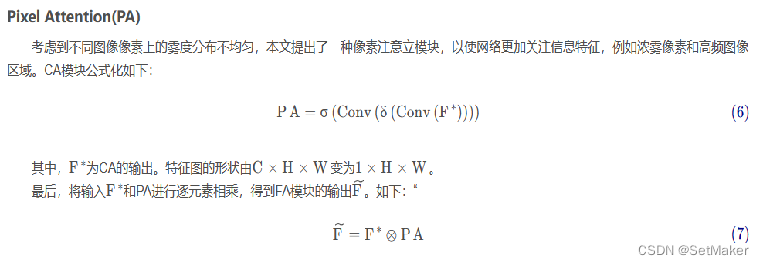

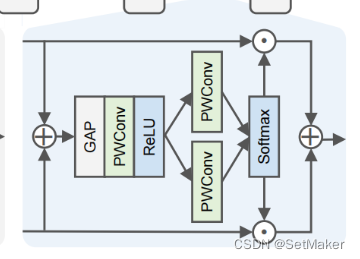

本文提出了Feature Fusion Attention Network(FFA-Net)用于单幅图像去雾。该网络最重要的是Feature Attention(FA)模块。FA模块包含了Channel Attention(CA)模块和Pixel Attention(PA)模块。

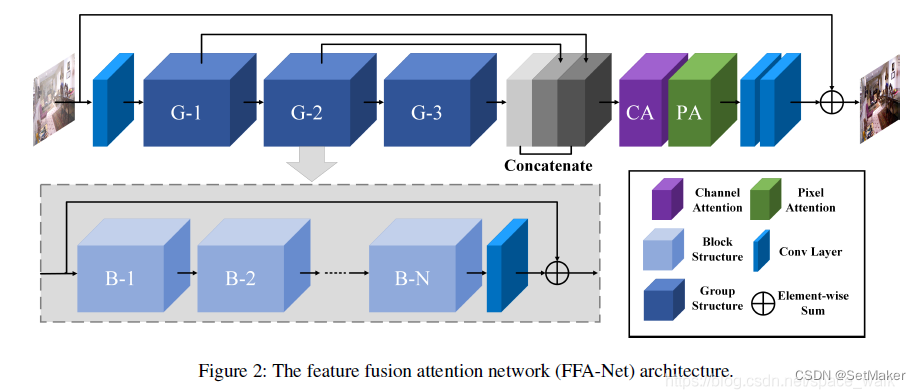

网络的输入为一张雾图,经过一个浅层的特征提取部分,然后馈入N个带有跳跃连接的Group Architecture,输出结果由本文提出的特征注意力模块进行融合,最后,经由重建部分和全局残差学习结构得到最终的无雾图输出。

大多数去雾网络平等对待通道和像素的特征,无法准确处理雾分布不均和加权通道方式特征的图像。 本文的特征注意力包含了通道注意力和像素注意力,可以在处理不同类型的信息时提供额外的灵活性。 FA不平等地对待不同的特征和像素区域,这可以在处理不同类型的信息时提供额外的灵活性,并可以扩展CNN的表示能力。 关键步骤是如何为每个通道和像素方向的特征生成不同的权重。

对于FFAnet就不仔细说了,结构没有什么非常亮眼的地方,提出的CA,PA模块也相对比较传统,且模型计算量太大了,接下来看一下gUNet。

https://arxiv.org/pdf/2209.11448v1.pdf

GitHub - IDKiro/gUNet: Rethinking Performance Gains in Image Dehazing Networks

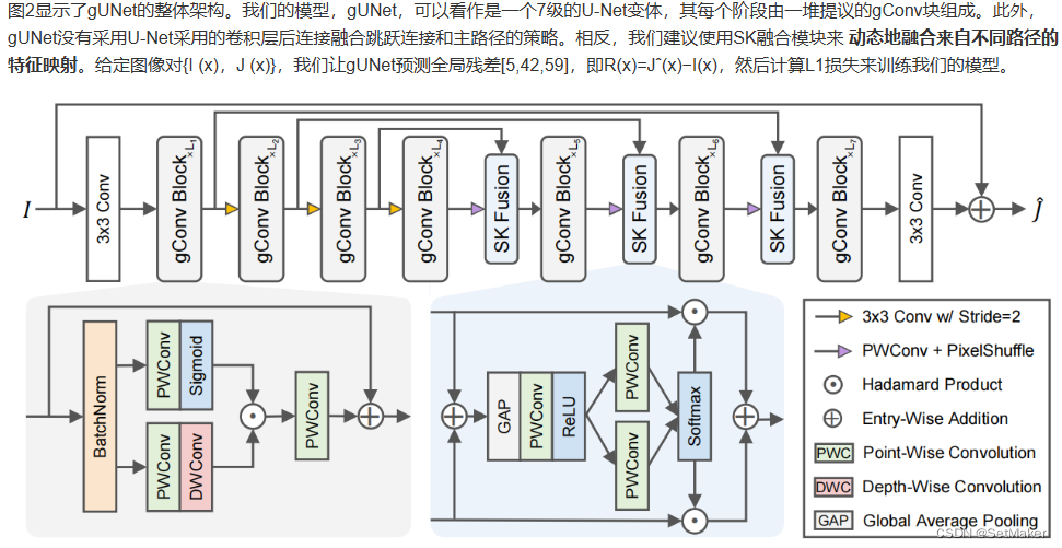

具体来说,我们将U-Net中的卷积块交换为具有门控机制的残差块,融合主路径的特征映射,并使用选择核跳过连接,并调用得到的U-Net变体gUNet。因此,gUNet以显著降低的开销,在多个图像去雾数据集上优于最先进的方法。最后,通过广泛的消融研究验证了这些关键设计对图像去雾网络性能增益的影响。

该文章指出:FFA-Net [42],提出了一种引入像素注意模块和通道注意模块的深度网络。其他作品也提出了合理的修改建议。然而,这些修改只带来适度的性能提高,但使网络更加复杂和难以部署。

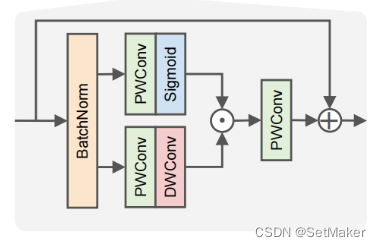

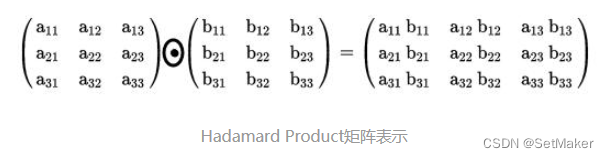

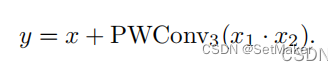

这个小圆点叫做Hadamard product。 使用这种门口机制给网络提供非线性,没有使用relu,

![]()

Deeper vs. Wider. 考虑到参数的数量和计算成本,一个更深的网络比一个更宽的网络表现得更好,但代价是速度更慢。然而,一个广泛的网络也有负面影响,因为它生成更大的中间特征图,消耗更多的GPU内存,并且不利于边缘设备的推断。因此,在本文中,我们增加了网络的深度来扩展网络

数据集在上一篇传统算法中分享了,目前打算试一下gUNet,有结果会继续更新。

数据集在上一篇传统算法中分享了,目前打算试一下gUNet,有结果会继续更新。