热门标签

热门文章

- 1【hadoop】eclipse中运行hadoop相关程序出现Unable to load native-hadoop library for your platform解决方法_eclipse unable to load native-hadoop library for y

- 2mysql bit 对gorm使用何种类型?_mysql bit在go中怎么表示

- 3记录我裸辞的这100天_cc冥想怎么样了

- 4【时间序列竞赛方案】Baidu KDD Cup 2022 风电预测比赛总结 (含19个高分方案)

- 5Spring系列之异步@Async_spring 异步

- 6FPGA_fpga 是可编程阵列处理器,多用在操作系统仿真、算法固化等方面,它的性能不 如

- 7逆向推理与因果推断:人工智能在数据挖掘的应用

- 8如何看待云计算的第三次浪潮?

- 9FFNs网络理解(部分)

- 10java计算机毕业设计(附源码)学生信息管理系统(ssm+mysql+maven+LW文档)

当前位置: article > 正文

Python批量下载参考文献|基于Python的Sci-Hub下载脚本|Python批量下载sci-hub文献|如何使用sci-hub批量下载论文_批量下载论文的参考文献

作者:小惠珠哦 | 2024-07-18 04:23:13

赞

踩

批量下载论文的参考文献

本篇博文将介绍如何通过Python的代码实现快速下载指定DOI号对应的文献,并且使用Sci-Hub作为下载库。

一、库函数准备

在开始之前,我们需要先安装一些必要的库,包括:

- requests:发送HTTP请求并获取响应的库;

- beautifulsoup4:用于解析HTML页面;

- threading:用于实现多线程处理;

这些库可以通过pip命令进行安装,具体命令如下:

pip install requests

pip install BeautifulSoup

pip install threading

- 1

- 2

- 3

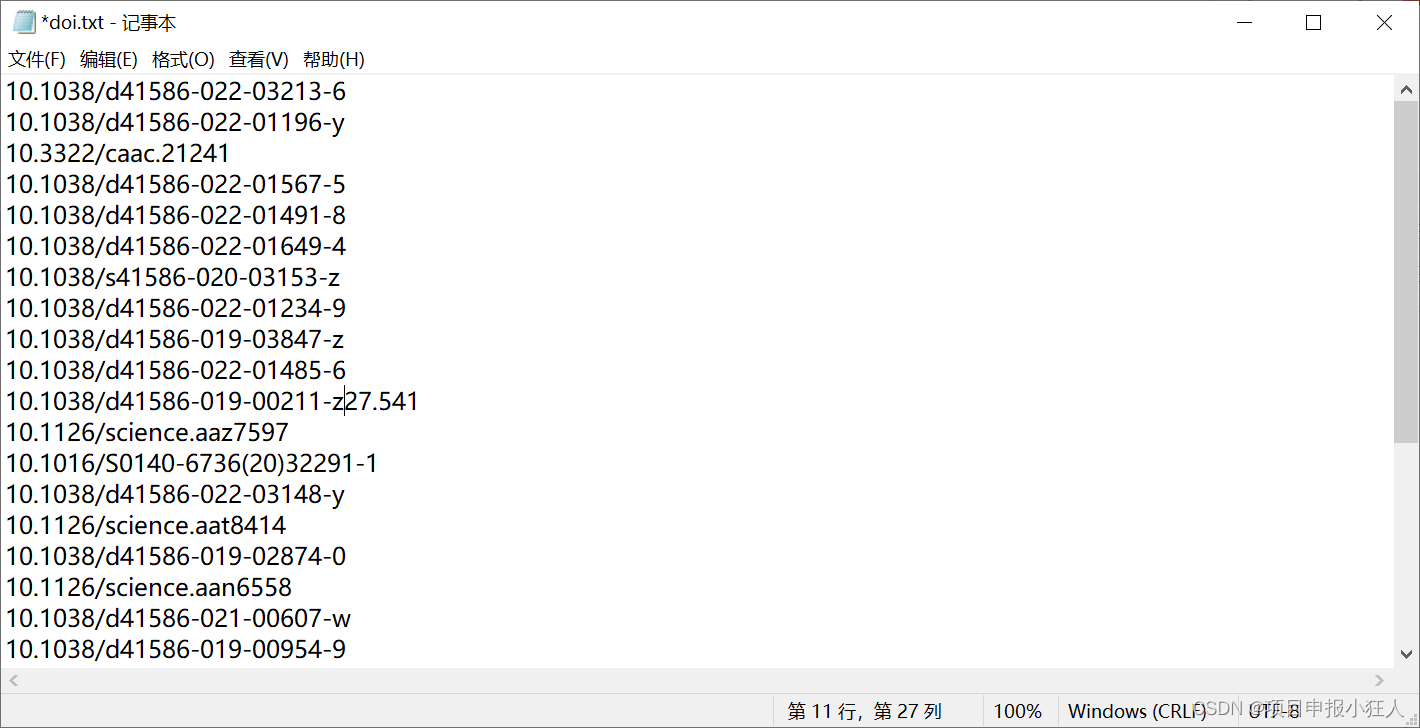

除此之外,还需要在代码所在目录下创建一个名为“papers”的文件夹,用于保存下载下来的文献。同时,需要准备一个包含多个DOI号的txt文件,每个DOI号占一行。

二、实现步骤

整个下载过程大致可以分为以下几个步骤:

- 读取存储有DOI号的txt文件;

- 构造Sci-Hub链接并发送HTTP请求;

- 解析HTML页面,获取文献下载链接;

- 下载文献并保存到本地文件夹;

- 记录下载成功或失败的情况。

三、实现算法

代码通过读取txt文件中的doi号来拼接Sci-Hub的链接,然后解析得到文献下载链接并进行下载

定义了HTTP请求需要的请求头;接着定义了一个download_paper()函数,用于下载文献并保存到本地,其中doi参数是需要下载的文献的DOI号;在 download_paper() 函数内,我们首先根据DOI号构造了Sci-Hub链接,并发送HTTP请求;然后通过解析HTML页面,获取到了文献的下载链接,并使用requests库下载文献到本地,并将下载成功和失败的信息输出到控制台或记录到一个日志文件中;最后,我们打开存储有DOI号的txt文件,并遍历其中的每一行,调用download_paper()函数下载对应的文献。

需要注意的是,由于Sci-Hub常常会更换域名,因此在实际应用中,我们需要通过浏览器访问Sci-Hub,找到当前可用的域名,并将其替换到上述代码中的链接中。

四、加速下载

虽然上述代码已经可以完成文献下载的任务,但是由于单线程下载速度较慢,因此我们可以使用多线程来加速下载过程。具体来说,我们可以将需要下载文献的DOI号作为参数传递给download_paper()函数,并创建多个线程来并行下载文献。下面是一种使用多线程下载文献的代码实现方式:

import requests

from bs4 import BeautifulSoup

import os

import threading

# 创建papers文件夹用于保存文献

path = "C:/Users/ypzhao/Desktop/papers/"

if not os.path.exists(path):

os.mkdir(path)

# 请求头

head = {

"user-agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/79.0.3945.117 Safari/537.36"

}

# 下载文献的函数

def download_paper(doi):

# 拼接Sci-Hub链接

url = "https://www.sci-hub.ren/" + doi + "#"

try:

download_url = ""

# 发送HTTP请求并解析HTML页面

r = requests.get(url, headers=head)

r.raise_for_status()

soup = BeautifulSoup(r.text, "html.parser")

# 解析得到文献下载链接

if soup.iframe == None:

download_url = "https:" + soup.embed.attrs["src"]

else:

download_url = soup.iframe.attrs["src"]

# 下载文献并保存到文件

print(doi + "\t正在下载\n下载链接为\t" + download_url)

download_r = requests.get(download_url, headers=head)

download_r.raise_for_status()

with open(path + doi.replace("/", "_") + ".pdf", "wb+") as temp:

temp.write(download_r.content)

print(doi + "\t文献下载成功.\n")

# 下载失败时记录错误信息

except Exception as e:

with open("error.log", "a+") as error:

error.write(doi + "\t下载失败!\n")

if download_url.startswith("https://"):

error.write("下载url链接为: " + download_url + "\n")

error.write(str(e) + "\n\n")

# 打开包含doi号的txt文件

with open(path + "doi.txt", "r", encoding="utf-8") as f:

# 遍历读取doi号,并启动多线程下载文献

threads = []

for line in f:

doi = line.strip()

t = threading.Thread(target=download_paper, args=(doi,))

threads.append(t)

# 启动所有线程

for t in threads:

t.start()

# 等待所有线程完成

for t in threads:

t.join()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

五、运行结果

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小惠珠哦/article/detail/843585

推荐阅读

相关标签