- 1微软史诗级的蓝屏

- 2“我30岁了,转行IT行业!还有没有出路?”_30岁转行学it的下场

- 3Mysql 优化的几种方法_mysql优化

- 4【AI绘画】小白必看!ComfyUI 基础案例_comfyui节点移动不了

- 5推荐开源项目:sops-nix - 高效安全的NixOS秘密管理工具

- 6【JAVA高频面试题】(超全完全体)(个人心得总结)(细致到位)(持续更新)_java面试高频题

- 7NLP中两种不同的中文分词形式分析,jieba和spaCy_中文分句模型 排名 spacy

- 8centos7手动安装mysql服务_【MySQL】CentOS7下安装MySQL服务

- 9OpenAI 宣布将让人们无需注册账户即可免费使用 ChatGPT_免费openai

- 10C++动态内存分配(new和delete)_如何delete 动态数组

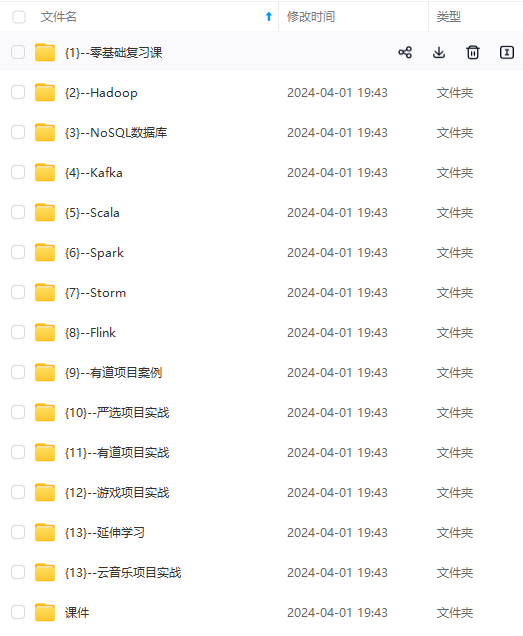

最全hadoop3分布式基本部署_hadoop3 双namenode 部署(1),看完直接怼项目经理_hadoop 3服务组件支持部署的方式有

赞

踩

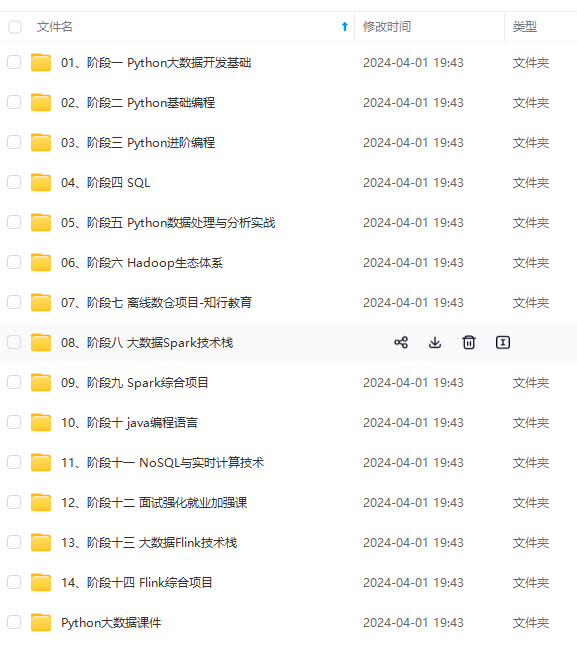

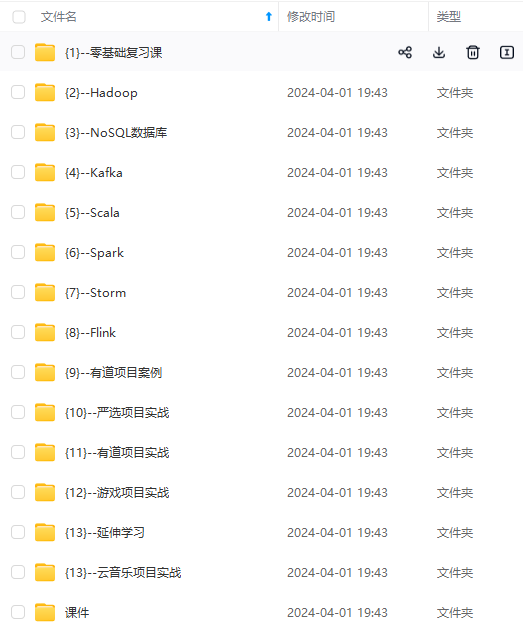

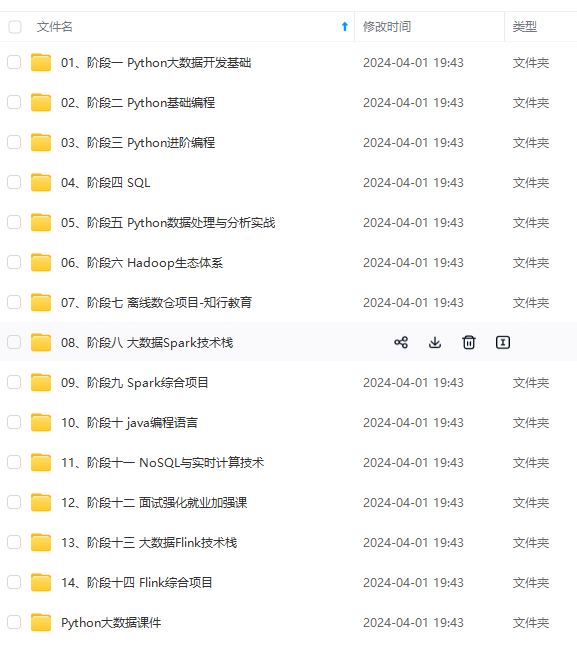

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

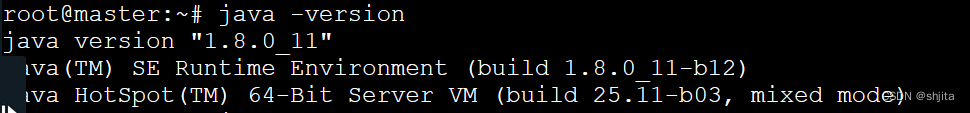

1、安装JAVA环境

(1)解压java安装包

命令:tar -zxvf /opt/jdk-8u11-linux-x64.tar.gz -C /app

注意:

1)路径尽可能用绝对路径。

2)参数-C指定目标位置

3)tar命令解压tar包

4)源位置和目的位置根据实际情况变化

(2)解压后文件夹名较长,可用mv更名

如:mv jdk-8u11-linux-x64 jdk1.8

(3)配置到环境变量

全局环境变量配置文件位置:/etc/profile

用户环境变量配置文件位置:/home/.bashrc

1)指定JAVA家目录

export JAVA_HOME=/app/jdk1.8

export PATH= P A T H : PATH: PATH:JAVA_HOME/bin

注意区分大小写。

(4)让配置文件生效并验证。

生效:source /etc/profile

验证:java -version,出现java版本,正确

验证:javac,

(5)将master中的配置文件/etc/profile和java解压文件传输到slave1,slave2中

命令:

scp -r /etc/profile slave1:/etc

scp -r /app/jdk1.8 slave1:/app

scp -r /etc/profile slave2:/etc

scp -r /app/jdk1.8 slav2:/app

注意:

1)目的地的文件夹若不存在,需创建

2)传输后必须用source命令让配置生效,并验证

3)-r指的是级联传输,对传输文件夹时不可缺省。

(三)hadoop配置

master中

(1)解压hadoop

tar -zxvf /opt/hadoop3.0.1.tar.gz -C /app/

(2)配置hadoop环境变量/etc/profile,并source应用配置

(3)验证hadoop,hadoop version

(4)配置hadoop相关配置。

hadoop-env.sh:

1)java环境家目录:export JAVA_HOME=/app/jdk1.8

2)用户权限

export HDFS_NAMENODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export HDFS_DATANODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

3)一个works文件,主要是DATANODE节点存放在哪些地方?

如:master,slave1,slave2等

4)4个配置文件,core-site.xml,hdfs-site.xml.mapreduce-site.xml,yarn-site.xml

core-site.xml

主是以下两个:

fs.defaultFS

hadoop://master:9820

hadoop.tmp.dir

/app/hadoop3.1/tmpData

其它的配置可以缺省,用默认的。

(5)将hadoop文件分发到slave1,slave2

scp -r

四、初始化Hadoop

hdfs namenode -formate

五、启动hadoop并查看相关进程

start-all.sh启动所有

start-dfs.sh启动hdfs

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!