- 1USB子系统学习之基础篇三(host controller)_usb fhci

- 2多维时序 | Matlab实现BiTCN双向时间卷积神经网络多变量时间序列预测

- 3提升 iOS 开发效率! Xcode 9 内置模拟器的9个技巧_ios模拟器编写程序

- 4基于SpringBoot的点餐系统的设计与实现(源码+数据库+文档+说明)_基于springboot的酒店订餐点餐管理系统需要实现什么样的功能

- 5烟火识别视频分析系统的应用-河北消防机器人项目

- 6堆排序--HeapSort()_使用堆排序算法实现升序排序,并把每趟排序结果输出

- 7分析了一下360安全卫士的HOOK_ntuserpostmessage

- 8鸿蒙源码分析(七十四)---安全子系统_鸿蒙huks中文全称是什么

- 9ArkTs自定义模版文件设置 DevEco Studio_arkts如何新建文件单独管理样式

- 10android 获取手机的一些硬件信息_androd 获取 hardwaretype

从算力到AI,计算的边界在哪里?_探索计算的边界是什么

赞

踩

算力是指计算机进行计算任务的能力。这些任务可以是简单的计算,如加法、减法、乘法或除法,也可以是更复杂的任务,如模拟人工智能等。

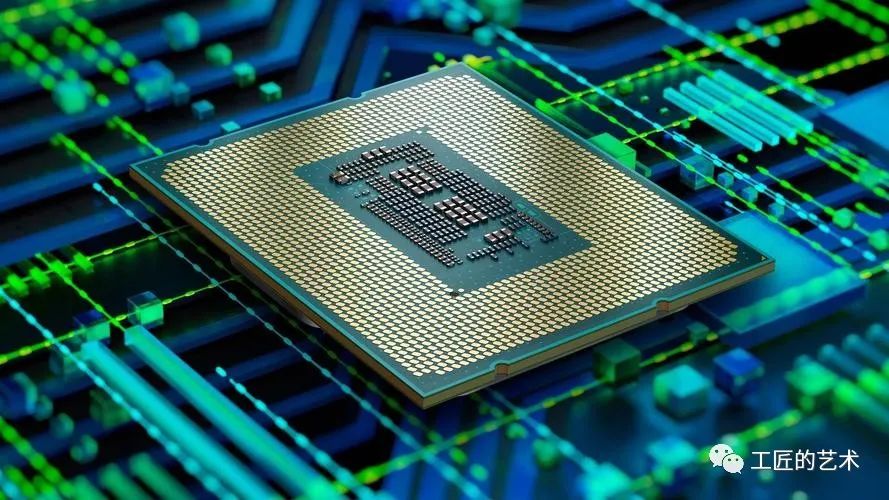

在计算机操作时,需要使用中央处理器(CPU)、图形处理器(GPU)或专用芯片(ASIC)等硬件来提供算力支持。这些硬件可以提供不同的计算能力,具体取决于硬件规格和设计。

GPU 现在被广泛应用在人工智能和大规模数据处理场景中。GPU相比CPU,有更高的并行处理能力和内存带宽,并能在大规模并行计算时提供更快的速度。因此,在训练大规模深度学习模型时,GPU是很好的工具,可以提供比CPU更高效的算力。

ASIC芯片是专门设计的芯片,可用于加速特定应用程序的处理,例如AI应用程序的加速。ASIC芯片可以更快地运行特定任务,因为它不需要进行通用计算任务。事实上,ASIC芯片的好处是可以实现更大、更复杂的特定任务。

在 AI的世界里,越来越多的人工智能应用需要完成大规模的数据处理,这样能够对AI进行训练、测试,以及生产应用。因此,一流的AI 优化和发展需要强大的高速计算。

但是,计算的边界并不仅仅局限于硬件的算力,而是与计算机能力的极限和人工智能的技术水平相关。

在机器学习中,人工神经网络需要进行许多次的迭代运算来得出最终的结果。因此,深度学习的可行性和成功取决于它能够利用GPU和其他硬件加速器的能力。通过将计算量拆分成许多较小的部分或“任务”,GPU可以帮助加速学习过程。

然而,AI技术仍然存在着一些问题。例如,AI模型的精度仍然是一个重要问题。使用更先进的模型或更强大的深度学习框架,会较快、更准确地增加精度。同时,数据的不确定性和质量也是人工智能技术面临的挑战之一,这些问题往往需要借助更高级别的技术解决。

一、芯片如何为ChatGPT提供算力

ChatGPT是目前流行的开放域对话系统中一种基于深度学习模型的聊天机器人。作为深度学习模型,ChatGPT模型计算量非常大。为了提供充足的算力支持,需要使用高性能的芯片技术。

算力是指计算机处理数据的能力,通常以浮点运算次数(FLOPs)为单位衡量。对于大多数深度学习任务,需要进行大量的矩阵乘法和卷积运算,这些运算需要大量的算力支持,而GPU、ASIC、FPGA、TPU等专用化芯片都可以提供高效率的算力支持。

GPU(Graphics Processing Unit)是专为图形处理而设计的芯片,因其并行处理能力,在深度神经网络训练中表现出色。基于显卡的训练助手比CPU更快地完成了AI推理,一般情况下可以加速20-30倍。同时,GPU的开发与GPU硬件兼容的深度学习框架中的深度学习算法被Cuda优化,使得GPU在许多情况下强于CPU。因此,很多主流芯片供应商都推出了针对深度学习模型的GPU产品,例如英伟达(NVIDIA)的Tesla V100、T4等。

ASIC (Application-Specific Integrated Circuit)是专门设计用于特定任务的集成电路,具有高度优化的特定功能。ABI Research估计,在2019年AI芯片市场中,ASIC占据了接近50%的市场份额。ASIC的优点是在处理相同任务时能够超越GPU的性能。针对复杂的神经网络,ASIC有增加神经元、降低功耗、加速重复计算等创新设计,其中与AI用途相关的优化设计对聊天机器人的训练效果尤为突出。OpenAI 首先向外放出消息称与国外芯片商 partnership 开发了AI特殊芯片,这也是基于ASIC的应用。Google的TPU(Tensor Processing Unit)就是基于ASIC芯片设计的针对深度神经网络加速的处理器。

FPGA ( Field Programmable Gate Arrays )是可重构的计算机组件,可在运行时重新配置。FPGA通过活用可编程逻辑和对加速器运算的计划,最大化了性能和灵活性。由于FPGA可重构的特点,适用于深度神经网络的训练和推理。FPGA芯片可以根据不同任务的计算量大小,进行调整优化,具有低功耗、低成本等优点,常常被用于单个的、海量的、特殊的应用需求场景。AWS 和英特尔的一些FPGA产品都是这类的典型代表。

二、OpenAI是如何训练ChatGPT的,对芯片有什么要求

OpenAI 推出的 GPT-2 和 GPT-3 都是基于深度学习的自然语言处理模型。相较于 GPT-2,GPT-3 拥有更多的参数和更准确的预测。这些模型的参数量大,训练时间长,对算力的要求很高,因此需要使用高效的算力支持。

OpenAI 使用的解决方案是使用 AWS 的 GPU 实例来训练 GPT-2 和 GPT-3 模型。这些 GPU 实例包括 GPU 子型号为 NVIDIA Tesla P100、V100、P4、K80 等,在训练过程中提供了丰富的算力支持。对于像 ChatGPT 这样的大型深度学习模型,需要在大规模数据集上进行训练,通常需要使用多个GPU进行并行化训练。

为了提高训练效率,OpenAI 还使用了分布式训练方法。这种方法是将任务拆分成多个子任务并分配给多个计算机进行训练,从而加速模型的训练速度。在 OpenAI 的分布式训练方案中,显存和带宽是最重要的一些考虑因素。因此,在准备硬件时,OpenAI 首先仔细考虑了不同 GPU 子型号之间的显存和带宽差异,并选择最适合其训练任务的 GPU 子型号,以实现最佳效果。

三、涉及的主要技术点

-

深度学习算法

深度学习算法是在大规模数据集上训练多层人工神经网络的一个过程。深度学习模型由多个层组成,每一层都包含一组可调参数。在训练过程中,模型的训练算法将根据数据集的输入和预期输出来调整这些参数,从而使输出逐渐接近预期输出。深度学习算法能够在自然语言处理、计算机视觉和语音识别等领域中获得突破性的进展。

-

GPU并行计算

GPU并行计算是在大规模计算中实现高性能计算的重要手段。与传统的序列计算不同,GPU并行计算可以同时进行多个运算,从而大大提高了计算效率。GPU并行计算的局限是数据交换和同步,因此需要专门的算法来管理这些操作。

-

分布式训练

分布式训练是指将训练任务拆分成多个子任务,并分配给多个计算机进行训练的一种方法。分布式训练能够加速训练任务的执行速度,但需要解决各种通信和同步问题,保证不同计算机之间通信和计算的正确性和准确性。

-

ASIC/FPGA设计

ASIC和FPGA的设计是在特定领域实现高性能计算的重要方式。ASIC和FPGA作为专用芯片,可以实现高度优化的计算。它们可以根据特定任务的不同优化设计,对于不同的深度学习算法实现高效率的计算。但是,ASIC和FPGA的设计需要专业知识,也需要投入大量的时间和成本。

四、芯片技术在 ChatGPT 中的应用案例

芯片技术已经成为了 ChatGPT 的重要应用方向。下面将针对 ChatGPT 的应用场景,举一些芯片技术在 ChatGPT 中的具体应用案例:

-

NVIDIA GPT-2:NVIDIA 推出的 GPT-2 版本中采用了半精度浮点运算和 Tensor Core 技术,从而实现了推理速度的大幅提升。该版本还采用了 Transformer-XL 和 Byte Pair Encoding(BPE)技术,进一步提高了模型的性能和效率。

-

Google TPU:Google 的 Tensor Processing Units 也被广泛应用于 ChatGPT 中。例如在 OpenAI 的 GPT-2 中使用了 Google TPU 的加速器,从而实现了高效的训练和推理速度。

-

Baidu ERNIE:Baidu ERNIE 模型也是采用了芯片技术来提高算力。在该模型中,使用了 NVIDIA 的 GPU 加速器,从而实现了训练速度的大幅提升,同时也提高了模型的准确率。

-

Huawei Noah's Ark:华为研究院的 Noah's Ark 也采用了 GPU 加速器来提高 ChatGPT 的算力。他们采用了 PyTorch 框架和 NVIDIA Tesla V100 GPU 加速器,从而显著提高了训练和推理速度。

这些案例都充分说明了芯片技术在 ChatGPT 中的重要性和应用价值。

五、芯片技术在 ChatGPT 中的局限性

然而,芯片技术并不是万能的,在 ChatGPT 的应用中还存在一些局限性。以下是其中一些常见的问题:

-

能耗问题:虽然 GPU 加速器可以提高 ChatGPT 的算力,但是相比传统的 CPU,其能耗通常也较高。这意味着在使用 GPU 加速器时需要对能耗进行优化。

-

瓶颈问题:在使用 GPU 加速器时,可能会遇到内存或者计算能力的瓶颈问题。例如,当网络规模较大时,可能会出现内存不足的情况。

-

成本问题:GPU 加速器通常比 CPU 更贵,这可能会增加 ChatGPT 模型的总体成本。

-

对用户的要求:如果在使用 ChatGPT 的过程中需要用户拥有一定的计算资源

六、主要芯片供应商和主流产品的对比

1. GPU

GPU是通用计算芯片,通常使用基于图形学渲染的大量并行操作,适用于训练和推理深度学习模型。市场上主要的GPU供应商是NVIDIA和AMD,其中NVIDIA的主要产品包括Tesla、GeForce和Quadro系列,AMD的主要产品包括Radeon系列。

-

NVIDIA Tesla系列:Tesla系列是专为数据中心、高性能计算和科学研究而设计的GPU。Tesla V100是当前最强大的GPU,具有世界领先的AI训练和推理性能。

-

NVIDIA GeForce系列:GeForce系列是主要用于游戏和消费者市场的GPU,但也被广泛应用于深度学习领域。GeForce RTX 3090是目前最强大的消费者级GPU。

-

AMD Radeon系列:Radeon系列GPU适用于数据中心、云计算和游戏等应用场景。Radeon Instinct MI100是AMD发布的用于加速深度学习、高性能计算和云计算的GPU。

2. ASIC

ASIC是针对特定应用领域设计的芯片,具有高度优化的硬件结构和算法实现,因此在特定任务上具有极高的效率和性能,但其灵活性和通用性较低。市场上的ASIC芯片大多用于加速深度学习任务。

-

Google TPU系列:TPU是Google公司专门为自己的TensorFlow框架而设计的ASIC芯片,旨在提供高效的神经网络训练和推理。Google TPU v4是TPU系列中速度最快的产品,具有AI训练和推理方面的领先性能。

-

Cambricon MLU系列:MLU是专为人工智能应用设计的ASIC芯片,主要用于加速深度学习和计算机视觉等任务。Cambricon MLU270是其旗舰产品,具有强大的性能和能效比。

3. FPGA

FPGA具有高度可编程性和灵活性,能够实现各种算法实现,因此在通用AI加速方面具有较高的潜力。市场上的FPGA芯片用于来加速深度学习任务和图像处理任务。

-

Xilinx Alveo系列:Alveo系列是Xilinx公司提供的高性能FPGA加速器,适用于数据中心、云计算和5G等应用场景。Alveo U280是当前最主要的产品之一,具有广泛的适用性和出色的性能表现。

-

Intel Arria系列:Arria系列是Intel公司提供的高性能FPGA加速器,适用于大规模虚拟化、高性能计算、深度学习加速和数据压缩等应用场景。Arria 10 GX是其旗舰产品之一,具有高度定制化和可编程性。

综合来看,不同类型的芯片供应商和产品适用于不同的应用场景和任务。选择适合自己需求的芯片和加速器是关键的一步。

微信公众号:工匠的艺术

从算力到AI,计算的边界在哪里?