- 1易语言如何写一个取随机数的程序_易语言 随机数

- 2unity账号被封之后,无法登录怎么启动unity?_unity账号被锁定

- 3鸿蒙开发两种简单本地数据库RDB和ORM的入门demo以及配置_鸿蒙 dataorm

- 4因果推断正在让AI预测走向决策智能_因果推断智能算法

- 5常见Linux服务器框架_服务器框架调用linux数据库

- 6教你怎么批量查询快递单号,一学就会_批量查快递单号物流

- 7单源最短路径

- 8week06 day02(sql gropy by 、having、order by、limit、运算符、函数)

- 9EfficientDet: Scalable and Efficient Object Detection_加权双向特征金字塔网络

- 10STM32电机库(ST-MC-Workbench)学习记录——无感FOC代码生成_st workbench

搭建自己的AI实验环境_如何搭建个人ai

赞

踩

一、PC配置

AMD Ryzen 5 3500X 6-Core Processor 3.59 GHz

内存 32.0 GB

Windows 10 企业版

2张N卡:

NVIDIA GeForce RTX 3060 Ti 8G显存

NVIDIA GeForce RTX 3060 12G显存

大容量硬盘:12T

二、使用wsl安装Ubuntu虚机

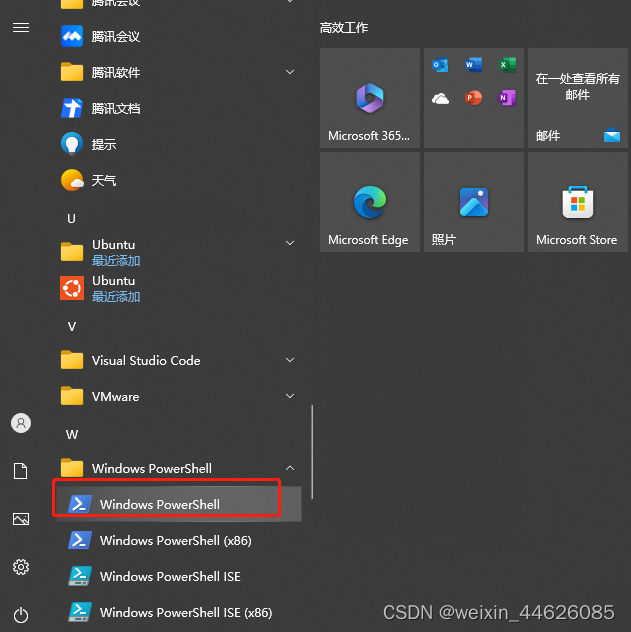

打开powershell

安装ubuntu 22.04.2 LTS

命令:wsl --install

如果遇到异常报错,先用命令wsl --update更新wsl

在unbuntu上面安装ssh

参考Ubuntu安装ssh服务详细过程[通俗易懂]-腾讯云开发者社区-腾讯云

三、安装Visual Studio Code

Visual Studio Code – 代码编辑器 | Microsoft Azure

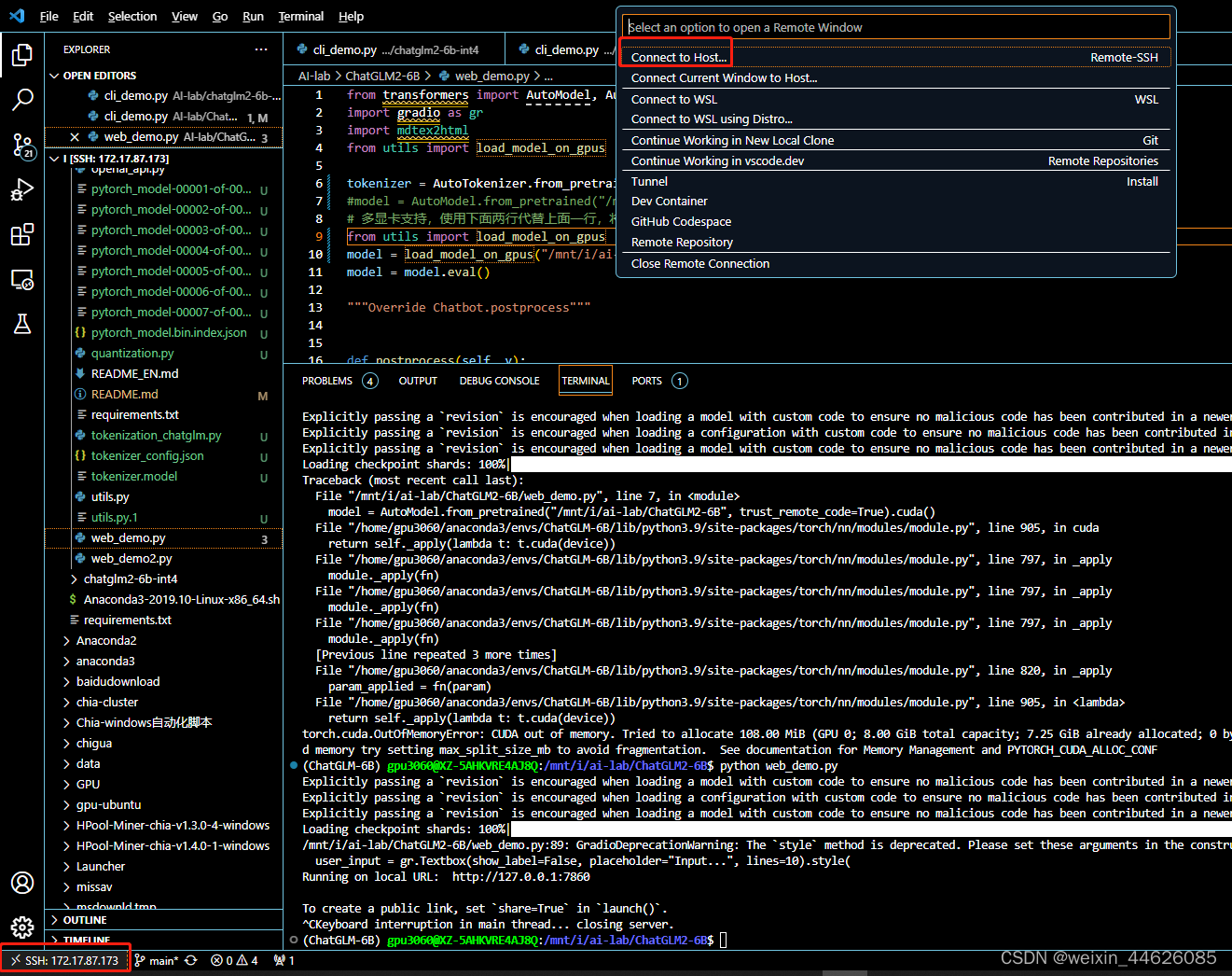

四、配置Visual Studio Code连接ubuntu

Visual Studio Code先安装如下插件

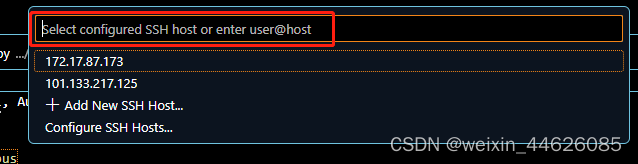

配置ssh

按照提示进行配置

例如:我的Ubuntu安装的时候用户名为gpu3060,密码为XXXXX,按提示一步步进行配置

五、安装conda

参考Ubuntu安装conda_没有金刚钻,也木有刷子的博客-CSDN博客

六、部署各种AI推理环境,以ChatGLM2-6B为例

部署推理

环境配置

1 conda create -n chatglm2-6b python==3.9

2 pip install -r requirements.txt

模型下载

git-lfs安装

修改cli_demo.py相关参数

进入对应的conda环境里面运行

(base) gpu3060@XZ-5AHKVRE4AJ8Q:/mnt/i/AI-lab/ChatGLM2-6B$ conda info --envs

# conda environments:

#

base * /home/gpu3060/anaconda3

ChatGLM-6B /home/gpu3060/anaconda3/envs/ChatGLM-6B

chatglm2-6b /home/gpu3060/anaconda3/envs/chatglm2-6b

(base) gpu3060@XZ-5AHKVRE4AJ8Q:/mnt/i/AI-lab/ChatGLM2-6B$ conda activate chatglm2-6b

(chatglm2-6b) gpu3060@XZ-5AHKVRE4AJ8Q:/mnt/i/AI-lab/ChatGLM2-6B$

(chatglm2-6b) gpu3060@XZ-5AHKVRE4AJ8Q:/mnt/i/AI-lab/ChatGLM2-6B$ python cli_demo.py

Loading checkpoint shards: 100%|███████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████| 7/7 [00:58<00:00, 8.40s/it]

欢迎使用 ChatGLM2-6B 模型,输入内容即可进行对话,clear 清空对话历史,stop 终止程序

用户:ChatGLM2-6B

ChatGLM:您好!很高兴见到您,欢迎问我任何问题。

用户:ChatGLM2-6B介绍一下吧

ChatGLM:ChatGLM2-6B 是一个人工智能助手,基于清华大学 KEG 实验室与智谱 AI 公司于 2023 年共同训练的语言模型 GLM2-6B 开发而成,可以针对用户的问题和要求提供适当的答复和支持。

用户:

查看显卡使用情况

(base) gpu3060@XZ-5AHKVRE4AJ8Q:~$ nvidia-smi

Sat Sep 16 17:08:56 2023

+---------------------------------------------------------------------------------------+

| NVIDIA-SMI 535.54.03 Driver Version: 536.23 CUDA Version: 12.2 |

|-----------------------------------------+----------------------+----------------------+

| GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+======================+======================|

| 0 NVIDIA GeForce RTX 3060 Ti On | 00000000:04:00.0 On | N/A |

| 0% 53C P2 40W / 200W | 7079MiB / 8192MiB | 0% Default |

| | | N/A |

+-----------------------------------------+----------------------+----------------------+

| 1 NVIDIA GeForce RTX 3060 On | 00000000:07:00.0 Off | N/A |

| 0% 40C P8 9W / 170W | 6053MiB / 12288MiB | 0% Default |

| | | N/A |

+-----------------------------------------+----------------------+----------------------+

+---------------------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=======================================================================================|

| 0 N/A N/A 23 G /Xwayland N/A |

| 0 N/A N/A 5263 C /python3.9 N/A |

| 1 N/A N/A 23 G /Xwayland N/A |

| 1 N/A N/A 5263 C /python3.9 N/A |

+---------------------------------------------------------------------------------------+

(base) gpu3060@XZ-5AHKVRE4AJ8Q:~$

修改web_demo.py相关参数

(chatglm2-6b) gpu3060@XZ-5AHKVRE4AJ8Q:/mnt/i/AI-lab/ChatGLM2-6B$ python web_demo.py

Loading checkpoint shards: 100%|███████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████| 7/7 [00:58<00:00, 8.31s/it]

/mnt/i/AI-lab/ChatGLM2-6B/web_demo.py:89: GradioDeprecationWarning: The `style` method is deprecated. Please set these arguments in the constructor instead.

user_input = gr.Textbox(show_label=False, placeholder="Input...", lines=10).style(

Running on local URL: http://127.0.0.1:7860

To create a public link, set `share=True` in `launch()`.

- 相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。