- 1部署更轻松了,Github-Action自动化部署Hexo:代码推送,云服务器自动部署_action 自动部署

- 2【精品收藏】想自学编程?推荐几个实用编程学习网站!_指针编程的网站是什么

- 3图扑软件 3D 组态编辑器,低代码零代码构建数字孪生工厂_0代码虚拟仿真制作

- 4uniapp 安卓手机 input type=“number“ 没有点,不能输入小数_uniapp数字input如何输入小数点

- 5vue官网构建的基本项目解读_vue官网项目

- 6YoloV5 的部署【详解】_yolov5的部署

- 7软件定义汽车落地的五大关键要素_soa服务化架构图

- 8vue+openlayers实现流动线效果(js源码导出方法直接复制使用即可生效)

- 9第3关:String串类操作练习 - 文件名与邮箱验证_第3关:string串类操作 - 文件名与邮箱验证

- 10深度学习【 return _VF.meshgrid(tensors, **kwargs) # type: ignore[attr-defined]】_python ignore[attr-defined]

OneDiff 1.0发布!生产环境稳定加速SD/SVD模型

赞

踩

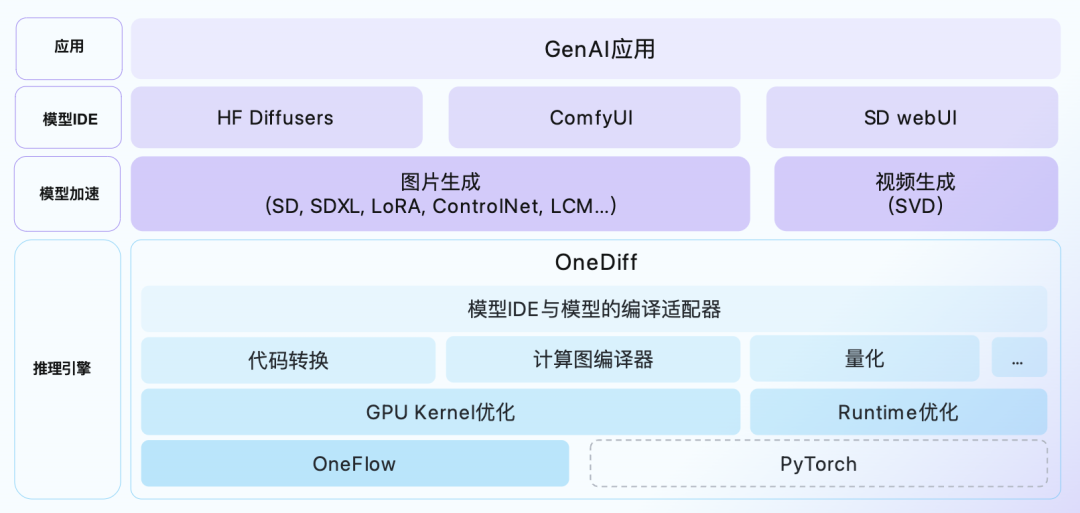

自Stable Diffusion模型发布以来,硅基流动开发的OneDiff图片/视频推理加速引擎以其卓越的性能、“一键”加速的易用性、以及对最新算法和应用框架的快速支持,深受开发者和用户的喜爱。

今天,OneDiff v1.0.0正式发布。本次版本更新解决了此前版本v0.13中的问题,主要包括以下新特性、改进以及若干Bug修复:

OneDiff质量评估

重复利用编译图

改进对Playground v2.5的支持

支持ComfyUI-AnimateDiff-Evolved

支持ComfyUI_IPAdapter_plus

支持Stable Cascade

提高了VAE的性能

为OneDiff企业版提供了量化工具

欢迎体验新版本,期待你的反馈。完整更新列表请查看:https://github.com/siliconflow/onediff/releases/tag/1.0.0

OneDiff的后续版本将专注于DiT/Sora类模型。

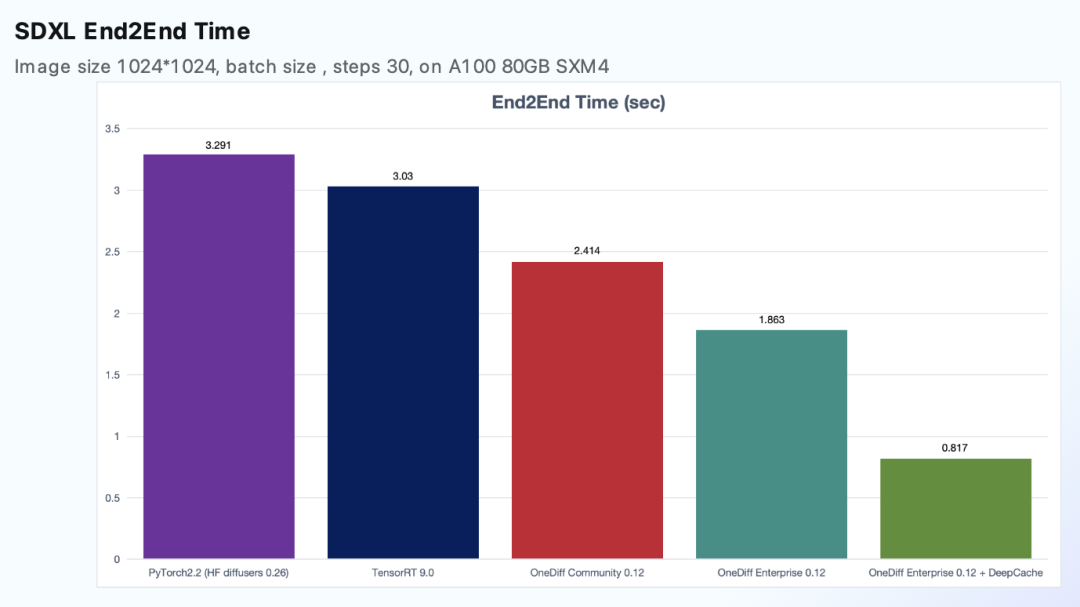

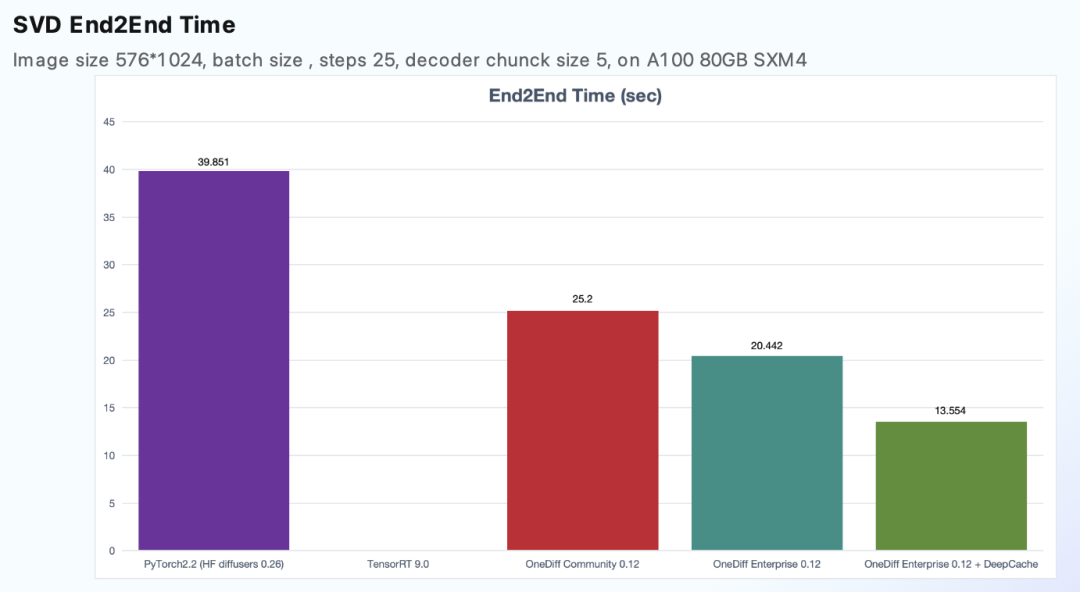

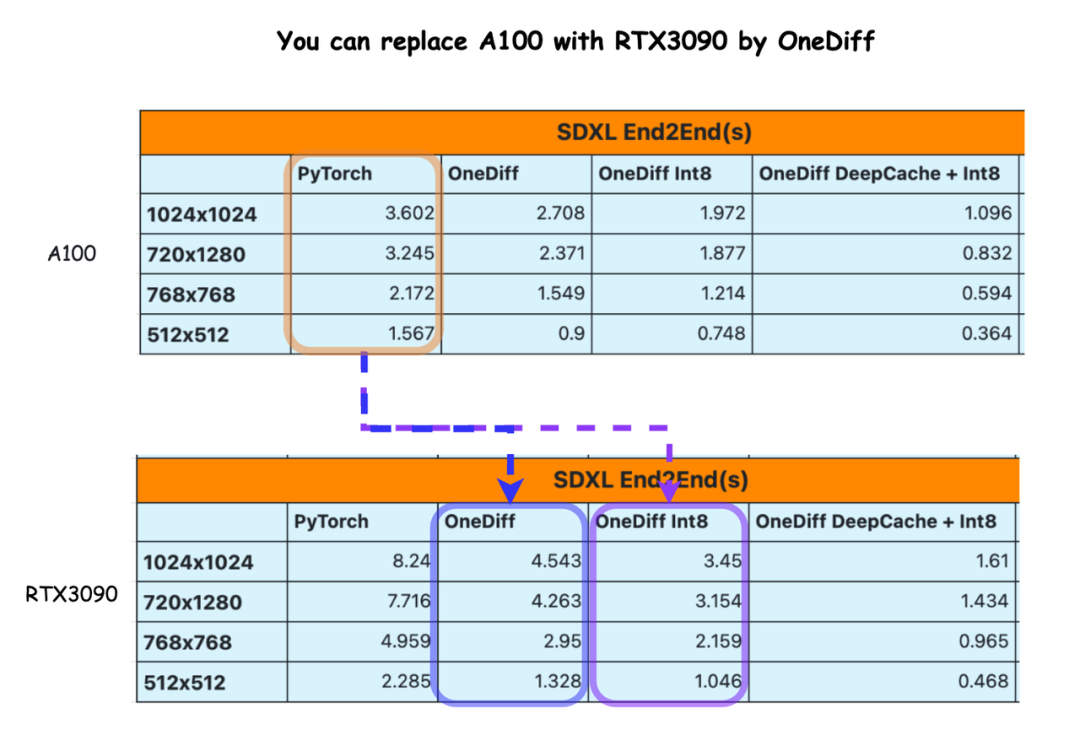

SOTA性能

性能方面,无论是Stable Diffusion还是Stable Video Diffusion模型,OneDiff依然保持2~3倍的端到端推理加速。

在OneDiff的加持下,RTX3090甚至可以超越A100的性能,帮助企业和用户大幅节省使用A100的成本。

OneDiff Demo

从默认皮肤灰袍甘道夫到近战法师白袍甘道夫,无论是细节层面“加入法杖”、“骑马”、“加入霍比特人”,还是宏观的场景切换(从Shire到Mordor),随着提示词即时更换,OneDiff 加速库实现图片即时生成(推理时间与端到端时间均小于300ms)。在经过层层嵌套、修改提示词,OneDiff的输出依然稳定(录屏展示无加速)。

应用案例

OneDiff已在多家海内外知名GenAI企业的生产环境中得到应用。

更多案例持续更新中:github.com/siliconflow/onediff/wiki