热门标签

热门文章

- 1数据预处理系列:多重共线性_检测和解决办法_什么数据需要共线性处理

- 2Windows本地部署Fooocus AI绘画工具(小白教程!)_fooocus本地布置

- 3sqlite优化简单分析_sqlite 性能

- 4写python爬虫的第一天,拿百度练手遇到 “ 被反爬遇到<title>百度安全验证</title> ” 的解决方案_被百度反爬

- 5猿编程怎么编程机器人平板:深入探索与实践

- 6【第十届“泰迪杯”数据挖掘挑战赛】B题:电力系统负荷预测分析 Baseline_泰迪杯电力负荷预测

- 7西门子PLC入门-PLC介绍_西门子plc编程软件界面介绍

- 82023社招阿里、腾讯、蚂蚁金服「四面」Java面试真题分享_阿里内部java岗位面试题汇总

- 9getStorageInfoSync和getStorageSync

- 10深入理解二叉树及其在C语言中的实现

当前位置: article > 正文

flink sink jdbc没有数据_Flink流处理API——Sink

作者:小蓝xlanll | 2024-05-24 01:17:32

赞

踩

flink jdbcsink.sink 无效 也不报错

本文主要从以下几个方面介绍Flink的流处理API——Sink

一、输出到Kafka

二、输出到Redis

三、输出到MySQL

数据处理的过程基本可以分为三个阶段分别是,数据从来哪里,做什么业务逻辑,落地到哪里去。

这三部分在Flink中分别被称为Source、Transform和Sink

其中Source部分可以参考这篇:Flink流处理API——Source

Flink 没有类似于 spark 中 foreach 方法,让用户进行迭代的操作。虽有对外的输出操作都要利用 Sink 完成。最后通过类似如下方式完成整个任务最终输出操作。

stream.addSink(new MySink(xxxx))

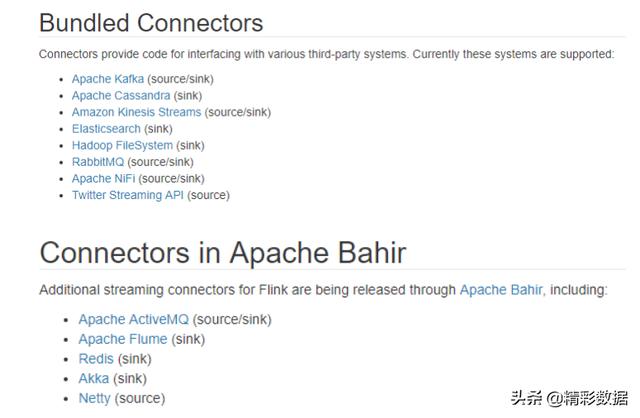

官方提供了一部分的框架的 sink。除此以外,需要用户自定义实现 sink。

Flink支持的Sink

版本:

scala:2.11.12

Kafka:0.8.2.2

Flink:1.7.2

Redis:3.2.9

MySQL:5.7.30

pom.xml依赖部分(log日志的依赖一定要加上,否则当Flink链接Kafka0.8时会报Failed to instantiate SLF4J LoggerFactory Reported exception错误)

org.apache.flink flink-scala_2.11 1.7.2org.apache.flink flink-streaming-scala_2.11 1.7.2providedorg.apache.flink flink-clients_2.11 1.7.2org.apache.flink flink-connector-kafka-0.8_2.11 1.7.2org.slf4j slf4j-api 1.7.22org.slf4j 声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小蓝xlanll/article/detail/615137

推荐阅读

相关标签