热门标签

热门文章

- 1Window 11本地部署 Meta Llama3-8b_llama3 windows

- 23月9日 笔记:RANSAC随机样本一致性,灭点、对极几何计算、H矩阵、PNP估计相机位置,3D匹配、投影变换、N点定位求解姿态_内参k、外参r、t生成h

- 3计算机网络基础知识 学习笔记_计算机网络技术基础第五版笔记

- 4如何使用Python进行数据分析【新手必看、高手备查】_怎么用python进行数据分析

- 5爬虫实战(三) 用Python爬取拉勾网_python爬拉钩网

- 6521源码-免费网络教程-Linux如何增加安全组端口(命令行方式)

- 7小朋友也能听懂的Rust网络编程框架知识-Tokio基础篇

- 8Hive窗口函数案例_jack,2017-01-01、

- 9vscode编译和调试wsl环境的c语言程序

- 10在自己笔记本上使用 Llama-3 生成 PowerPoint — 幻灯片自动化的第一步_llama3 制作ppt

当前位置: article > 正文

ollama大模型容器详解,根据ollama进行web开发_ollama 命令

作者:小蓝xlanll | 2024-06-03 17:57:44

赞

踩

ollama 命令

介绍

ollama底层基于docker容器,将类似于镜像的大模型从中央仓库拉取到本地,在docker容器中运行

ollama在每个容器中都提供了大模型运行的基本环境

简单的来说,可以把ollama看作docker容器,把ai大模型看作是镜像

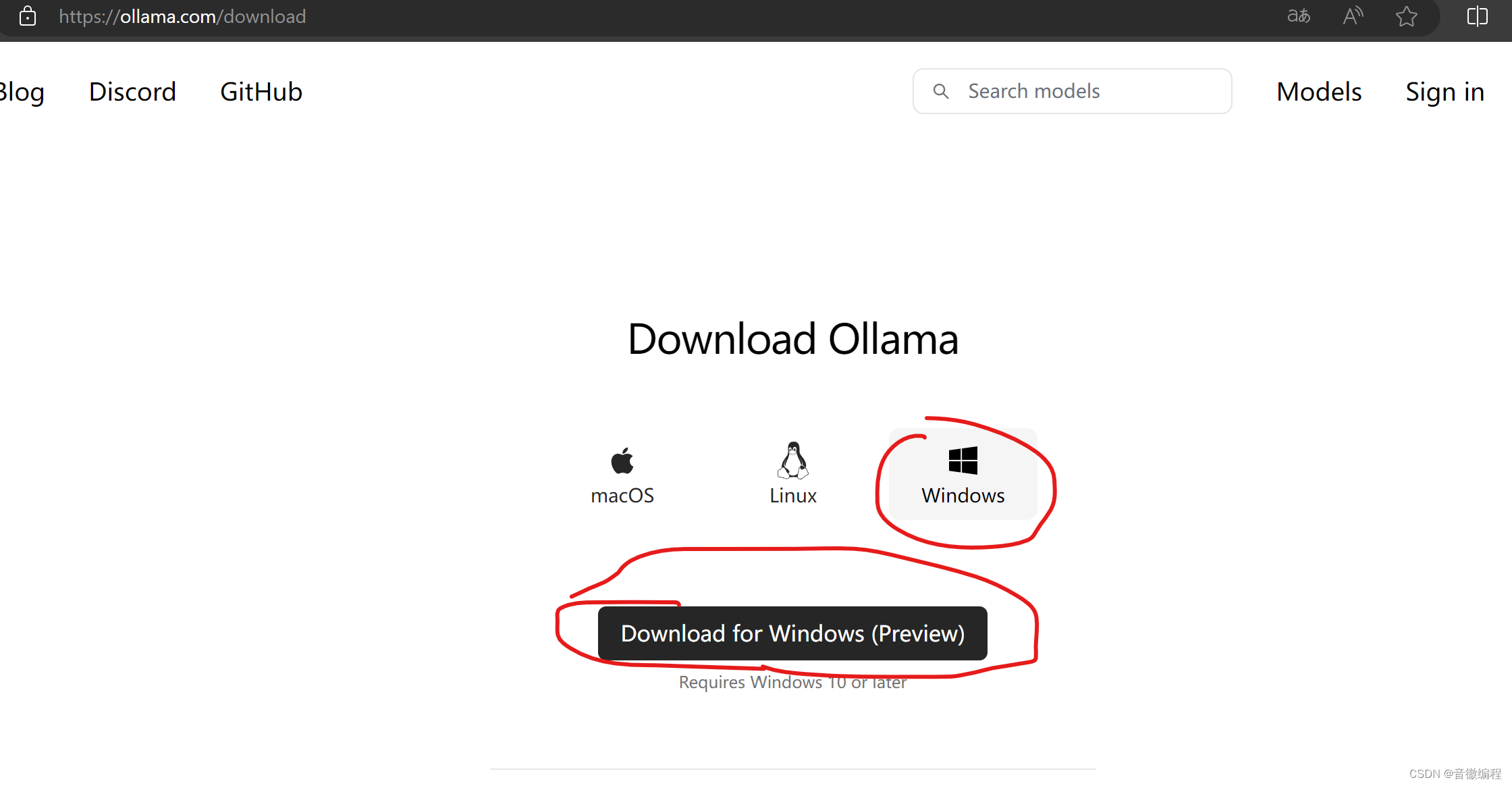

ollama下载到本机

官方目前提供了多个系统的下载方案:

window,macOs,linux

还可以借助docker容器运行ollama

详细说一下windows的下载:

现在是无法选择下载文件夹的,默认是下载的C盘,但是模型下载目录是可以指定的,在系统变量中新建ollama_models变量,指定一个目录,不要指定c盘

ollama后台指令

ollama通过命令行指令启动服务

使用方法:

ollama [flags]

ollama [command]

可用命令:

serve 启动ollama

create 从模型文件创建模型

show 显示模型信息

run 运行模型

pull 从注册表中拉取模型

push 将模型推送到注册表

list 列出模型

cp 复制模型

rm 删除模型

help 获取有关任何命令的帮助信息

标志:

-h, --help 显示ollama的帮助信息

-v, --version 显示版本信息

使用 "ollama [command] --help" 获取有关特定命令的更多信息

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

ollama RestfulApi

在命令行操作ollama是极其不方便,同时官方也提供了ollama的restful风格的api

我通过接口测试工具测了一下,发现接口使用起来是很简单的,甚至不需要任何身份验证

其中/generate是等全部输出后再一起返回,而/chat则是逐个单词返回

这里放一下请求响应:

POST localhost:11434/api/generate

{

"model": "mistral",

"prompt": "请用中文描述双亲委派机制",

"stream": false

}

POST localhost:11434/api/chat

{

"model": "mistral",

"messages": [

{

"role": "user",

"content": "请用中文回答:python,java,c的执行效率比较,并说明原因"

}

]

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

ollama docker部署

docker中央仓库已经有ollama的镜像了,所以可以直接再docker容器中部署ollama程序

CPU only

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

- 1

Nvidia GPU

docker run -d --gpus=all -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

- 1

总结

按照ollama团队的设想,ollama存在的目的就是提供一个可以再个人电脑上运行大语言模型的环境,而非运行在服务器上

在客户端上运行ai,可以完全依赖客户端的算力

但是ollama有提供了web api和docker部署方案,显然他们也没有放弃服务端部署

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小蓝xlanll/article/detail/668280

推荐阅读

相关标签