- 1git本地电脑客户端小乌龟,如何配置新拉的项目推送远端配置?_tortoisegit remote 设置

- 2对云函数隐藏C2技术的防御反制思路

- 3ubnutu 安装openssh-server 连接 secure CRt_没有可用的软件包 libssl0.9.8,但是它被其它的软件包引用了

- 4河南理工大学计算机学院保研,#研历言谈#优秀保研生介绍之测绘篇

- 5深度学习关键技术总结_深度学习的关键技术

- 6java 算法题 - 面试中常见的位操作算法题,2024年最新MongoDB面试中常见问题_java面试算法题

- 7从源码解析 Bert 的 BertPooler 模块_bert pooler

- 8Matlab实现读取CSV文件字符串数据_matlab怎么读csv中的字符串

- 9使用MapReduce进行编程来对数据进行处理和计算_能用平台编写mapreduce 程序并分析该程序的数据处理、map阶段、reduce阶段、迭代

- 10Hive所有字段类型汇总_hive relapce所有字段为

Orange Pi AI Pro 开箱 记录

赞

踩

香橙派 AIpro(OrangePi AIpro)是一款面向AI开发的强大开发板,提供了高性能和多功能的开发环境。我将结合自己的开发经验,详细介绍这款开发板的性能、适用场景及使用体验。

一、产品概述

香橙派 AIpro配备了强大的硬件配置,包括8GB内存、电源、散热组件和32GB存储卡。这些硬件为AI开发提供了充足的资源和稳定的运行环境。

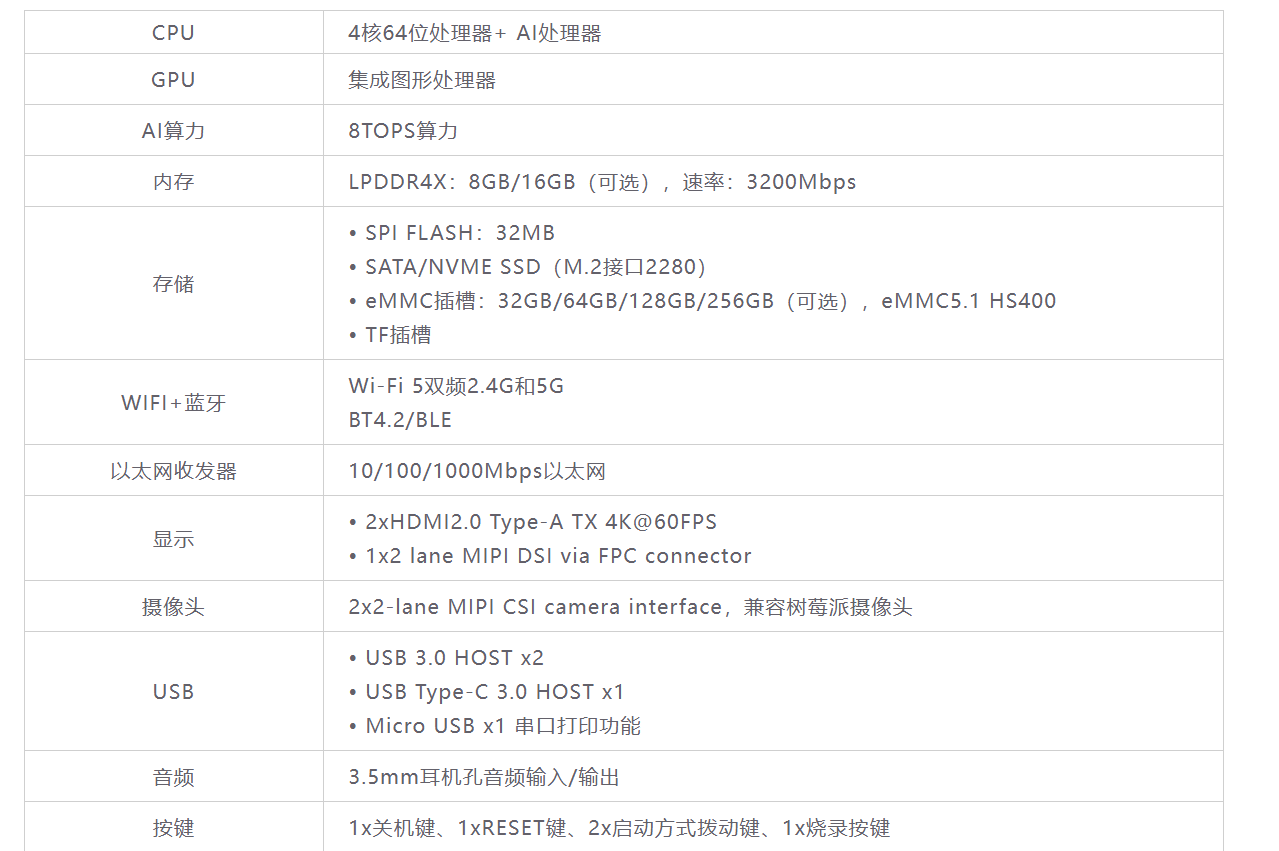

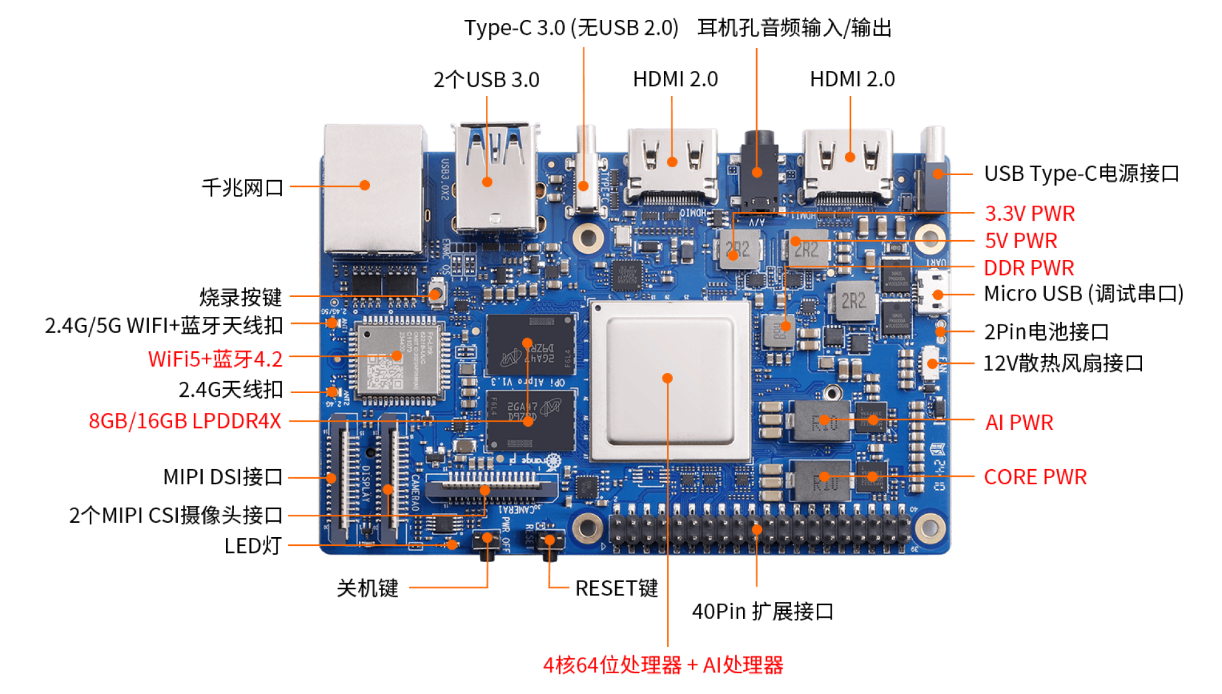

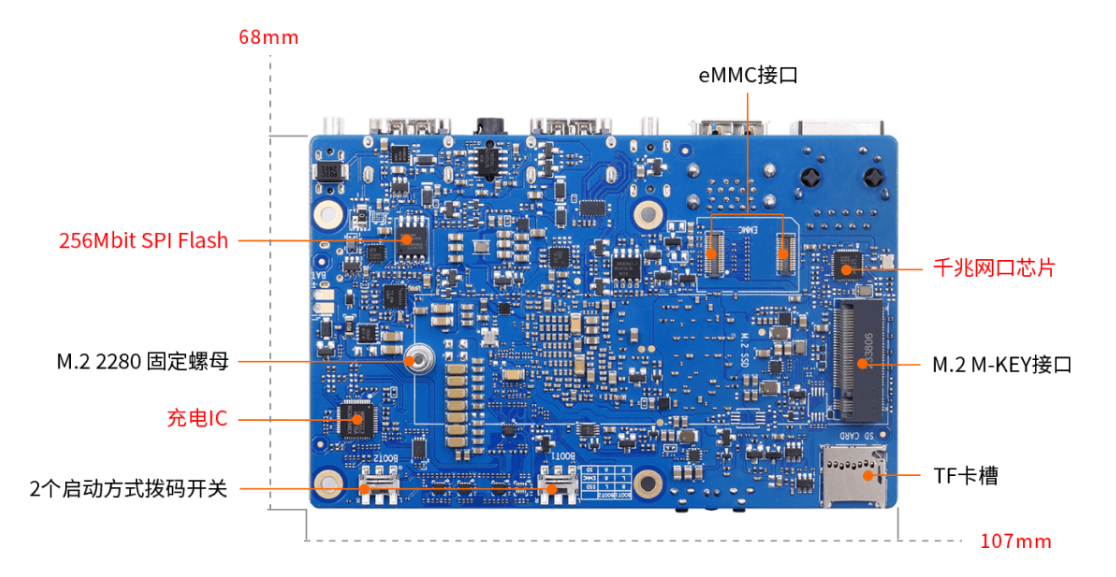

OrangePi AIpro(8T)采用昇腾AI技术路线,4核64位处理器+AI处理器,集成图形处理器,支持8TOPS AI算力,拥有8GB/16GB LPDDR4X,可以外接32GB/64GB/128GB/256GB eMMC模块,支持双4K高清输出。 Orange Pi AIpro引用了相当丰富的接口,包括两个HDMI输出、GPIO接口、Type-C电源接口、支持SATA/NVMe SSD 2280的M.2插槽、TF插槽、千兆网口、两个USB3.0、一个USB Type-C 3.0、一个Micro USB(串口打印调试功能)、两个MIPI摄像头、一个MIPI屏等,预留电池接口,可广泛适用于AI边缘计算、深度视觉学习及视频流AI分析、视频图像分析、自然语言处理、智能小车、机械臂、人工智能、无人机、云计算、AR/VR、智能安防、智能家居等领域,覆盖 AIoT各个行业。 Orange Pi AIpro支持Ubuntu、openEuler操作系统,满足大多数AI算法原型验证、推理应用开发的需求。

二、开发体验

1. 硬件安装

安装香橙派 AIpro非常简单,按照官方提供的说明书,连接好电源、散热组件和存储卡,整个过程不到三分钟。

到手后如图所示:有一个板子、一个充电器,然后板子上已经装好了风扇和sd卡,sd卡预装了 orange pi 的 linux 系统(系统是官方定制的Ubuntu20.04,也可以换为openEuler版本)。

2. 系统安装

香橙派 AIpro支持多种操作系统,包括Ubuntu和openEuler。到手的办卡已经内置了Ubuntu系统。如果需要替换,去官网论坛下载其他镜像,通过烧录工具将系统镜像写入存储卡后,插入开发板,接通电源即可启动。

下载地址:http://www.orangepi.cn/html/hardWare/computerAndMicrocontrollers/service-and-support/Orange-Pi-AIpro.html

3.开发板结构

4. 开发环境配置

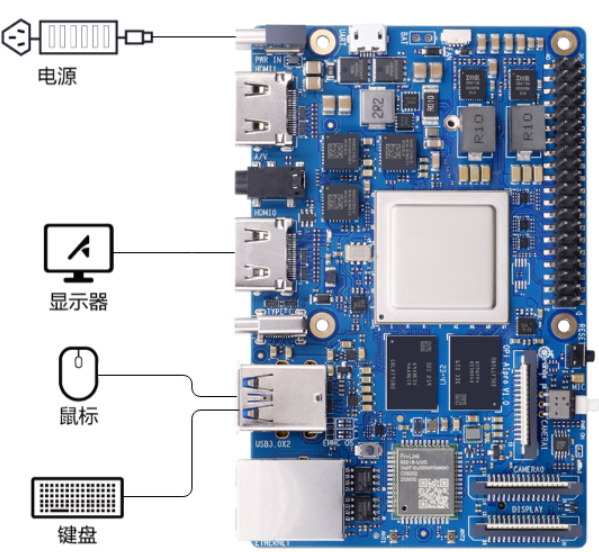

登录方式主要有两种,一种是通过远程ssh,给香橙派插入网线,然后找到其局域网地址,ssh上即可。另一种是直接给开发板接屏幕、键盘、鼠标。我是后面这种方案。(如下图所示)。

由于Orange Pi AI Pro 已经内置了 wifi 模块,我单独准备的有:

- 无线鼠标 x 1、无线键盘 x 1

- 嵌入式屏幕 x 1、hdmi 线(用于连屏幕)x1

刚好我手上都有,所以直接开始下一步。

- 分别给香橙派、屏幕供电,然后hdmi线连接屏幕,以及插上两个无线键盘鼠标的信号接收器就成功开机啦。【开发板上电后,LED指示灯绿色常亮,表示启动正常。】

- 刚开机的时候风扇可能会声音比较大,开机后会保持稳定声音变的很小。

- 效果如下图:

在Ubuntu系统上,安装Python和TensorFlow等常用的AI开发工具。香橙派 AIpro的8GB内存在运行这些工具时表现出色,开发环境配置过程非常顺畅,没有出现卡顿或性能不足的情况。

三、性能测试

1 图片识别

为了测试香橙派 AIpro的性能,我选择了一个常见的机器学习任务——图像分类。在开发板上运行了一个预训练的卷积神经网络模型,整个推理过程非常流畅,处理速度也很快,充分展示了这款开发板的强大性能。

在 /opt/opi_test 下预置有一些测试代码可以体验。

香橙派默认密码:Mind@123

su # 记得需要root

cd /opt/opi_test

# 这里有很多测试代码,可供学习

cd ResnetPicture/scripts/

bash sample_run.sh

# 如果这里报错大概率是没root登录导致的

- 1

- 2

- 3

- 4

- 5

- 6

- 7

2 手写数字识别

参考项目:https://gitee.com/ascend/EdgeAndRobotics/tree/master/Samples/HandWritingTrainAndInfer

git clone https://gitee.com/ascend/EdgeAndRobotics.git

# 切换到样例目录

cd EdgeAndRobotics/Samples/Mnist_For_Pytorch

- 1

- 2

- 3

Pytorch 安装参考官方文档:https://www.hiascend.com/document/detail/zh/canncommercial/700/envdeployment/instg/instg_0046.html

注意版本:PyTorch2.1.0、torchvision1.16.0

# torch_npu由于需要源码编译,速度可能较慢,本样例提供 python3.9,torch2.1版本的torch_npu whl包

wget https://obs-9be7.obs.cn-east-2.myhuaweicloud.com/wanzutao/torch_npu-2.1.0rc1-cp39-cp39-linux_aarch64.whl

# 使用pip命令安装

pip3 install torch_npu-2.1.0rc1-cp39-cp39-linux_aarch64.whl

- 1

- 2

- 3

- 4

- 5

配置离线推理所需的环境变量:

# 配置程序编译依赖的头文件与库文件路径

export DDK_PATH=/usr/local/Ascend/ascend-toolkit/latest

export NPU_HOST_LIB=$DDK_PATH/runtime/lib64/stub

- 1

- 2

- 3

安装离线推理所需的ACLLite库(参考https://gitee.com/ascend/ACLLite)

CANN版本要求: 7.0及以上社区版本。【参考https://www.hiascend.com/zh/document安装CANN】

# 我这里是ubuntu

apt-get install ffmpeg libavcodec-dev libswscale-dev libavdevice-dev

# 拉取ACLLite仓库,并进入目录

git clone https://gitee.com/ascend/ACLLite.git

cd ACLLite

# 设置环境变量,其中DDK_PATH中/usr/local请替换为实际CANN包的安装路径

export DDK_PATH=/usr/local/Ascend/ascend-toolkit/latest

export NPU_HOST_LIB=$DDK_PATH/runtime/lib64/stub

# 安装,编译过程中会将库文件安装到/lib目录下,所以会有sudo命令,需要输入密码

bash build_so.sh

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

到现在完成了基础环境的安装。下面是运行配置:

设置环境变量减小算子编译内存占用

export TE_PARALLEL_COMPILER=1

export MAX_COMPILE_CORE_NUMBER=1

# 运行训练脚本

python3 main.py

- 1

- 2

- 3

- 4

训练脚本后,会自动下载Mnist数据集,数据集目录结构如下:

├── dataset

├──MNIST

├──raw

│──train-labels-idx1-ubyte.gz

│──train-labels-idx1-ubyte

│──train-images-idx3-ubyte.gz

│──train-images-idx3-ubyte

│──t10k-labels-idx1-ubyte.gz

│──t10k-labels-idx1-ubyte

│──t10k-images-idx3-ubyte.gz

│──t10k-images-idx3-ubyte

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

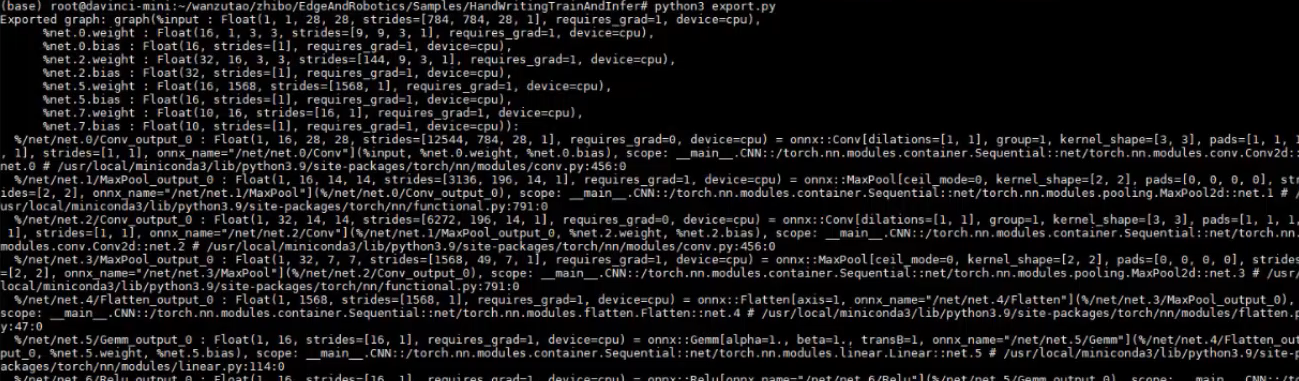

执行以下命令,将训练生成的mnist.pt转换mnist.onnx模型:mnist.onnx模型生成在当前路径下

python3 export.py

- 1

执行以下命令,获取在线推理的测试图片。

cd data

wget https://obs-9be7.obs.cn-east-2.myhuaweicloud.com/wanzutao/mnist/8.jpg

- 1

- 2

执行在线推理。

cd ../onnxInfer/

python3 infer.py

- 1

- 2

模型可以正确识别为8。

因为我这里没有usb摄像头,所以就不进行目标检测的演示了。

四、适用场景

香橙派 AIpro适用于多种AI开发场景,包括但不限于:

- 图像处理:高效的硬件支持图像分类、目标检测等任务,广泛应用于视频图像分析、智能安防等领域。

- 自然语言处理:强大的计算能力使其能轻松处理文本生成、情感分析等任务,适用于自然语言处理和智能家居等应用。

- 边缘计算:小巧的体积和低功耗设计,使其在边缘计算中具有显著优势,特别适用于AI边缘计算、智能小车、机械臂和无人机等场景。

- 深度视觉学习和视频流AI分析:凭借其强大的性能,香橙派 AIpro在深度视觉学习和视频流AI分析中表现出色,可应用于AR/VR和智能安防等领域。

- 云计算和AIoT:作为AIoT领域的重要设备,香橙派 AIpro覆盖了从云计算到各个AIoT行业的广泛需求。

五、使用感受

总体来说,香橙派 AIpro是一款性能优越的AI开发板,硬件配置强大,开发环境友好,适用于多种AI应用场景。特别是在图像处理和边缘计算方面,表现尤为出色。非常适合硬件创客去做一些DIY应用。