热门标签

热门文章

- 1西北农林科技大学2024学年C++面向对象程序设计OJ——T14 安全数组类模板

- 2Java分布式锁,搞懂分布式锁实现看这篇文章就对了

- 3IDEA通过jar文件引入jar包_idea jar in jar

- 4如何实现靠谱的分布式锁技术?

- 5编写MapReduce程序,统计每个买家收藏商品数量,实现统计排序功能_使用mapreduce统计数量占比

- 6密码系统的安全性

- 7python flask框架学习(三)——豆瓣微信小程序案例(二)整理封装block,模板的继承...

- 8数据结构:4.1.2二叉搜索树的插入

- 9python中的import heapq模块中几个主要的函数

- 10Python如何获取列表长度?_python列表长度

当前位置: article > 正文

Windows里使用ollama本地大模型部署_windows 部署大模型

作者:小蓝xlanll | 2024-06-17 18:34:11

赞

踩

windows 部署大模型

下载

ollama官网进行下载

下载完后下一步下一步即可

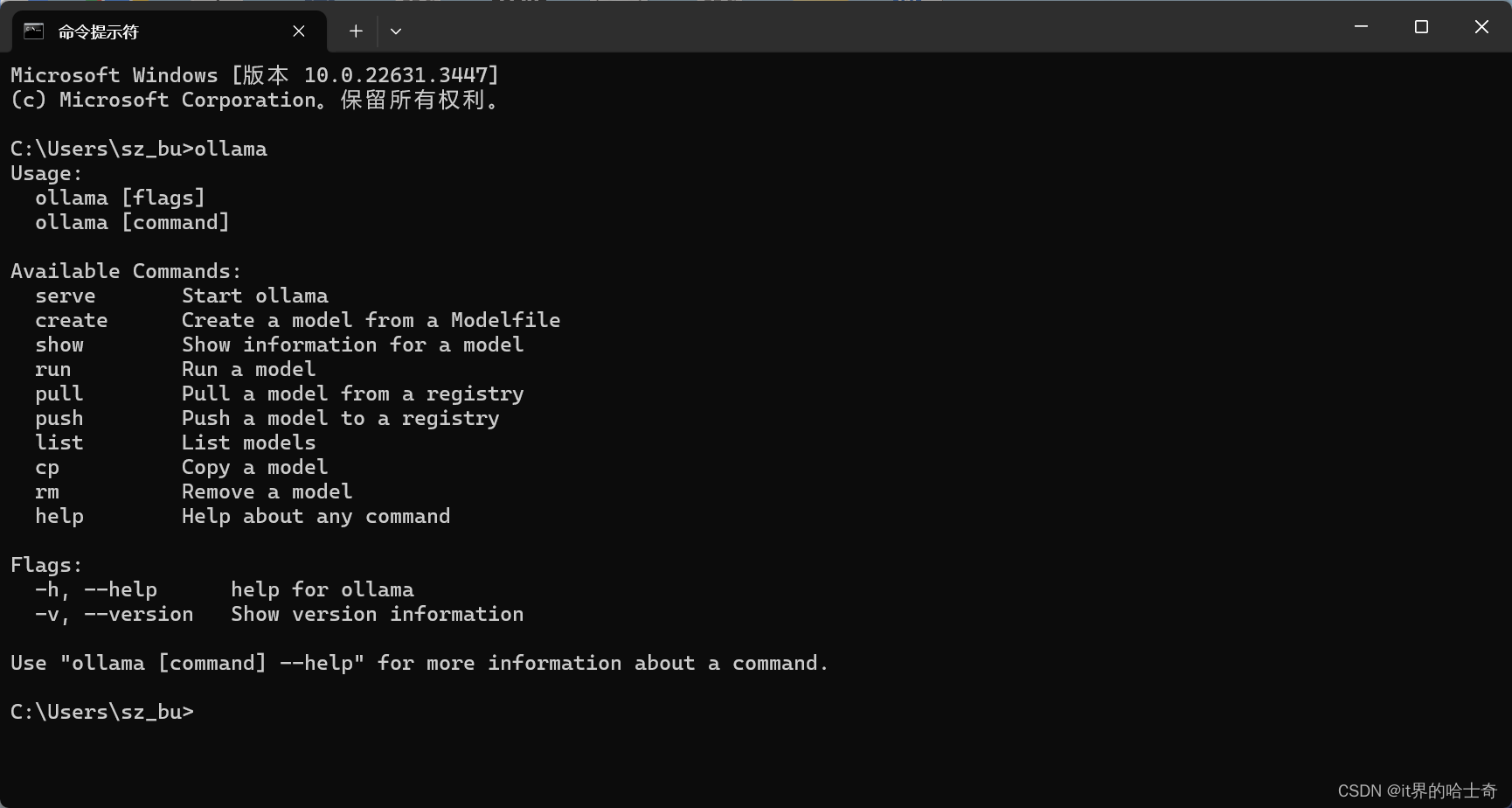

安装完成后验证是否成功,打开命令行输入ollama,有该指令即安装成功

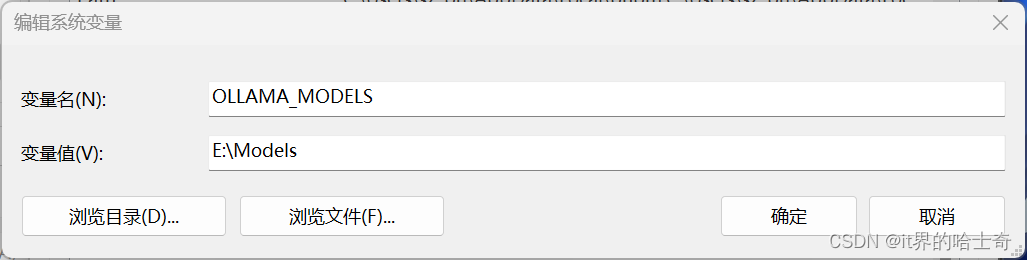

环境变量配置

ps: 如果已经打开了ollama,需要重启ollama才能生效!!!

安装大模型

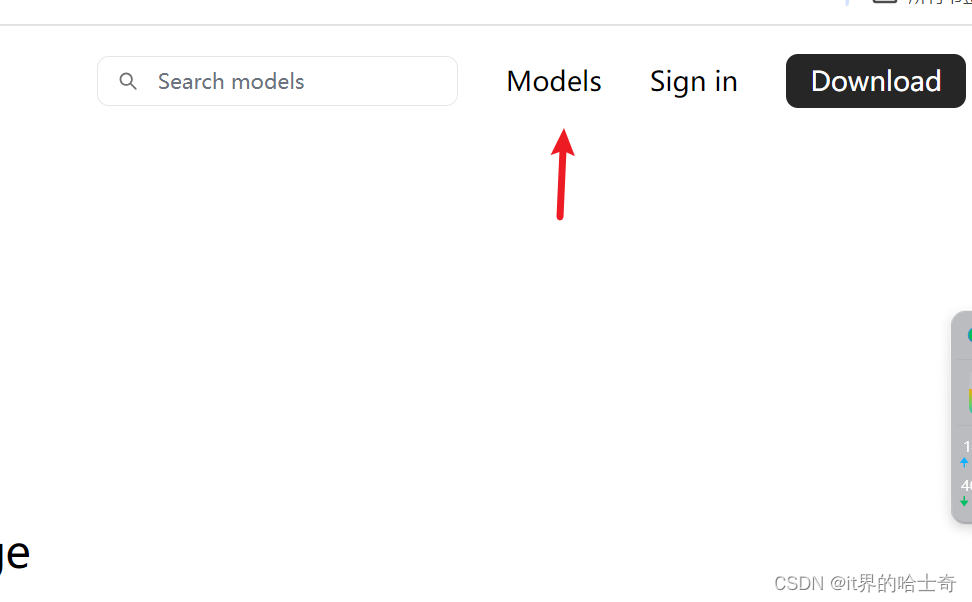

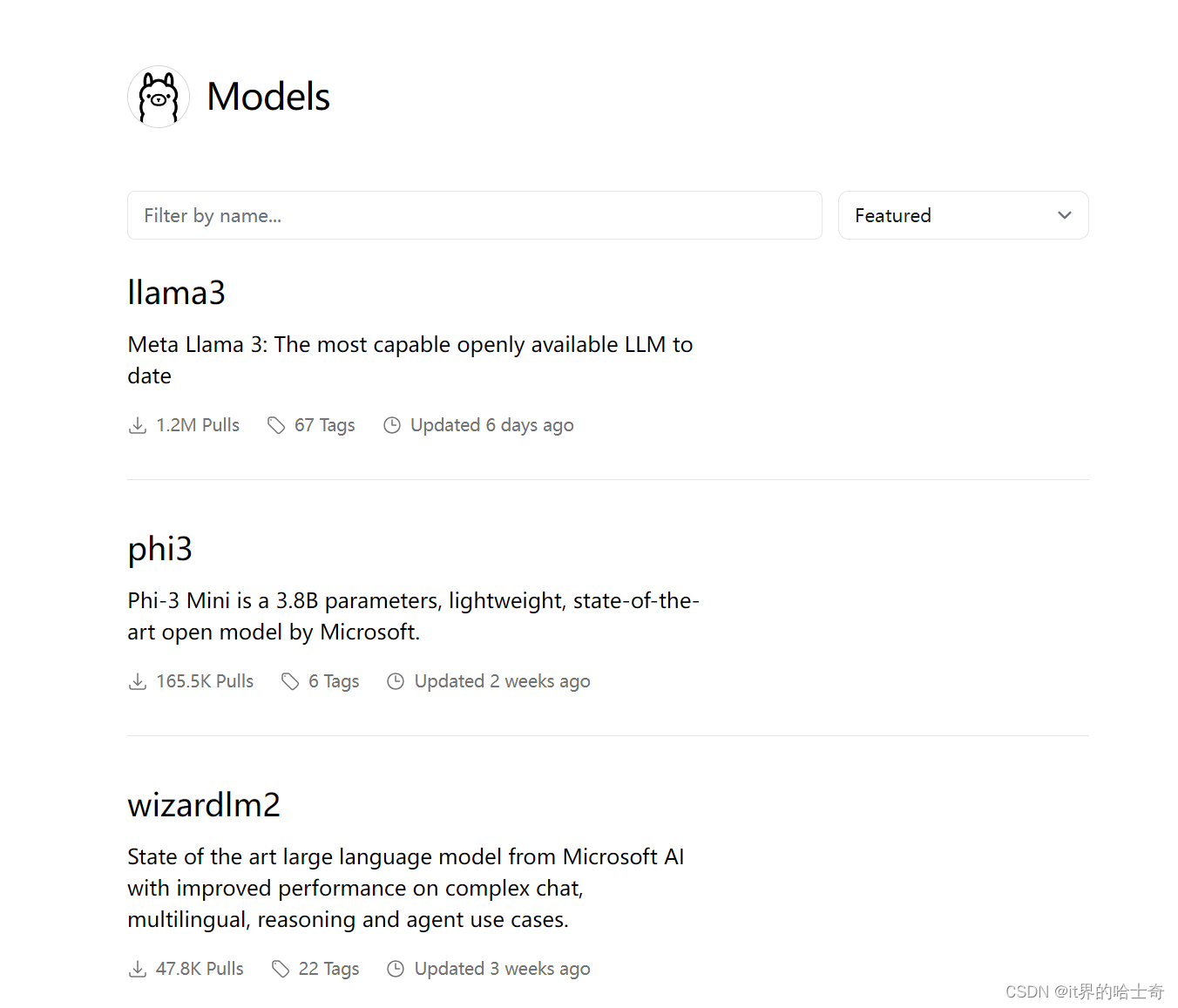

回到官网,点击右上角的models

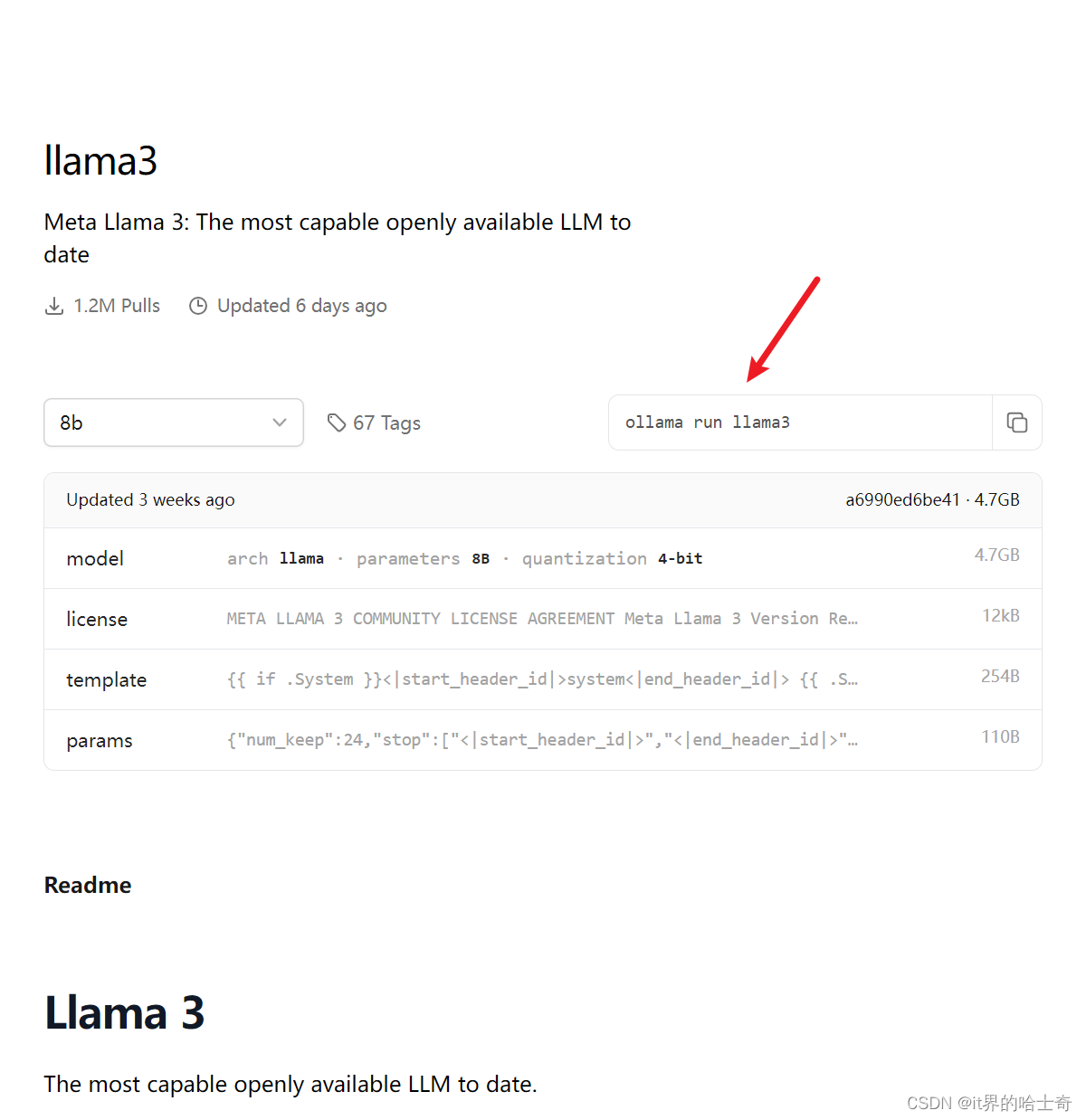

选择自己想要的模型,点进去

在命令行中执行对应的命令即可

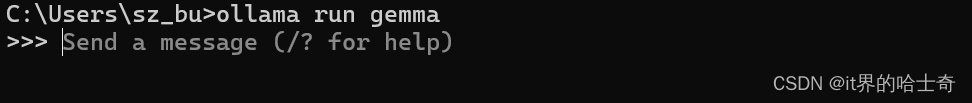

安装完成后即可在命令行进行对话

安装图形化界面

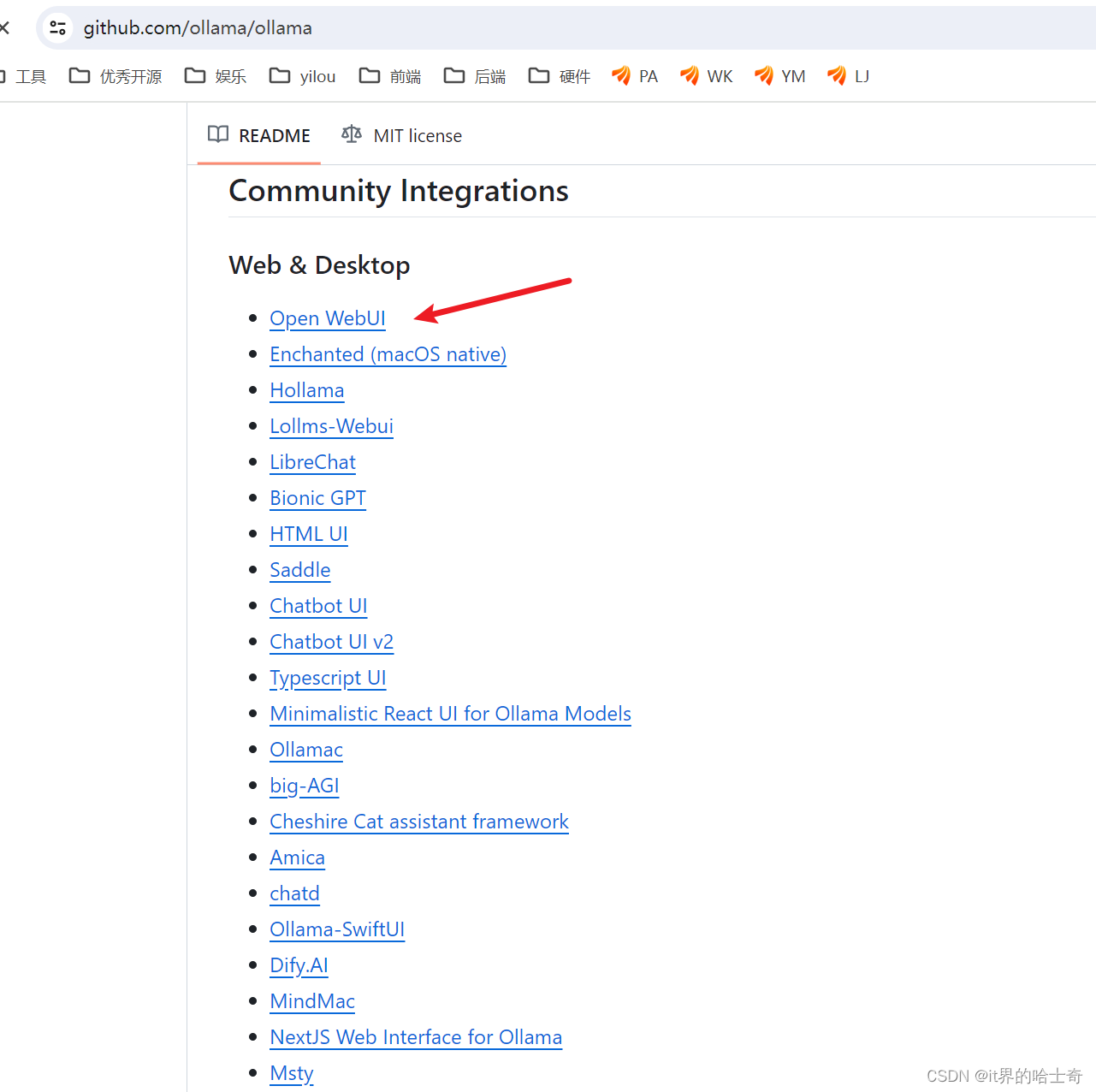

在ollama的github的介绍上面,有多个已经适配了ollama的web可以选择

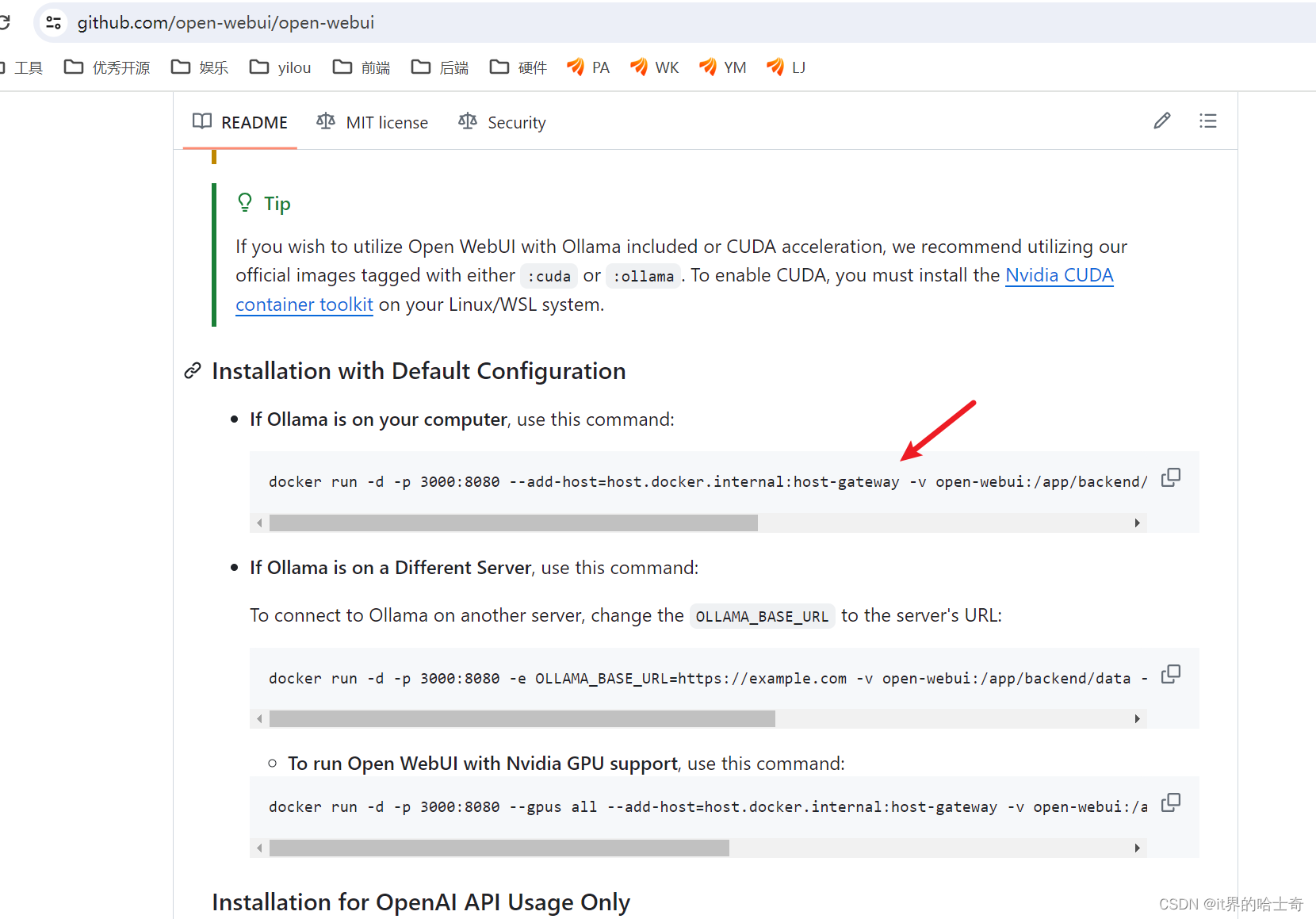

这里选open-webul为例,找到对应的github仓库,安装文档安装,这里选择docker安装

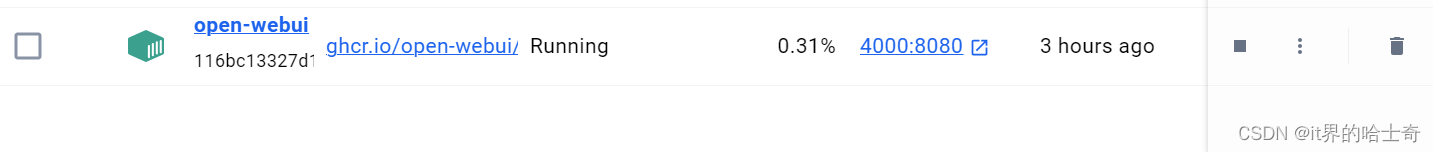

我配置的的映射端口是4000,如果按github上的脚本是3000

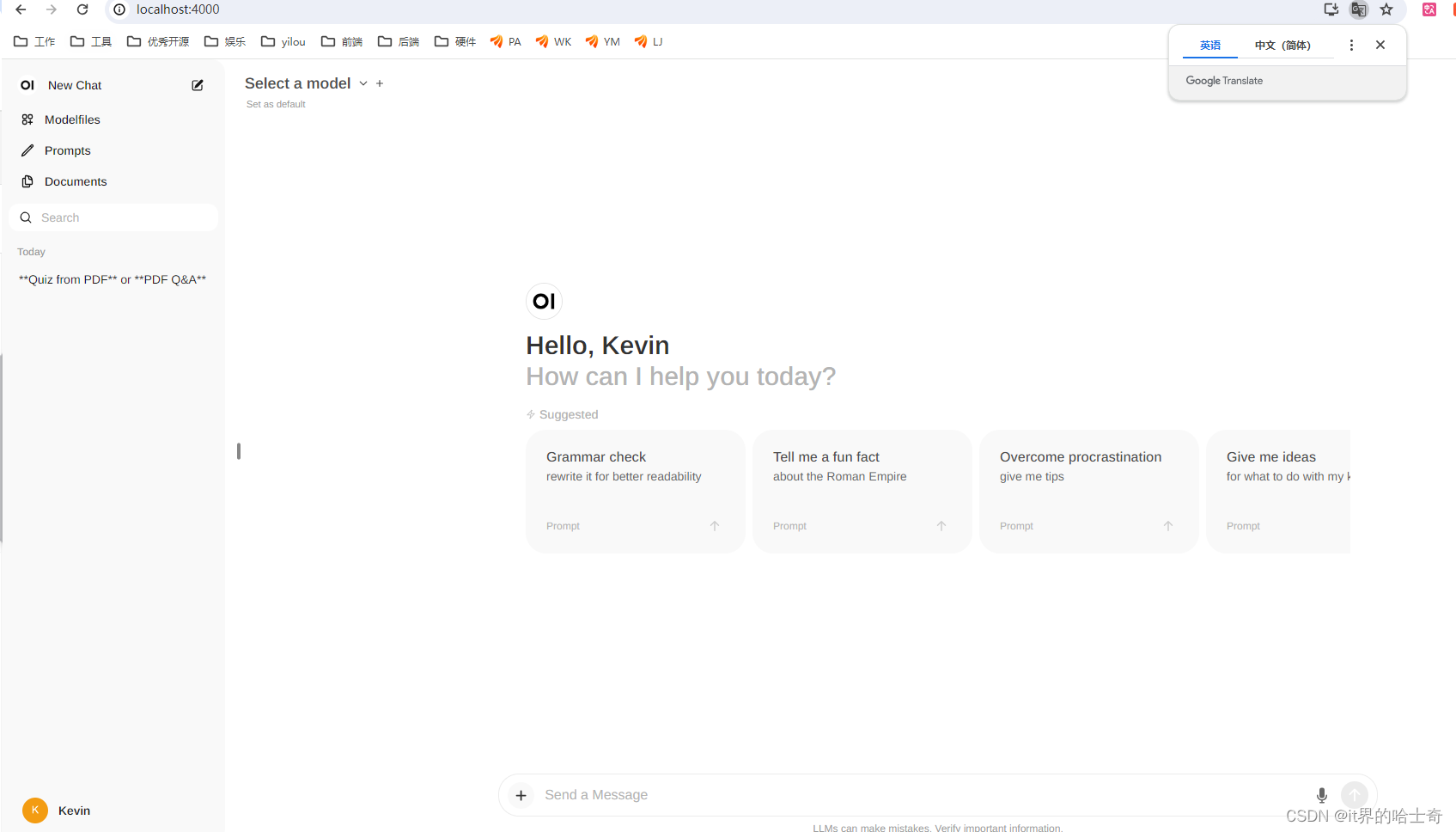

浏览器输入地址打开对应的网页

第一次进入要注册,首次注册的是管理员账号

然后就可以聊天了

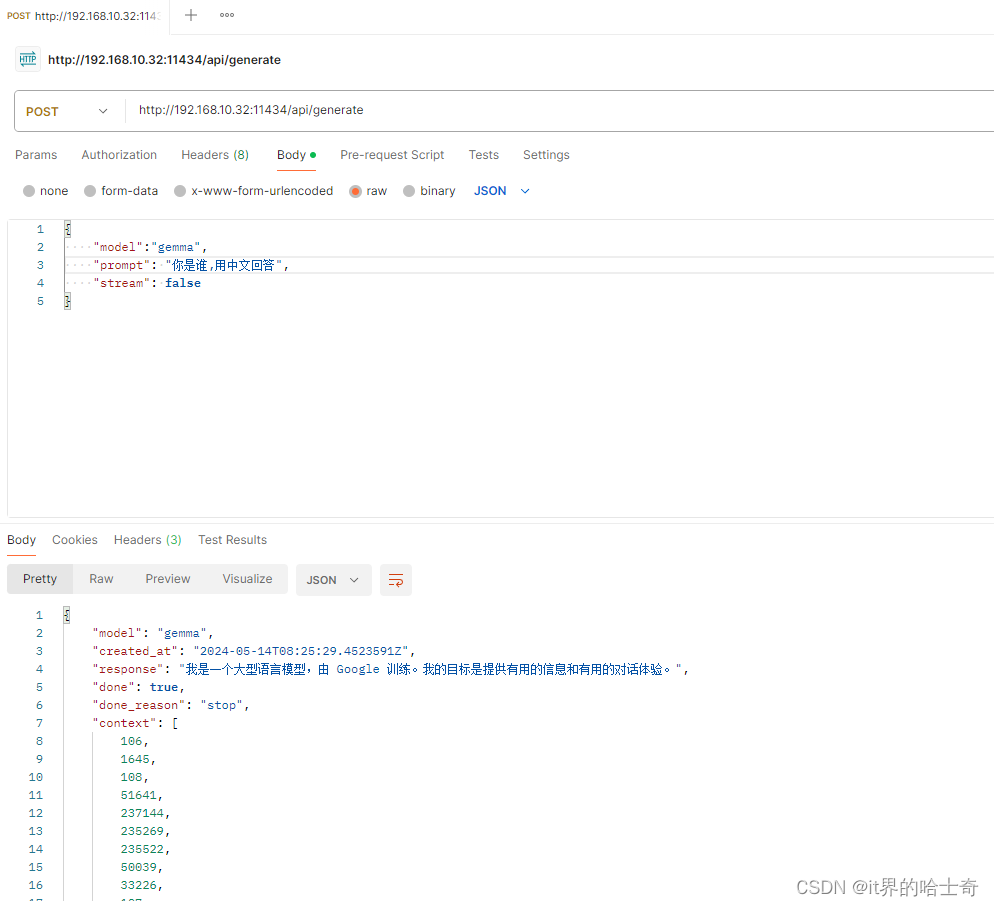

api访问

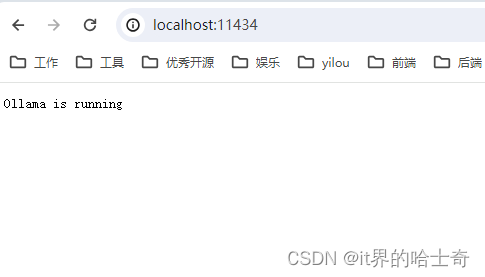

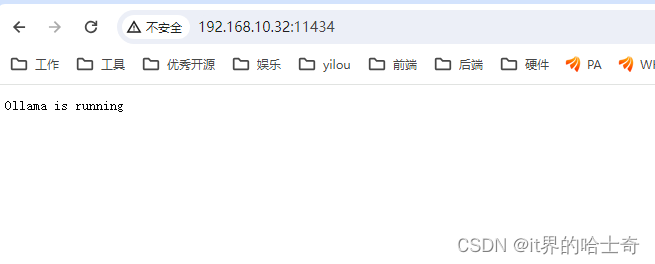

如果是本地访问,直接调用11434端口即可

如果是外部访问,需要配置上面的第二条环境变量

然后就可以发请求玩了

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小蓝xlanll/article/detail/732325

推荐阅读

相关标签