热门标签

热门文章

- 1解决微信小程序报[ app.json 文件内容错误] app.json app.json 未找到,未找到入口 app.json 文件,或者文件读取失败,请检查后重新编译。小程序app.json报错_dist/dev/mp-weixin/app.json: 根据 project.config.jso

- 2远程桌面无法连接上(管理员已结束了会话)的解决方法

- 3(Vue2版本)Uniapp编写H5项目_uniapp创建h5项目

- 4ceph-objectstore-tool

- 5HarmonyOS鸿蒙原生应用开发设计- 图标库_鸿蒙图标库

- 6使用python在视频上渲染文本

- 72024 年最值得推荐的几款小众软件(二):哪些软件让眼前一亮,让你事半功倍!_wifi mouse 和wifi mouse pro 区别

- 8git 利用好git status的提示信息_changes not staged for commit: (use "git add

- 9报错:与目标 VM 断开连接, 地址为: ‘‘127.0.0.1:56529‘,传输: ‘套接字‘‘

- 10java 日期判断 给定日期是否为当天 一周7天以内 一周7天以外_判断时间是否是7天内 java

当前位置: article > 正文

《英伟达-本地AI》--NVIDIA Chat with RTX-本机部署_chat with rtx 部署 中文

作者:很楠不爱3 | 2024-03-15 06:59:33

赞

踩

chat with rtx 部署 中文

阿丹:

突然发现公司给配置的电脑是NVIDIA RTX 4060的显卡,这不搞一搞本地部署的大模型玩一玩???

从0-》1记录一下本地部署的全过程。

本地模型下载地址:

Build a Custom LLM with Chat With RTX | NVIDIA

GitHub上的开发者下载地址:

下载的文件有32个G!!

开始安装:

为了方便观看我直接放翻译的版本:(跟着红色箭头就可以了)

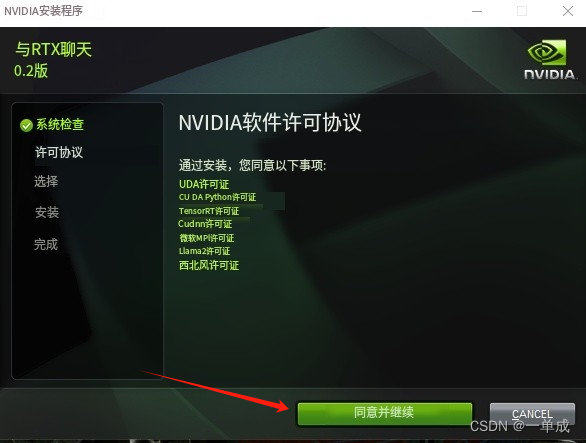

安装许可:

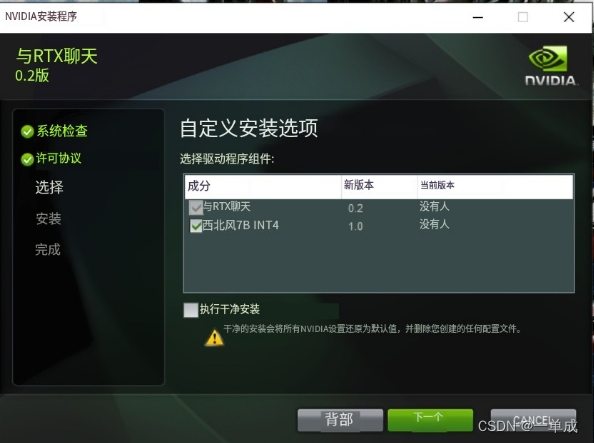

这个应该是选择安装的功能:

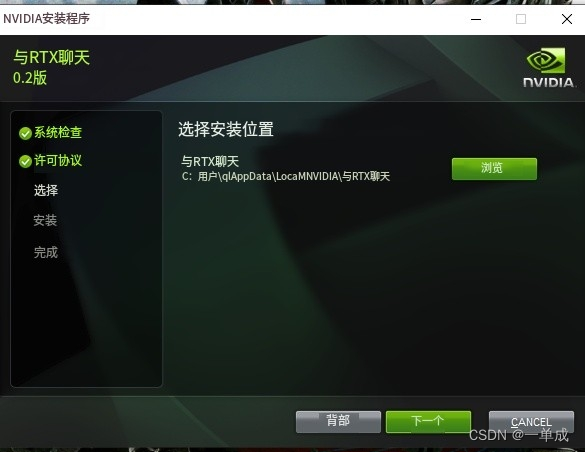

选择安装的位置:

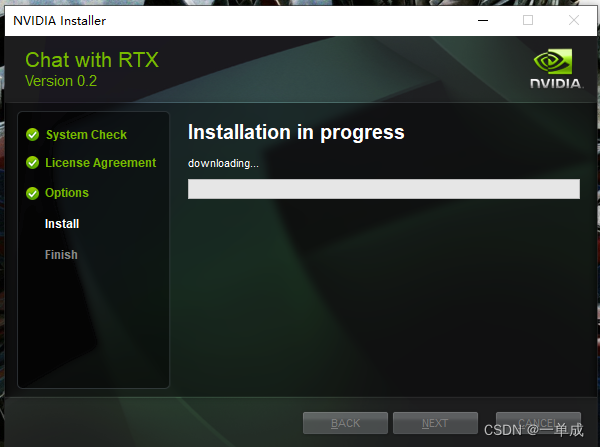

开始安装:(这个下载的过程需要使用科学的上网环境!)

然后开始漫长的等待安装。。。。。。

点击完成:

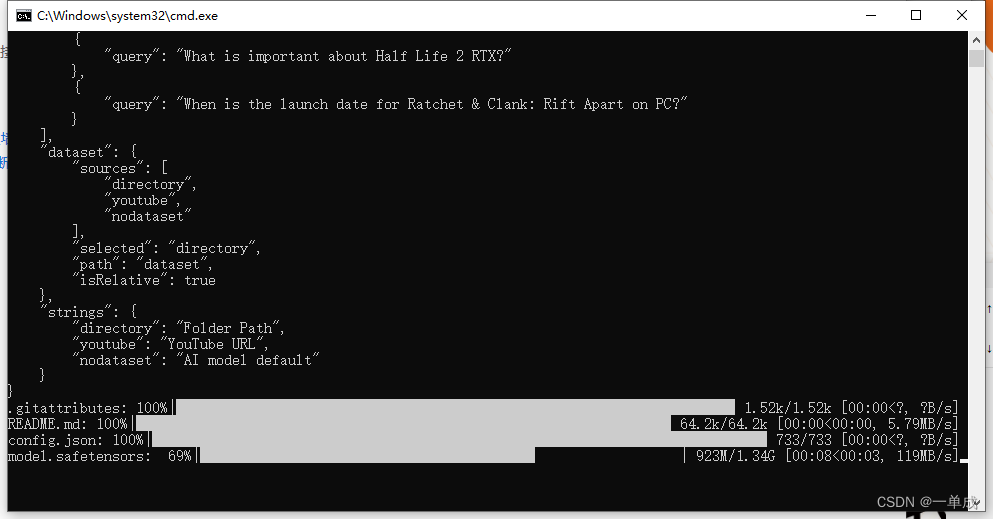

双击第一次会开始下载数据也是一些依赖

这些依赖下载完毕就欧克了。

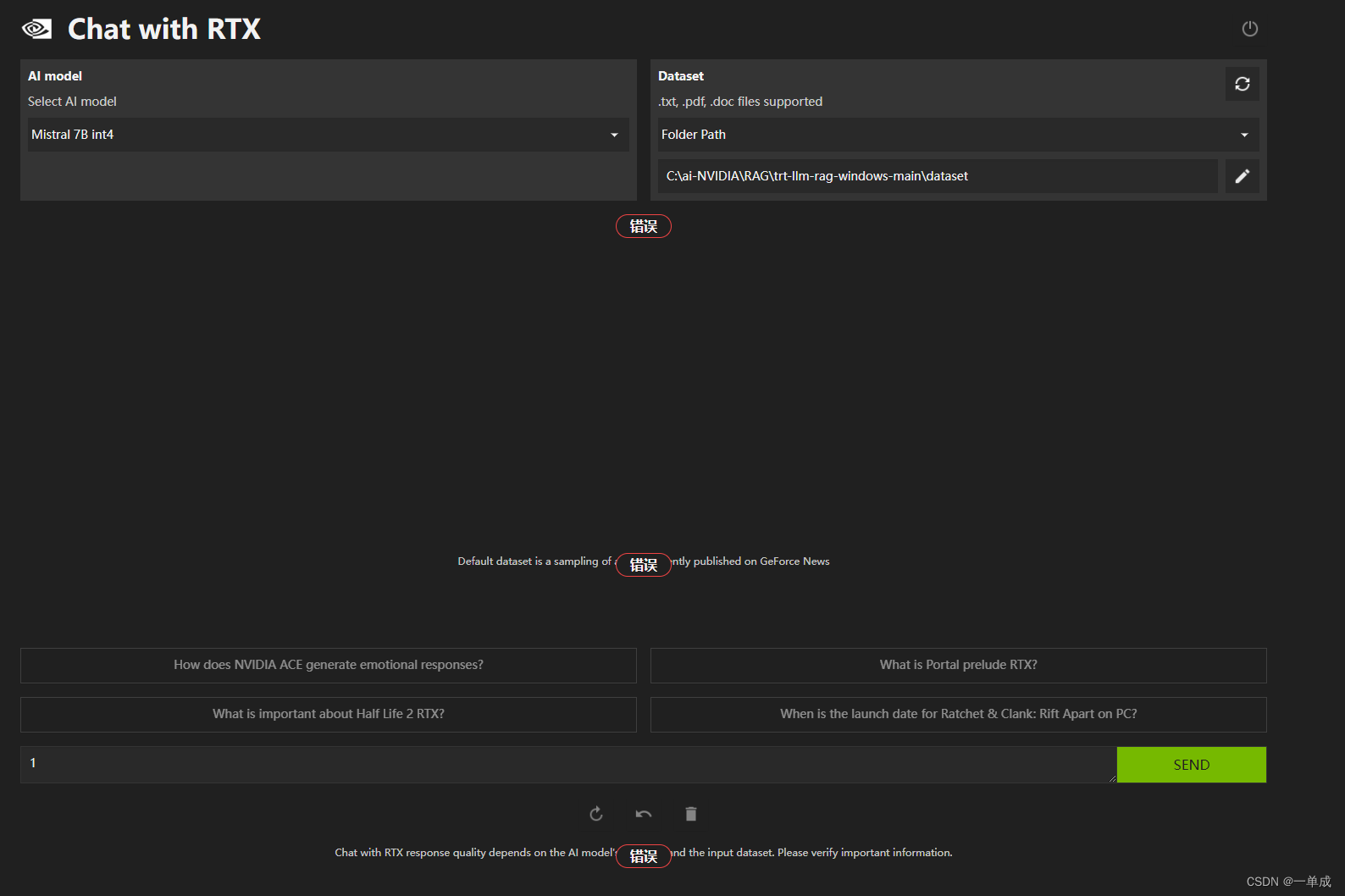

会自己将网页打开。

但是在本地访问的时候出现了一些问题。

但是在本地访问的时候出现了一些问题。

要注意的是。在本地运行的时候需要开启科学的上网环境。

下个文章我会重点解决和汇总一下我在安装的时候出现的问题。集中一起解决。

部署问题解决文章:

《英伟达-本地AI》--NVIDIA Chat with RTX--部署问题:ValueError: When localhost is not accessible-CSDN博客

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/很楠不爱3/article/detail/239319?site

推荐阅读

相关标签