- 1【开题报告】Springboot大学生创新创业项目管理60qsr计算机毕业设计_java项目springboot 大学生创新创业项目论文开题报告

- 2微调Llama2自我认知_self_cognition 数据集

- 3【MATLAB源码-第176期】基于matlab的16QAM调制解调系统频偏估计及补偿算法仿真,对比补偿前后的星座图误码率。

- 4强强联手,丝滑办公新体验!IdeaHub+华为云会议实测_华为idea hub接入

- 5第九层(16):STL终章——常用集合算法

- 6互联网架构演变过程_网络结构演进的过程

- 7图文带你彻底弄懂MySQL事务原子性之UndoLog_mysql undolog 原子性

- 8CVPR-2020笔记 | 文末送书

- 9【腾讯云 TDSQL-C Serverless 产品测评】Serverless集群高可用测评_tdsql-c mysql版 serverless

- 10OpenLayers 开源的Web GIS引擎_openlayers中文官网

带你玩转Jetson之Deepstream简明教程(二)Deepstream是什么?干什么?有什么优势?

赞

踩

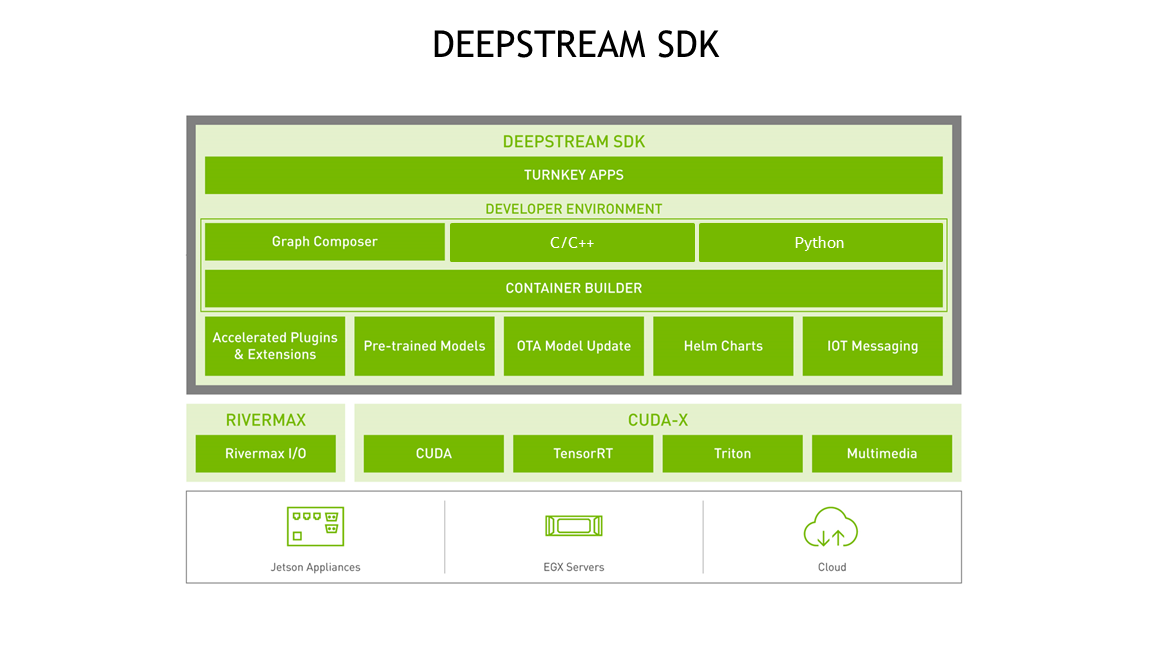

1.Deepstream是什么?

Deepstream是Nvidia公司推出的一套基于开源视频流框架Gstreamer的一套库。其本身由多个.lib.so和.h构成,其支持语言包括了Python和Cpp两种主流语言。你可以在任何Python或者Cpp编译器、开发环境中引用库的API构建属于你自己的推理流。

在这里解释一下,GStreamer 是用来构建流媒体应用的开源多媒体框架(framework),其目标是要简化音/视频应用程序的开发,已经能够被用来处理像 MP3、Ogg、MPEG1、MPEG2、AVI、等多种格式的多媒体数据。

这里打个不恰当的比方类比一下,Gstreamer就相当于是开源OpenCv库,用来开发图像处理软件,而Deepstream实际上就是闭源封装的一个OpenCv算子,可以实现推理等功能。

2.Deepstream用来干什么?

提到Deepstream是用来干什么就必须先提到Gstreamer的功能。Gstreamer框架本身是一个用于做视频流处理和播放的框架,利用Gstreamer的API可以快速搭建类似于一个视频播放器的功能,类似于我们日常所见的windows player。虽然,Gstreamer提供了强大的API用于视频编码、解码、播放等接口,但是这些接口对于Nvidia的GPU调度和使用并不充分,并没有完全利用起来并行计算的相关资源。因此就有了Accelerated-Gstreamer。这个Accelerated-Gstreamer主要是实现了视频编码、解码、推流、OSD、缩放、混流等等的并行化操作,用较低的延迟实现极大的吞吐量。Accelerated-Gstreamer官方文档链接在此。

Deepstream在Accelerated-Gstreamer插件的基础上增加了推理插件,可以实现整个视频流的并行化,通过调度GPU和Nvidia专属的硬件加速来实现一定延迟下的大吞吐量的视频流接受,转码,堆叠缩放、推理、OSD、物联网消息收发、视频编码、推流等一系列操作。

如何区分原始的Gstreamer插件和英伟达加速后的插件?其实很简单,只需要确认插件名称前缀是否带有“nv”字样即可。例如nvosd插件就是并行化加速后的。

所以总而言之,Deepstream是用来做几乎全套并行化加速的视频AI推理流应用的。

3.Deepstream具有什么优势?

推理框架千千万,我们为什么要用Deepstream?他有什么优势?

虽然你可以使用其他框架替换掉Deepstream的每一个环节,推理可以自己做部署,解码可以有其他的库,例如ffmpeg,显示可以用OpenCv等等。但是最核心最关键的问题是,你使用其他框架,无法调动Nvidia的所有硬件。

优势之一:调动你能想到的、想不到的底层硬件

以Jetson为例,除了我们熟知的GPU单元,解码需要调用NVDEC硬件解码器,编码需要用到NVENC编码器,OSD操作和光流跟踪需要用到英伟达的VIC硬件,如果你的网络是比较轻量或者是网络层支持,可以直接放入英伟达DLA深度学习计算模块直接推理,以上所有硬件都可以帮助CPU和GPU缓解计算负担,如果不使用Deepstream SDK,上面这些硬件想要全部调动起来并不容易。甚至部分硬件根本没有底层API可以调用。而在Deepstream中,只需要通过程序代码设置或者TXT文档配置即可调用上述相关硬件,无需关心底层实现。

优势之二:能够用较低延迟获取极高的推理性能

在Jetson设备上,如果我们运行原版的YoloV3,我们根据型号不同,会获得不同推理表现效果。nano上面大约5-10帧,nx可以20帧。但这对于多路摄像头取流推理根本是杯水车薪。

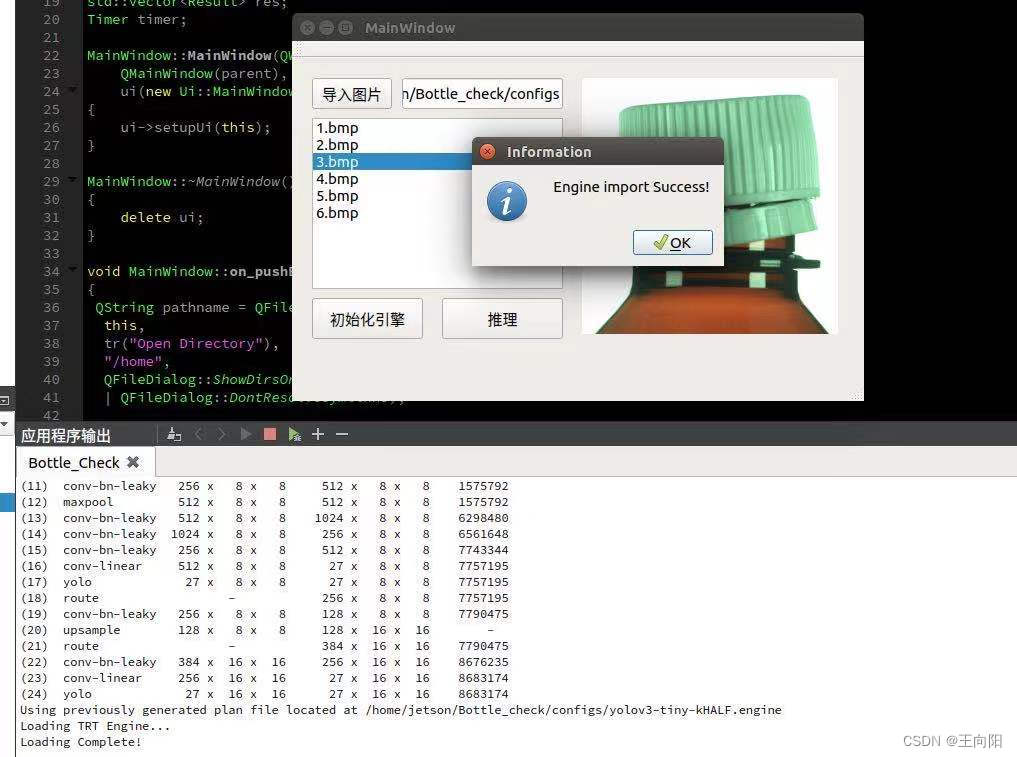

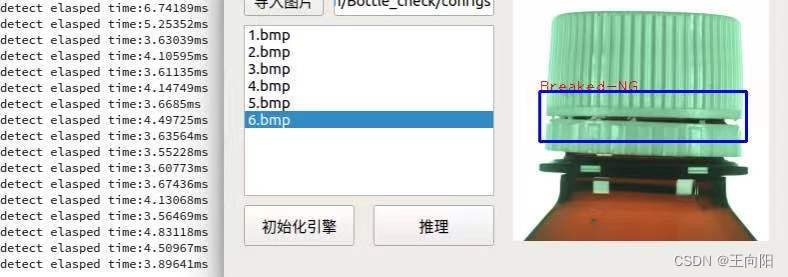

Deepstream底层集成了Nvidia TensorRT量化框架,通过TensorRT量化后的模型,推理帧率可以得到倍数提升。例如很久之前做得一个塑料瓶口质量检测推理,原版yolo只能提供30fps,经过python版本的trt加速以后获得了70fps的帧率,经过Cpp的trt加速以后可以获得200fps+的帧率,推理一张500x500的图片只需要3ms+。这是其他嵌入式平台无法比拟的优势。

但是这些并不是完全没有代价的。据我观察Deepstream系列在嵌入式Jetson上面会根据推理负载的不同产生不同的延时,比较理想的情况是在几百毫秒左右。这样对于实时性比较高的推理就需要针对性优化网络大小、图片输入大小、batch、跳帧推理、优化分辨率等。在一些监控性质的项目上对于实时性要求不高,所以使用起来基本没问题。当然你可以往上堆设备性能去解决延迟问题。

优点之三:巨快的技术回复

Nvidia官方论坛技术支持这点必须表扬一下,Nvidia的技术论坛有问必答,只要你把完整的bug,error日志贴出来,给出具体的环境,研发人员会在美国上班时间给你回复问题。有问必答而且可以搜索其他人类似的bug,这一点是其他框架没有的。官方技术论坛链接在此。注意一定要去英文论坛,你会获得更详尽的信息。

优点之四:无脑接入TLT迁移学习框架,不会设计网络也能玩转

Nvidia官方为Deepstream等设计了TLT迁移学习,各种模型譬如目标识别和语义分割、NLP等都有官方的模型,直接用Docker训练以后无缝接入Deepstream,如果你不会深度学习,不知道啊如何设计模型,网络结构,可以直接从官网下载模型迁移训练以后直接部署。Nvidia官方的网络基本够用,适用于对网络要求没那么高的深度学习场景。

缺点之一:和Gstreamer框架深度集成,然而Gstreamer在国内资料少

这是目前遇到比较多问题的地方,很多Gstreamer资料国内没有,查一个Bug需要非常费劲,而且基本没有国内论坛等相关资料。Deepstream本来就是Gstreamer框架下的闭源库,你要想使用就避不开这个Gstreamer。所以需要你恶补这个Gstreamer框架。

缺点之二:偶尔会遇到神奇Bug

之前我遇到过一些神奇Bug,而且很难追查原因。譬如我构建了一个管道,用完了释放掉,再去重新构建,反复如此多次以后莫名其妙程序会崩掉。我确认我已经按照教程正确释放了,给官方论坛也查不出结果,技术人员无法在他的环境复现我的全部程序,人也没有义务这么做,只能说让我仔细检查我的代码。