热门标签

热门文章

- 1机器学习--逻辑回归模型(Logistic Regression)

- 2keil5【问题解决】提示:Target ‘LED‘ uses ARM-Compiler ‘Default Compiler Version 5‘ which is not available_*** target 'led' uses arm-compiler 'default compil

- 3【SCI一区 原创首发】基于SSA-CNN-LSTM-Mutilhead-Attention麻雀算法优化卷积长短期记忆神经网络融合多头注意力机制多变量时间序列预测(matlab完整源码和数据)

- 4基于知识的推荐系统(案例学习)

- 5鸿蒙OS执行效率,鸿蒙OS知多少:四大技术特性,三年遍地开花

- 6洛谷 P8783 [蓝桥杯 2022 省 B] 统计子矩阵

- 7《人工智能》课程作业2_公式集总可以合一

- 8Linux下的tar压缩解压缩命令详解_linux tar

- 9jeecg左右布局左树右表单_jeecg左树右表

- 10基于云ModelArts的PPO算法玩“超级马里奥兄弟”【华为云至简致远】_华为云使用ppo

当前位置: article > 正文

LLM 模型量化推理速度评测_awq量化 推理速度

作者:很楠不爱3 | 2024-04-08 19:45:40

赞

踩

awq量化 推理速度

最近了解了下些常见的推理和加速方案:

1、量化方案:

- gptq、quantization、int8、int4、AWQ、Speculative Decoding、GGUF

2、Attention加速方案:

- atten的不同种类

- fused attention

3、内存层面:

- kv_cache策略、page_attention

- StreamingLLM(这个不能算加速,算技巧)

- batching

- 复用prompt策略

- Continuous batching

4、硬件层面:

- A100最好,越高越好,新的加速硬件

- flash_attention1 & flash_attention2 加速策略

- kernel 算子融合策略

- tensor 并行,分布式

5、模型层面:

- 参数量降低1B?、层数降低、模型结构创新

可能不少遗漏,欢迎各位大佬补充在评论区~

部分经验总结 & 问题:

1、compile 整个模型后的模型确实更快了,如果只compile attention部分加速不大,因为compile优化的空间并不大

2、投机采样测试过程中发现多卡推理 int4 模型出现报错,int8模型没有问题,这个目前没空看了

3、量化确实会带来速度的巨大提升,但是模型效果截图不太方便,效果确实降低了一些

4、AWQ量化后的千问7B模型,效果巨差,暂不确定问题在哪,目测了效果

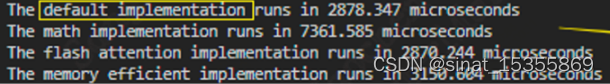

不同cuda_kernel 的测试结果: default vs sdp-math vs sdp-flash vs sdp-efficient:

vllm & compile测试后的结果:

公众号"小晨的AI工作室"回复: "vllm_test" 获得无水印原图~

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/很楠不爱3/article/detail/387785?site

推荐阅读

相关标签