热门标签

热门文章

- 1当世界加速离你而去

- 2【Mac】【Git】 全局配置 忽略 .DS_Store_mac git dostore

- 3苹果PDF压缩工具:PDF Squeezer_pdf squeezer ipad

- 4clang frontEnd插件 常见Traverse函数、Visit函数 例子

- 5pyspark连接MySQL出错 java.sql.SQLException: No suitable driver_pyspark : java.sql.sqlexception: no suitable drive

- 6数据结构笔记1 线性表-顺序表示_!l.elem什么意思

- 7web对象page、request、session、application的生命周期_request,session,cookie,application生命周期区别

- 8文心一言 VS 讯飞星火 VS chatgpt (71)-- 算法导论7.1 1题

- 9SpringCloud--LoadBalancer负载均衡服务调用

- 10minio最新版本(2022.10.31)简易集群搭建(详细到爆)

当前位置: article > 正文

ollama与open-webui、lobe-chat简单使用案例_ollmo运行qwen并生成调用bsh

作者:很楠不爱3 | 2024-04-29 12:41:46

赞

踩

ollmo运行qwen并生成调用bsh

参考:

https://github.com/ollama/ollama

https://github.com/open-webui/open-webui

ollama最为大模型后端服务

open-webui、lobe-chat前端聊天页面

ollama直接下载客服端安装win cpu安装推理;open-webui、lobe-chat使用docker安装

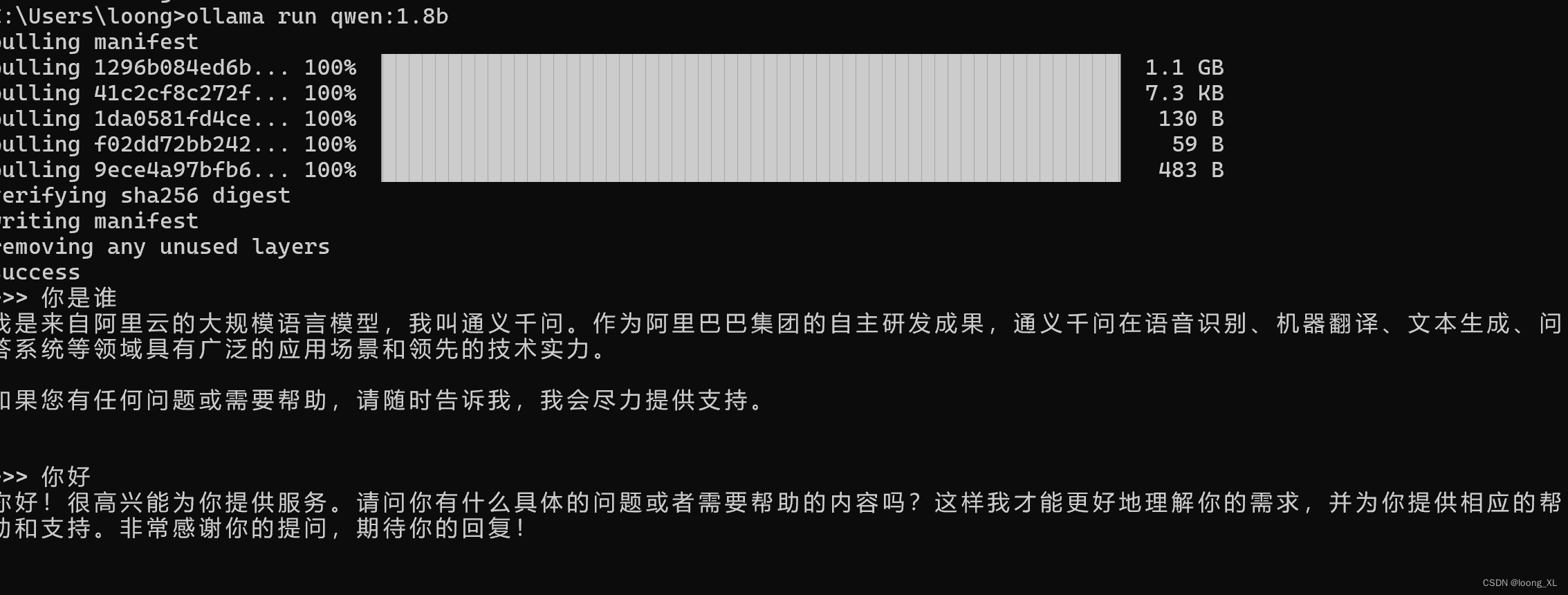

1、ollama

安装好后可以直接运行,cpu使用不稳定比较慢

ollama run qwen:1.8b

- 1

具体可下载模型列表:https://ollama.com/library

2、open-webui

本地安装ollama运行后可以使用下面运行

docker run -d -p 3000:8080 --声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/很楠不爱3/article/detail/507794

推荐阅读

相关标签