- 1物联网数据处理技术课程设计——基于python实现的智能图书馆借阅管理系统(OpenCV+MySQL)_图书管理系统python

- 2码云Gitee 上传代码出现的错误(一)_error: cannot pull with rebase: you have unstaged

- 3Flink:详细的不能再详细的安装步骤(三)[安装步骤]

- 4『现学现忘』Git基础 — 36、标签tag(一)_python git tag

- 5什么是PSD(功率谱密度)_psd谱

- 6重装操作系统win10+重装sqlserver+数据库可视化工具_sql server可视化工具

- 7TransE模型的简单介绍&TransE模型的python代码实现

- 8微信小程序自定义tabbar导航栏,中间凸出样式_微信小程序底部tab栏特殊样式

- 9程序员如何通过被动收入实现“暴富”_程序员 被动收入

- 10ChatGPT爆火网络背后的故事?_chatgpt 故事背景

100%本地离线运行的 ChatGPT最佳替代!支持各大开源的AI大模型,NVIDIA Chat with RTX 部署您的个性化本地人工智能聊天机器人_windows开源大模型单机运行

赞

踩

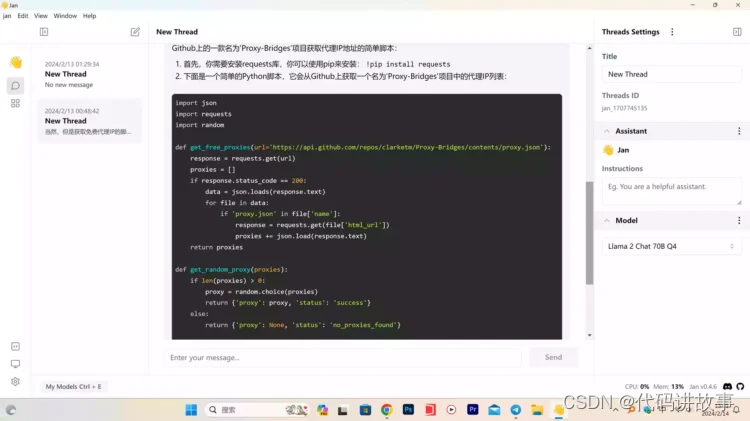

100%本地离线运行的 ChatGPT最佳替代!支持各大开源的AI大模型,NVIDIA Chat with RTX 部署您的个性化本地人工智能聊天机器人。

NVIDIA 最近发布了一款利用RTX AI 加速技术打造的聊天机器人——「Chat with RTX」早期演示程序。只要你拥有配备8GB显存的NVIDIA RTX 30或40系列显卡,就能体验到这一新技术。其亮点在于,用户可以向大型语言模型提供txt、doc、pdf文件或视频链接,从而定制模型以提供个性化的回答。索引工作在本机上进行,因此无需担心隐私问题。

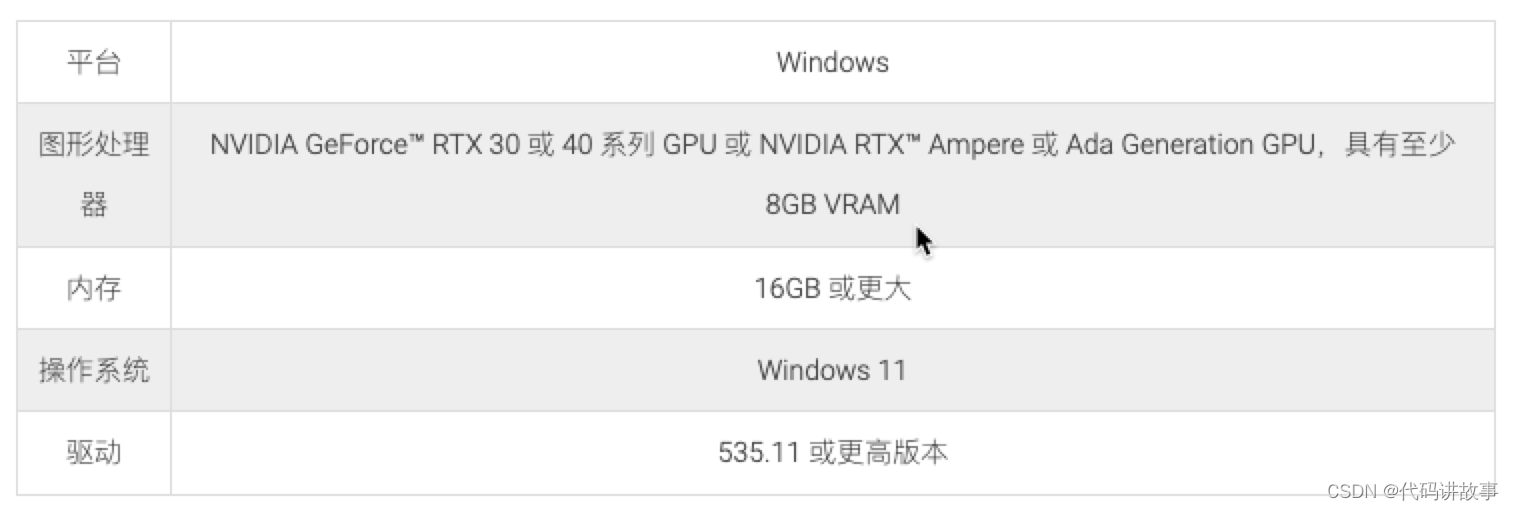

系统要求

官方下载:【点击前往】

Chat with RTX 支持各种文件格式,包括文本、pdf、doc/docx 和 xml。只需将应用程序指向包含文件的文件夹,它就会在几秒钟内将它们加载到库中。此外,您可以提供 YouTube 播放列表的网址,应用程序将加载播放列表中视频的转录,使您能够查询它们涵盖的内容。

Chat with RTX 技术演示是根据GitHub上提供的 TensorRT-LLM RAG 开发人员参考项目构建的。开发人员可以使用该参考来开发和部署自己的基于 RAG 的 RTX 应用程序,并由 TensorRT-LLM 加速。

https://github.com/NVIDIA/trt-llm-rag-windows

真正完全免费! 100%本地离线运行的ChatGPT最佳替代,完全免费开源

可以导入各大开源的AI大模型,支持Windows 、Mac 和linux系统,可以随时随地,哪怕在没有网络的情况下,

都可以在我们电脑上跑AI大模型,他原理上用我们的电脑硬件提供算力,支持的硬件如下:

▪️ vidia GPUs (fast)

▪️ Apple M-series (fast)

▪️ Apple Intel

▪️ Linux Debian

▪️ Windows x64 cpu

通过可定制的 AI助手、全局热键和内联 AI 将工作效率提高 10 倍!

下载链接:【点击前往】

Github 开源:【链接直达】

AI 生成对口型视频(支持多语言):https://www.heygen.com/?sid=rewardful&via=jin

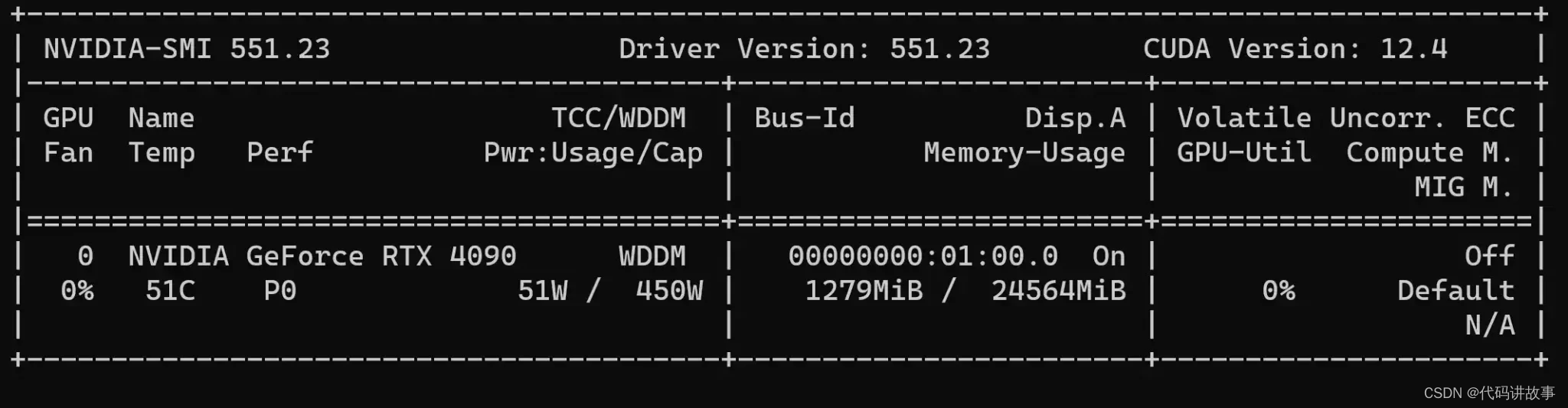

检查电脑是否安装 NVIDIA 驱动和CUDA

要进行验证,请打开 PowerShell 或终端并输入以下命令:

nvidia-smi

- 1

如果看到类似以下结果,则说明您已成功安装 NVIDIA 驱动程序:

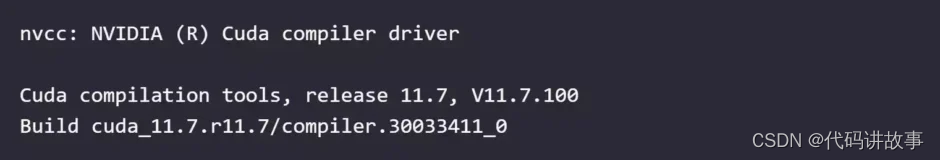

2.检查是否安装 CUDA

确保您已安装与 NVIDIA 驱动程序兼容的 CUDA 工具包。

要进行验证,请打开 PowerShell 或终端并输入以下命令:

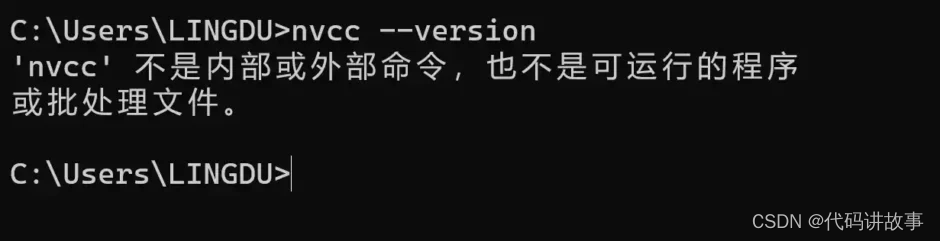

nvcc --version

- 1

如果看到类似以下结果,则说明您已成功安装 CUDA:

但是如果返回的信息是这样的:

那说明电脑上没有安装CUDA,或者没有配置到系统环境

1.CUDA 官方安装包:【点击下载】

2.添加 CUDA 到系统环境变量: 确保 CUDA 的安装目录已经添加到系统的环境变量中。你可以手动将 CUDA 的 bin 目录添加到 PATH 环境变量中。默认安装路径: CUDA 工具包通常默认安装在特定的目录中。在 Windows 上,默认路径一般是 C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA。