热门标签

热门文章

- 1【日常笔记】20230619——修改Linux镜像源_linux镜像源更改

- 2AI重复率怎么检测的?本科论文aigc检测率为多少?_aigc论文检测多少算正常

- 3数据结构----二叉树中序遍历_中序遍历例子

- 4【FPGA】:ip核--XADC_xadc ip核

- 5计算机网络谢希仁习题及解析百度云,计算机网络谢希仁(第七版)复习题(带答案)...

- 6C#知识|泛型集合List相关方法

- 7Python图形用户界面(GUI)编程:大解密_pythongui设计

- 8二叉树遍历之中序遍历算法(非递归、递归)入门详解_二叉树中序遍历

- 9CSDN获得积分和C币的方法_csdnc豆怎么获得

- 10自定义标签(带属性)_自定义标签老师热

当前位置: article > 正文

spacy的安装与使用_spacy安装

作者:很楠不爱3 | 2024-05-07 05:49:45

赞

踩

spacy安装

一、安装

下载spacy:conda install spacy

下载英文model:sm、md、lg分别表示三种大小的nlp模型,en_core_web_lg更精确,一般en_core_web_sm即可

conda install -c conda-forge spacy-model-en_core_web_sm

conda install -c conda-forge spacy-model-en_core_web_md

conda install -c conda-forge spacy-model-en_core_web_lg

- 1

- 2

- 3

各类spacy模型的网址:https://github.com/explosion/spacy-models/tags

官方文档:https://spacy.io/api/doc

二、使用教程

spacy的统计模型和处理管道是其核心内容。

统计模型使spacy能够执行一些nlp任务,如词性标记、命名实体识别、依存关系解析

导入模型:import spacy之后,执行spacy.load('model_name')导入模型

import spacy

nlp = spacy.load('en_core_web_sm')

- 1

- 2

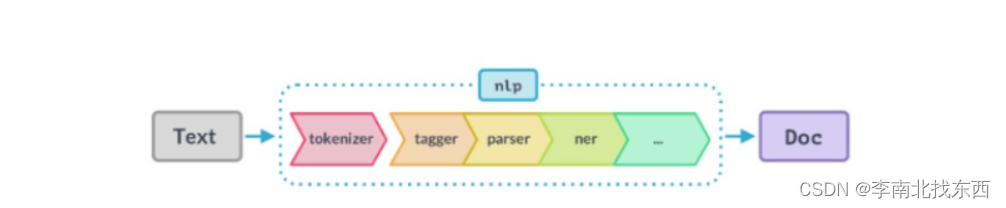

处理管道:使用spacy时第一步是将文本字符串传递给nlp对象,这个对象本质上是由几个文本预处理操作组成的管道(如标记生成器、标签器、解析器、ner等)

import spacy

nlp = spacy.load('en_core_web_sm')

# 创建nlp对象

doc = nlp("he want to be alone")

# 输出活动的管道组件

print(nlp.pipe_names)

# 禁用部分管道组件

# 当只需要标记文本时,可禁用整个管道,此时标记化过程会变得非常快

nlp.disable_pipes('tagger','parser')

print(nlp.pipe_names)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

三 、使用spacy执行各种nlp任务

3.1、词性标注

自动将词性标注分配给句子中所有单词,该任务有助于nlp的各种下游任务(如特征工程、语言理解、信息提取等)

doc2 = nlp("when that comes, all the things will be solved.")

# 遍历token,输出每个token的pos标记,

# 若不明白标记的含义,可使用spacy.explain("PART")来确定

for token in doc2:

print(token.text,"--->",token.pos_)

- 1

- 2

- 3

- 4

- 5

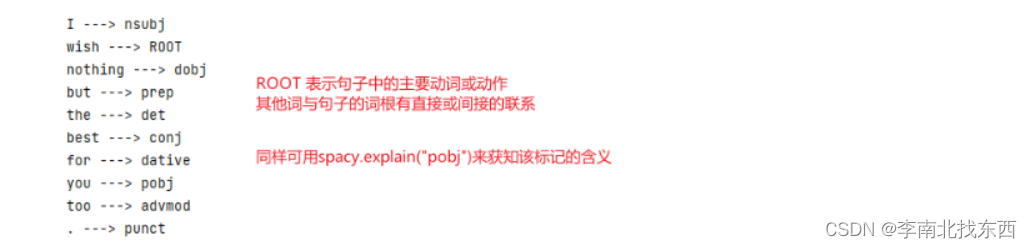

3.2、依存分析

通过依存句法分析提取出句子的语法结构,也可看做是一个有向图,图中的节点对应于句子中的单词,图中的边对应于单词间的对应依赖关系

doc3 = nlp("I wish nothing but the best for you too.")

for token in doc3:

print(token.text,"--->",token.dep_)

- 1

- 2

- 3

3.3、命名实体识别

实体是表示诸如个人、地点、组织等常见事物的信息的词或词组,即具有专有名称

doc4 = nlp("Indians spent over $71 billion on clothes in 2018")

for ent in doc4.ents:

print(ent.text, ent.label_)

- 1

- 2

- 3

3.4、基于规则的spacy匹配

使用spacy匹配器,可以以用户定义的规则在文本中匹配到单词或短语

- 类似于正则表达式,正则表达式使用文本模式来查找单词和短语,

- spacy匹配器不仅使用文本模式还使用单词的词汇属性(如pos标记、依赖标记、词根等)

# 4. 基于规则的spacy匹配 from spacy.matcher import Matcher #用spaCy词汇表初始化Matcher对象 matcher = Matcher(nlp.vocab) # 向nlp对象传递输入文本内容 doc4 = nlp("HELLO WORLD on Google Maps.") # 定义内容提取规则 patterns = [ [{"LOWER": "hello"}, {"LOWER": "world"}], [{"ORTH": "Google"}, {"ORTH": "Maps"}] ] # 定义打印函数 def on_match(matcher, doc, id, matches): print('Matched!', matches) #输出:[匹配ID,匹配标记的起始位置,结束位置] for match_id, start, end in matches: # 获得匹配的宽度 matched_span = doc4[start:end] print(matched_span.text) # 将规则、函数添加到matcher对象 matcher.add("TEST_PATTERNS", patterns, on_match=on_match) # 用自定义的提取规则提取文本 matches = matcher(doc4)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

matcher.add(match_id, patterns[, on_match] [, greedy])

向匹配器添加一条规则,以对匹配项进行操作

# 5. spaCy matcher的另一个用例

doc51 = nlp("You read this book")

doc52 = nlp("I will book my ticket")

matcher2 = Matcher(nlp.vocab)

pattern = [{'TEXT': 'book', 'POS': 'NOUN'}]

matcher2.add('rule_2', [pattern])

matches1 = matcher2(doc51)

matches2 = matcher2(doc52)

print(matches1)

print(matches2)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/很楠不爱3/article/detail/547672

推荐阅读

相关标签