- 1【PAT乙级】1012 数字分类

- 2ET前端重点类梳理_yooasset

- 3某赛通电子文档安全管理系统 44处 反序列化RCE漏洞复现

- 4Idea配置Maven并添加阿里源详解(2020)_maven setting 增加阿里

- 5matlab实现三自由度机械臂旋转_设计一个带旋转抓取功能的机械臂,该机械臂至少具备三个自由度,动力源为步进电机

- 6记录使用Echarts-gl实现3D地图

- 7开源鸿蒙南向嵌入学习笔记——NAPI框架学习(一)_鸿蒙 napi

- 8react渲染流程是怎样的

- 9【必读】从MII到RGMII,一文了解以太网PHY芯片不同传输接口信号时序!_以太网驱动通信时序

- 10一文了解网络地址转换(NAT)_目的nat

2019_8_30 sklearn-数据预处理_鸢尾花数据归一化

赞

踩

先看一个例子

识别 Iris(鸢尾花)类别

鸢尾花识别是一个经典的机器学习分类问题,它的数据样本中包括了4个特征变量,1个类别变量,样本总数为150。

它的目标是为了根据花萼长度(sepal length)、花萼宽度(sepal width)、花瓣长度(petal length)、花瓣宽度(petal width)这四个特征来识别出鸢尾花属于山鸢尾(iris-setosa)、变色鸢尾(iris-versicolor)和维吉尼亚鸢尾(iris-virginica)中的哪一种。

from sklearn import datasets # 加载鸢尾花数据 iris = datasets.load_iris() # 查看特征名称 print("feature_names: {0}".format(iris.feature_names))# 查看目标标签名称 print("target_names: {0}".format(iris.target_names)) # 查看元数据(特征矩阵)形状 print("data shape: {0}".format(iris.data.shape))# 查看元数据(特征矩阵)前五条 print("data top 5:\n {0}".format(iris.data[: 5]))# 查看目标标签的类别标识 print("target unique: {0}".format(np.unique(iris.target))) print("target top 5:\n {0}".format(iris.target[: 5])) 输出: feature_names: ['sepal length (cm)', 'sepal width (cm)', 'petal length (cm)', 'petal width (cm)'] target_names: ['setosa' 'versicolor' 'virginica'] data shape: (150, 4) data top 5: [[ 5.1 3.5 1.4 0.2] [ 4.9 3. 1.4 0.2] [ 4.7 3.2 1.3 0.2] [ 4.6 3.1 1.5 0.2] [ 5. 3.6 1.4 0.2]] target unique: [0 1 2] target top 5: [0 0 0 0 0]

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

数据预处理:

首先介绍一下:

fit

用于计算训练数据的均值和方差,后面就会用均值和方差来转换训练数据

fit_transform

不仅计算训练数据的均值和方差,还会基于计算出来的均值和方差来转换训练数据,从而把数据转化成标准的正态分布。eg: MinMaxScaler().fit_transform(x)

transform

很显然,它只是进行转换,只是把训练数据转换成标准的正态分布。(一般会把train和test集放在一起做标准化,或者在train集上做标准化后,用同样的标准化器去标准化test集,此时可以使用scaler)。

- 1

- 2

- 3

- 4

- 5

- 6

1.数据标准化:StandardScaler计算训练集的平均值和标准差,以便测试数据及使用相同的变换。

scaler = preprocessing.StandardScaler().fit(X)

这一步可以计算得到scaler,scaler里面存的有计算出来的均值和方差

scaler.transform(X)

这一步再用scaler中的均值和方差来转换X,使X标准化。

- 1

- 2

- 3

- 4

最后,在预测的时候,也要对数据做同样的标准化处理,即也要用上面的scaler中的均值和方差来对预测时候的特征进行标准化。

注意:测试数据和预测数据的标准化的方式要和训练数据标准化的方式一样,必须使用同一个scaler来进行transform。

也叫做Z-score标准化。这种方法基于原始数据的均值mean和标准差standard deviation进行数据的标准化。将特征A的原始值x使用z-score标准化到x’。z-score标准化方法适用于特征A的最大值和最小值未知的情况,或有超出取值范围的离群数据的情况。将数据按其特征(按列进行)减去其均值,然后除以其方差。最后得到的结果是,对每个特征/每列来说所有数据都聚集在0附近,方差值为1。

2.最小-最大规范化Min-Max标准化

最小最大规范化对原始数据进行线性变换,变换到[0,1]区间(也可以是其他固定最小最大值的区间)。

#2. 将每个特征值归一化到一个固定范围

scaler = preprocessing.MinMaxScaler(feature_range=(0, 1)).fit(train_data)

scaler.transform(train_data)

scaler.transform(test_data)

#feature_range: 定义归一化范围,注用()括起来

- 1

- 2

- 3

- 4

- 5

3.MaxAbs标准化

MaxAbs的工作原理与Min-max非常相似,但是它只通过除以每个特征的最大值将训练数据特征缩放至 [-1, 1] 范围内,这就意味着,训练数据应该是已经零中心化或者是稀疏数据。公式如下:

X_train = np.array([[ 1., -1., 2.],

[ 2., 0., 0.],

[ 0., 1., -1.]])

max_abs_scaler = preprocessing.MaxAbsScaler()

X_train_maxabs = max_abs_scaler.fit_transform(X_train)

>>> X_train_maxabs

array([[ 0.5, -1. , 1. ],

[ 1. , 0. , 0. ],

[ 0. , 1. , -0.5]])

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

4.正则化(归一化)

当你想要计算两个样本的相似度时必不可少的一个操作,就是正则化。其思想是:首先求出样本的p范数,然后该样本的所有元素都要除以该范数,这样最终使得每个样本的范数都是1。规范化(Normalization)是将不同变化范围的值映射到相同的固定范围,常见的是[0,1],也称为归一化。

归一化是缩放单个样本以具有单位范数的过程。归一化实质是一种线性变换,线性变换有很多良好的性质,这些性质决定了对数据改变后不会造成“失效”,反而能提高数据的表现,这些性质是归一化的前提。归一化能够加快模型训练速度,统一特征量纲,避免数值太大。值得注意的是,归一化是对每一个样本做转换,所以是对数据的每一行进行变换。而之前我们讲过的方法是对数据的每一列做变换。

归一化分为好几种范式,由norm指定如L2范式

>>> X = [[ 1., -1., 2.],

... [ 2., 0., 0.],

... [ 0., 1., -1.]]

>>> X_normalized = preprocessing.normalize(X, norm='l2')

>>> X_normalized

array([[ 0.40..., -0.40..., 0.81...],

[ 1. ..., 0. ..., 0. ...],

[ 0. ..., 0.70..., -0.70...]])

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

这就是L2 norm,变换后每个样本的各维特征的平方和为1.类似的,L1 norm则是变换后每个样本的各维特征的绝对值之和为1.还有max norm,则是将每个样本的各维特征除以该样本各维特征的最大值,

在度量样本之间相似性时,如果使用的是二次型kernel,则需要做Normalization。

5.非线性转化----映射到均匀分布

6.非线性变化----映射到高斯分布

7.one-hot编码

one-hot编码是一种对离散特征值的编码方式,在LR模型中常用到,用于给线性模型增加非线性能力。

data = [[0, 0, 3], [1, 1, 0], [0, 2, 1], [1, 0, 2]]

encoder = preprocessing.OneHotEncoder().fit(data)

enc.transform(data).toarray()

- 1

- 2

- 3

8.多项式特征

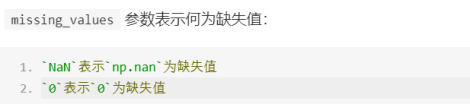

估算缺失值