热门标签

热门文章

- 1YOLOv5源码逐行超详细注释与解读(2)——推理部分detect.py_class-agnostic nms

- 2【Spark编程基础】实验二Spark和Hadoop的安装(附源代码)

- 3ChatGPT在自然语言处理中的应用案例

- 4【GoEnhance AI】高质量视频转动画,无卡顿——登录和使用:详细指南!

- 5python内存地址和编译字节码_python 字节码中含有内存地址

- 6中间件的分类_操作系统数据库中间件归位哪一类

- 7NLP:spacy库安装与zh_core_web_sm配置

- 8NLP-了解BERT下游任务_nlp下游任务

- 9AIGC: 关于ChatGPT中token和tiktoken工具_tiktoken是openai开发的开源的快速token切分器

- 10(JAVA)02——面向对象编程(上)_java伪代码面向对象

当前位置: article > 正文

Stable diffusion(四)

作者:我家小花儿 | 2024-03-25 23:00:13

赞

踩

Stable diffusion(四)

训练自己的Lora

【DataSet】【Lora trainer】【SD Lora trainer】

前置的知识

- batch size:模型一次性处理几张图片。一次性多处理图片,模型能够综合捕捉多张图片的特征,最终的成品效果可能会好。但是处理多个batch size也意味着更大的显存。同时batch size和Step的关系也是相反的。多batch size意味着每张图片能分到的step变小了。

- Epoch轮数。重复训练几轮的意思。

- Step:步数。 Step = 图片数量 * 重复次数(repeat) * 轮数(epoch) ÷ batch size。距离,假设你有50张图片,每张图片的repeat设置为10次,训练10个epoch。那么 Step = 50 * 10 * 10 ÷ 2= 2500步。

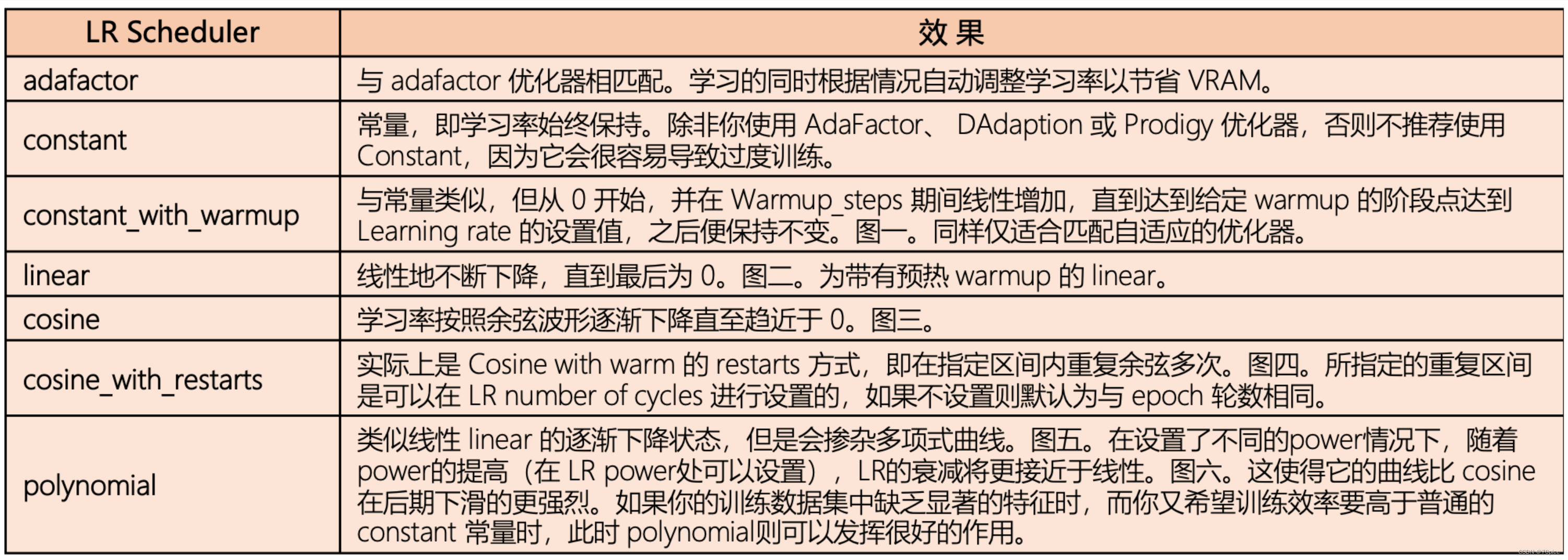

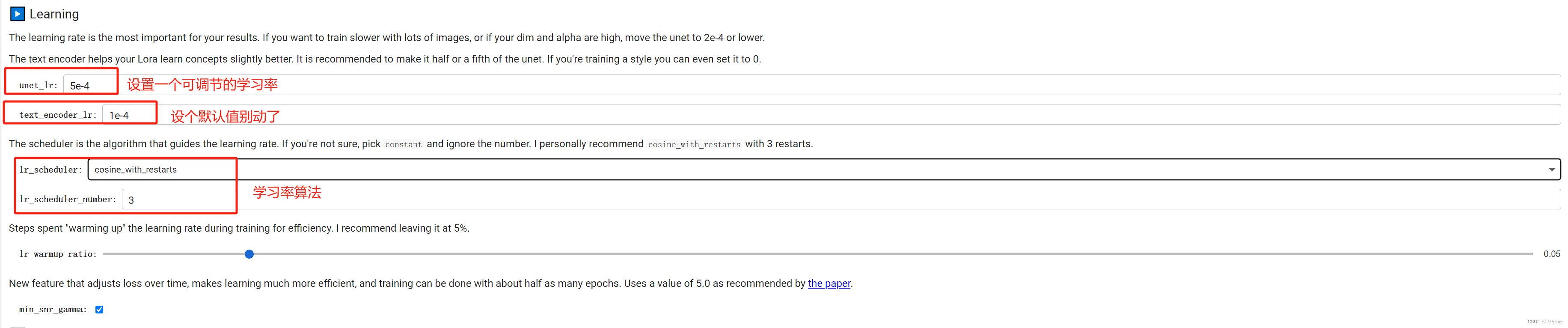

- Learning rate:学习率就代表着收敛的速度。我建议是可变的学习率,前面几个step大点,后面几个step小点。常见的学习率调整算法

- Learning rate scheduler:

- Optimizer:优化器,这个后面进阶再去了解

- network alpho:缩放因子防止模型过拟合

- network dim :模型的层数 network alpho推荐设置为 netwrok dim的一半。

- Lora的选型

- warnup:warmup是针对学习率learning rate优化的一种策略,主要过程是,在预热期间,学习率从0线性(也可非线性)增加到优化器中的初始预设lr,之后使其学习率从优化器中的初始lr线性降低到0

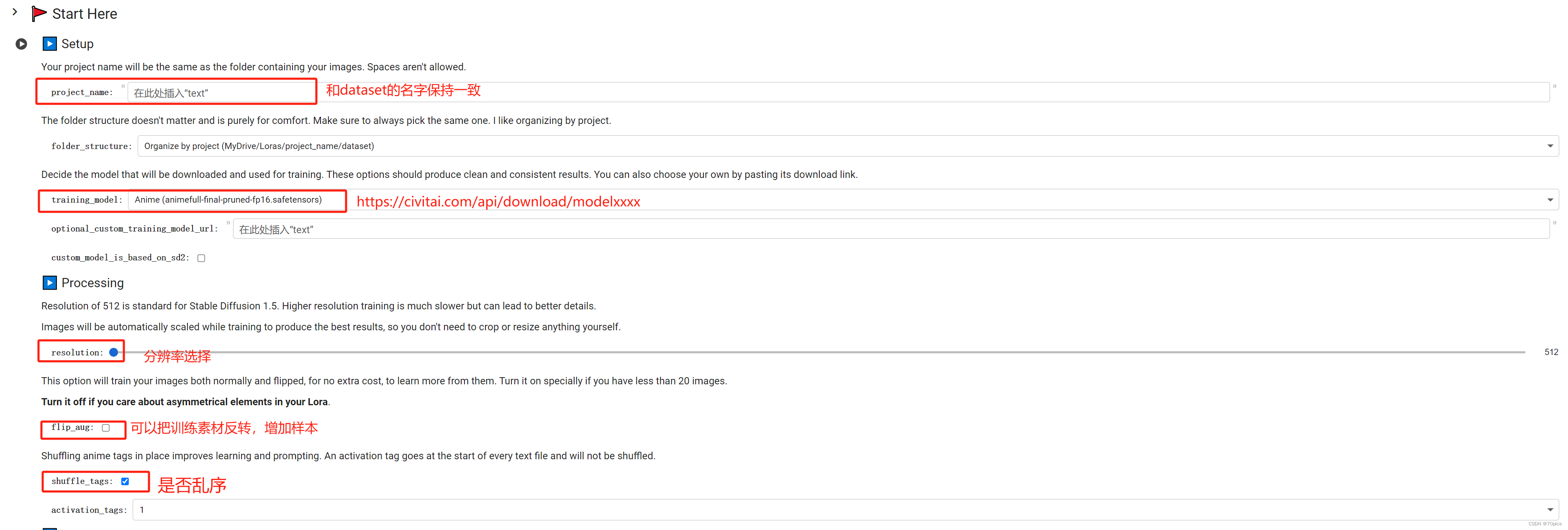

界面介绍

如何完成自己的DataSet

因为自己练出的Lora实在太丑,愤而不写了。不如用别人的

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家小花儿/article/detail/312960

推荐阅读

相关标签