热门标签

热门文章

- 1Manticore Search 中文分词搜索入门

- 2计算机毕业设计(附源码)python新冠疫苗接种在线预约管理系统_约苗公众号预约代码

- 3知识图谱1-序列标注:BiLSTM-CRF模型做基于字的中文命名实体识别_bilstm-crf 分词

- 4OpenCV颜色识别_opencv检测相近色彩区域的方法

- 5自动化开启安全运营新趋势|基于麒麟操作系统的奇安信SOAR解决方案_麒麟操作 奇安信

- 6(学习笔记)OoDAnalyzer: Interactive Analysis of Out-of-Distribution Samples_ood sample

- 7智能合约,批量转账 ERC20Transfer_erc20批量转币abi

- 87款最好用的AI视频剪辑工具_智能科技公司用电脑处理图片视频可以吗

- 9[论文阅读笔记64]A Unified Generative Framework for Various NER Subtasks

- 10利用Tensorflow进行自然语言处理(NLP)系列之一Word2Vec

当前位置: article > 正文

NLP-transformer部分知识点

作者:我家小花儿 | 2024-04-03 00:03:13

赞

踩

NLP-transformer部分知识点

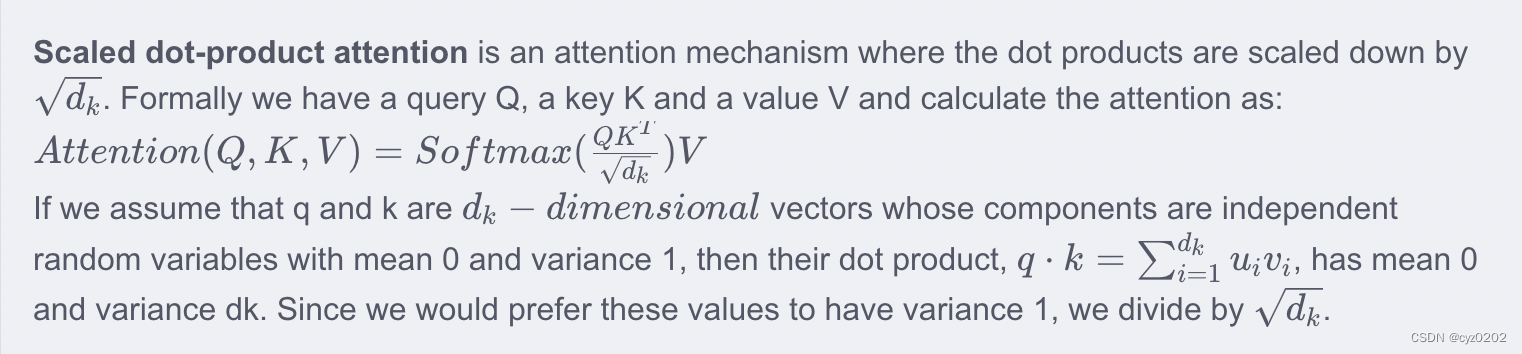

1. Scaled Dot-Product Attention中为什么要除以

- 计算公式:

- 在softmax中起到temperature的作用,即使分布趋于平滑,增加可能性

- 为什么是

而不是 3、4、5等 随便一个数。。。

-

解释一下上述引用内容

2. transformer encoder对单词进行embedding时,为什么乘以(来自知乎)

- 假设embedding table是用 Xavier初始化,即

- 从onehot -> embedding,相当于从上述总体分布采样了

个样本,合起来称为该总体的一组子样本;

- 记某组子样本(

维)的均值、样本方差分别为

、

,可得

- 所以

,乘以

以达到统一的标准正态分布的目的(知乎@王四喜)

- 那么为什么不直接用

进行初始化?

- 知乎@Towser解释:因为transformer中可以设置tied-embedding的存在(减少参数),此时 比如 decoder最后输出softmax前,需要做一次线性映射(Linear)到词汇空间,linear的weight即来自于embedding的weight;线性层需要用到Xavier初始化,因此embedding层也就先用Xavier初始化,再缩放回来;

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家小花儿/article/detail/354109?site

推荐阅读

相关标签