- 1MySQL数据表range分区例子

- 2Python + SQLAlchemy操作MySQL数据库(ORM)_python sqlalchemy mysql

- 3使用Token方式实现用户身份鉴权认证_token发起权限认证请求

- 4Unity实现Angry Bird弹弓发射功能_unity prevvelocity

- 5以太坊中的重要概念_以太坊的叔侄区块奖励

- 6普通人如何搭上AIGC行业快车道?近屿智能带你来看AI就业新趋势

- 7二分查找_设某个有序表中有8个元素,使用二分法查找到其中某一个元素需多少次?

- 8华为OD机试 - 批量处理任务 - 二分查找(Java 2024 C卷 200分)_批量处理任务 华为od

- 9一文理解单片机BootLoader的前世今生(万字长文,配33张高清图)

- 10socket原理详解_消息队列和socket区别

微软深夜拯救“打工人”:自定义Copilot、多模态小模型出奇招,Altman“闪现”剧透新模型

赞

踩

整理 | 屠敏

出品 | CSDN(ID:CSDNnews)

这边国内 AI 大模型疯狂地打起了「价格战」,那边国外用 AI 模型和生产力较起了劲,甚至“内卷”得可怕。

这不,昨天凌晨,微软刚召开一场发布会,提前推出搭载高通 Snapdragon X Elite 和 X Plus 的全新 AI PC 品牌 Copilot+PC,不仅与苹果 M3 MacBook Air 在性能上进行了正面较量,还展示了新芯片的 NPU 具备每秒 45 万亿次运算(TOPS)的能力,解锁了一系列新的 Copilot 功能。

仅在一天后,北京时间 5 月 22 日凌晨 12 点,微软又正式拉开了 Build 2024 的帷幕。这一场专属开发者的盛会,在微软 CEO 萨蒂亚·纳德拉(Staya Nadella)、微软体验+设备执行副总裁 Rajesh Jha、微软人工智能执行副总裁兼首席技术官 Kevin Scott 等高管主导下,势要掀起 AI 生产力的革命。

在发布会的最后,出乎意料的是,最近刚忙完 GPT-4o 以及深陷舆论漩涡的 OpenAI CEO 奥特曼也出现在了现场,还小小地剧透了一下新模型的方向。

微软正在让 Copilot 变得无处不在

「感觉我们好像回到了 30 年前第一次讨论 Win 32 的时刻,如今 AI 正在重塑“技术堆栈的每一层”」,微软 CEO 纳德拉于大会伊始如是说道。

他表示,微软几十年来有两个梦想:

-

计算机能否理解我们,而不是我们必须理解计算机?

-

在一个信息不断增加的世界中,计算机能否帮助我们根据所有这些信息更有效地进行推理、计划和行动?

对此,纳德拉将这波 AI 浪潮定位为微软梦想的答案。站在 AI 新时代的风口,微软已经构建了三个平台:

-

Microsoft Copilot,作为 AI 日常伴侣,使得专业知识触手可及;

-

Copilot+PC,有史以来最快的 AI PC;

-

Copilot Stack,方便开发者可以构建 AI 应用程序、解决方案和体验。

而这场 Build 2024 也主要围绕这三个平台展开。

为 Windows 下一个十年设定方向的 Copilot+PC

微软 Windows、设备部门副总裁 Pavan Davuluri 表示,Copilot+PC 正在“重新定义你可以在 PC 上执行的操作,并为 Windows 下一个十年设定方向。”关于新一代 Copilot+PC,可详见 CSDN 昨日报道。

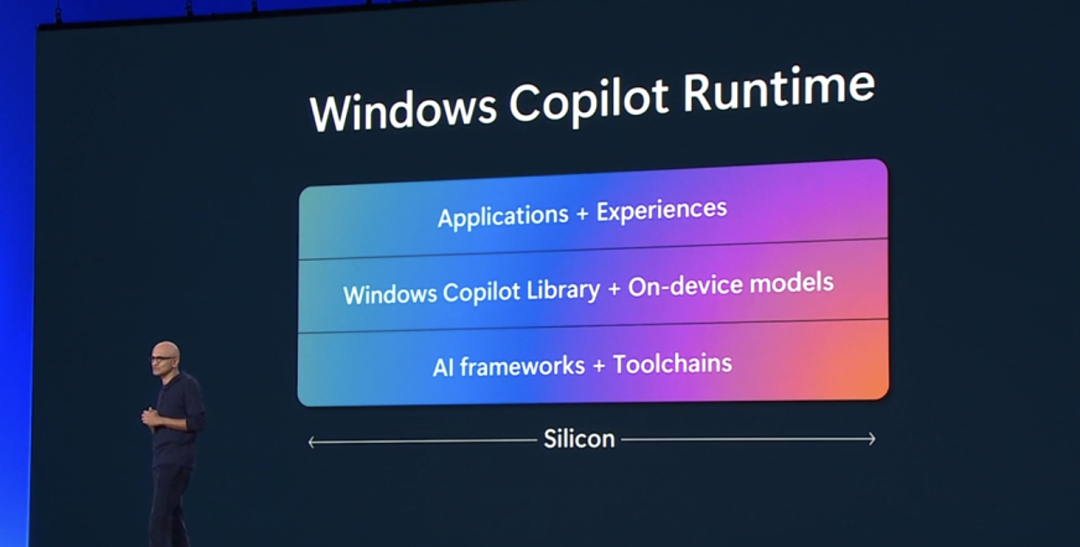

今天,基于最新发布的 Copilot+PC,微软推出了 Windows Copilot Runtime,纳德拉声称这将“使 Windows 成为人们构建人工智能应用程序的最佳平台”。

简单来看,Windows Copilot Runtime 将 Copilot 堆栈拓展到 Windows 系统,它也是 Windows 11 系统的全新组成部分。

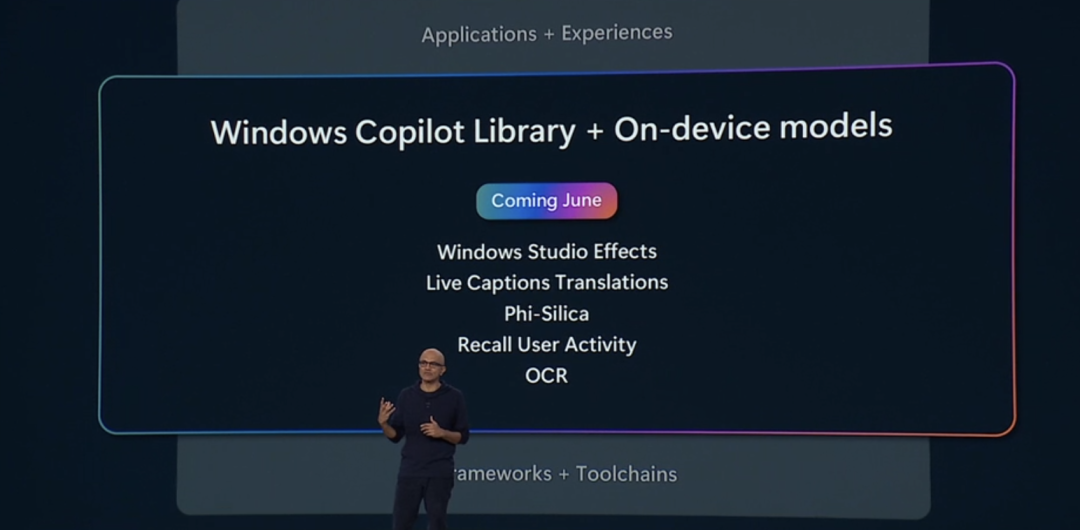

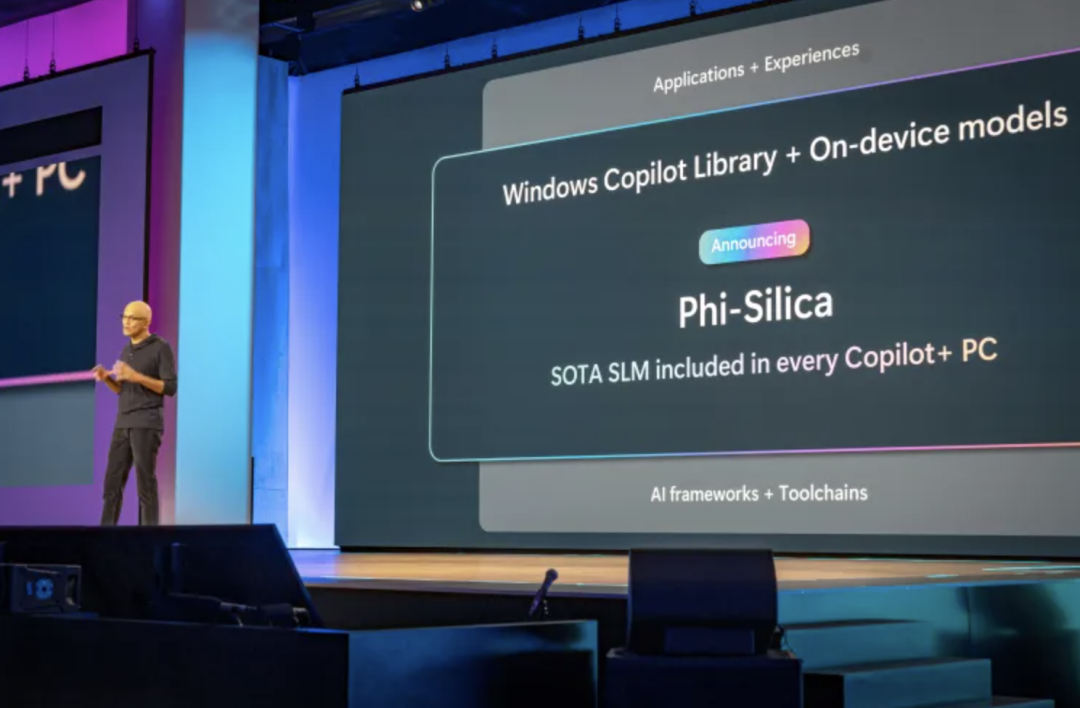

该运行时包含了 Windows Copilot 库以及可以随时可用的本地 API,它为开发者提供了现在可以访问的一系列语言模型,做到至少 40 种语言模型“开箱即用”。当然这 40 款模型中也覆盖了在这次大会上微软最新发布的 SLM(小模型)Phi-Silica,可在 Copilot+ PC 的 NPU 上运行,为设备带来更快的推理等 AI 体验。

据悉,Phi-Silica 是一个 33 亿个参数的模型,这也使其成为 Phi 系列 AI 模型中最小的一个。

该库还允许你将 RAG(检索增强生成)纳入设备应用程序,来处理设备上的数据。

得益于该运行时,Copilot+ PC 可在设备上通过 Windows Direct ML 原生支持 PyTorch 和 Web 神经网络,这将为开发人员提供更多可用的工具。

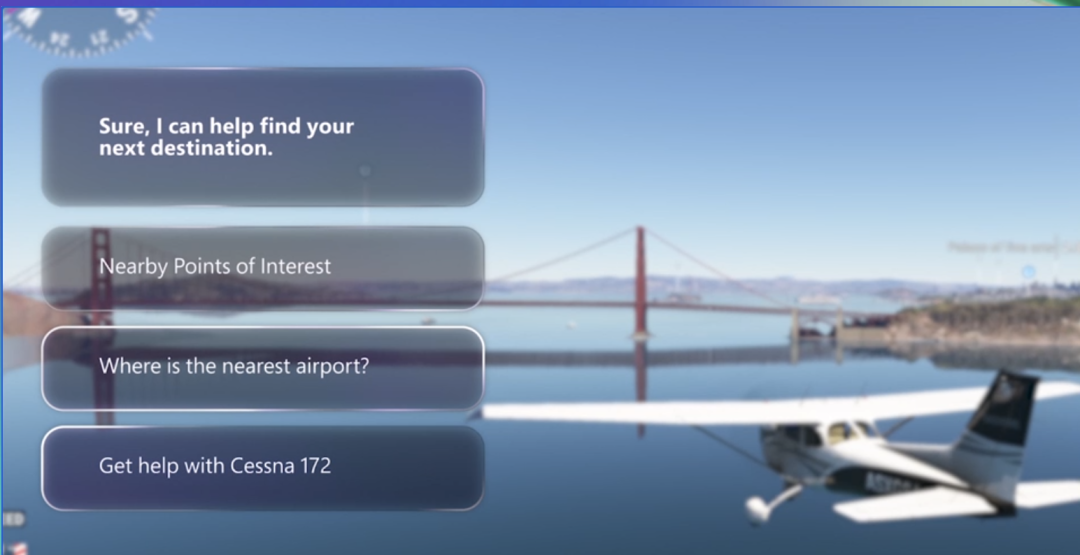

展望未来,微软表示,该运行时也会被 Xbox 团队运用来为玩家和游戏开发人员提供支持。在官方展示的游戏示例中,我们看到有人向 Copilot 询问如何完成游戏中任务的视频,人工智能代理提供了帮助。

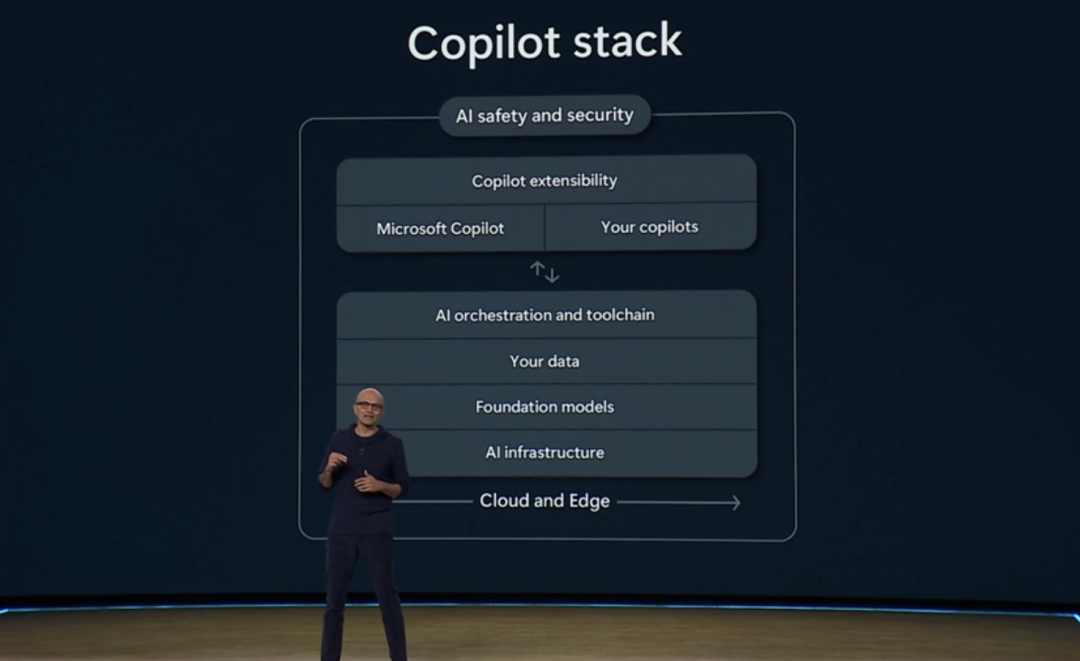

Copilot Stack

作为一家平台公司,纳德拉表示,微软的目标是构建最完整的端到端堆栈,从基础设施到基础模型、数据再到工具、应用程序可扩展性,这样开发者就可以应用这些强大功能来构建自己的应用程序。

在这次发布会上,微软也从下往上详细分享了 Copilot 的技术栈。

基础设施

首先,在技术栈最底层的基础设施层面,纳德拉表示,微软拥有“世界上最全面的人工智能基础设施”。从数据上来看,Azure 数据中心在全球 60 多个地区提供,微软希望提供云服务的可持续性。

微软与英伟达合作,这家图形芯片公司是微软人工智能计划的核心。纳德拉透露,微软将成为首批提供 Nvidia 最新 Blackwell AI 芯片的云提供商之一,公司“与英伟达有着深厚的合作伙伴关系”。

此外,AMD 的 ND MI300X V5 芯片也将针对 Microsoft Azure 工作负载进行优化。

基础模型层:Phi-3 系列中首个多模态小模型 Phi-3-vision 来了

再往上一层的基础模型方面,“通过 Azure AI,我们提供最广泛的前沿和开源模型选择,包括 LLM 和 SLM,”纳德拉说,「超过 50,000 个组织使用 Azure AI,甚至 GPT-4o 也在 Azure 上进行了训练」。

目前,OpenAI 的最新旗舰模型 GPT-4o 现已在 Azure OpenAI 服务中全面推出。这一开创性的多模态模型在单一模型中集成了文本、图像和音频处理功能,为生成式人工智能和对话式人工智能体验树立了新的标准。GPT-4o 的定价为输入 5 美元/100 万个 token,输出 15 美元/100 万个 token。

本月早些时候,微软通过 Azure OpenAI 服务启用了带有视觉功能的 GPT-4 Turbo。利用这些新模型,开发人员可以构建具有跨文本、图像等输入和输出的应用程序,从而获得更丰富的用户体验。

同时,Azure AI 也支持多款新模型,如 Core42 JAIS、Nixtla TimeGEN-1,未来还将支持 Bria AI、Gretel、NTT DATA、Stability AI 等多款模型。

一直以来,微软也是小模型的引领者。在发布会上,微软发布了自家开发的 AI 小模型 Phi-3 系列中的 Phi-3-small、Phi-3-medium 和 Phi-3-vision(一种全新的多模态模型,https://huggingface.co/microsoft/Phi-3-vision-128k-instruct)。

Phi-3 模型是目前能力最强、性价比最高的小型语言模型 (SLM),在各种语言、推理、编码和数学基准测试中均优于相同大小和更大的模型。这些模型使用高质量的训练数据进行训练,Phi-3 模型的推出扩大了 Azure 客户对高质量模型的选择范围,为他们组成和构建生成式人工智能应用提供了更多实用的选择。

加上这次最新发布的,如今 Phi-3 模型系列共有四个模型:

-

Phi-3-vision 是一个 4.2B 参数的多模态模型,具有语言和视觉功能。

-

Phi-3-mini 是一个 3.8B 参数的语言模型,有两种上下文长度(128K 和 4K)。

-

Phi-3-small 是一个 7B 参数的语言模型,有两种上下文长度(128K 和 8K)。

-

Phi-3-medium 是 14B 参数语言模型,有两种上下文长度(128K 和 4K)。

其中,其中 Phi-3-vision 是 Phi-3 系列中的第一个多模态模型,它将文本和图像结合在一起,并具有对现实世界图像进行推理以及从图像中提取和推理文本的能力。它还针对图表和图表理解进行了优化,可用于生成见解和回答问题。Phi-3-vision 以 Phi-3-mini 的语言功能为基础,继续在小型模型中提供强大的语言和图像推理质量。

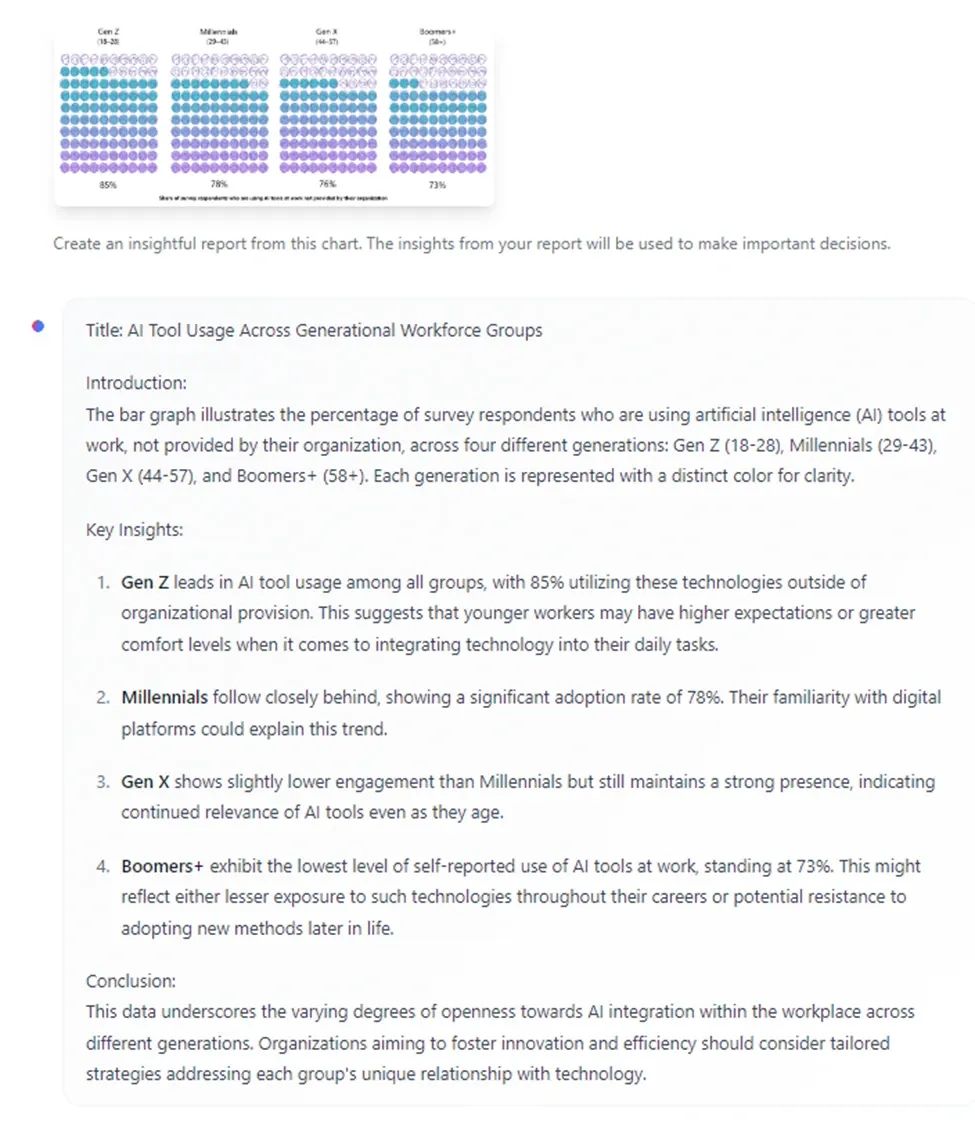

Phi-3-vision 可以从图表中生成见解:

这对经常需要分析数据的“打工人”而言,无疑是一个好消息。

除了新模型外,微软还在 API 中添加了新功能,以实现多模态体验。Azure AI Speech 在预览版中增加了多项新功能,包括语音分析和视频翻译,从而帮助开发人员构建高质量的语音应用程序。Azure AI Search 现在的存储容量大幅增加,向量索引大小最多可增加 12 倍,而且无需额外费用,即可大规模运行 RAG 工作负载。

此外,微软还从今天开始向所有开发人员提供一个端到端的开发环境——Azure AI Studio,用于构建、训练和微调 AI 模型,现已全面推出。该专业代码平台支持负责任的生成式人工智能开发,包括开发开发者自己的定制 Copilot 应用程序。无缝开发方法包括友好的用户界面(UI)和代码优先功能,包括 Azure Developer CLI (AZD) 和 VS Code 的 AI Toolkit,使开发人员能够为自己的项目选择最方便的工作流程。

开发人员可以使用 Azure AI Studio 探索 AI 工具,协调多个互操作 API 和模型;正如上文所述,使用检索增强生成(RAG)技术,利用数据建立模型;测试和评估模型的性能和安全性;以及在生产中进行大规模部署和持续监控。

数据层

在数据层,为了训练、微调和建立模型,微软推出了其人工智能数据分析平台的核心 Microsoft Fabric。它是一款人工智能工具,旨在减轻开发人员和组织的工作量。随着 Fabric 新发布的实时智能功能,用户可以享受“关于流数据的即时可操作的见解”。

此外,微软通过 Azure Cosmos DB for NoSQL 为 Azure Cosmos DB 增加了向量搜索功能。Azure Cosmos DB 由功能强大的算法库 DiskANN 提供支持,这使得 Azure Cosmos DB 成为首个无需管理服务器即可在云规模下提供更低延迟向量搜索的云数据库。

与此同时,目前微软还推出 Azure AI 的 Azure Database for PostgreSQL 扩展、Azure SQL DB 中的 Microsoft Copilot 功能预览版。

工具链

再往技术栈上面一层就是工具链。今天,微软推出多款工具:

-

适用于 Azure 的 GitHub Copilot 预览版,扩展了 GitHub Copilot 以提高其对所有开发人员的实用性。

-

AI Toolkit for Visual Studio Code 也于今天开始出了预览版,它是一个扩展,提供开发工具和模型,帮助开发人员获取和运行模型、在本地微调模型以及部署到 Azure AI Studio,所有这些都来自 VS Code;

-

.NET Aspire 发布(https://learn.microsoft.com/zh-cn/dotnet/aspire/fundamentals/setup-tooling?tabs=windows&pivots=visual-studio),这款全新的云原生堆栈通过自动配置和集成弹性模式简化了开发过程。有了 .NET Aspire,你可以在使用首选工具的同时,更专注于编码,减少设置工作。此堆栈包括一个开发人员仪表板,可从一开始就增强可观察性和诊断性,从而实现更快、更可靠的应用程序开发。

-

此外,微软为提高了应用平台服务的易用性标准,推出了 Azure Kubernetes Services (AKS) Automatic(https://learn.microsoft.com/en-us/azure/aks/learn/quick-kubernetes-automatic-deploy?pivots=azure-portal),这是将人工智能应用投入生产的最简单的托管 Kubernetes 体验。作为开发人员,你现在可以访问 AKS Automatic,该平台可以在几分钟内从容器映像转移到已部署的应用程序,同时仍然让你能够访问 Kubernetes API。

安全

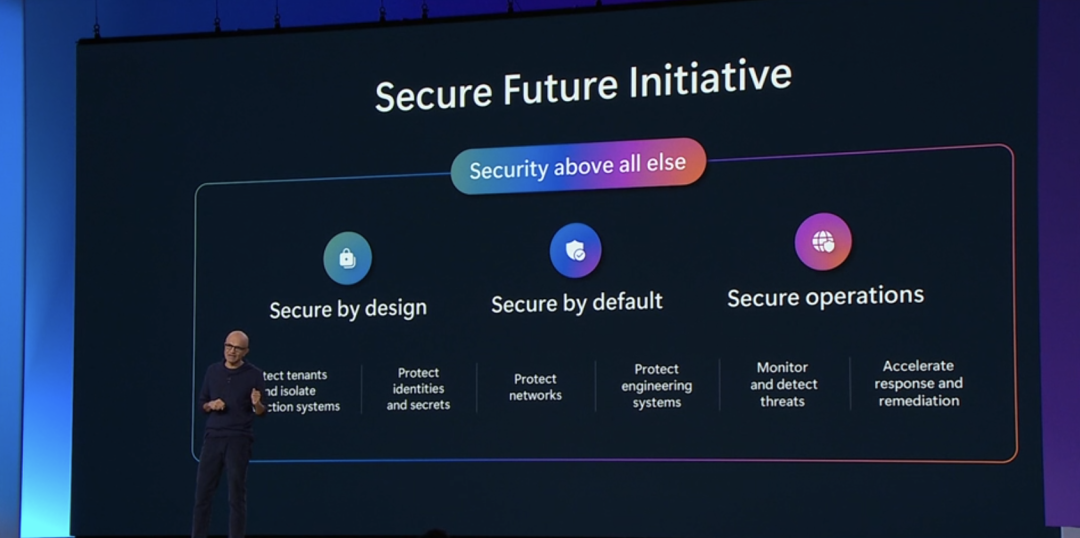

在安全维度,纳德拉表示,微软希望将“安全性置于一切之上”,这意味着其将在各种产品的“设计、默认设置和操作”等多个环节来确保人工智能的安全。

在 Build 2024 上,微软宣布内容安全方面添加了新功能,包括自定义类别、提示屏蔽和接地检测。同时,纳德拉宣布,Azure AI 自定义模型即将到来,可以让开发者能够基于自己所在的领域和数据训练一个独特的自定义模型,这些模型可以是专有的。

看 Copilot AI 如何提升生产力?

紧接着,微软体验部执行副总裁 Rajesh Jha 进一步详细地分享了 AI 技术栈引入微软产品的细节,让众人亲眼见证 Copilot 是如何提升生产力的。

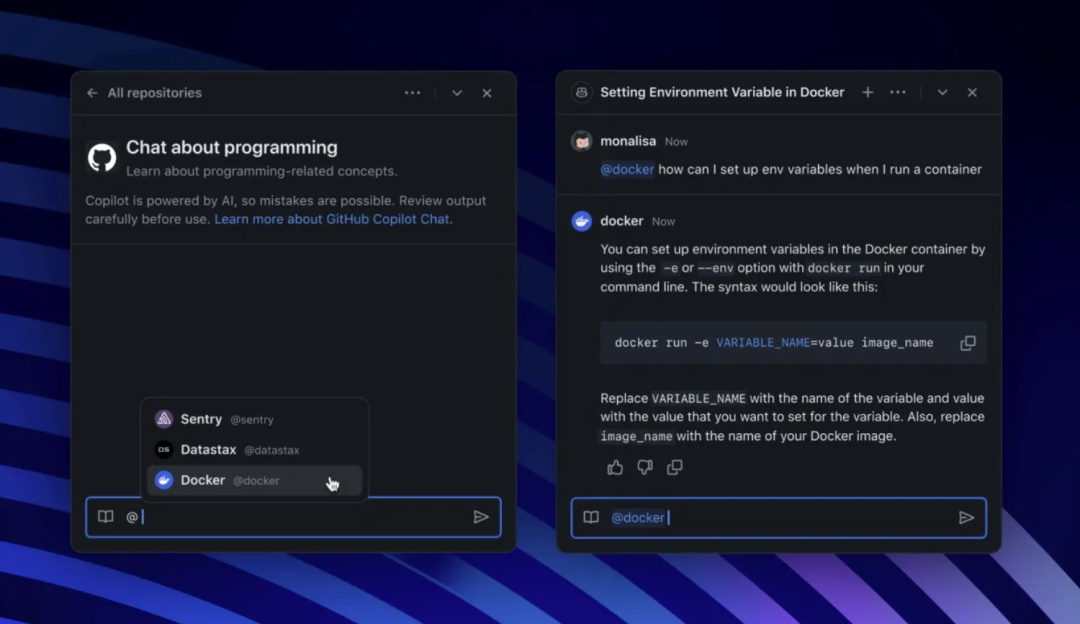

对于个人开发者而言,微软重磅宣布为 GitHub Copilot 推出 Copilot Extension。顾名思义,Copilot 扩展允许开发者使用第三方技能扩展 Copilot。

GitHub Copilot 支持各种各样的开发工具和平台,包括 DataStax、Docker、MongoDB、Octopus Deploy、Pangea、Pinecone、Product Science、ReadMe、Sentry 和 Stripe。

“我们的目标是:让 GitHub Copilot 成为最集成、最强大、最智能的人工智能平台,为加速人类进步提供无限可能”,GitHub 产品高级副总裁 Mario Rodriguez 表示,“用自然语言编程将继续降低任何想构建软件的人的入门门槛。今天,我们离 10 亿人可以利用 GitHub Copilot 更近一步,Copilot 作为一个智能平台,能与开发者技术栈中的任何工具集成,完全使用自然语言。”

这些扩展将存在于 GitHub Marketplace 中,但开发人员也可以创建自己的个人扩展以与其内部系统和 API 集成。

不过,截至目前,Copilot Extensions 处于内测阶段。

从个人过渡到团队,Copilot 将从三个维度深入,发挥更大作用:

-

Team Copilot:将 Copilot 的功能扩展到个人助理之外,代表团队工作,从而改善协作和项目管理。

-

Agent:自定义副驾驶使用户能够编排和自动化业务流程。

-

Copilot 扩展和 Copilot 连接器:可以轻松定制和扩展 Copilot 以满足独特的业务需求。

团队中有价值的新成员——Teams Copilot

Team Copilot 将 Copilot 从个人助理扩展为有价值的团队成员--与团队一起参与并做出贡献。当然,微软强调,人类始终可以掌控一切,只需要将任务或职责分配给 Copilot,让整个团队一起提高工作效率、协作性和创造力。

在 Microsoft Teams、Microsoft Loop、Microsoft Planner 等协作平台上都可以使用 Teams Copilot。

根据工作场景的不同,可以将 Teams Copilot 分配为不同角色,譬如:

-

会议主持人:Copilot 通过管理议程和记录会议中任何人都可以共同撰写的笔记,使会议讨论更有成效。

-

小组协作者:Copilot 可帮助每个人从聊天中获得更多信息,显示最重要的信息,跟踪行动项目,并解决未解决的问题。

-

项目经理:Copilot 可创建和分配任务,跟踪截止日期,并在需要团队成员提供意见时通知他们,从而确保每个项目顺利进行。

值得注意的是,这些功能将在 2024 年晚些时候以预览版的形式提供给拥有 Microsoft Copilot for Microsoft 365 许可证的用户。

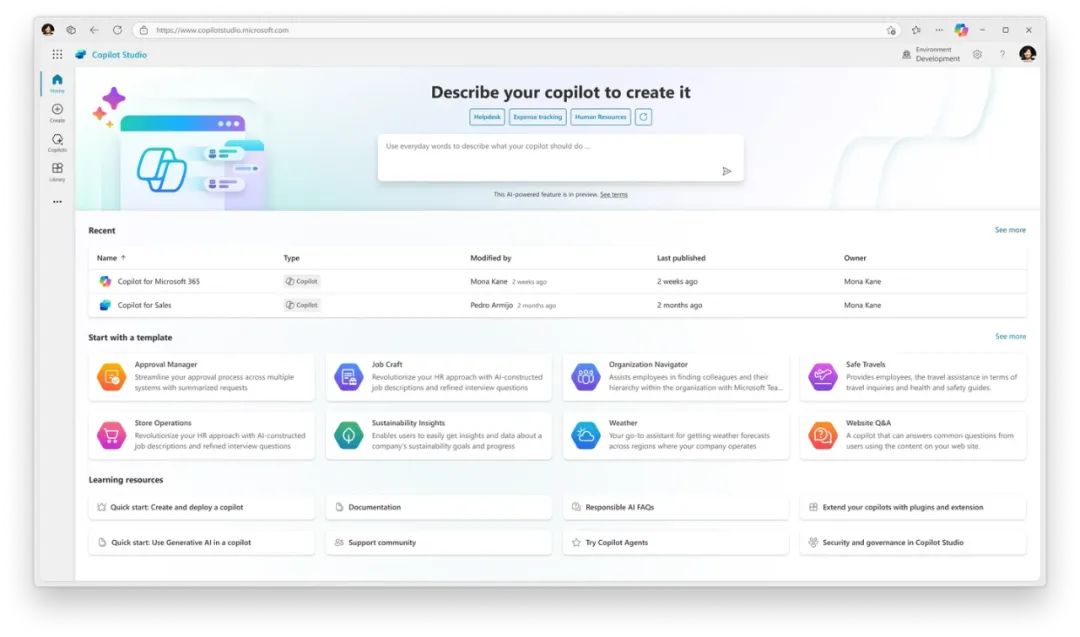

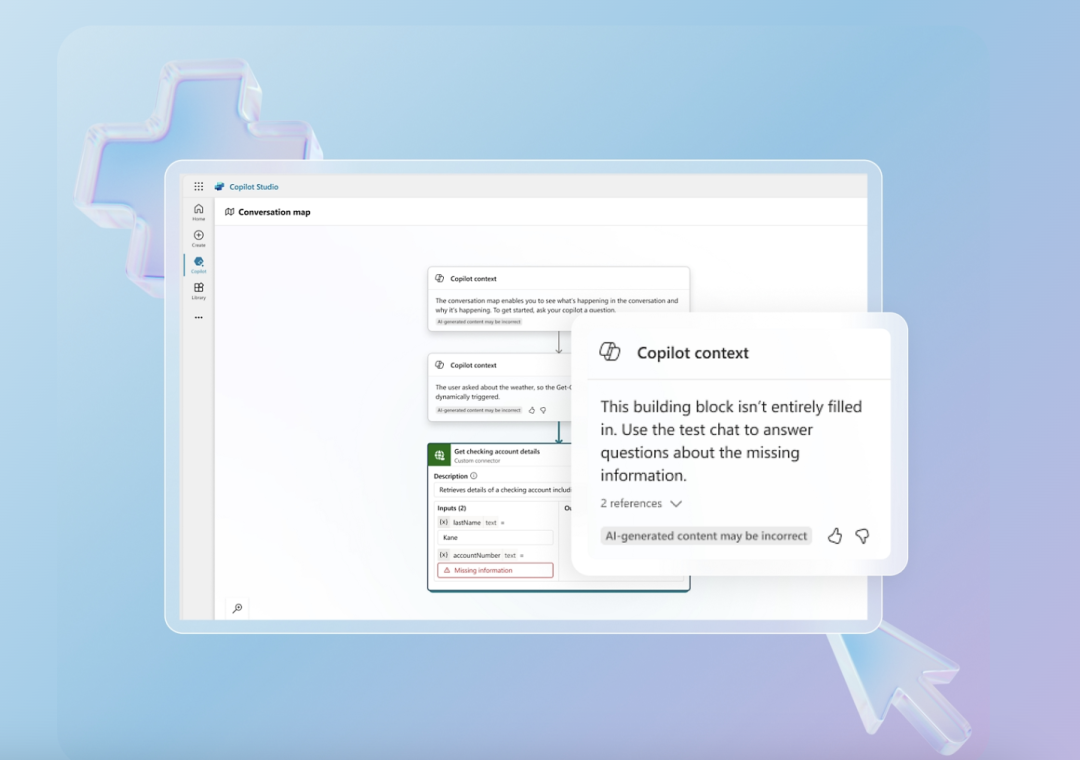

Agent:可实现业务流程自动化的新自定义 Copilot

微软在 Microsoft Copilot Studio 中发布新的功能,用于构建自定义的协作机器人,这些机器人可以作为 Agent 在人类的指导下独立工作,从而实现以下功能:

-

将长期运行的业务流程自动化。

-

对操作和用户输入进行推理。

-

利用记忆引入上下文。

-

根据用户反馈进行学习。

-

记录异常请求并寻求帮助。

微软表示,Copilot AI Agent 很快可以用作虚拟员工,企业可以用它来执行一些琐碎的任务,例如监控电子邮件、执行一系列自动化任务、帮助员工入职或进行数据输入,所有这些都无需提示。微软强调,新的 Copilot 功能不会取代工作——只会取代无聊的部分。

不过这些功能还处于起步阶段,微软希望能在 2024 年晚些时候实现更广泛的可用性。

此外,微软还开发了可以让开发者轻松创建以 SharePoint 和 OneDrive 数据为基础的自定义协同任务——你的组织知识就存在于这些数据中。

只需点击几下,从 SharePoint 创建的自定义 Copilot 就能帮助你的团队在几秒钟内从文件中获取所需的信息,并可使用 Copilot Studio 进一步编辑和增强。这一新功能目前在“早期访问计划”中提供,并将于 2024 年晚些时候推出预览版。

Copilot 扩展和连接器

通过新的 Copilot 扩展,任何人都能轻松定制 Copilot,并将 Copilot 扩展到他们的数据和业务系统。

开发人员可以使用 Copilot Studio 或 Teams Toolkit for Visual Studio 构建这些扩展。

同时,微软还在 Copilot Studio 中引入了 Copilot 连接器,使开发人员能够更轻松、更快速地创建 Copilot 扩展。

OpenAI CEO Sam Altman 惊喜亮相

让人有些意外的是,本次发布会的最后,OpenAI CEO Sam Altman 出现在了现场,与微软 AI 首席技术官兼执行副总裁 Kevin Scott 进行了一场简短的对话。

Sam Altman 上台表示,“开发者一直是过去一年半所发生的事情的核心部分,他们正在做的事情非常惊人。采用速度、人才以及弄清楚如何利用这一切来构建产品的速度都非常快。当我们在 API 中推出 GPT-3 时,有些人觉得它很酷,但应用范围很窄。然而,看看人们用 GPT-4 所做的事情,以及现在 GPT-4o 的应用情况,尽管它还很新,还没推出多久,但我从未见过一项技术在如此短的时间内以如此有意义的方式被如此迅速地采用。”

当被问及 OpenAI 未来 GPT 的开发前景时,Altman 认为,「新的模态和整体智能将是 OpenAI 下一个模型的关键...模型将变得更加智能」。同时,他指出了 GPT-3、GPT-3.5 和 GPT-4 之间的性能和功能差异,并表示这种进步在未来只会持续下去,提高速度和降低成本是公司的主要关注点。

在发布会上,Altman 也给出了自己对 AI 时代开发者的建议,「这是一个特殊的时期,所以要充分利用它,现在不是推迟计划或等待下一个机会的时候...现在是自 2008 年移动繁荣甚至互联网繁荣以来在初创公司工作的“最激动人心的时刻”。但不要指望人工智能会为你做所有的工作......人工智能本身就是一个新的推动者,但它不会自动打破商业规则」。