热门标签

热门文章

- 1CART-分类和回归树_cart算法是否购买计算机

- 2分布式锁简单入门以及三种实现方式介绍

- 3人工智能在音乐创作中的崛起与未来展望_音乐人工智能发展前景

- 4YOLOv 改进 GhostNet 主干系列:高效 GhostNet 网络改进,华为出品,全新检测器实现计算机视觉_改ghostnet

- 5github-IntelliJ IDEA上传本地代码到github仓库_intelli14j本地代码上传到github

- 6基于Echarts+HTML5可视化数据大屏展示—大数据智慧数据平台_echart编制平台

- 7Pytorch里CrossEntropyLoss,BCEWithLogitsLoss,BCELoss区别简析_torch.nn.bcewithlogitsloss() 和 celoss

- 8Vatee万腾平台:科技与生活的无缝连接

- 9未来乡村/美好乡村新视野:EasyCVR智能视频监控技术助力乡村振兴

- 10关于FPGA对 DDR4 (MT40A256M16)的读写控制 4

当前位置: article > 正文

高性能推理框架漫谈

作者:我家小花儿 | 2024-06-24 10:20:07

赞

踩

高性能推理框架漫谈

传统模型分布式推理框架

- Tensorflow serving

- Pytorch Serving

- Triton Server

大语言模型的推理框架

- 其中, VLLM 后端接入了Ray 框架, 作为调度请求的分发处理;

- 除此之外,还包括Nvidia 最新推出的TensorRT-LLM, 增加了对LLM 的支持

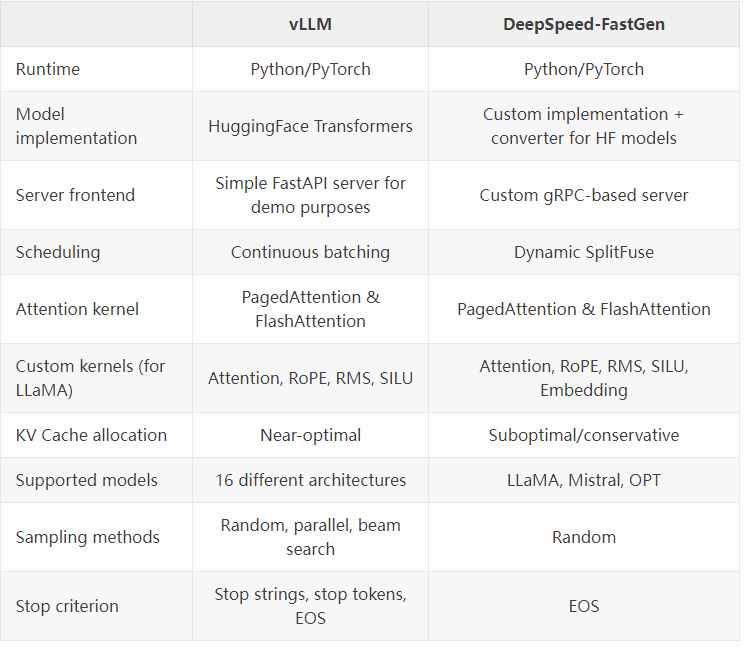

目前应用比较多的是VLLM 和DeepSpeed, 关于二者的比较:

Reference

- https://medium.com/@plthiyagu/comparing-llm-serving-frameworks-llmops-f02505864754

- https://blog.vllm.ai/2023/11/14/notes-vllm-vs-deepspeed.html

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家小花儿/article/detail/752436

推荐阅读

相关标签