- 1完整教程--idea使用git进行项目管理

- 2c语言有程序段inti x=1,C语言考试题库及答案(1)

- 3必知的下载网页视频攻略!包含视频号视频下载_视频号下载网页

- 4简述ECC加密算法

- 5【Python】 探索Python的site-packages目录:初学者指南_python site-packages

- 6擅长公有云的Serverless,搞起私有化部署也很香!

- 7java毕业设计汽车销售管理系统(Springboot+mysql+jdk1.8+maven3.39)_车辆销售管理系统

- 8CH2_感知机算法原理及其spark 实现_vectorassembler

- 9阿里云-签名文件直传_阿里云oss小程序直传 获取签名

- 10ThingsBoard开源物联网平台介绍_thingsbord_thingsboard物联网

gbdt 回归 特征重要性 排序_GBDT算法原理及应用

赞

踩

是新朋友吗?记得先点蓝字关注我哦~

作者介绍

知乎@王多鱼

京东的一名推荐算法攻城狮。

主要负责商品推荐的召回和排序模型的优化工作。

一、GBDT算法原理

Gradient Boosting Decision Tree(GBDT)是梯度提升决策树。GBDT模型所输出的结果是由其包含的若干棵决策树累加而成,每一棵决策树都是对之前决策树组合预测残差的拟合,是对之前模型结果的一种“修正”。梯度提升树既可以用于回归问题(此时被称为CART回归树),也可以被用于解决分类问题(此时被称为分类树)。

举个简单的例子:假如大华30岁,第一棵树拟合出的年龄为20岁,此时差距为10岁;第二棵树拟合的年龄为6岁,此时差距还有4岁;第三棵树拟合的年龄为3岁,此时的差距就只有1岁了。每一轮迭代,拟合的岁数误差都会减小。

在GBDT的迭代中,假设我们前一轮迭代得到的强学习器是Fm-1(x),损失函数是L(y,Fm-1(x)),本轮迭代的目标是找到一个CART回归树模型的弱学习器hm(x),让本轮的损失函数L(y,Fm-1(x))=L(y,Fm-1(x)+hm(x))最小。即在本轮迭代中找到一颗决策树,使得样本的损失尽量变得更小。

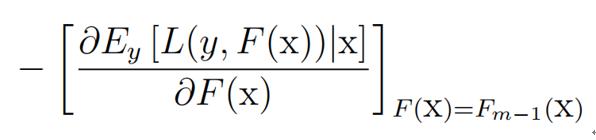

怎么找到本轮中的决策树是关键,GBDT是利用损失函数在当前模型的负梯度作为提升树算法的残差近似值, 去拟合一棵树。即:

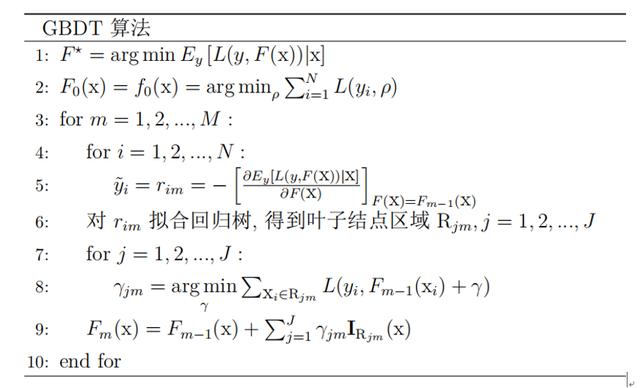

GBDT算法步骤如下:

我们需要做的是计算rim,即计算公式(1)作为第m棵树样本新的label, 将数据(xi,rim(x))作为第m棵树的训练数据。通过使用 CART 回归树逼近rim,使得CART 回归树模型与label 之间的距离尽可能的接近。衡量距离有多种方式, 包括均方误差和Logloss。

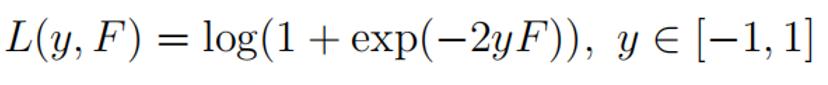

下面给出 Logloss 损失函数的具体推导:

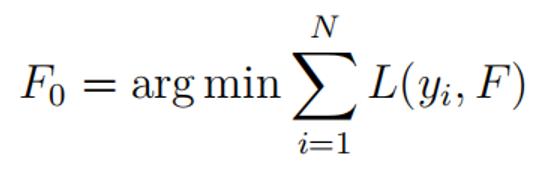

Step1:首先求解初始值F0 , 令其偏导等于 0。实现后是第一棵树需要拟合的残差。

令: