热门标签

热门文章

- 1ROSNOTE : ROS从callback中获取数据在回调函数以外使用_ros回调函数能否写在别的源文件中

- 2android开发笔记之adb命令详解_android 13 charger mode打开adb

- 3面试题解答思路——高并发_怎么处理高并发面试题

- 4好用的URL

- 5Java学习-常用API-ArrayList

- 6银河麒麟V10(Kylin Linux Advanced Server V10 (Tercel))安装Python3.8、MySQL5.7、Redis_麒麟v10安装python3.8

- 7蓝桥杯龟兔赛跑预测Python(超详细!!)

- 8SpringBoot—Entity父子类表@Inheritance和@MappedSuperclass_继承父类的entity 插入数据到数据库后,父类的字段为空

- 9前端通过file上传文件后,直接转为Bolb进行下载_a-upload 转成blob

- 10软件工程与项目管理

当前位置: article > 正文

集成学习基础知识一(Bagging和Boosting的区别以及Boosting(Adaboost)的过程与实例)_写出boosting算法和bagging算法

作者:我家小花儿 | 2024-02-17 01:14:42

赞

踩

写出boosting算法和bagging算法

在集成算法中主要分为bagging算法(英文翻译是套袋)和boosting算法(英文翻译是提升)

Bagging算法的过程如下:

- 从原始样本集中使用Bootstarping方法随机抽取n个训练样本,共进行k轮抽取,得到k个训练集(k个训练集之间相互独立,元素可以有重复)。

- 对于n个训练集,我们训练k个模型,(这个模型可根据具体的情况而定,可以是决策树,knn)

- 对于分类问题:由投票表决产生分类结果;对于回归问题,由k个模型预测结果均值作为最后预测的结果(所有的模型的重要性相同)

Boosting算法的过程如下:

- 对于训练集中的每个样本建立权值wi,表示对每个样本的权重,其关键在与对于被错误分类的样本权重会在下一轮的分类中获得更大的权重(错误分类的样本的权重增加),这样做的目的就是使得错误分类的样本可以受到更多的关注,然后基于调整后的样本分布来训练下一个基学习器;如此重复进行,直至基学习器数目达到指定的值T,或者集成效果达到退出条件,然后将这些学习器进行加权结合。

- 同时加大分类误差概率小的弱分类器的权值,使其在表决中起到更大的作用,减少分类误差率较大的弱分类器的权值,使其在表决中起到较小的作用。每一次迭代都得到一个弱分类器,需要使用某种策略将其组合,作为最终模型,(ababoost给每次迭代之后的弱分类器一个权值,将其线性组合作为最终的分类器,误差小的分类器权重越大)

Bagging和Boosting的主要区别:

- 样本选择上:Bagging采取Booststraping随机有放回的取样,Boosting的每一轮训练的样本是固定的,改变的是分类器的权重。

- 样本权重上:Bagging采取的是均匀取样,且每个样本权重相同,Boosting根据错误率调整样本权重,错误率越大的样本权重会越大,错误率小的样本权重会变小,

- 预测函数上:Bagging中预测函数权重相同,Boosting中误差越小的预测函数其权重越大。

- 并行计算:Bagging的各个预测函数可以并行生成;Boosting的各个预测函数必须按照顺序迭代生成。

下面给出AdaBoost算法的流程图,一看就懂(哈哈)

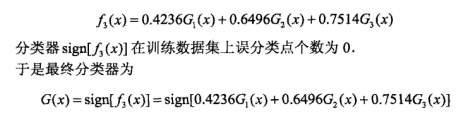

一个实例:

AdaBoost算法为加法模型、损失函数为指数函数、学习算法为前向分布算法的二分类算法。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家小花儿/article/detail/98589

推荐阅读

相关标签