热门标签

热门文章

- 1【Java-LangChain:使用 ChatGPT API 搭建系统-4】评估输入-分类_java实现langchain

- 2算法导论(原书第3版)

- 3python matlplotlib/seaborn 绘制曲线的平均值标准差阴影图_带标准差阴影光谱曲线

- 4Devexpress XAF框架——基本知识及安装软件介绍_devexpress跟xaf

- 5jQuery学习教程六: jQuery 效果 - 滑动 slide_jquery.slde

- 6tf.keras快速入门——自定义损失函数(一)_keras自定义模型损失函数

- 7MySQL5.7: my.cnf参数速查小册子_mysql 5.7 my.cnf

- 8Windows安装Tomcat详解_tomcat windows安装

- 9挑战杯 基于LSTM的天气预测 - 时间序列预测

- 10UE5 虚幻引擎中UI、HUD和UMG的区别与联系_ue5 头显

当前位置: article > 正文

利用Python爬取租房信息_爬虫爬取q房租房网站房源信息论文

作者:我家自动化 | 2024-03-06 06:37:05

赞

踩

爬虫爬取q房租房网站房源信息论文

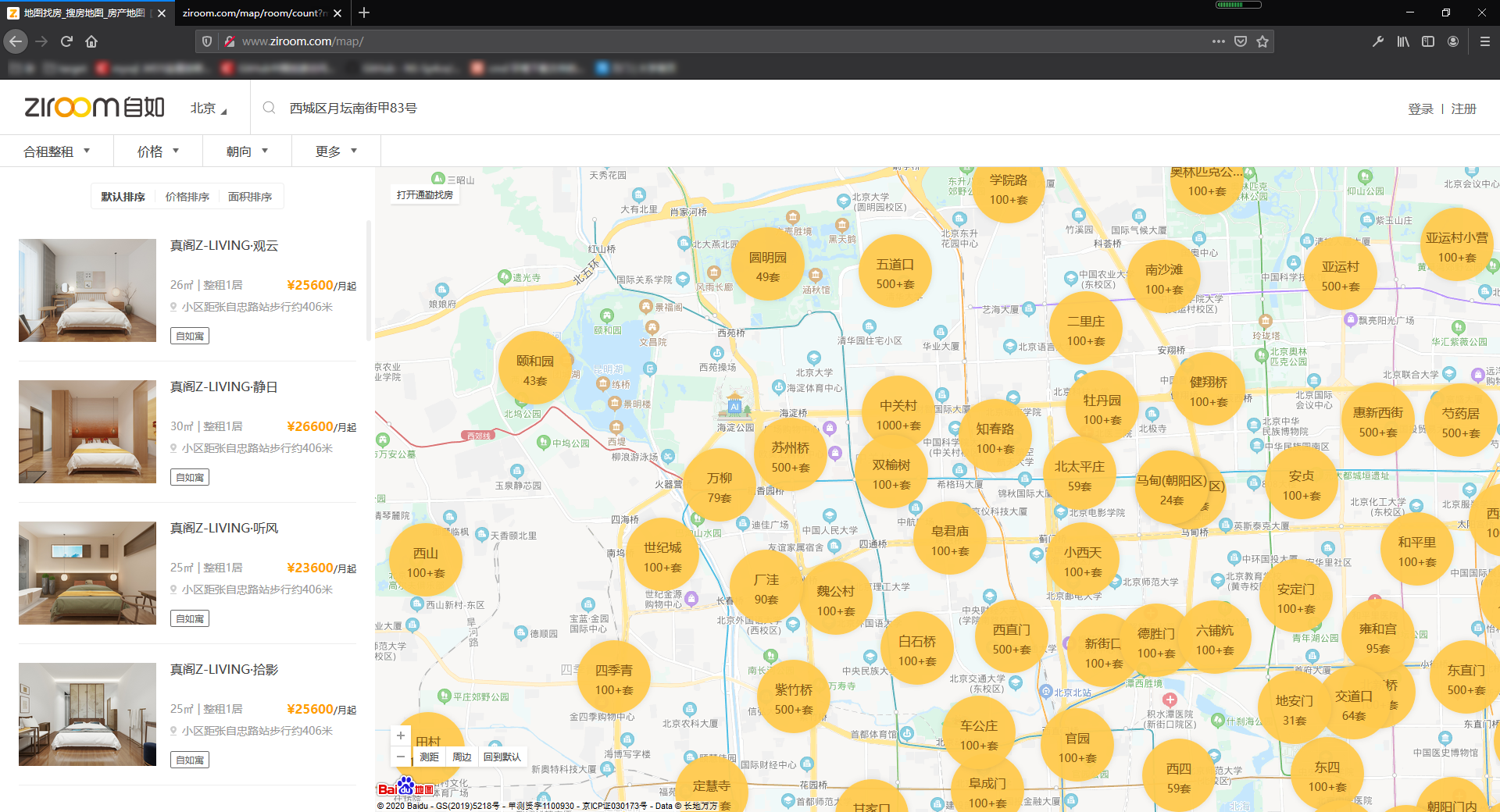

很多北漂都是通过自如来租房,自如网站提供了地图找房的功能,可以在地图上找到附近的房源,但是这样还是不够直观,这时候爬虫就派上用场了,可以帮助找房者快速的找到需要的房子,节省找房的时间。

开发环境

- Firefox 开发版

- VSCode 编辑器

- Anaconda3 (python3环境)

- Mongodb 用于存储数据

爬虫原理

首先打开浏览器的开发者选项,观察一下自如的地图找房api接口

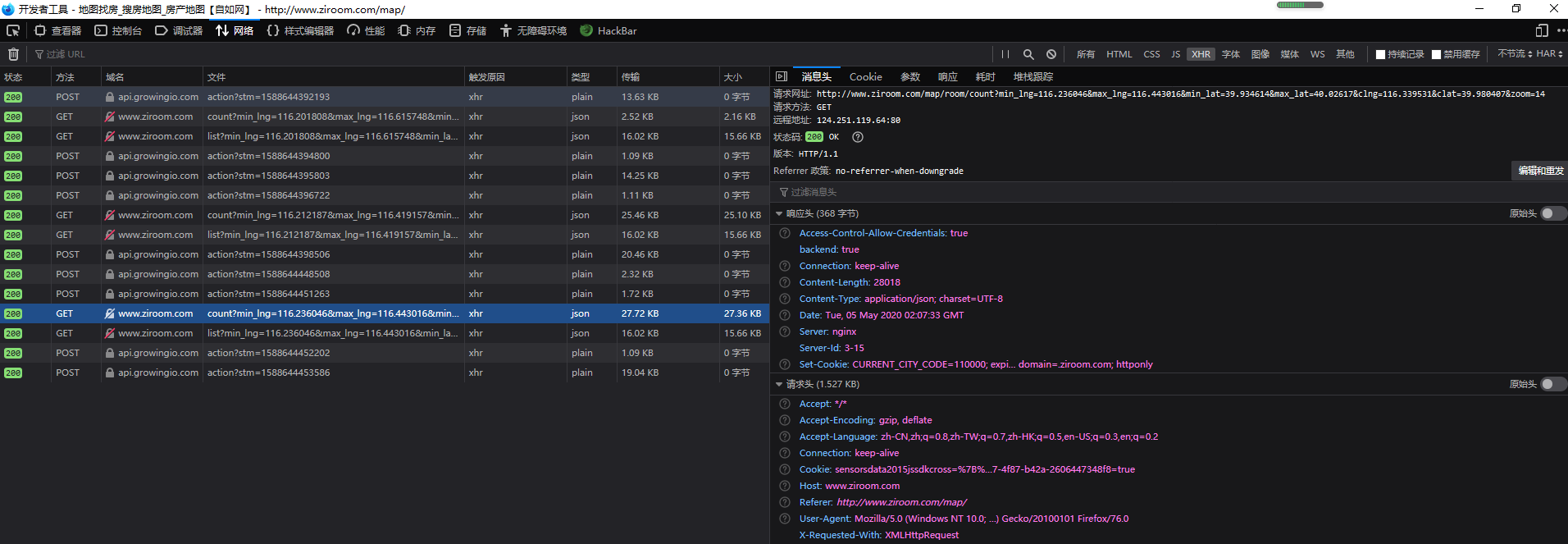

在浏览器中打开自如地图找房首页 http://www.ziroom.com/map/,将地图大小设置为14,点击减号,在network中查找前后端交互的请求,

请求如下图所示

url为http://www.ziroom.com/map/room/count?min_lng=116.236046&max_lng=116.443016&min_lat=39.934614&max_lat=40.02617&clng=116.339531&clat=39.980407&zoom=14

提交GET参数为

{

"min_lng": "116.236046",#最小的经度

"max_lng": "116.443016",#最大的经度

"min_lat": "39.934614",#最小的纬度

"max_lat": "40.02617",#最大的纬度

"clng": "116.339531",#中心的经度

"clat": "39.980407",#中心的纬度

"zoom": "14"#地图放大的级别

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

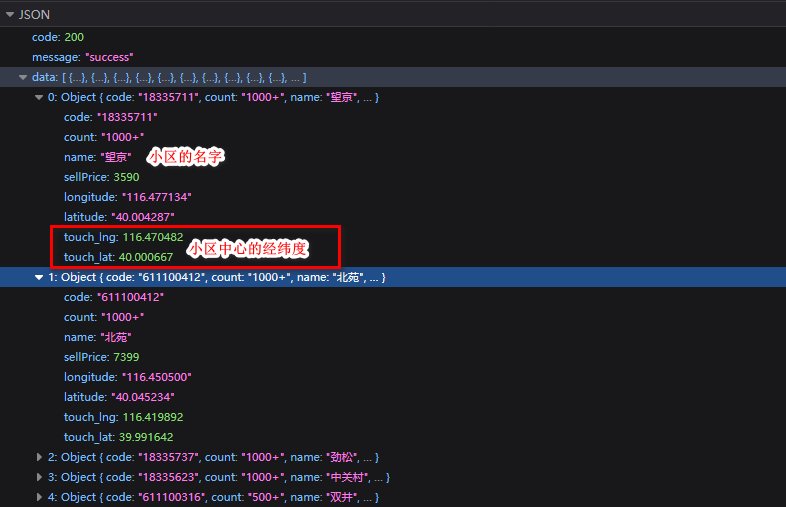

返回的数据为

点击小区进去(比如望京)

HTTP请求url为http://www.ziroom.com/map/room/count?min_lng=116.444611&max_lng=116.496353&min_lat=39.989225&max_lat=40.012107&clng=116.470482&clat=40.000667&zoom=16

参数为

{

"min_lng": "116.444611",

"max_lng": "116.496353",

"min_lat": "39.989225",

"max_lat": "40.012107",

"clng": "116.470482",#与上面图中的一致

"clat": "40.000667",#与上面图中一致

"zoom": "16"

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

小区的最大最小经纬度如何确定的,不知道,再点开一个小区(这是亚运村小营),提交的参数为

{

"min_lng": "116.394021",

"max_lng": "116.445763",

"min_lat": "39.980199",

"max_lat": "40.003084",

"clng": "116.419892",

"clat": "39.991642",

"zoom": "16"

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

不难发现这两组参数中的max_lng-clng和max-clat为一个固定值

这样通过clng和clat就可以确定min_lng,max_lng,min_lat,max_lat的值了

代码实现

下面直接上代码

#-*- coding:utf-8 -*- import requests,re,pickle,sys,json from bs4 import BeautifulSoup from requests.packages import urllib3 import pandas as pd urllib3.disable_warnings() from pymongo import MongoClient #mongodb数据库,用于将爬取的租房信息存下来 mongo = MongoClient('localhost',27017).zufang.ziru #全局变量 room_info_list = [] headers = { 'User-Agent':'Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:68.0) Gecko/20100101 Firefox/68.0', 'Origin':'http://www.ziroom.com' } #requests的会话对象 s = requests.Session() #爬取每个小区的租房信息 def spider(info): room_info_list = [] #当前页 pg = 1 #总的页数 pages = 1 url = 'http://www.ziroom.com/map/room/list' #自如将地图划分成一个个矩形的小格子,每个小格式表示一个小区的范围,小格子的区域使用经纬度来表示 #提交的参数 #通过观察可以发现所有提交的参数中,格子边界距离中心的距离为固定值,这样就比较容易构造参数了 lat_diff = 0.011443 lng_diff = 0.025871 #这里所有参数值均为字符串 params = { "max_lng": "%.6f" % (info['touch_lng'] + lng_diff),#最大经度 "min_lng": "%.6f" % (info['touch_lng'] - lng_diff),#最小经度 "max_lat": "%.6f" % (info['touch_lat'] + lat_diff),#最大纬度 "min_lat": "%.6f" % (info['touch_lat'] - lat_diff),#最小纬度 "clng": "%.6f" % info['touch_lng'], "clat": "%.6f" % info['touch_lat'], "zoom":"16", "p":"1" } while pg <= pages: params['p'] = str(pg) r = s.get(url=url, params=params,headers=headers) if r.status_code == 200: data = r.json() pages = data['data']['pages'] for item in data['data']['rooms']: try: #将结果存入数据库 mongo.update( {"id":item['id']}, { '$set':item }, upsert = True ) #将结果存储为csv格式 item['location'] = item['location'][0]['name'] for k,v in item.items(): #将list类型转化为str类型 if str(type(v)) == "<class 'list'>": item[k] = str(v) #将//开关的url转化为http://开头 if str(type(v)) == "<class 'str'>" and v.startswith('//'): item[k] = 'http:' + v room_info_list.append(item) print(item['name']) except: pass print(info['name'],pg,pages) pg += 1 #将结果导入为csv格式,每个小区一个csv文件,方便筛选 if room_info_list: pickle.dump(room_info_list,open('ziru_result/%s.db' % info['name'],'wb')) df = pd.DataFrame(room_info_list)[['name','desc','price','location','detail_url']] df.to_excel('ziru_result/%s.xls' % info['name']) def main(): #获取北京所有小区的租房信息, url = 'http://www.ziroom.com/map/room/count?min_lng=116.228373&max_lng=116.486653&min_lat=40.019069&max_lat=40.123091&clng=116.357513&clat=40.0711&zoom=14' r = s.get(url,headers = headers) if r.status_code == 200: data = r.json()['data'] for item in data: #爬取每个小区的租房信息 print(item) spider(item) main()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

- 85

- 86

- 87

- 88

- 89

- 90

- 91

- 92

- 93

- 94

- 95

- 96

- 97

- 98

- 99

- 100

- 101

结果

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家自动化/article/detail/196541

推荐阅读

相关标签