- 1【springboot开发】项目打包、发布和部署_springboot项目打包部署

- 2实例99:使用AEGAN对MNIST数据集压缩特征及重建_ae-gan

- 3通过openssl生成密钥以及如何设置flask接口的https访问_openssl 证书 flask

- 4云原生向量数据库Milvus(二)-数据与索引的处理流程、索引类型及Schema_milvus 多字段search

- 5美国国会听证会探讨“深度伪造(deepfake)”风险及对策_深度伪造引发社会风险

- 6解决Plugin ‘xxx‘ is incompatible with this installation的问题(bito)_this plugin is not a production of jetbrains

- 7恐怖的ChatGPT,肉哥也All in了!

- 8使用Unity3D 自主实战开发的赛车游戏实例,关键点记录 (五)之实时排名系统

- 9哲理故事300篇 中_我要松下特别痛苦走到哪住哪楼上做装饰销售可达弄到我身上老愈吗

- 10F5负载均衡

英伟达推出新的 AI 芯片和软件:我们要做像苹果或微软一样的公司_nvidia inference microservices

赞

踩

-

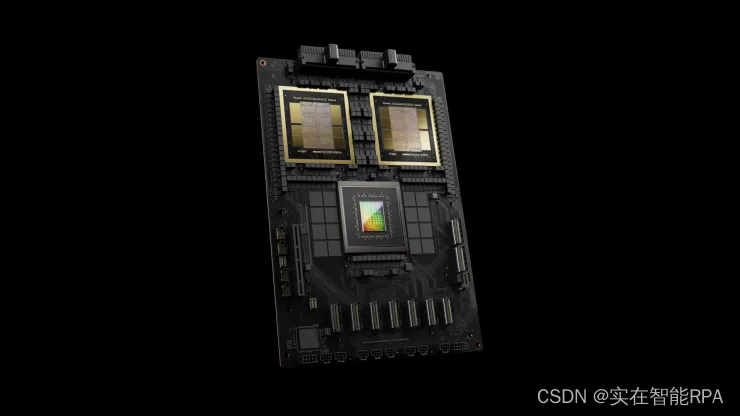

英伟达周一宣布推出新一代人工智能芯片和用于运行人工智能模型的软件。

-

新的人工智能图形处理器被命名为Blackwell,预计将于今年晚些时候发售。

-

这一消息发布之际,各公司和软件制造商仍在争先恐后地购买当前一代的 H100 和类似芯片。

刚刚,英伟达宣布推出新一代人工智能芯片和用于运行人工智能模型的软件。这一消息是在圣何塞举行的开发者大会上宣布的,英伟达公司正寻求巩固其作为人工智能公司首选供应商的地位。

自 2022 年底 OpenAI 的 ChatGPT 掀起人工智能热潮以来,英伟达股价上涨了五倍,总销售额增长了两倍多。英伟达的高端服务器 GPU 对于训练和部署大型 AI 模型至关重要。像微软已花费了数十亿美元用于购买芯片。

新一代 AI 图形处理器被命名为 Blackwell。第一款 Blackwell 芯片称为 GB200,将于今年晚些时候发售。

01 不只卖芯片,还卖软件

英伟达正在用更强大的芯片来吸引客户,以刺激新订单。例如,公司和软件制造商仍在争先恐后地获得当前一代的“Hopper”H100 和类似芯片。

“Hopper 太棒了,但我们需要更大的 GPU,”英伟达首席执行官黄仁勋在加州举行的公司开发者大会上表示。

该公司还推出了名为 NIM 的创收软件,该软件将使人工智能的部署变得更加容易,为客户提供了另一个理由,让他们在不断增长的竞争对手中坚持使用英伟达芯片。

英伟达高管表示,我们不再是一个唯利是图的芯片提供商,而更像是一个平台提供商,就像微软或苹果一样,其他公司可以在平台上构建软件。

“Blackwell 不是芯片,而是一个平台的名称,”黄说。

英伟达企业副总裁 Manuvir Das 在接受采访时表示:“可销售的商业产品是 GPU,而软件都是为了帮助人们以不同的方式使用 GPU。” “当然,我们仍然这样做。但真正改变的是,我们现在真正拥有了商业软件业务。”

Das 表示,英伟达的新软件将使在任何 Nvidia GPU 上运行程序变得更加容易,甚至是那些可能更适合部署但不适合构建人工智能的旧 GPU。

“如果你是一名开发人员,你有一个有趣的模型,希望人们采用,如果你将它放入 NIM 中,我们将确保它可以在我们所有的 GPU 上运行,这样你就能接触到很多人, ”Das 说道。

02 Blackwell GPU 功能很强大,但也很贵

英伟达每两年更新一次 GPU 架构,实现性能的大幅提升。去年发布的许多人工智能模型都是在该公司的 Hopper 架构上进行训练的,该架构由 H100 等芯片使用,该架构于 2022 年发布。

英伟达表示,基于 Blackwell 的处理器(例如 GB200)为 AI 公司提供了巨大的性能升级,其 AI 性能为 20 petaflops,而 H100 为 4 petaflops。英伟达表示,额外的处理能力将使人工智能公司能够训练更大、更复杂的模型。

该芯片包括英伟达所谓的变压器引擎,专门用于运行基于变压器的人工智能,这是支撑 ChatGPT 的核心技术之一。

Blackwell GPU 很大,将两个单独制造的芯片组合成一颗由台积电制造的芯片。它还将作为一个名为 GB200 NVLink 2 的完整服务器提供,结合了 72 个 Blackwell GPU 和其他旨在训练 AI 模型的英伟达部件。

亚马逊、谷歌、微软和甲骨文将通过云服务出售 GB200 的访问权限。GB200 将两个 B200 Blackwell GPU 与一个基于 Arm 的 Grace CPU 配对。

英伟达表示,亚马逊网络服务将构建一个包含 20,000 个 GB200 芯片的服务器集群。该系统可以部署27万亿参数的模型。这甚至比最大的模型(例如 GPT-4)还要大得多,据报道 GPT-4 有 1.7 万亿个参数。

许多人工智能研究人员认为,具有更多参数和数据的更大模型可以释放新功能。

英伟达没有提供新 GB200 或它所使用的系统的成本。据分析师估计,英伟达基于 Hopper 的 H100 每个芯片的成本在 25,000 美元到 40,000 美元之间,整个系统的成本高达 200,000 美元。

03 Nvidia 推理微服务

英伟达还宣布在企业软件订阅中添加一款名为 NIM(Nvidia Inference Microservice)的新产品。

NIM 使使用旧版 Nvidia GPU 进行推理或运行人工智能软件的过程变得更加容易,并将允许公司继续使用他们已经拥有的数亿个 Nvidia GPU。

与新人工智能模型的初始训练相比,推理所需的计算能力更少。NIM 使想要运行自己的 AI 模型的公司能够使用,而不是从 OpenAI 等公司购买 AI 结果作为服务。

该策略是让购买基于英伟达的服务器的客户注册 Nvidia enterprise,每个 GPU 每年的许可费用为 4,500 美元。

英伟达将与微软或 Hugging Face 等人工智能公司合作,确保他们的人工智能模型能够在所有兼容的英伟达芯片上运行。然后,使用 NIM,开发人员可以在自己的服务器或基于云的 Nvidia 服务器上高效地运行模型,而无需冗长的配置过程。

“在我的代码中,当我调用 OpenAI 时,我将替换一行代码,将其指向我从 Nvidia 获得的 NIM,”Das 说。

英伟达表示,该软件还将帮助人工智能在配备 GPU 的笔记本电脑上运行,而不是在云端服务器上运行。