- 1el-table的各个属性5.17_el-table属性

- 2Dependency ‘org.springframework.cloud:spring-cloud-starter-config:‘ not found_dependency 'org.springframework.cloud:spring-cloud

- 3Windows的cmd运行编译器(cmd运行c/c++、python等)_windows cmd python

- 42023如果纯做业务测试的话,在测试行业有出路吗?_业务测试是不是最简单的

- 5MAC 安装PHP及环境配置 保姆级别_formula.jws.json: update failed, falling back to c

- 6xcode通过链接ssh 链接git_xcode 配置ssh

- 7fastapi响应数据处理_fastapi中間件修改響應

- 8一篇文章带你入门文件上传漏洞_如何利用文件上传漏洞

- 9c语言中输入一个字符串直到遇到回车为止,C语言程序设计实践第四章.pptx

- 10“BS,“ “PL,“ 和 “CF“ 是财务报告中常用的缩写,它们分别代表财务报表的不同部分_bs pl

马斯克旗下xAI正式宣布开源大模型Grok-1

赞

踩

Grok-1

目前,xAI关于Grok-1没有透露更多信息。

官网放出的信息如下——

- 基础模型在大量文本数据上训练,未针对任何特定任务进行微调。

- 314B参数的MoE,有25%的权重在给定token上处于激活状态。

- 2023年10月,xAI使用JAX和Rust之上的自定义训练堆栈从头开始训练。

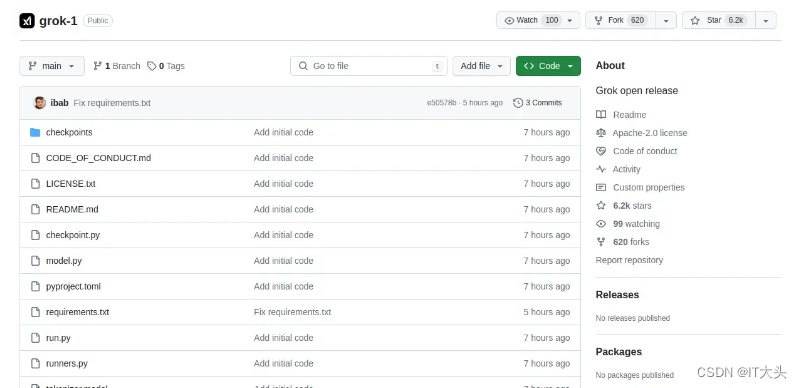

- 截至到目前为止,,Grok在Github上就狂揽了6k星,620个Fork。

3140亿的参数,让Grok-1成为迄今参数量最大的开源LLM,是Llama 2的4倍。

全球首个最大模型开源

这次xAI开源Grok-1,遵守的是Apache-2.0许可证,因此,用户可以自由使用、修改和分发软件。

存储库包含了用于加载和运行Grok-1开源权重模型的JAX示例代码。

由于模型较大,参数达到了314B参数,因此需要具有足够GPU内存的计算机,才能使用示例代码测试模型。

一般人估计是很难在个人PC上运行起来。

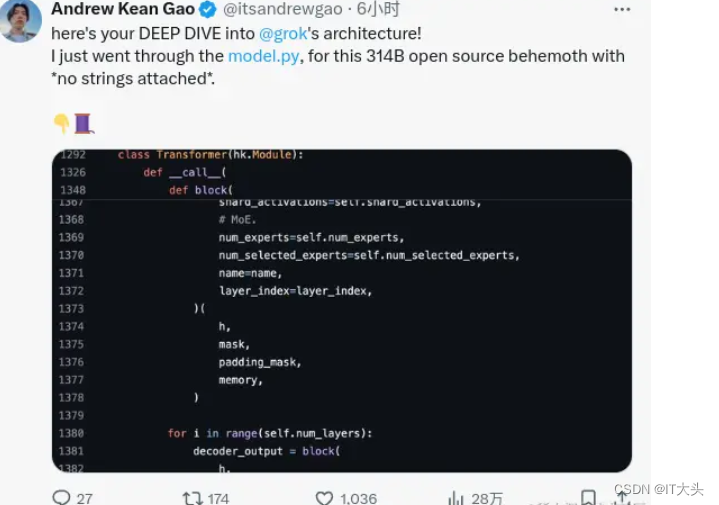

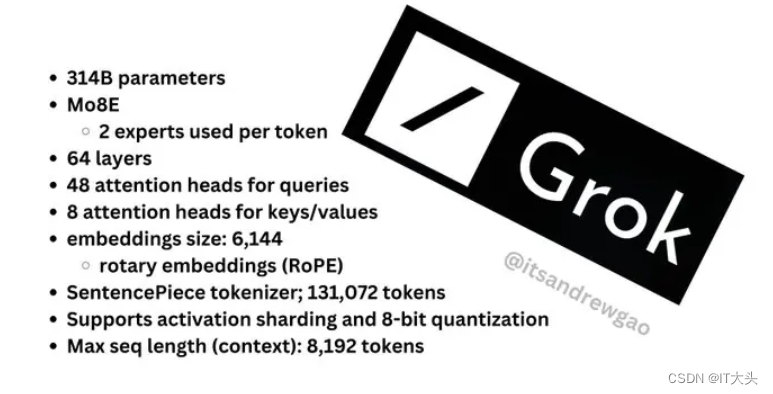

斯坦福研究者Andrew Kean Gao浏览了model.py介绍了更多Grok的架构信息,3140亿参数没有更多附加条款。

8个混合专家(2个活跃专家),860B活跃参数。它使用旋转嵌入,而不是固定位置嵌入。

-

tokenizer词汇量:131,072(于GPT-4类似)相当于2^17

-

嵌入大小:6144(48*128)

-

Transformer层:64(每一层都有一个解码层:多头注意块和密度块)

-

键值大小:128

最后大家可以直接看Andrew Kean Gao针对Grok-1的总结版图。

大模型第二春?

AI社区已经沸腾了!

连OpenAI的员工,都表示了自己对Grok的强烈兴趣。

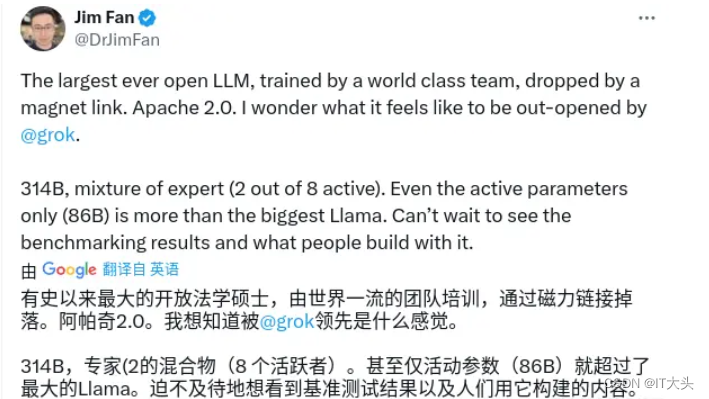

英伟达高级科学家Jim Fan表示,「有史以来最大的开源大模型,由世界级团队训练,通过磁力链Apache 2.0发布。

xAI表示,Grok的设计灵感来源于《银河系漫游指南》,它能够回答几乎所有问题,助力人类不分背景或政治立场地追求理解和知识。

Grok最初的版本Grok-0拥有330亿参数,紧接着xAI推出了经过数次改进的Grok-1,为X上的Grok聊天机器人提供支持。

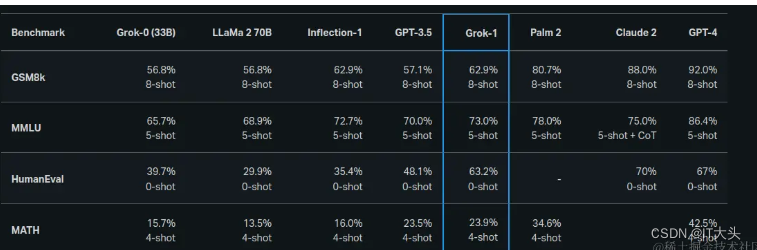

根据xAI公布的数据,在GSM8K、HumanEval和MMLU等一系列基准测试中,Grok-1的表现超过了Llama-2-70B和GPT-3.5,虽然跟GPT-4还差得远。

referer:x.ai/blog/grok

但此次xAI并没有放出Grok-1的具体测试成绩,其与OpenAI即将发布的GPT-5的大模型王者之战,必将成为业内关注的焦点。