- 1Linux基础 - SSH之秘钥登录_chmod 600 id_rsa

- 2免费安全的内网穿透实现——Tailscale_tailscale windows

- 3sublime text 格式化json快捷键配置_sublime text json

- 4物联网(AIOT)--下一个技术风口_物联网设备层

- 5windows环境下yolov5使用tensorrt加速,生成engine文件_yolov5 export.py

- 6基于注意力机制的seq2seq模型_基于点积的注意力机制 seq2seq

- 7python抖音github_使用 Python 下载抖音无水印视频

- 8mac下Tomcat的安装和配置_tomcat foler

- 9实测物联网平台云监控WEB设备iot系统源码_iot源代码

- 10NLP(六十五)LangChain中的重连(retry)机制_retrying langchain_google_genai.chat_models._chat_

windows下Hadoop的安装_hadoop windows安装

赞

踩

安装教程

主要参考安装教程

如在安装过程中遇到问题,可参考下方本人的问题记录。

问题记录

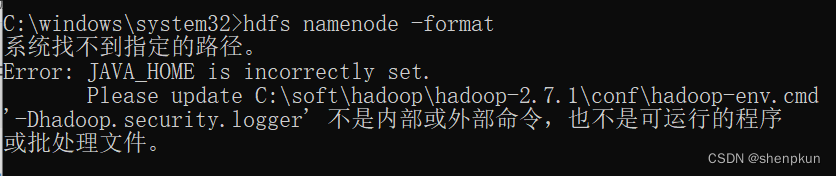

第4步 配置HADOOP_HOME

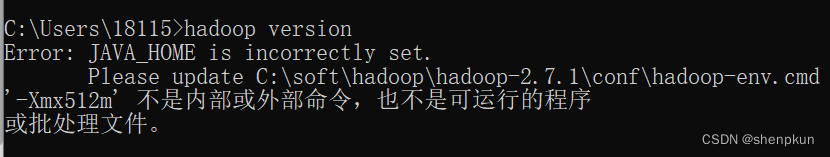

配置好后,cmd窗口输入hadoop version 报错:

解决教程:Hadoop版本查询报错解决

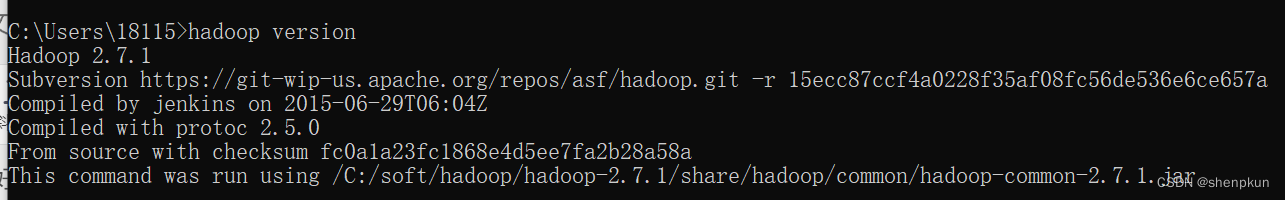

注意:修改的jdk版本一定和自己本地安装的一致(可通过java -version命令查询)

重启cmd窗口,再次输入hadoop version ,成功显示:

注意:这里按照解决教程修改完cmd里的后,安装教程第5步就不需要再修改了,不然会像我第9步时,重现一样的报错!!!

第7步

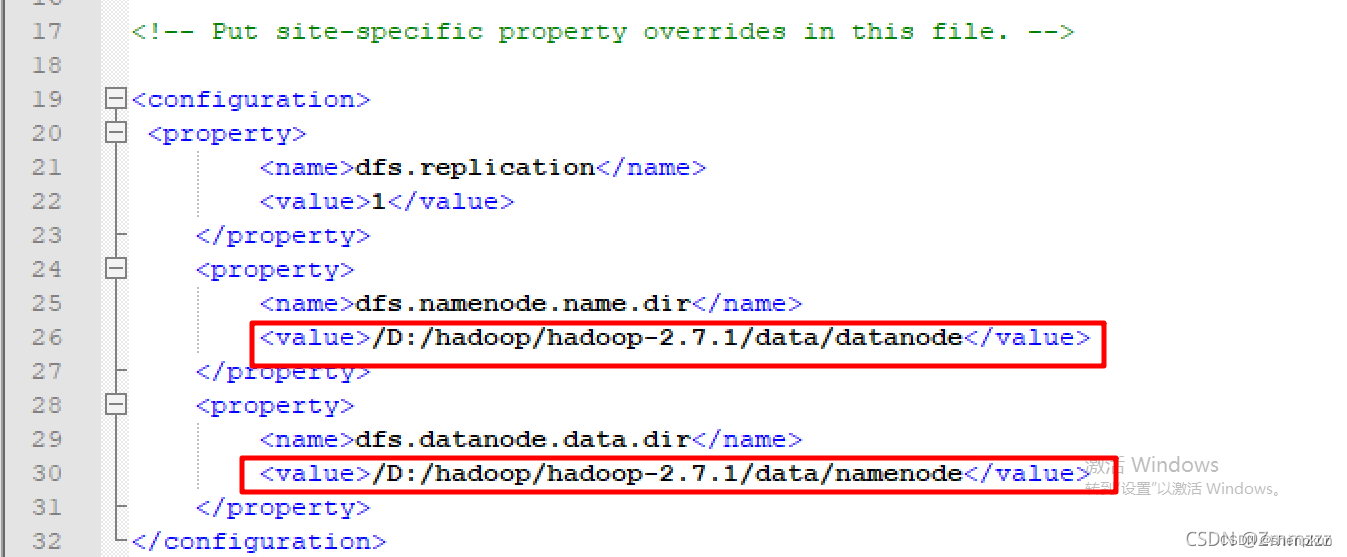

本人实际:教程中的datanode和namenode我怀疑弄反了

第9步

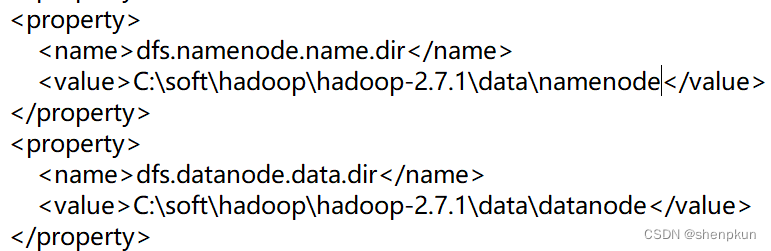

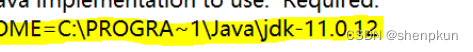

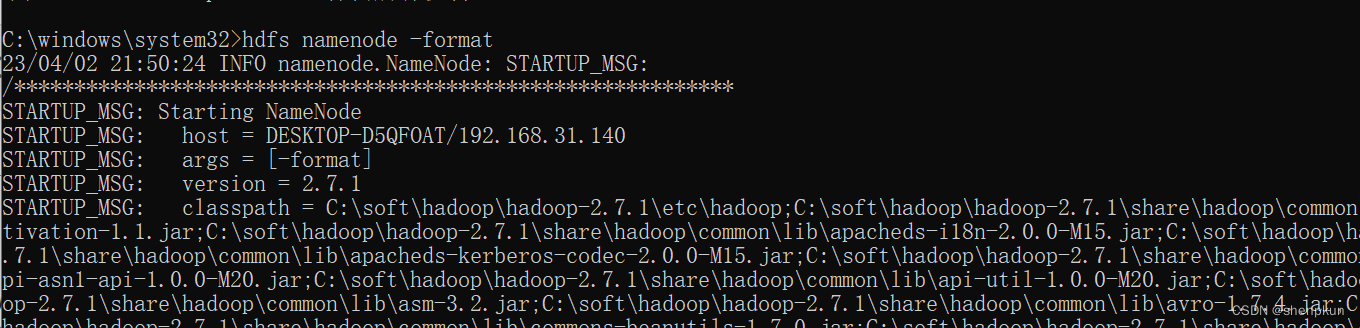

因为跟着总教程第5步把位置改了,尝试改回类似下方这种

输入hdfs namenode -format 正常显示:

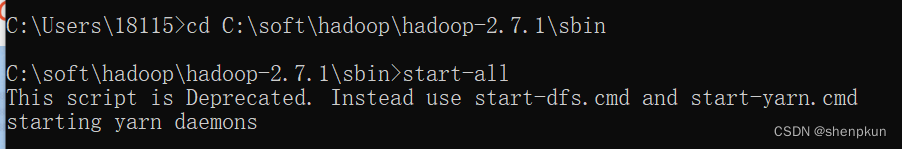

第10步

首先,说start-all这个命令已弃用,用后面两个一起替换(同样,stop-all亦是如此)。

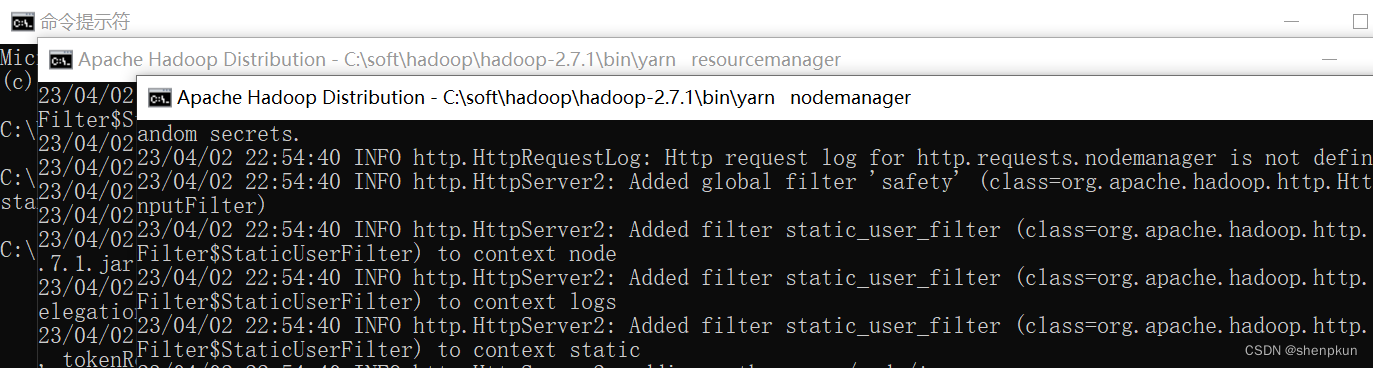

use start0dfs.cmd 开启两个;start-yarn.cmd开启两个;一共四个

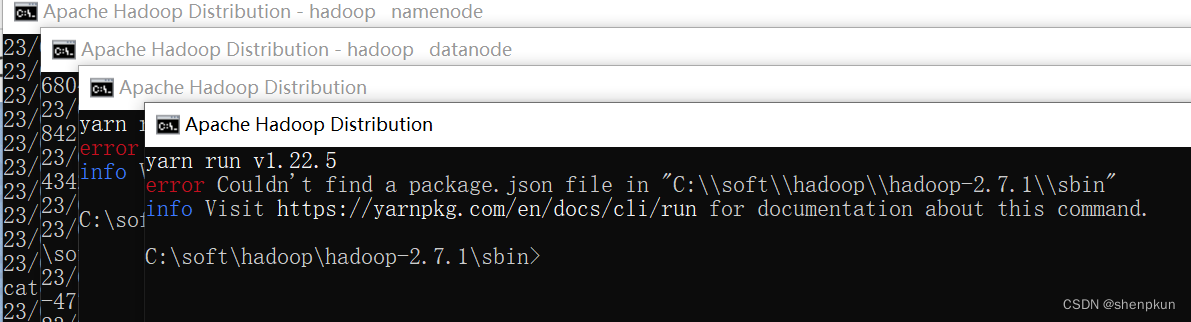

先不管这个。我的四个窗口有两个出现了error

(start-yarn.cmd开启的两个报错)

解决教程:解决couldn’t find a package.json file in …… 大概就是有重名yarn命令的原因

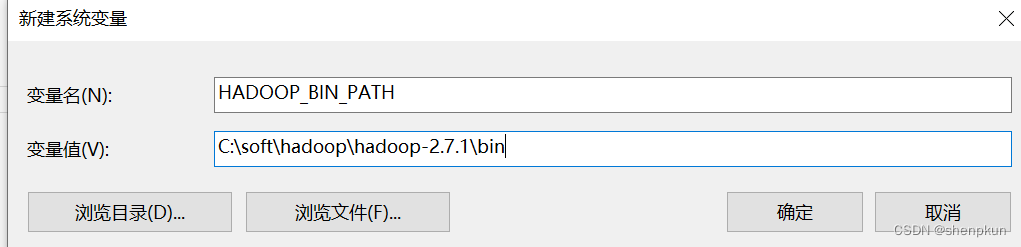

注意:除了跟着上方修改了yarn的路径外,需要自己手动去设置环境变量

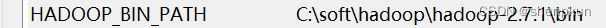

新建环境变量 HADOOP_BIN_PATH 为hadoop安装目录下的bin目录位置

重启cmd窗口,切换到Hadoop的sbin文件夹下,输入start-yarn.cmd 即可

第13步上传测试

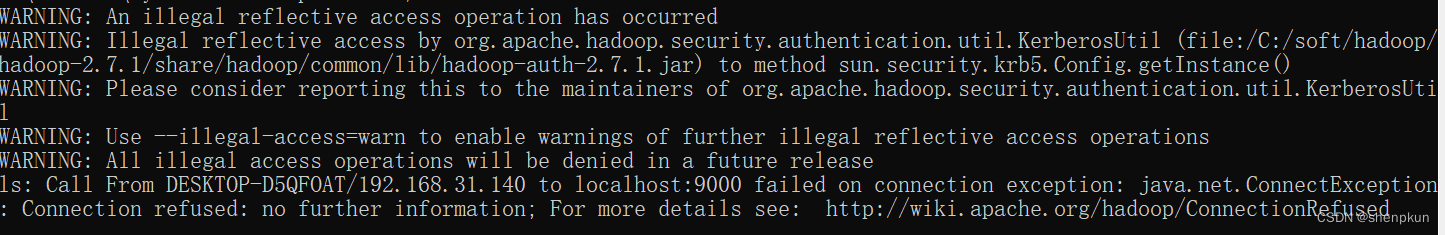

我复制命令输入都会有一串的警告:

可能原因是jdk版本较高,但貌似能运行,所以此处可以不管这些警告,就是有点影响体验。

我跟着上面提到过的修改etc/hadoop/hadoop-env.cmd的Java位置

我的原本是jdk-11.0.16.1,改成了jdk1.8.0_241之后警告就没有出现了。

注意:我能直接修改是在此之前配置过了相关的并且下载jdk1.8.0的版本,所以如果没有这个版本的可以不改,或者先把版本下载完配置好后再修改。

看上图最后一行提示错误:ls: ……连接失败

不能访问localhost:9000,想要访问这个需要开启hdfs

开启hdfs

在sbin文件夹路径下 cmd窗口命令:start-dfs.sh就可以访问了