热门标签

热门文章

- 12022年软件测试行业就业发展前景,软件测试前景好吗?我该学什么?_现在中国软件测试培训机构多如牛毛,将来软件测试`就业会相当困难是这样吗?

- 2request设置请求头_【SpringBoot WEB 系列】RestTemplate 之自定义请求头

- 3初学者学习AI大模型必看指南,一文尽览大模型知识点!绝对干货!!!_ai大模型学习

- 4python3.X 使用pip 离线安装whl包(转载)

- 5c语言两个指针相等,C语言之指针,便于理解

- 6MobaXterm连接Telnet设置方法

- 7本地离线部署Ai大模型的三种方案,含安装教程!_本地部署ai梦放在u盘里吗

- 8再也不想去字节跳动面试了,6年测开面试遭到这样打击....._字节测开四面是因为表现不好吗

- 9rabbitmq集群搭建报错:[error] Cookie file /var/lib/rabbitmq/.erlang.cookie must be accessible by owner only

- 10语音识别技术的前世今生【前世篇】_语音识别技术产生与起源

当前位置: article > 正文

基于Windows部署Ollama本地运行大模型_ollama windows本地部署大模型

作者:我家自动化 | 2024-07-30 13:37:08

赞

踩

ollama windows本地部署大模型

1. 下载并Ollama客户端

从ollama官网下载Windows版本的OllamaSetup.exe

下载好后双击并安装

2. 修改环境变量(可选)

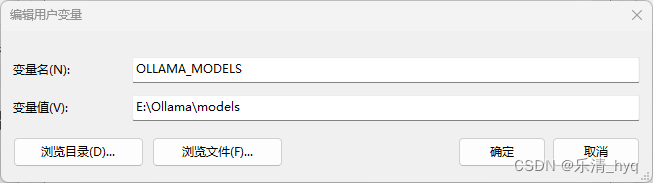

2.1 修改模型存储位置

若不修改,模型默认存储在C:\Users\%username%\.ollama\models

可通过设置环境变量OLLAMA_MODELS为自定义存储路径来修改模型存储位置

win11:设置->系统->高级系统设置->环境变量

新建环境变量,变量名为OLLAMA_MODELS,变量值为自定义存储路径

例:

3. 运行大模型

运行命令

ollama run <模型名>

- 1

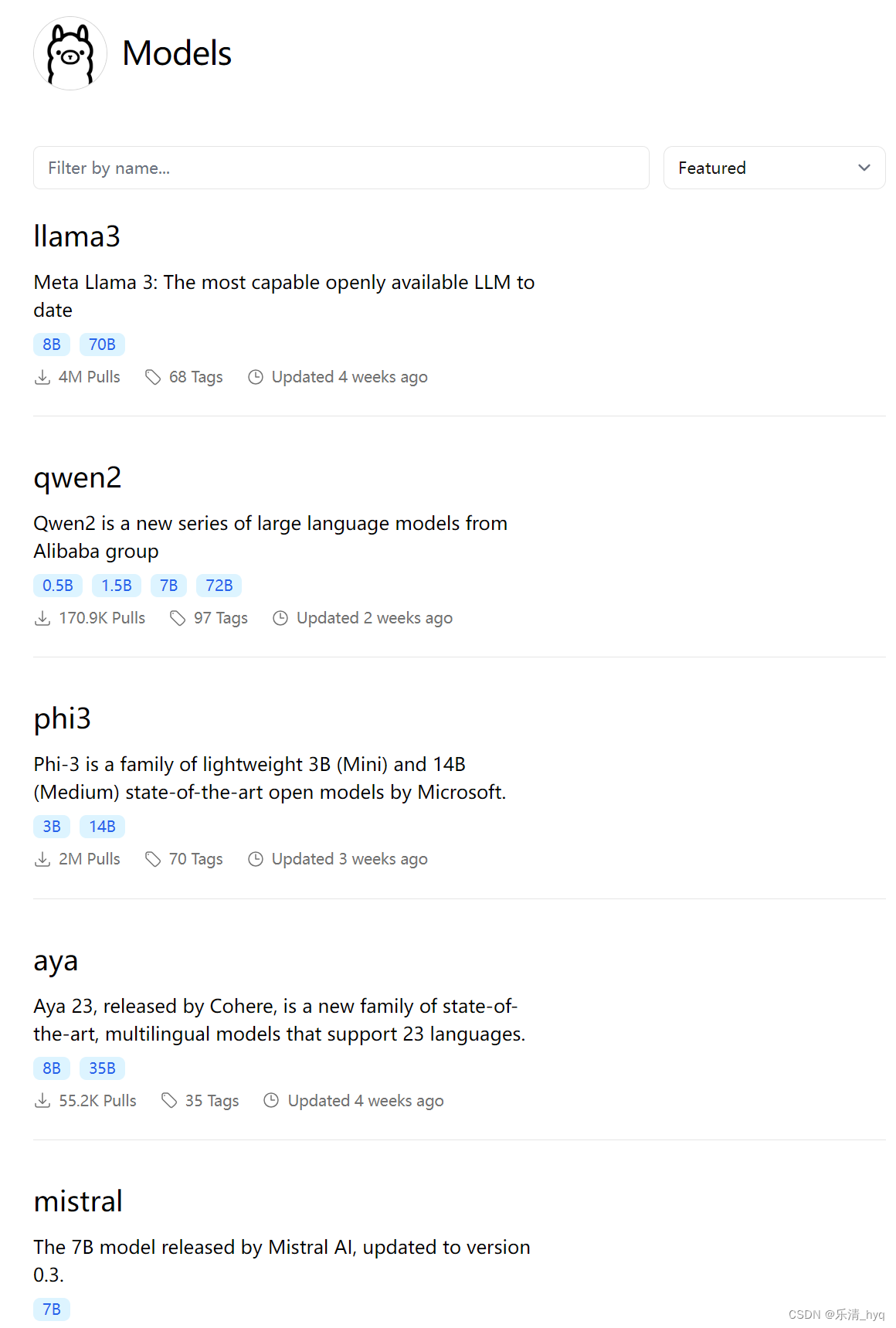

模型可以通过ollama官方模型列表查看

例:

// llama3,meta,有8b(80亿参数)和70b两种参数大小的

ollama run llama3:8b

// gemma,google,有2b和7b两种参数大小的

ollama run gemma

// mistral,法国mistral AI,有7b参数大小的

ollama run mistral

// 通义千问,阿里,有0.5b,1.5b,7b,72b四种参数大小的

ollama run qwen2

// phi3,微软,有3b,14b两种参数大小的

ollama run phi3

// llava-llama3,有8b参数大小的,支持视觉输入

ollama run llava-llama3

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

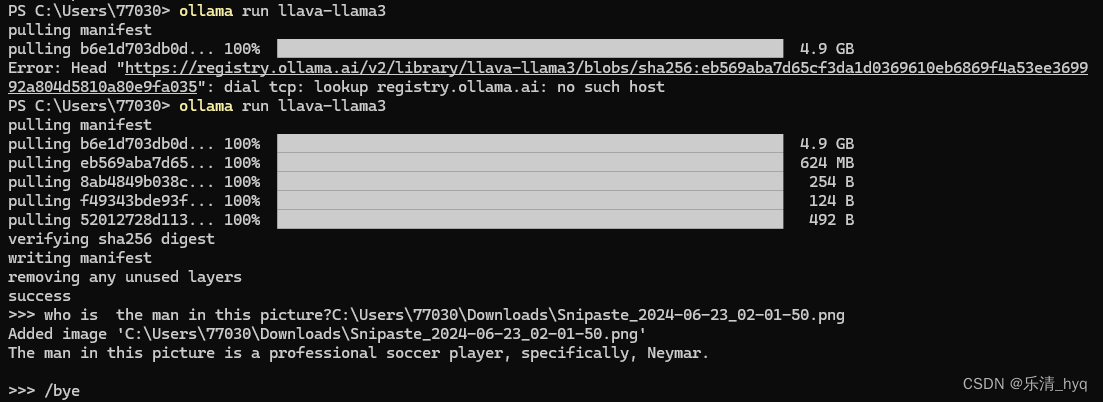

执行运行命令后,ollama首先会加载模型,加载成功后可通过命令行进行对话(图中llava-llama3模型支持图片输入,输入问题后直接将图片拖入命令行即可)

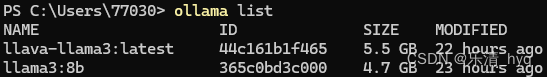

通过ollama list可以查看当前已加载的模型(系统重启后需要重新加载)

4. 搭建用户界面

命令行不方便交互,我们可以通过OpenWebUI搭建和ChatGPT类似的网页

OpenWebUI guide

4.1 Docker部署

官网提供了比较方便的通过Docker部署的方法,执行以下命令来运行OpenWebUI(首先要在Windows配置Docker环境):

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

- 1

4.2 源码nodejs编译

如果不方便配置Docker环境,可下载源码后通过nodejs编译

-

版本要求:

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家自动化/article/detail/903960

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。