- 1基于ODPS的SQL语句_odps java插入datetime类型的数据sql

- 2苹果cmsV10 MXone Pro自适应2.0影视模板源码下载_mxprov2.0自适应影视站模板

- 3python:threading.Thread类的使用详解_python thread 能否绑定一个类方法

- 4项目二 OpenStack快速入门

- 5大数据概述、前世今生、处理流程、学习路线、开发工具详解_大数据开发的基本概念与使用的工具

- 6分割一切视频版来了!SAM-PT:点几下鼠标,视频目标就分割出来了!

- 7python numpy库安装特别慢_python3.6下Numpy库下载与安装图文教程

- 8【MySql】 深入了解 SQL 窗口函数:ROW_NUMBER() 的使用与应用_mysql开窗函数rownumber

- 910的负8次方用python,decimal --- 十进制定点和浮点运算 — Python 3.8.8 文档

- 10Scrum工作模式及Scrum工具_scrum工作法

每个 AI/ML 工程师都应该知道的 Gen AI 框架和工具!_nlp 和gen ai

赞

踩

在快速发展的技术领域,生成式人工智能是一股革命性的力量,它改变了开发人员和AI/ML工程师处理复杂问题和创新的方式。本文深入探讨了生成式 AI 的世界,揭示了对每个开发人员都至关重要的框架和工具。

LangChain

LangChain 由 Harrison Chase 开发并于 2022 年 10 月首次亮相,是一个开源平台,旨在构建由 LLM 驱动的强大应用程序,例如 ChatGPT 等聊天机器人和各种量身定制的应用程序。

LangChain旨在为数据工程师提供一个包罗万象的工具包,以便在各种用例中使用LLM,包括聊天机器人、自动问答、文本摘要等。

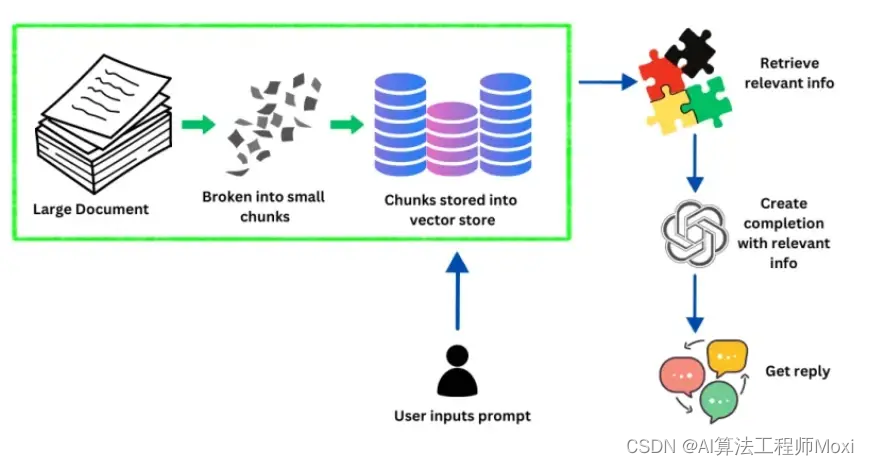

上图显示了LangChain如何处理和处理信息以响应用户提示。最初,系统从一个包含大量数据的大型文档开始。然后,该文档被分解为更小、更易于管理的块。

这些块随后被嵌入到向量中——这是一个将数据转换为系统可以快速有效地检索的格式的过程。这些向量存储在向量存储中,该存储本质上是为处理矢量化数据而优化的数据库。

当用户在系统中输入提示时,LangChain会查询这个向量存储,以查找与用户请求非常匹配或相关的信息。该系统使用大型 LLM 来理解用户提示的上下文和意图,从而指导从向量存储中检索相关信息。

一旦确定了相关信息,LLM 就会使用它来生成或完成准确解决查询的答案。最后一步最终是用户收到定制的响应,这是系统数据处理和语言生成功能的输出。

SingleStore

SingleStore Notebook 基于 Jupyter Notebook,是一种创新工具,可显著增强数据探索和分析过程,特别是对于那些使用 SingleStore 分布式 SQL 数据库的用户。它与 Jupyter Notebook 的集成使其成为数据科学家和专业人士熟悉且功能强大的平台。以下是其主要功能和优势的摘要:

本机 SingleStore SQL 支持:此功能简化了直接从笔记本查询 SingleStore 分布式 SQL 数据库的过程。它消除了对复杂连接字符串的需求,为数据探索和分析提供了一种更安全、更直接的方法。

SQL/Python 互操作性:这允许 SQL 查询和 Python 代码之间的无缝集成。用户可以在笔记本中执行 SQL 查询,并直接在 Python 数据帧中使用结果,反之亦然。这种互操作性对于高效的数据操作和分析至关重要。

协作工作流:笔记本支持共享和协作编辑,使团队成员能够共同处理数据分析项目。此功能增强了团队有效协调和组合其专业知识的能力。

交互式数据可视化:通过对 Matplotlib 和 Plotly 等流行数据可视化库的支持,SingleStore Notebook 使用户能够直接在笔记本环境中创建交互式且信息丰富的图表和图形。此功能对于需要直观地传达其发现的数据科学家至关重要。

易用性和学习资源:该平台是用户友好的,带有模板和文档,可帮助新用户快速入门。这些资源对于学习笔记本的基础知识和执行复杂的数据分析任务非常宝贵。

未来的增强和集成:SingleStore 团队致力于不断改进笔记本,并计划引入导入/导出、代码自动完成和适用于各种方案的笔记本库等功能。此外,人们还期待机器人功能能够促进 SingleStoreDB 中的 SQL 或 Python 编码。

简化 Python 代码集成:未来的目标是更轻松地在笔记本中对 Python 代码进行原型设计,并将此代码作为存储过程集成到数据库中,从而提高系统的整体效率和功能。

SingleStore Notebook 是面向数据专业人员的强大工具,它将 Jupyter Notebook 的多功能性与用于 SingleStore 的 SQL 数据库的特定增强功能相结合。它专注于易用性、协作和交互式数据可视化,以及未来增强的承诺,使其成为数据科学和机器学习社区的宝贵资源。

Llamaindex

LlamaIndex 是一个高级编排框架,旨在增强 GPT-4 等 LLM 的功能。虽然 LLM 本身就很强大,在庞大的公共数据集上进行了训练,但它们通常缺乏与私有或特定领域数据进行交互的方法。LlamaIndex 弥合了这一差距,提供了一种结构化的方式来摄取、组织和利用各种数据源,包括 API、数据库和 PDF。

通过将这些数据索引为针对 LLM 优化的格式,LlamaIndex 促进了自然语言查询,使用户能够无缝地与他们的私有数据进行对话,而无需重新训练模型。该框架用途广泛,既适合使用高级 API 进行快速设置的新手,也适合通过较低级别 API 寻求深度定制的专家。从本质上讲,LlamaIndex 释放了 LLM 的全部潜力,使它们更容易访问和适用于个性化的数据需求。

LlamaIndex如何运作?

LlamaIndex 充当桥梁,将 LLM 的强大功能与不同的数据源连接起来,从而开启了一个新的应用程序领域,可以利用自定义数据和高级语言模型之间的协同作用。通过提供用于数据摄取、索引和自然语言查询界面的工具,LlamaIndex 使开发人员和企业能够构建强大的数据增强应用程序,从而显着增强决策和用户参与度。

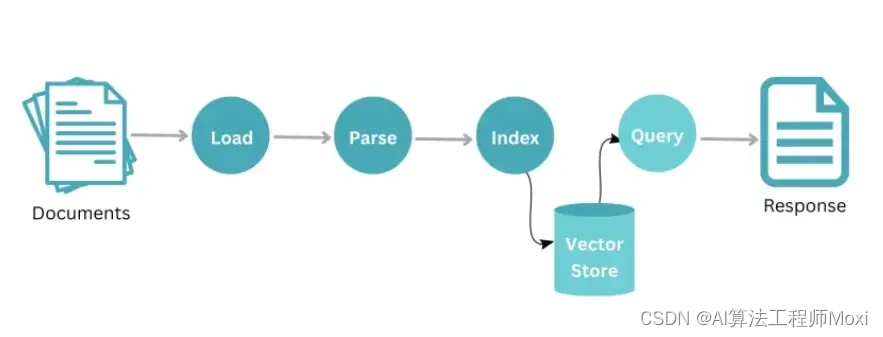

LlamaIndex 通过从一组文档开始的系统工作流程进行操作。最初,这些文档会经历一个加载过程,在该过程中它们被导入到系统中。加载后,对数据进行解析,以易于理解的方式分析和构建内容。解析后,将对信息进行索引,以实现最佳检索和存储。

这些索引数据安全地存储在标有“store”的中央存储库中。当用户或系统希望从此数据存储中检索特定信息时,他们可以启动查询。作为对查询的响应,相关数据被提取并作为响应传递,响应可能是一组相关文档或从中提取的特定信息。整个过程展示了 LlamaIndex 如何有效地管理和检索数据,确保快速准确地响应用户查询。

Llama2

Llama 2 是由 Meta 开发的最先进的语言模型。它是原始LLaMA的继任者,在规模,效率和性能方面提供了增强。Llama 2 型号的参数范围从 7B 到 70B 不等,可满足不同的计算能力和应用需求。Llama 2 专为聊天机器人集成量身定制,在对话用例中大放异彩,提供细致入微且连贯的响应,突破了对话式 AI 所能实现的界限。

Llama 2 使用公开可用的在线数据进行预训练。这涉及将模型暴露给大量文本数据,如书籍、文章和其他书面内容来源。此预训练的目标是帮助模型学习一般语言模式并获得对语言结构的广泛理解。它还涉及从人类反馈 (RLHF) 中进行监督微调和强化学习。

RLHF 的一个组成部分是拒绝抽样,它涉及从模型中选择响应,并根据人类反馈接受或拒绝它。RLHF 的另一个组成部分是近端策略优化 (PPO),它涉及直接根据人类反馈更新模型的策略。最后,迭代优化通过监督迭代和校正确保模型达到所需的性能水平。

Hugging Face

Hugging Face 是一个多方面的平台,在人工智能领域发挥着至关重要的作用,尤其是在自然语言处理 (NLP) 和生成式 AI 领域。它包含各种元素,这些元素协同工作,使用户能够探索、构建和共享 AI 应用程序。

以下是其关键方面的细分:

1. 模型中心:

Hugging Face 拥有大量预训练模型库,用于各种 NLP 任务,包括文本分类、问答、翻译和文本生成。

这些模型在大型数据集上进行训练,可以针对特定要求进行微调,使其易于用于各种目的。

这消除了用户从头开始训练模型的需要,从而节省了时间和资源。

2. 数据集:

除了模型库之外,Hugging Face 还提供对 NLP 任务的大量数据集的访问。

这些数据集涵盖了各种领域和语言,为训练和微调模型提供了宝贵的资源。

用户还可以贡献自己的数据集,丰富平台的数据资源并促进社区协作。

3. 模型训练和微调工具:

Hugging Face 提供了用于在特定数据集和任务上训练和微调现有模型的工具和功能。

这使用户能够根据自己的特定需求定制模型,从而提高其在目标应用中的性能和准确性。

该平台提供了灵活的培训选项,包括个人机器上的本地培训或针对大型模型的基于云的解决方案。

4. 应用程序构建:

Hugging Face 通过与 TensorFlow 和 PyTorch 等流行的编程库无缝集成,促进了 AI 应用程序的开发。

这允许开发人员利用预先训练的模型构建聊天机器人、内容生成工具和其他 AI 驱动的应用程序。

提供大量应用程序模板和教程来指导用户并加快开发过程。

5. 社区与协作:

Hugging Face 拥有一个由开发人员、研究人员和 AI 爱好者组成的充满活力的社区。

该平台通过模型共享、代码存储库和论坛等功能促进协作。

这种协作环境促进了知识共享,加速了创新,并推动了 NLP 和生成式 AI 技术的进步。

Hugging Face 不仅仅是一个模型存储库。它是一个全面的平台,包含模型、数据集、工具和蓬勃发展的社区,使用户能够轻松探索、构建和共享 AI 应用程序。对于希望在努力中利用人工智能力量的个人和组织来说,这使其成为一项宝贵的资产。

Haystack

Haystack 可以归类为一个端到端框架,用于构建由各种 NLP 技术提供支持的应用程序,包括但不限于生成式 AI。虽然它并不直接专注于从头开始构建生成模型,但它提供了一个强大的平台,用于:

1. 检索增强生成 (RAG):

Haystack擅长将基于检索和生成的方法相结合,用于搜索和内容创建。它允许集成各种检索技术,包括向量搜索和传统关键字搜索,以检索相关文档以供进一步处理。然后,这些文档将作为生成模型的输入,从而产生更有针对性和上下文相关的输出。

2. 多样化的NLP组件:

Haystack 为各种 NLP 任务提供了一套全面的工具和组件,包括文档预处理、文本摘要、问答和命名实体识别。这允许构建复杂的管道,将多种 NLP 技术结合起来以实现特定目标。

3. 灵活性和开源:

Haystack 是一个开源框架,建立在流行的 NLP 库(如 Transformers 和 Elasticsearch)之上。这允许与现有工具和工作流程进行定制和集成,使其能够适应不同的需求。

4. 可扩展性和性能:

Haystack 旨在有效地处理大型数据集和工作负载。它与 Pinecone 和 Milvus 等强大的矢量数据库集成,即使处理数百万个文档,也能快速准确地搜索和检索。

5. 生成式 AI 集成:

Haystack 与 GPT-3 和 BART 等流行的生成模型无缝集成。这允许用户利用这些模型的强大功能,在基于 Haystack 构建的应用程序中执行文本生成、摘要和翻译等任务。

虽然 Haystack 的重点不仅仅放在生成式 AI 上,但它为构建利用这项技术的应用程序提供了坚实的基础。它在检索、多样化的 NLP 组件、灵活性和可扩展性方面的综合优势使其成为开发人员和研究人员探索生成式 AI 在各种应用中的潜力的宝贵框架。

总之,生成式人工智能的格局正在迅速发展,HuggingFace、LangChain、LlamaIndex、Llama2、Haystack和SingleStore Notebooks等框架和工具处于领先地位。这些技术为开发人员提供了将 AI 集成到其项目中的丰富选择,无论他们从事的是自然语言处理、数据分析还是复杂的 AI 应用程序。

如果你也想成为一名 AI/ML 工程师,那么这份资料一定不要错过:

1:人工智能详细学习路线图

2:Python数据分析与机器学习书(代表作)

3:PyTorch深度学习实战书籍

3:机器学习算法+深度学习神经网络基础教程

4:论文指导,职业规划和技术问题解答

可以关注我的公-众-号【迪哥谈AI】回复333 无偿获取