- 1iOS开发进阶(一):iOS原生开发环境搭建步骤详解_ios编译环境搭建

- 2昇思25天学习打卡营第13天 | LLM原理和实践:文本解码原理--以MindNLP为例_自回归按照概率下一个词的

- 3Hive---拉链表_hive拉链表

- 4hadoop3.0高可用分布式集群安装_hadoop3.0高可用集群搭建

- 5Git与GitHub之本地仓库_git本地仓库是哪个盘

- 6OPENWRT路由配置IPV6公网访问_ipv6访问路由器

- 7STM32f103入门(12)USART串口信息发送+接收_stm32f103串口接收字符串

- 8Web3.js与智能合约交互_web3 .send写法

- 9Neuralink 将启动第二例人类脑机芯片植入;多项 Claude 3.5 Sonnet AI 工具发布丨RTE 开发者日报

- 10安全加固----二、Tomcat服务安全加固_等保三级tomcat

警惕:与ChatGPT共享业务数据可能十分危险

赞

踩

您已经在使用ChatGPT了吗?或者您正在考虑使用它来简化操作或改善客户服务?虽然ChatGPT提供了许多好处,但重要的是,您要意识到与ChatGPT这样的人工智能工具共享敏感业务数据相关的安全风险。下面,我们概述了一些关键问题,并就如何降低与ChatGPT共享公司数据的风险提供了建议。

ChatGPT不存储用户的输入数据,是吗?

聊天机器人从用户输入中记忆和学习的影响可能是深远的:想象一下,您正在做一场内部演示,其中包含了新的企业数据,揭示了一个将在董事会会议上讨论的企业问题。将这些专有信息泄露出去可能会损害股价、消费者态度和客户信心。更糟糕的是,议程上的法律事项被泄露可能会使公司承担真正的责任。但是,仅仅把这些东西输入聊天机器人中,这些事情真的会发生吗?

研究公司Cyberhaven于今年2月就这一问题进行了深入探索,结果指出,如果第三方根据该高管提供的信息向ChatGPT询问某些问题,那么输入ChatGPT的机密数据可能会被泄露给第三方。

英国国家网络安全中心(NCSC)在3月份分享了对此事的进一步见解,指出ChatGPT和其他大型语言模型(LLM)目前不会自动将信息从查询添加到模型中供其他人查询。也就是说,在查询中包含信息不会导致潜在的私有数据被合并到LLM中。然而,提供LLM的组织(就ChatGPT而言,指的是OpenAI)将能看到查询。

这些查询会被存储起来,几乎肯定会在某个时候用于开发和训练LLM服务或模型。这可能意味着LLM提供商(或其合作伙伴/承包商)能够读取查询,并可能以某种方式将它们合并到未来的版本中。

2021年6月,来自苹果、斯坦福大学、谷歌、哈佛大学等的研究人员发表了一篇论文,揭示了类似于ChatGPT的语言学习模型GPT-2可以准确地从训练文档中回忆起敏感信息。

报告发现,GPT-2可以调用具有特定个人标识符的信息,重新创建精确的文本序列,并在提示时提供其他敏感信息。这些“训练数据提取攻击”可能会对机器学习模型研究人员的安全构成越来越大的威胁,因为黑客可能能够访问机器学习研究人员的数据并窃取他们受保护的知识产权。

总而言之,我们有理由担忧与ChatGPT共享敏感业务数据会威胁企业安全,并造成无法挽回的后果。

与ChatGPT共享敏感数据的风险

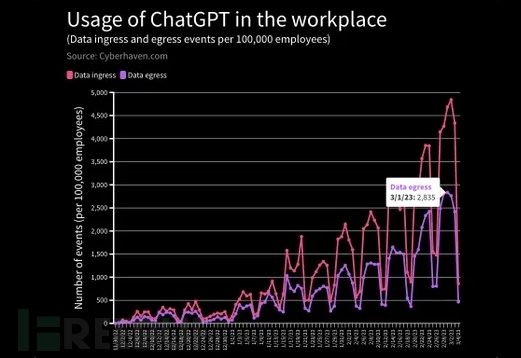

据数据安全公司Cyberhaven发布的统计数据显示,平均每家公司每周会向ChatGPT发布数百次敏感数据,涉及客户或患者信息、源代码、机密数据和监管信息等等,这些请求引起了严重的网络安全问题。

【ChatGPT在工作场所使用情况】

对于组织来说,理解并缓解与ChatGPT共享敏感数据的风险,以保护其资产、维护客户信任并遵守法规要求是至关重要的。具体来说,这些风险涵盖以下几点:

1. 数据隐私和保密风险

优先考虑公司敏感信息的隐私和机密性是至关重要的。请注意,当您使用ChatGPT时,实际上是在与外部实体共享组织数据。人工智能模型处理这些数据以生成所需的输出,这可能导致意外地将敏感信息暴露给第三方。

您可以始终决定不允许ChatGPT将企业数据用于培训目的。然而,即使在这种情况下,您与ChatGPT分享的任何公司数据都将通过互联网发送,并可能存储在某个地方进行处理,以便回答您的问题。

在将业务数据输入ChatGPT之前,请确保您了解人工智能提供商的数据存储、使用和保留策略,并实施强大的数据保护措施。

2. 知识产权风险

当与ChatGPT共享信息时,企业的知识产权(IP)可能会无意泄露。为了减轻这种风险,请避免与人工智能工具共享专有数据、商业机密或版权材料。最近的一个突出案例是三星员工在ChatGPT中无意泄露了公司的秘密。

3. 数据合规风险

许多国家都有数据保护法规,例如欧盟的《通用数据保护条例(GDPR)》和《加州消费者隐私法案》(CCPA)。这些法案管理企业如何收集、存储和处理个人信息。如果您在ChatGPT中无意地分享了个人数据,可能会让企业暴露于合规风险上。

缓解建议

制定使用政策

ChatGPT的使用和可访问性可以是一把双刃剑,因为它增加了员工滥用或滥用的风险。此外,员工也可能会被诱惑使用人工智能工具来实现非相关的目的。为了解决这些问题,必须建立清晰的使用策略和指导方针,详细规定在使用ChatGPT时可接受和不可接受的行为。

去年年初以来,在发现ChatGPT生成的文本中有疑似商业机密的情况后,不少科技巨头已经开始提醒自己的员工不要在使用ChatGPT时输入敏感信息数据。无独有偶,微软也曾表示,只要员工不与ChatGPT分享机密信息,就可以在工作时使用。

教育员工相关风险

人员始终是攻击链中最薄弱的环节,因此对员工进行教育和培训同样至关重要。组织必须确保他们了解负责任地使用ChatGPT以及滥用ChatGPT的潜在后果。这包括让他们意识到数据隐私问题、知识产权风险和合规要求。

利用先进技术

识别和控制员工提交给ChatGPT的数据并非没有挑战。当员工在ChatGPT中输入公司数据时,他们不是上传文件,而是将内容复制粘贴到他们的网络浏览器中。许多安全产品都是围绕保护文件(被标记为机密)不被上传而设计的,但一旦内容从文件中复制出来,他们将无法跟踪它。

为了提高可见性,组织应该在其安全web网关(SWG)上实施策略,以识别人工智能工具的使用,还可以应用数据丢失预防(DLP)策略来识别哪些数据被提交给这些工具。

结语

虽然ChatGPT提供了非凡的功能,但理解和管理相关的安全风险是至关重要的。通过实施强有力的数据保护措施,遵守数据保护法规,保护知识产权和监控员工使用,组织可以最大限度地降低这些风险,并利用ChatGPT的力量推动业务向前发展。

原文链接:

Are you sharing company data with ChatGPT? - Endare

Sharing sensitive business data with ChatGPT could be risky | CSO Online