- 1Tiny CC 发挥 C 语言的威力 之一:介绍

- 2JAVA 基于模板生成 Word 文件_java根据word模板生成word文档

- 3AI 时代,网关更能打了?_ai网关

- 4生成式人工智能 (Generative AI)

- 5比 Elasticsearch 更快 RediSearch + RedisJSON = 王炸_redis存json对象性能怎么样

- 6C语言-使用指针数组作为函数参数,实现对10个字符串进行排序

- 7推荐一款强大的游戏开发框架:Phaser 3 TypeScript 项目模板

- 8C++入门学习

- 9【分布式】Pytorch分布式训练原理和实战_pytorch采用horovod分布式

- 10【淘宝技术这十年】,读后总结篇

带你快速了解大模型微调原理_什么是大模型微调

赞

踩

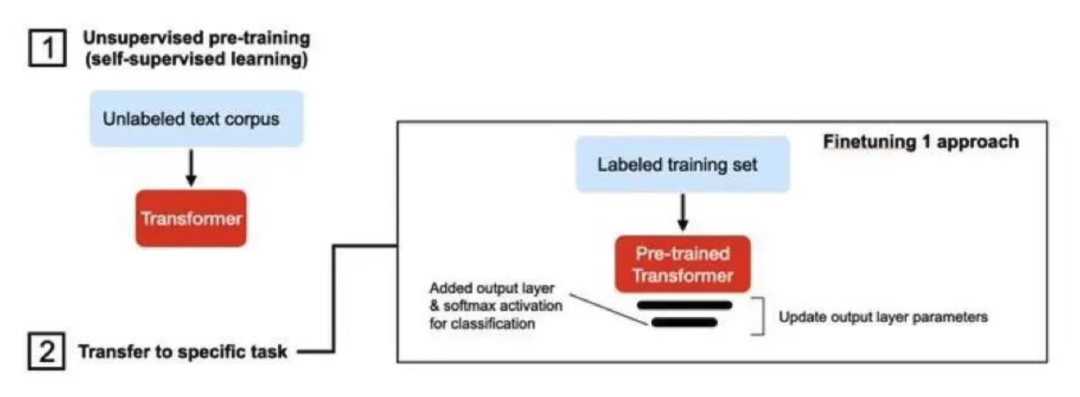

大模型微调(Fine-tuning)是指在已经预训练好的大型深度学习模型基础上,使用新的、特定任务相关的数据集对模型进行进一步训练的过程。这种微调技术的主要目的是使模型能够适应新的、具体的任务或领域,而无需从头开始训练一个全新的模型。以下是大模型微调的一些关键点和详细解释。

01

定义与背景

定义:大模型微调是指利用预训练模型(这些模型通常在大规模数据集上进行训练,如BERT、GPT等)的权重和特征,通过在新任务数据集上的训练,对模型进行适应性和优化调整。

背景:随着深度学习技术的不断发展,大型预训练模型在各个领域取得了显著成效。然而,这些模型往往过于庞大,难以直接应用于特定任务。因此,微调技术应运而生,成为连接预训练模型与实际应用场景的重要桥梁。

02

微调过程

大模型微调的过程通常包括以下几个步骤:

-

选择预训练模型:首先,根据任务需求和模型特性,选择一个合适的预训练模型作为起点。这些模型通常在大规模数据集上进行训练,具有强大的特征提取和泛化能力。

-

准备新任务数据集:收集并准备与新任务相关的数据集。这些数据集将用于对预训练模型进行微调训练。

-

设置微调参数:根据任务特性和模型要求,设置合适的微调参数,如学习率、批处理大小、训练轮数等。

-

进行微调训练:使用新任务数据集对预训练模型进行微调训练。在训练过程中,模型将学习新任务的特征和规律,并逐步调整其权重和参数以适应新任务。

-

模型评估与调优:在微调训练过程中和结束后,使用验证集对模型进行评估和调优。根据评估结果调整微调参数或训练策略以提高模型性能。

03

微调方法

大模型微调有多种方法,其中一些常见的方法包括:

-

全量微调(Full Fine Tuning, FFT):对预训练模型的所有参数进行训练以适应新任务。这种方法虽然效果显著但计算成本较高且可能导致灾难性遗忘问题(即模型在新任务上表现良好但在原任务上性能下降)。

-

参数高效微调(Parameter-Efficient Fine Tuning, PEFT):仅对预训练模型的部分参数进行训练以适应新任务。这种方法计算成本较低且能够保持模型在原任务上的性能。常见的PEFT方法包括Prefix Tuning、Prompt Tuning等。

04

应用场景

大模型微调技术在自然语言处理(NLP)、计算机视觉(CV)等多个领域具有广泛应用。例如:

1. 在NLP领域,可以使用BERT等预训练模型进行情感分析、文本分类等任务的微调。

2. 在CV领域,可以使用ResNet等预训练模型进行图像分类、目标检测等任务的微调。

05

总结

大模型微调是一种有效的深度学习技术,它能够在保持预训练模型强大特征提取能力的同时,使模型适应新的具体任务或领域。通过选择合适的预训练模型、准备新任务数据集、设置微调参数以及采用合适的微调方法,可以实现模型性能的显著提升。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。