热门标签

热门文章

- 1java实现微信订阅功能记录_java 微信用户订阅公众号消息

- 2【自然语言处理】中文开源工具汇总(7种)_opennlp 中文语料库

- 3导出 Whisper 模型到 ONNX_whisper large-v2 onnx

- 4聚类算法之LDA_lda困惑度一直上升

- 5SQLServer2022新特性Window子句_sqlserver2022xin特性

- 6ModuleNotFoundError: No module named '_sqlite3'_error: cannot find module 'sqlite3

- 7php小h站视频系统源码,苹果cms v10x 原创自适应x站h站源码 视频模板 带试看功能 带自动采集YM源码...

- 8【回眸】ChatGPT Plus 测评体验

- 9【Java】JS简介_java js

- 10Pikachu靶场全级别通关教程详解_pikachu使用教程

当前位置: article > 正文

chatglm3-6B本地部署_本地部署chatglm3-6b

作者:正经夜光杯 | 2024-06-22 14:06:47

赞

踩

本地部署chatglm3-6b

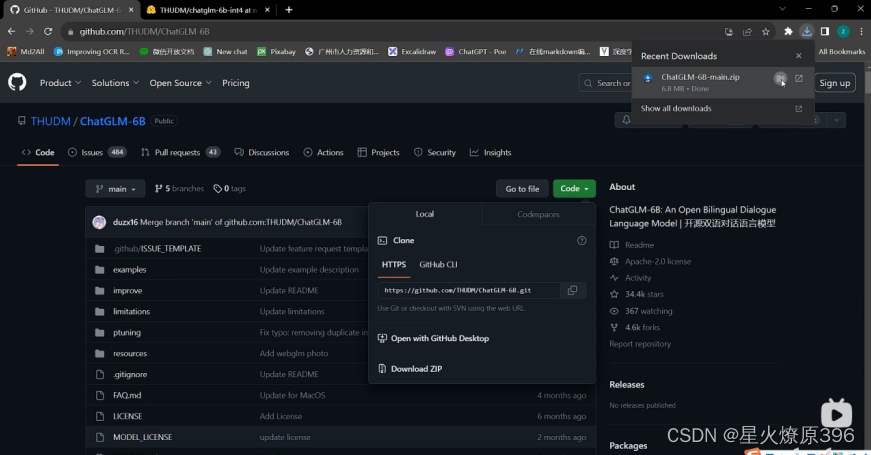

ChatGLM github地址:https://github.com/THUDM/ChatGLM-6B

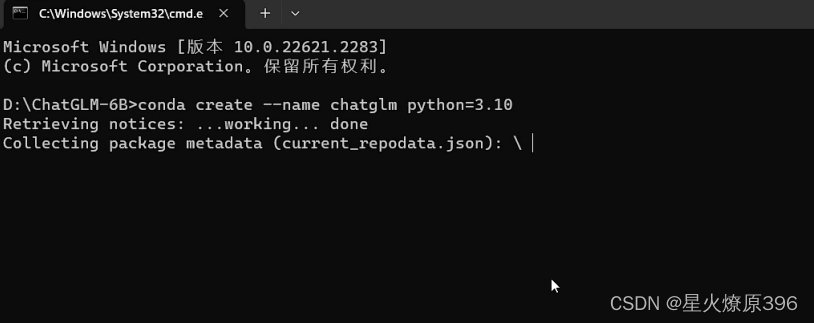

在此文件夹下cmd,创建一个专门独立的虚拟环境(部署要求较高,需要运存6G,python建议3.10及以上,transformers 库版本推荐为 4.30.2,torch 推荐使用 2.0 及以上的版本)

在此文件夹下cmd,创建一个专门独立的虚拟环境(部署要求较高,需要运存6G,python建议3.10及以上,transformers 库版本推荐为 4.30.2,torch 推荐使用 2.0 及以上的版本)

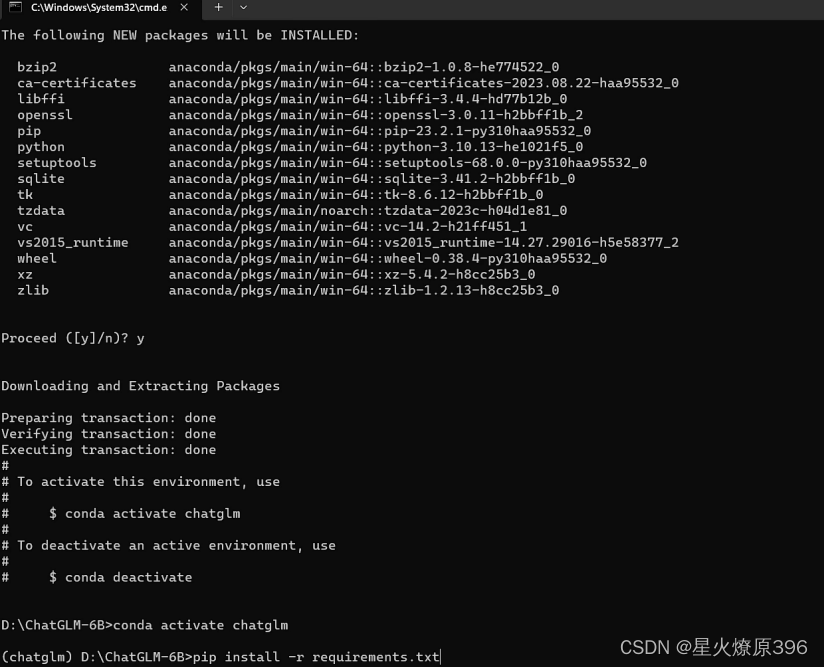

从文本读取安装环境依赖,假设环境名为

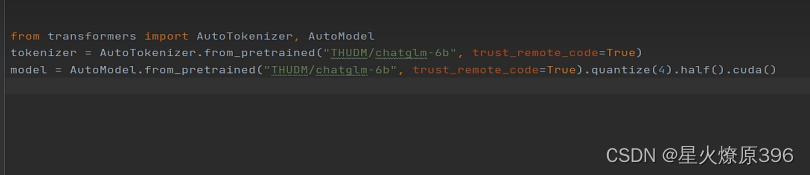

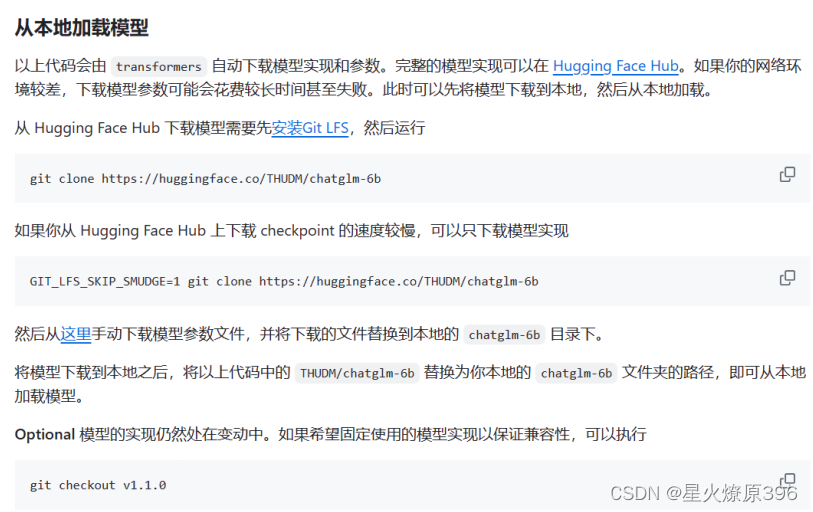

然后下载模型,可以通过transform,通过python运行下述代码

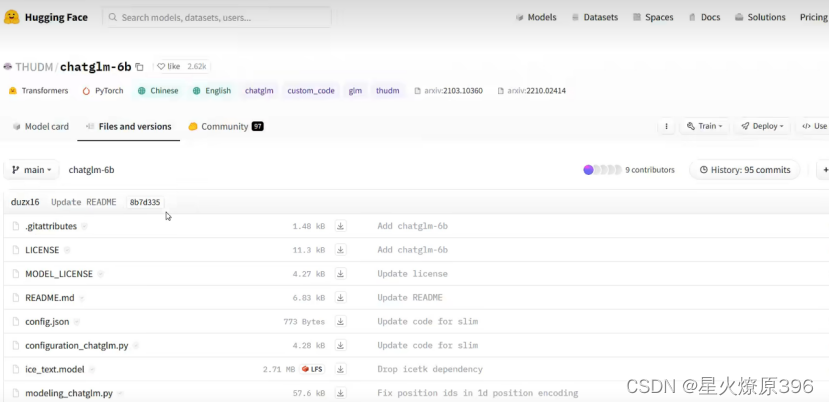

或者通过网站直接下载

ChatGLM huggingface地址:https://huggingface.co/THUDM/chatglm-6b

(全下就行)

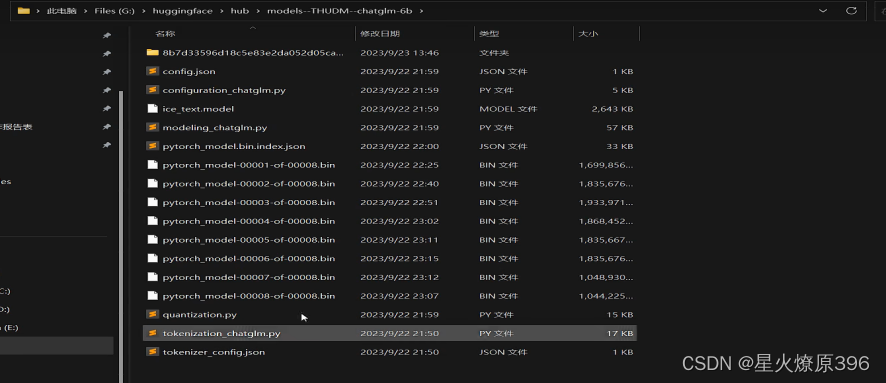

把文件放到一个指定位置就行

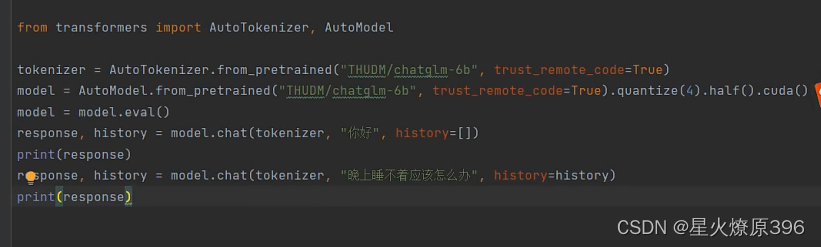

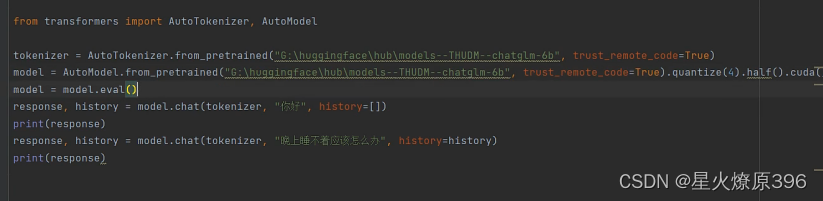

运行下述代码测试即可quantize(4)是量化运行小精度,占用内存更小,改为8也可以

如果是手动下载需要改一下路径,依你存模型的路径而定,如下图

包括回应和历史对话,可以提前写几条history来给模型添加前置条件,让模型进行角色扮演。History的编写形式:

测试成功即完成部署。

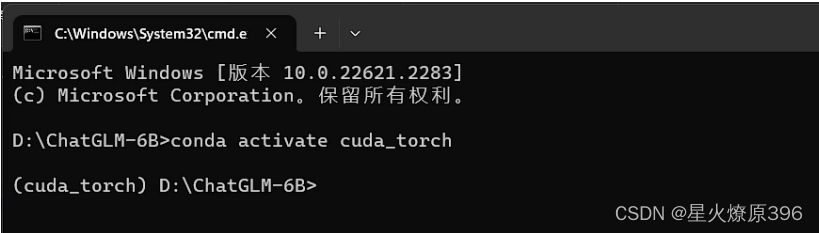

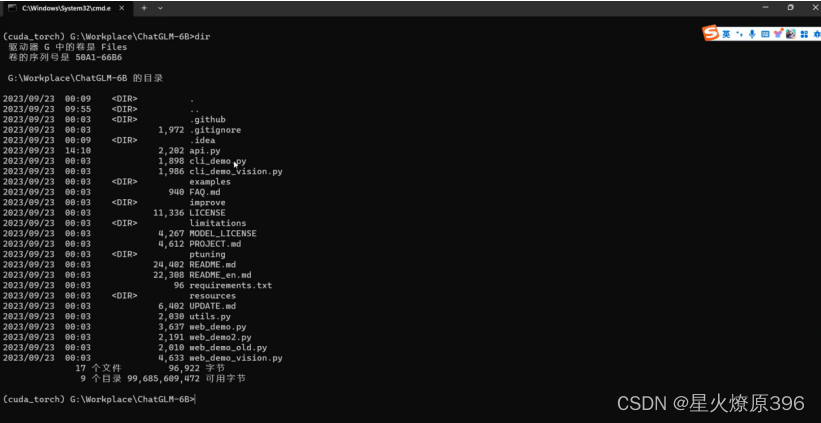

获取模型的api,进入环境输入dir查看到api.py。

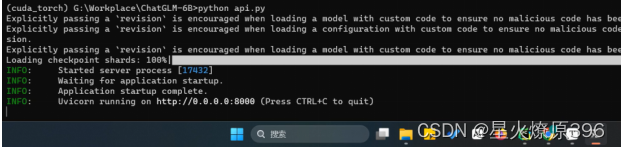

然后运行python api.py,加载模型并开放一个api接口

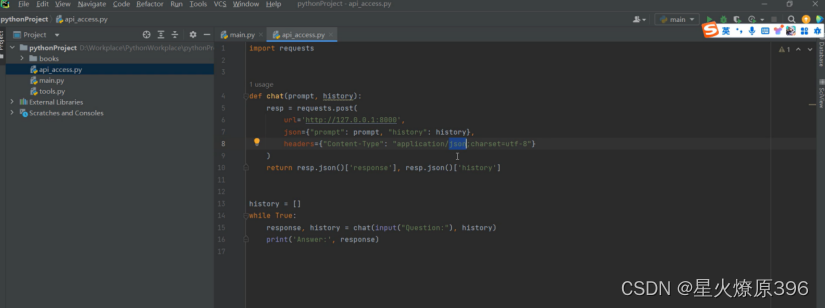

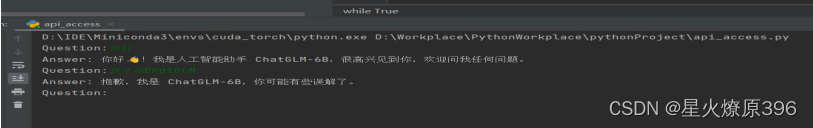

写下述代码运行,发送post请求,将url改为本地端口,运行代码进行测试,question:后面输入提问,

测试如下

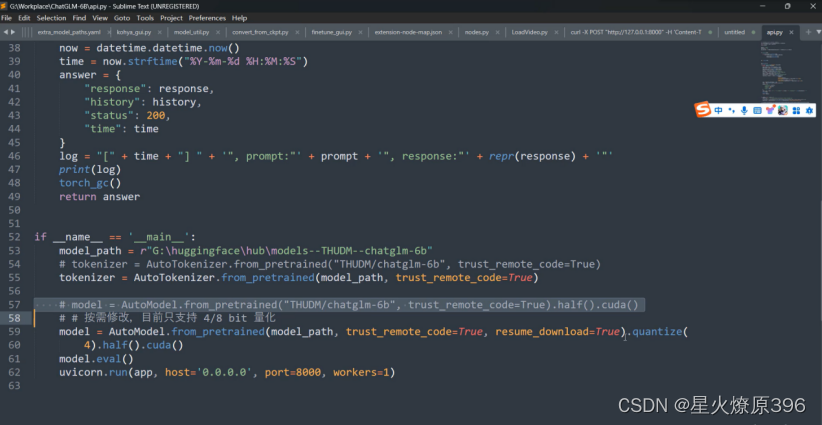

然后进行在langchain中接入大模型,先在下载的chatglm里面找到api.py,修改路径地址path为后下载huggingface的地址,并按需修改量化模式,具体如下

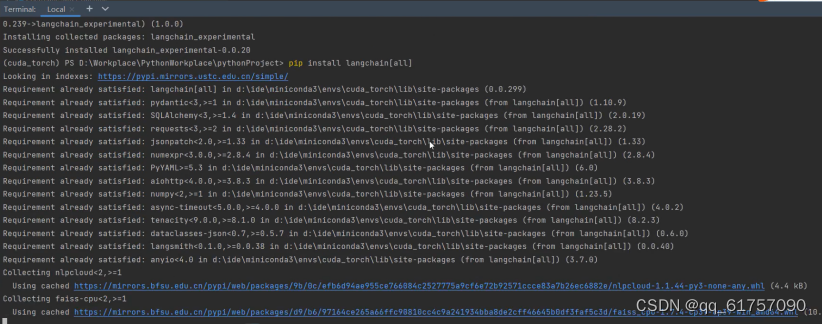

然后下载langchain,(虚拟环境中直接pip,指令如下)

进行以下代码,在langchain中接入模型

实现:

- 学会chatglm本地部署,写成手册

- 实现本地模型的api调用

- 实现在langchain中接入大模型

问题:

- 关于解决langchain给chatglm的问题是英文输入,而用户提问问题一般都中文的,如何解决,(包括统一问答语言提高准确性,模型给出问题中英文混杂的问题)

解答:

关于chatglm和 Hugging Face Hub的分别

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/正经夜光杯/article/detail/746724

推荐阅读

相关标签