- 1搞懂JDK8与Java1.8的区别_jdk18就是jdk1.8吗

- 2网络安全的基本知识_csdn 网络安全

- 3如何正确地配置Gradle版本_gradle已有为什么还要下载

- 4IDEA 2023.2 配置 JavaWeb 工程_idea2023.2配置

- 5C++:在“替代”中迎来“转机”的 2022 年!_c++23发布时间

- 6Git教程使用系列(一):认识工作区,暂存区,本地仓库,远程仓库_工作区和本地仓库的区别

- 7数学建模学习(1)遗传算法

- 8wireshark抓包分析聊天程序聊天记录_抓包能抓到聊天记录吗

- 9Git如何将pre-commit也提交到仓库_git pre-commit如何提交

- 10Linux ----用户管理_5、以root身份登录,在根目录下,创建一个目录newtest,并在该目录下新建一个文件及

【大模型应用篇6】私有化智能体平台,为了数据更安全........_dify和coze

赞

踩

之前《【大模型应用篇4】普通人构建智能体的工具》介绍了普通人(包括没有任何计算)可以使用工具构建智能体, 并在《【大模型应用篇5】应对裁员潮,突发奇想,打造“收割offer”智能体…》文章中实现了一个“offer收割”的智能体, 这种方式虽然具有上手快、成本低等优点,但是也带来数据安全性、平台依赖性等问题, 大部分有能力、有资源的公司还是会选择私有化部署智能体平台, 今天就带领大家了解一下,哪些开源,可以私有化部署的智能体平台.

友情提示, 今天所介绍的工具,如果大家想私有化部署,需要具备一定计算机背景和计算资源, 关于计算资源, 如果想纯粹感受一下不考虑用户使用量,可以参考一下《【小白入门篇5】哪些免费GPU羊毛可以薅?》,使用一些免费GPU资源,练练手.

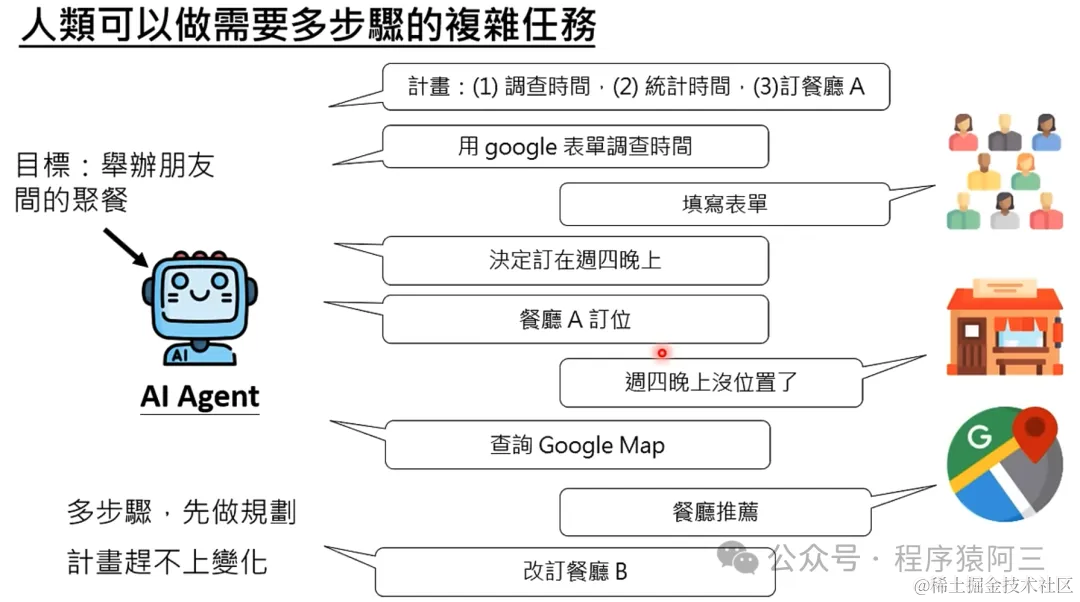

为了避免大家对智能体(AI-Agent)理解不一致,我这里所说的智能体就是能够完成复杂的任务,制定计划,修改计划.

01 原生智能体开发框架

名称 | 地址 | 说明 |

langchain | https://python.langchain.com/docs/get_started/introduction/ | 一个开发基于语言模型的应用程序和智能体的框架,旨在简化语言模型的应用开发流程。 |

autoGPT | https://github.com/Significant-Gravitas/AutoGPT | 提供了一套工具,帮助开发者构建 AI 智能体,简化了AI智能体的开发工作。 |

Langroid | https://github.com/langroid/langroid | 通过多智能体编程,将智能体作为核心组件,通过消息交互协作完成任务,简化了大语言模型应用的构建过程。 |

AutoGen | https://microsoft.github.io/autogen/docs/Getting-Started | 一个使多个智能体能够交流协作解决问题的大语言模型应用开发框架,推动了智能体之间的对话和任务解决能力。 |

OpenAgents | https://github.com/xlang-ai/OpenAgents | 一个开放的平台,用于在实际环境中使用和托管语言智能体,促进了语言智能体的广泛应用。 |

gpt-engineer | https://github.com/gpt-engineer-org/gpt-engineer | 专注于自动化代码生成以辅助完成开发任务,简化了编程工作。 |

MetaGPT | https://github.com/geekan/MetaGPT | MetaGPT,这是一种多代理框架,它通过将包含现实世界专业知识的 SOP 编码到 LLM 代理中来扩展复杂问题的解决能力,实验表明,与现有方法相比,它可以生成更一致、更全面的解决方案 |

.... | ....... | ...... |

类似的原生的开发框架还有很多,大家可以挑选一些开源生态强大的框架研究部署即可, 同时也有一些人基于以上一些框架开发一些产品.

02 二次开发的产品

名称 | 地址 | 说明 |

dify | https://dify.ai/ | Dify 是一个开源的 LLM 应用开发平台。其直观的界面结合了 AI 工作流、RAG 管道、Agent、模型管理、可观测性功能等,让您可以快速从原型到生产。 |

Langchain-Chatchat | https://github.com/chatchat-space/Langchain-Chatchat | 一种利用 langchain 思想实现的基于本地知识库的问答应用,目标期望建立一套对中文场景与开源模型支持友好、可离线运行的知识库问答解决方案。0.3.x版本支持agent方式 |

ChatDev | https://github.com/OpenBMB/ChatDev | ChatDev是一个多代理人的组织结构,以“通过编程彻底改变数字世界”为使命,将代理们团结在一起。ChatDev中的代理通过参加专门的功能研讨会进行协作,完成设计、编码、测试和文档编制等任务。 |

...... | ....... | ........ |

网上还有很多开源的智能体二次开发的产品, 大家如果有更好的产品,可以在留言区评论

03 智能体的挑战

虽然我们理想很丰满,但是现阶段智能体处于初级发展阶段, 智能体依然存在一些挑战

(1) 大模型随机性: 我们在《【小白入门篇1】GPT到底是怎样练成?》知道,大模型每次回答都具有随机性, AI-agent完成人类复杂任务时候,有时候会出现不按照人类预想的方向完成。

(2)长期规划与有限上下文长度:基于长时间历史的规划是一大挑战,可能导致错误累积,智能体难以自我纠错。同时,LLM 支持的上下文长度有限,这可能制约智能体的功能,比如限制其利用短期记忆的能力。

(3) 提示的稳定性与可靠性:LLM 智能体可能涉及设计多个提示来支持不同功能模块,如记忆和规划,而对提示微小变化的高敏感度常导致可靠性问题。整个提示框架的设计使其更易受到稳定性问题的影响。可能的解决办法包括通过反复试验来设计提示元素、自动优化或调整提示,或利用 GPT 自动生成提示。另一个常见问题是“语言幻觉”,LLM 智能体依赖自然语言与外部组件交互,可能因为接收到的冲突信息而产生信息准确性问题。

(4) 效率和资源挑战: 大模型推理依赖GPU资源, 特别是面对用户量庞大的系统, 推理所需的GPU资源,这可能影响其行动的效率,因其高度依赖于 LLM 的推理速度。同时,在部署多个智能体时,成本也成为了一个需要考虑的因素。

04 总结

上述介绍了这么多平台,关于平台选型问题, 主要还是看大家实际的诉求, 比如你们希望在公司打造一个类似coze的平台, 让业务人员也能构建智能体, 那就选择dify,他有很好的用户交互的界面,方便普通用户使用, 如果只是构建一个强大、定制的智能体,那就考虑langchain+langflow, 这些仅仅是我个人的观点,如有更好的建议,欢迎评论区留言交流

感谢您完成阅读

推荐阅读: