热门标签

热门文章

- 1如何使用git上传本地代码到码云上(超详细的呦)_本地的代码仓库如何跟码云同步

- 2经典算法题汇总

- 3机器学习(五)Python+OpenCV+dlib实现人脸识别_python人脸识别门禁系统 opencv+dlib

- 4理论+实验:MySQL数据库基本概念和介绍_mysql的理论和实验的联系

- 5LeetCode70爬楼梯_line 8: char 16: runtime error: index -2 out of bo

- 6在图像中隐藏数据:用 Python 来实现图像隐写术_hugo隐写算法python实现

- 7leetocde662. 二叉树最大宽度,面试必刷题,思路清晰,分点解析,附代码详解带你完全弄懂

- 8Vue 实现电子签名_vue实现电子签名

- 9了解和使用 Docker 镜像仓库_docker 镜像库

- 10关系型数据库学习手记——初见倾心PostgreSQL、MySQL、SQLite、MongoDB_在 postgresql (pg) 中实现动态哈希分表

当前位置: article > 正文

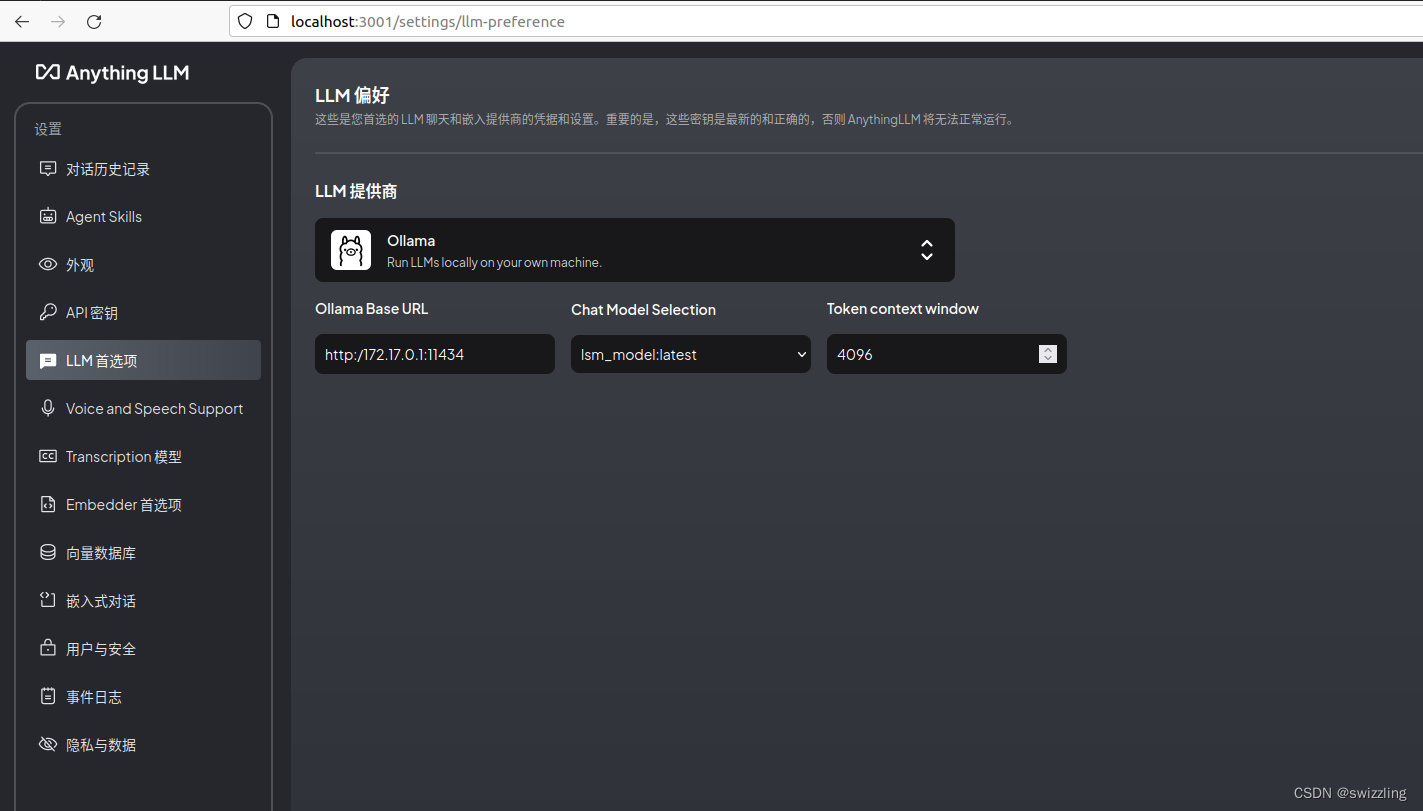

anythingllm无法识别ollama_anythingllm 没有ollama的模型

作者:正经夜光杯 | 2024-07-27 20:39:18

赞

踩

anythingllm 没有ollama的模型

linux下ollama base url和设置为以下三种都不行

http://127.0.0.1:11434

host.docker.internal:11434

localhost:11434

Chat Model Selection和Embedding Model Selection都无法识别读取

需要修改为

http:/172.17.0.1:11434即可正确识别

声明:本文内容由网友自发贡献,转载请注明出处:【wpsshop博客】

推荐阅读

相关标签