热门标签

热门文章

- 1让Ollama大模型联网:详细步骤与实例_ollama 配置

- 2【EI会议征稿通知】第三届电气工程与自动控制国际学术会议(EEAC 2024)_2024电气领域会议

- 3redisson解决redis服务器的主从一致性问题_redisson 读写都是走主库吗

- 4Flutter和ReactNative技术优劣分析对比_reactnative和flutter哪个性能好

- 5Docker Hub 国内镜像源配置_dockerhub国内镜像

- 6猫头虎分享已解决Bug || Error: CrashLoopBackOff (K8s)_argodb 启动 crashloopback

- 7MySQL架构篇

- 8深度 | IBM长文解读人工智能、机器学习和认知计算

- 9AXI Block RAM 控制器IP核的用法详解_axi bram controller ip

- 10python写的一个王者荣耀刷金币脚本_王者荣耀外挂的代码

当前位置: article > 正文

HADOOP伪分布式安装步骤_hadoop伪分布式环境安装

作者:煮酒与君饮 | 2024-07-18 03:20:34

赞

踩

hadoop伪分布式环境安装

HADOOP安装步骤

一.创建Hadoop用户

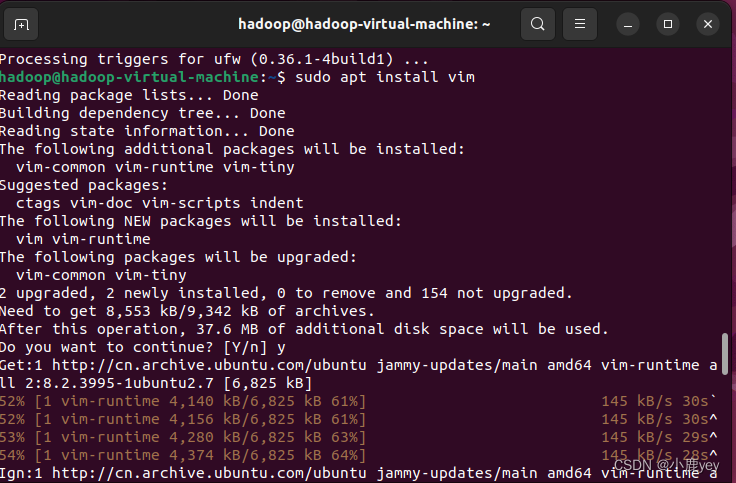

二.更新apt和安装vim编辑器

更新apt:

sudo apt-get install update

- 1

安装VIM编辑器:

apt install vim

- 1

在弹出的提示中输入yes(y)

三、安装SSH和配置SSH无密码登录

apt install openssh-server

- 1

ssh登录:

ssh localhost

- 1

退出ssh登录:

exit

- 1

ssh无密码登录配置:

cd ~/.ssh/

ssh-keygen -t rsa

cat ./id_rsa.pub >> ./authorized_keys

- 1

- 2

- 3

四、安装vim编辑器

sudo apt install vim

- 1

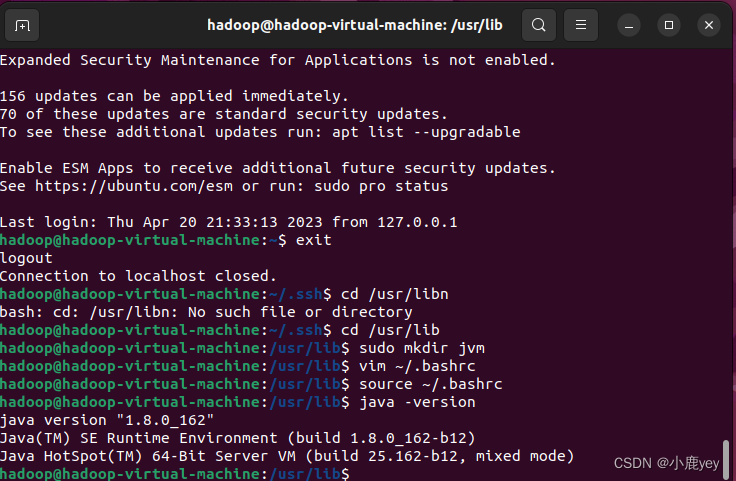

五、安装Java环境

cd /usr/lib

sudo mkdir jvm

- 1

- 2

进入jdk的存放目录:

sudo tar -zxvf (安装包) -C /usr/lib/jvm

- 1

设置环境变量:

vim ~/.bashrc

- 1

在文件开头添加:

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_162

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

- 1

- 2

- 3

- 4

- 5

保存.bashrc文件并退出vim编辑器。然后,继续执行如下命令让.bashrc文件的配置立即生效:

source ~/.bashrc

- 1

查看配置是否生效:

java -version

- 1

返回以下信息即为成功:

java version "1.8.0_162"

Java(TM) SE Runtime Environment (build 1.8.0_162-b12)

Java HotSpot(TM) 64-Bit Server VM (build 25.162-b12, mixed mode)

- 1

- 2

- 3

- 4

六、安装hadoop

在安装包所在目录打开终端,解压安装包:

sudo tar -zxvf hadoop-3.1.3.tar.gz -C /usr/local

cd /usr/local

sudo mv ./hadoop-3.1.3/ ./hadoop # 将文件夹名改为hadoop

sudo chown -R hadoop ./hadoop # 修改文件权限

- 1

- 2

- 3

- 4

- 5

检查 Hadoop:

cd /usr/local/hadoop

./bin/hadoop version

- 1

- 2

- 3

安装成功输出以下内容:

Hadoop 3.1.3

Source code repository https://gitbox.apache.org/repos/asf/hadoop.git -r ba631c436b806728f8ec2f54ab1e289526c90579

Compiled by ztang on 2019-09-12T02:47Z

Compiled with protoc 2.5.0

From source with checksum ec785077c385118ac91aadde5ec9799

This command was run using /usr/local/hadoop/share/hadoop/common/hadoop-common-3.1.3.jar

- 1

- 2

- 3

- 4

- 5

- 6

- 7

七、Hadoop伪分布式模式配置

cd ./etc/hadoop

vim core-site.xml

- 1

- 2

在 core-site.xml 中添加如下文件内容:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

编辑完成后,按esc键退出,然后在底部输入 :wq(保存退出)

在hdfs-site-xml文件中输入以下内容:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

保存退出

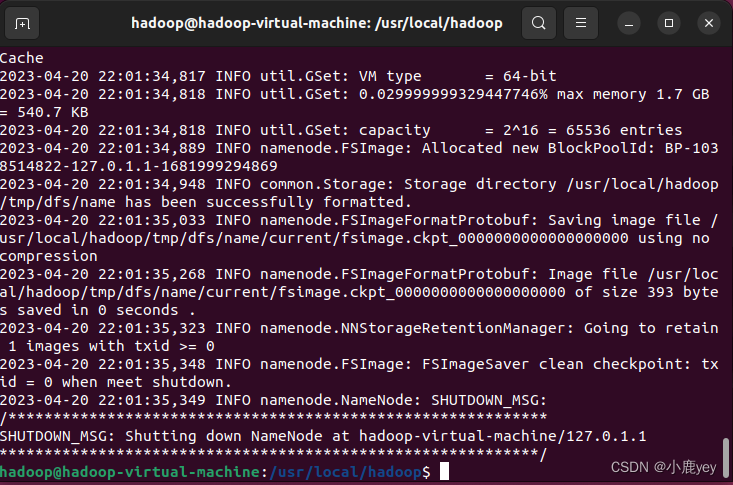

修改配置文件以后,要执行名称节点的格式化,命令如下:

cd /usr/local/hadoop

./bin/hdfs namenode -format

- 1

- 2

成功后输出以下页面:

注意:名称节点不能多次格式化,多次格式化后启动jps时Datanode将不会启动!!!

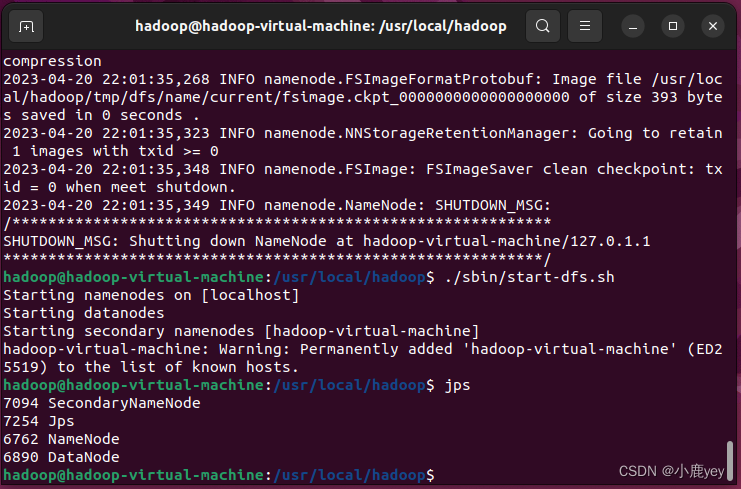

八、伪分布式模式配置

开启 NameNode 和 DataNode 守护进程

cd /usr/local/hadoop

./sbin/start-dfs.sh

- 1

- 2

节点成功开启后显示如下

若要关闭 Hadoop,则运行:

./sbin/stop-dfs.sh

- 1

注意: 下次启动 hadoop 时,无需进行 NameNode 的初始化,只需要运行 ./sbin/start-dfs.sh 就可以!!!

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/煮酒与君饮/article/detail/843366

推荐阅读

相关标签