- 1word-embedding_def forward(self,inp): out = self.fc(inp) return o

- 2如何申请与使用携程API接口_携程api开放平台

- 3手写RPC-令牌桶限流算法实现,以及常见限流算法

- 4单例模式以及线程安全问题_单例模式线程不安全

- 5基于java和百度AI人脸动漫头像生成系统设计与实现_人物头像卡通系统设计与实现

- 6【数据库】 mysql数据库管理工具 Navicat平替工具 免费开源数据库管理工具_navacat平替

- 7营销广告电商行业如何实现降本提效?看这篇就够了!_降低电商营销成本

- 8我开源的H5商城2.0版本发布,强烈推荐_开源的h5移动端商场项目

- 9Langflow系列教程之 09 快速搭建AI 文档质量检查,从本地内存加载的文档构建问答聊天机器人(教程含源码)_langflow 本地运行源码

- 10基于java swing和mysql实现的学生选课成绩信息管理系统(源码+数据库+ER图文档+运行指导视频)_javaswing+数据库学生管理系统

运行最强开源LLM大模型:Llama3 70B,只需一个4GB GPU!_airllm

赞

踩

导读

-

如何使用单4G GPU 运行 LLAMA3 70B

-

为什么接下来半年自己训练大模型创业公司会死一大批

-

数据对大模型的重要性

最强大的开源LLM模型Llama3已经发布,有人问:

AirLLM是否支持在本地用4GB的VRAM运行Llama3 70B?答案是肯定的。

此外,Llama3的性能如何与GPT-4相比?Llama3变得如此强大的关键前沿技术是什么?

Llama3的突破是否意味着开源模型正式开始超越闭源模型?

今天我们也会给出解释。

如何在只有4GB内存的单个GPU上运行Llama3 70B

Llama3的模型架构没有改变,所以:

AirLLM实际上已经自然地支持完美地运行Llama3 70B!它甚至可以在MacBook上运行。

首先,安装AirLLM:

pip install airllm

- 1

然后,你只需要几行代码:

from airllm import AutoModel` `MAX_LENGTH =128` `model = AutoModel.from_pretrained("v2ray/Llama-3-70B")` `input_text = [ ``'中国的首都是哪个城市?'` `]` `input_tokens = model.tokenizer(input_text, `` return_tensors="pt", `` return_attention_mask=False, `` truncation=True, `` max_length=MAX_LENGTH, ``padding=False)` ` `` `` ``generation_output = model.generate( `` input_tokens['input_ids'].cuda(), `` max_new_tokens=20, `` use_cache=True, ``return_dict_in_generate=True)` ` `` `` ``output = model.tokenizer.decode(generation_output.sequences[0])` `print(output)

- 1

请注意:它不适用于实时交互式场景,如聊天,更适用于数据处理和其他离线异步场景。

与GPT4相比效果如何?

根据官方评估数据和最新的lmsys排行榜,Llama3 70B非常接近GPT4和Claude3 Opus。

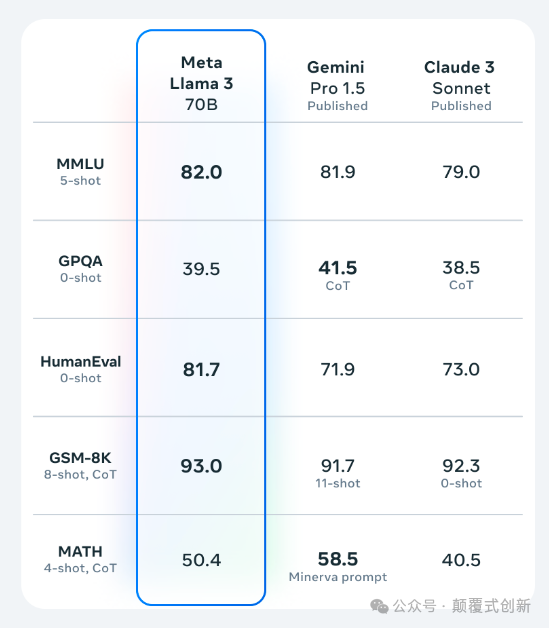

官方评估结果:

lmsys排行榜结果:

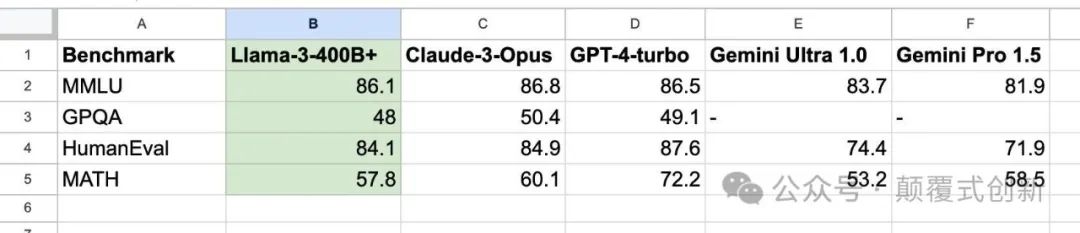

当然,将类似大小的400B模型与GPT4和Claude3 Opus进行比较会更加合理:

Llama3 400B已经非常接近最强版本的GPT4和Claude3,而且它仍在训练中。

Llama3 的核心改进是什么?

Llama3 的架构并没有改变;在训练方法上有一些技术改进,比如基于 DPO 的模型对齐训练。

DPO 已经成为所有排名靠前的大型模型在所有排行榜上的标准训练方法 - 它就是有效!

当然,Llama3 的主要秘密武器在于其训练数据的数量和质量的大幅增加。

从 Llama2 的 2T 增加到了 15T!AI 就是关于数据!

数据的改进不仅仅在于数量,还在于质量。

Meta 进行了大量的数据质量过滤、去重等工作。其中很多工作是基于使用像 Llama2 这样的大型模型来过滤和选择数据。

请注意:这个 15T 是经过严格过滤和清理之后的。在过滤之前,可能超过了 100T。

训练 AI 模型的核心是数据。

要训练一个好的 AI 模型,不是靠很多花哨的训练技巧,而是要扎实而细致地做基础工作。尤其是那些不起眼、肮脏、乏味的数据质量工作 - 这实际上非常重要。

很多人一直高度评价 Meta AI 的能力。从使用Transformer进行区分性 AI 的早期,Meta AI 就以其扎实的数据处理基础而闻名,生产了许多长期领先SOTA的经典模型,比如 Roberta 和 Roberta XLM,这些模型长时间以来一直是我们的首选模型。

Llama3 的成功是否预示着开源模型的崛起??

开源和闭源之间的战斗可能还远未结束。还有很多戏剧性的事情将要发生。

无论是开源还是闭源,训练大型模型已经成为了一场烧钱的游戏。15T 的数据和 400B 的模型并不是小公司可以承担得起的。

在接下来的六个月内,许多致力于大型模型的小公司将会消失。

当谈到烧钱竞争时,真正重要的是长期能力和效率如何将投资变现。

事实上,到目前为止,AI LLMs 的真正商业应用仍然很少。很难说谁能维持他们的投资,以及以何种方式。

从纯技术角度来看,我们一直认为开放的文化对于 AI 是至关重要的。近年来 AI 的快速发展离不开 AI 社区的开放和共享文化。

即使在公司内部也是如此。一个公司能否保持开放和共享的环境,并不断进行透明和开放的思想交流,这对于其 AI 的发展至关重要。

一个对外部世界非常封闭的公司很可能在内部也不够开放和透明,这迟早会阻碍其 AI 技术的快速发展,并阻止其真正建立一流的团队。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/煮酒与君饮/article/detail/847136

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。