- 1面经 | NLP算法岗(百度)

- 2在 PostgreSQL 里如何处理数据的跨库关联查询性能优化?

- 3能“读懂”古文还可反诈骗, 合合信息智能文字识别“黑科技”亮相2022WAIC_合合技术

- 42020多益校招秋招(互联网产品研发工程师)笔试题_多益网络校招笔试题软件工程师

- 5理论1-10_下列函数头,正确的是( )。 分数: 2 a. def f(a = 1, b): b. def f(

- 6创新引领未来,智慧水利在路上:数字孪生技术为水库管理开辟新机遇,带来新挑战,引领水利行业迈向智能化新纪元_水利数字孪生面临的机遇和挑战

- 7cdc捕获数据变更_cdc监控指定字段更新

- 8MISRS C:2004编程规范:——重要知识点_逻辑运算(&&和||)的右操作数不允许包含副作用

- 9C++数据结构——哈希桶HashBucket_c++哈希桶

- 10只需3步,即刻体验Oracle Database 23c

比肩Midjourney-v6!没有GPU也能跑可图Kolors

赞

踩

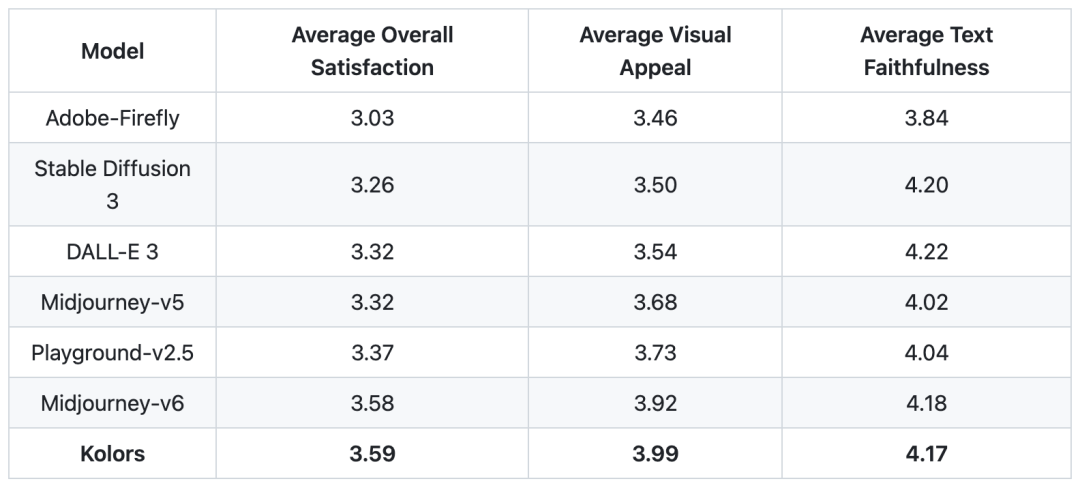

比肩Midjourney-v6,快手的文生图开源模型可图Kolors一发布,开源社区就炸开了锅。短短几天,可图在Github上收获2k Star,Huggingface模型下载热榜第一。

7月6日,快手宣布开源数十亿参数的文生图模型可图Kolors,可图支持中英文双语,支持长达256 token的上下文长度,最重要的是可以渲染中文,生成效果上实现了质的飞跃。

值得一提的是,可图采用了智谱的开源大模型ChatGLM3作为文本编码器,对中文的理解能力远超很多竞品。

国产文生图模型的强势崛起让人振奋,不过,由于硬件等客观条件限制,大多数跃跃欲试的用户却很难在本地部署并体验可图。

首先,可图模型完整下载有28G,下载模型、存放模型比较不方便;其次,可图采用的ChatGLM3代替了传统的CLIP模型做文本提示词嵌入,语义能力增强的同时显存消耗也从原来的几百MB变成十几G,这样,本地显存少于20G的用户,需要用有损量化或者损失推理速度的办法运行可图。

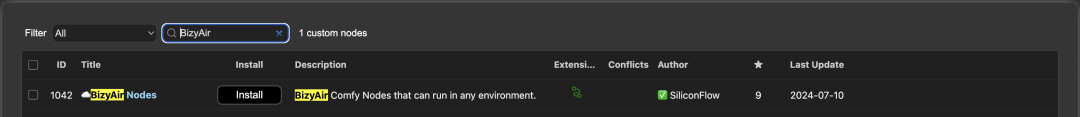

为了让用户无痛使用可图,硅基流动团队开源了BizyAir节点,这是一个专用于ComfyUI的节点仓库,首批节点就有可图Kolors。

现在,没有显卡,不用下载模型,你也能用可图极速生成图片。

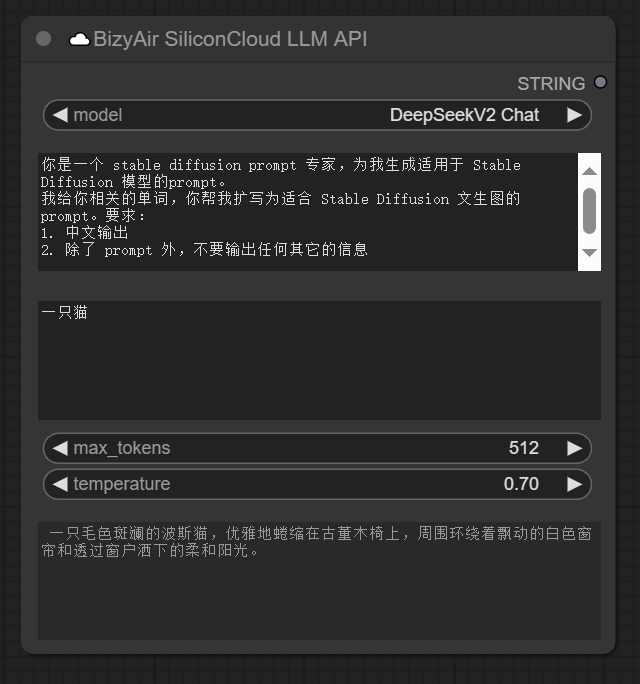

BizyAir还同步上线了一个小惊喜。考虑到写提示词的环节也很费劲,我们开源了SiliconCloud LLM节点,让GLM4、DeepSeek V2 Chat这类顶尖大语言模型接入ComfyUI,帮助你在工作流中生成、提炼提示词。

以DeepSeek V2 Chat为例,如果用它提炼提示词,需要500G左右的硬盘空间和8张A100以上的显卡才能部署这个模型,而SiliconCloud LLM节点直接提供了这个能力。

除了免去了用户搭配环境、模型下载与模型部署的门槛与烦恼。硅基流动还对Kolors节点提供基于专用的图片生成推理引擎OneDiff优化,节约图片生成时间与成本。

当然,你也可以一键无缝接入已有ComfyUI工作流,并可自由与本地节点做平替或组合。

一键直达传送门:

代码:github.com/siliconflow/BizyAir

那么,如何在ComfyUI中使用可图Kolors?

只需两大步。

一、安装BizyAir

在ComfyUI Manager中搜索“BizyAir”即可完成安装。

此外,你还可以通过源码、Comfy-cli安装。Windows新手可以下载独立的压缩包,具体可见:siliconflow.github.io/BizyAir/getting-started/

二、快速开始

-

设置API密钥

首次使用,你需要通过“Set SiliconCloud API Key(设置SiliconCloud API密钥)”来生成API密钥(https://cloud.siliconflow.cn/account/ak)。之后,这个节点就可以删除了。之后重启程序,也不需要重新输入。

-

使用BizyAir节点

所有BizyAir节点都在“☁️BizyAir”目录下。其中“☁️BizyAir SiliconCloud LLM API”节点可以利用大型语言模型帮你精炼提示词、翻译或执行任何其他任务。

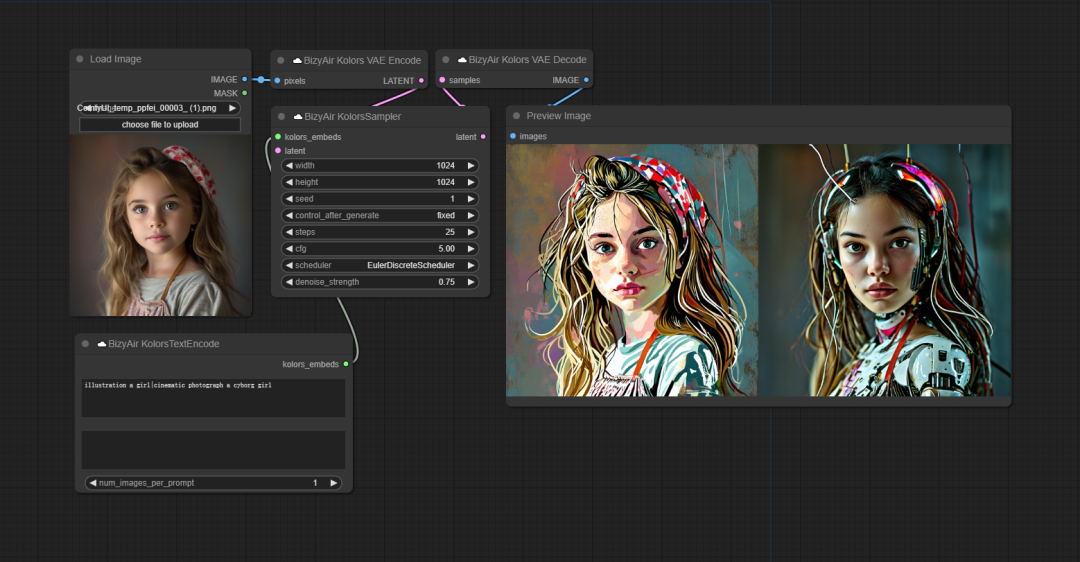

现在,你也可以添加“Kolors”节点快速进行文生图了。目前,BizyAir提供了与Kolors相关的节点,包括Kolors Sampler、Text encoding、VAE decoding、VAE encoding。

当然,图生图也不在话下。

快试试吧:

github.com/siliconflow/BizyAir

其他人都在看

开发生成式AI应用,减少响应时间

就用SiliconCloud