热门标签

热门文章

- 1Python GUI编程:深入探索现代GUI库及其创新应用_python 现代gui

- 2git 轻松上手(四)git stash 的妙用_stash the changes

- 3Android Studio 翻译插件Translation的安装_android studio translation 怎么设置

- 4收集22种开源Vue模板和主题框架「干货」_vue 模板

- 5自然语言处理(NLP)技术的详细介绍_nlp技术

- 62024全网最全网络安全(自学)学习路线!整理了一个月!_网安学习路线

- 7表单自动生成器form-create介绍:可以通过 JSON 生成具有动态渲染、数据收集、验证和提交功能的表单生成器

- 8mac Typora源码修改_typora 源码

- 9零基础学会用Airtest-Selenium对Firefox进行自动化测试_selenium驱动firefox

- 10React-Webpack5-TypeScript打造工程化多页面应用_react多页面应用搭建

当前位置: article > 正文

Ollama&llama_ollama server 模式下,调用ollama 接口

作者:爱喝兽奶帝天荒 | 2024-06-29 06:04:20

赞

踩

ollama server 模式下,调用ollama 接口

Olllama

直接下载ollama程序,安装后可在cmd里直接运行大模型;

llama 3

meta 开源的最新llama大模型;

下载运行

1 ollama

ollama run llama3

2 github

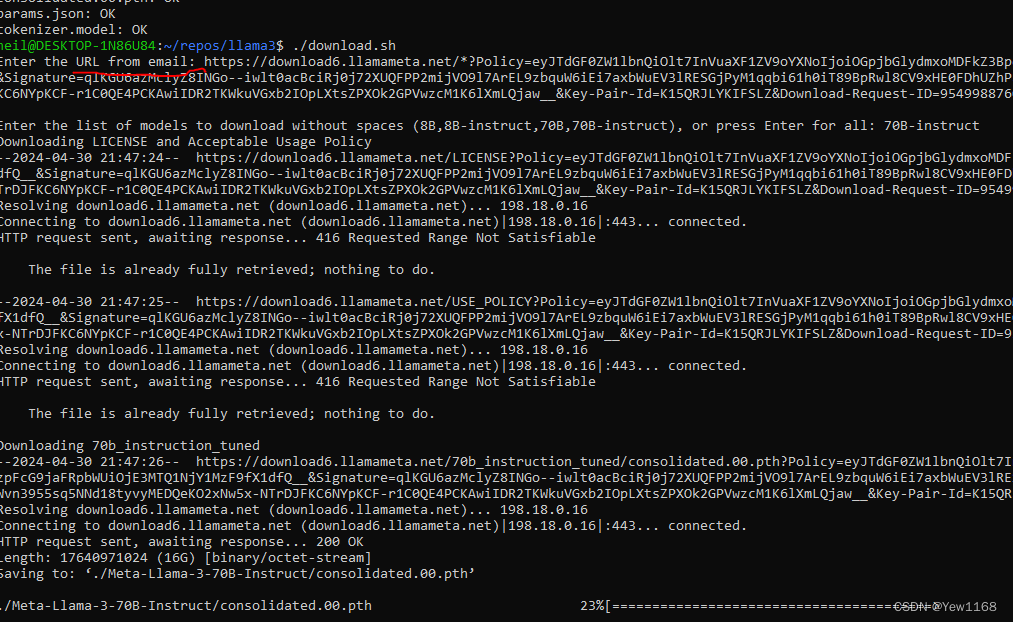

下载仓库,需要linux环境,windows可使用wsl;

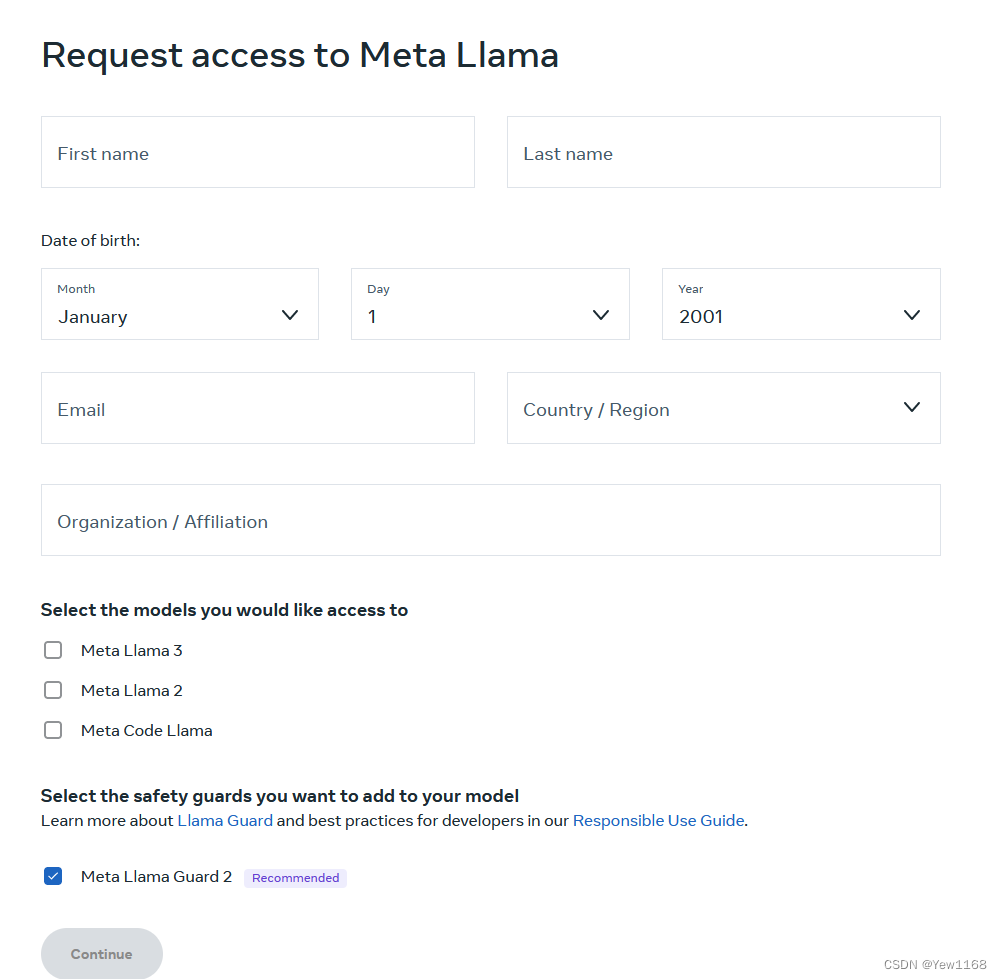

- 接受许可协议。获取下载链接

- 仓库运行download.sh

3.quickstart

3 huggingface

meta

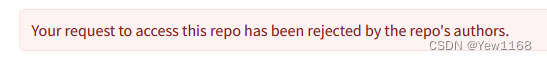

接受协议,访问模型文件,(不知道是不是affiliation填none被拒绝了)

补充

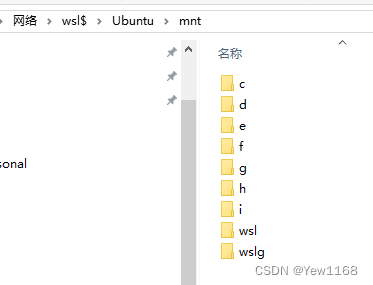

1.windows访问wsl文件

\\wsl$

- 1

查看文件

2. wsl访问windows

lwsl文件系统mnt已挂载windows盘符,不过需要在linux 里(terminal)访问,使用cp复制等。

3. 使用ip网络传输文件

#wsl terminal

#查看IP地址

ip addr

# 复制windows文件至wsl

scp [-r] file/dir hostname@ip_addr:/home/

# windows terminal

scp [-r] hostname@ip_addr:/home/ D:\rev

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

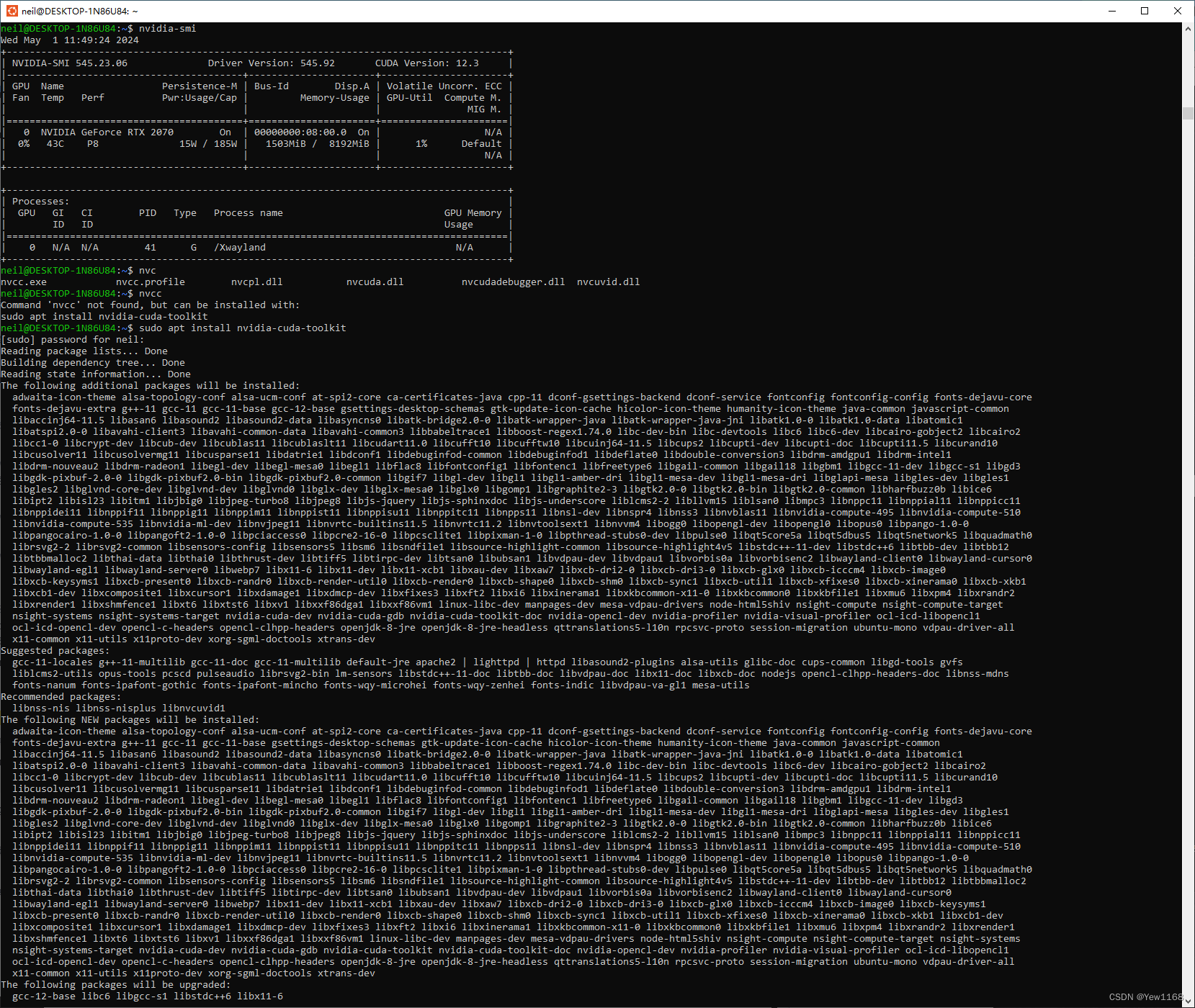

- wsl nvidia cuda

似乎默认能直接访问gpu,但cuda还需安装nvidia-cuda-toolkit

5.模型后缀

Instruct is fine-tuned for chat/dialogue use cases.

Example: ollama run llama3 / ollama run llama3:70b

Pre-trained is the base model.

Example: ollama run llama3:text / ollama run llama3:70b-text

声明:本文内容由网友自发贡献,转载请注明出处:【wpsshop】

推荐阅读

相关标签