- 1IOS自动化测试环境搭建(Python & Java)_python ios 自动化测试

- 2大模型时代,目标检测任务会走向何方?

- 3SpringBoot-03 | SpringBoot自动配置_springboot3.0外部自动配置类

- 4312. 戳气球(区间dp)_打气球区间dp

- 5IT入门知识第七部分《移动开发》(7/10)

- 6苹果系统macOS 中安装 StableDiffusionWebUI 的终极指南_mac stable-diffusion-webui

- 7自动化测试基础——Pytest测试框架_pytest框架

- 8html 引入vue Element ui 的方式_vue 开发实战二十一:html 项目中引入 elementui 的实现

- 9Qwen2大语言模型微调、导出、部署实践

- 108254初始化编程例题

基于视觉的机器人抓取——从物体定位、物体姿态估计到平行抓取器抓取估计——综述_如何根据物品的6d姿态进行抓取

赞

踩

综述

本文对基于视觉的机器人抓取进行了全面的综述。我们总结了基于视觉的机器人抓取过程中的三个关键任务,即物体定位、物体姿态估计和抓取估计。详细地说,对象定位任务包括无分类的对象定位、对象检测和对象实例分割。此任务提供输入数据中目标对象的区域。物体姿态估计任务主要是对6D物体姿态进行估计,包括基于对应关系的方法、基于模板的方法和基于投票的方法,为已知物体提供抓取姿态的生成。抓握估计任务包括2D平面抓握方法和6DoF抓握方法,其中前者被约束为从一个方向抓握。这三种任务可以实现不同组合的机器人抓取。许多物体姿态估计方法不需要进行物体定位,而是联合进行物体定位和物体姿态估计。许多抓取估计方法不需要对象定位和对象姿态估计,而是以端到端的方式进行抓取估计。本文详细回顾了基于RGB-D图像输入的传统方法和最新的基于深度学习的方法。还总结了相关数据集以及最先进方法之间的比较。此外,还指出了基于视觉的机器人抓取的挑战以及应对这些挑战的未来方向。

1.引言

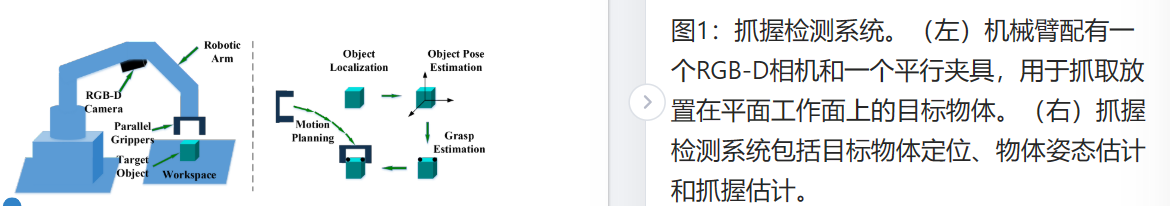

智能机器人有望感知环境并与之互动。在基本能力中,掌握能力是最基本和重要的,因为它将为社会带来巨大的力量[Sanchez et al.,2018]。例如,工业机器人可以完成人工费力的拾取和放置任务,家用机器人可以帮助残疾人或老年人完成日常抓握任务。赋予机器人感知能力一直是计算机视觉和机器人学科的一个长期目标。机器人抓取虽然意义重大,但长期以来一直在研究中。机器人抓取系统[Kumra和Kanan,2017]被认为由以下子系统组成:抓取检测系统、抓取规划系统和控制系统。其中,抓握检测系统是关键的切入点,如图1所示。抓握计划系统和控制系统与运动和自动化学科更相关,在本次调查中,我们只关注抓握检测系统。

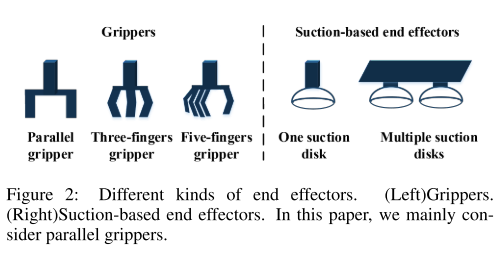

机械臂和末端执行器是抓握检测系统的重要组成部分。生产了各种5-7 DoF机械臂,以确保足够的灵活性,并将其安装在基座或类人机器人上。不同类型的末端执行器,如夹具和吸盘,可以实现物体拾取任务,如图2所示。大多数方法都关注平行夹具[Mahler et al.,2017;Zeng et al.,2017b],这是一个相对简单的情况。随着学术界的斗争,灵巧的抓握器[Liu et al.,2019b;Fan和Tomizuka,2019;Akkaya et al.,2019]被研究用于完成复杂的抓握任务。在本文中,我们只讨论夹具,因为基于吸力的末端执行器相对简单,并且在抓取复杂物体时受到限制。此外,我们还集中讨论了使用平行夹具的方法,因为这是研究最广泛的方法。

抓取目标物体的基本信息是相机坐标中的6D抓取器姿态,其中包含arXiv:1905.06658v4[cs.RO]2020年10月26日3D抓取器位置和执行抓取的3D抓取器方向。针对不同的抓取方式,6D抓取器姿态的估计各不相同,可分为2D平面抓取和6DoF抓取。2D平面抓取意味着目标对象位于平面工作空间上,并且抓取受到一个方向的约束。在这种情况下,夹具的高度是固定的,夹具的方向垂直于一个平面。因此,基本信息从6D简化为3D,即2D平面内位置和1D旋转角度。在早期不容易捕捉深度信息的情况下,主要研究二维平面抓取。最常用的场景是在工厂中抓取机器部件。评估抓取接触点是否能够承受力闭合[Chen和Burdick,1993]。随着深度学习的发展,许多方法将定向矩形作为抓取配置,这可能得益于成熟的二维检测框架。从那时起,二维平面抓取的能力大大增强,待抓取的目标对象从已知对象扩展到新对象。提出了大量通过评估定向矩形的方法[Jiang et al.,2011;Lenz et al.,2015;Pinto和Gupta,2016;Mahler et al.,2017;Park和Chun,2018;Redmon和Angelova,2015;张等人,2017;Kumra和Kanan,2017;Chu et al.,2018;Park等人,2018;Zhou et al.,2018]。此外,近年来还提出了一些基于深度学习的抓取接触点评估方法[Zeng et al.,2018;Cai et al.,2019;Morrison et al.,2018]。

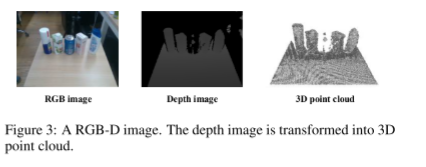

6DoF抓取意味着抓取器可以在三维空间中从不同角度抓取物体,而关键的6D抓取器姿势无法简化。早期,分析方法被用来分析三维数据的几何结构,并根据力闭合找到适合抓握的点。Sahbani等人[Sahbani等人,2012]概述了3D物体抓取算法,其中大多数算法处理完整的形状。随着微软Kinect、英特尔RealSense等传感器设备的发展,研究人员可以轻松获取目标物体的深度信息,现代抓取系统配备了RGB-D传感器,如图3所示。利用相机的固有参数可以很容易地将深度图像提升为三维点云,基于深度图像的6DoF抓取成为研究热点。在6DoF抓取方法中,大多数都是针对可以预先计算抓取的已知物体,从而将该问题转化为6D物体姿态估计问题[Wang et al.,2019b;Zhu et al.,2020;Yu等人,2020;He等人,2020]。随着深度学习的发展,许多方法[ten Pas等人,2017;Liang等人,2019a;Mousavian等人,2019;Qin等人,2020;赵等人,2020a]展示了处理新颖物体的强大能力。二维平面抓取和6DoF抓取都包含常见的任务,即物体定位、物体姿态估计和抓取估计。

为了计算6D抓取器姿态,首先要做的是定位目标物体。针对目标定位,存在三种不同的情况,即无分类的目标定位、目标检测和目标实例分割。不分类的对象定位是指在不对其类别进行分类的情况下获得目标对象的区域。存在这样的情况,即可以在不知道其类别的情况下抓住目标对象。对象检测是指检测目标对象的区域并对其类别进行分类。这提供了对多个候选对象中的特定对象的抓取。对象实例分割是指检测某一类的像素级或点级实例对象。这为姿态估计和抓取估计提供了精细的信息。早期的方法假设要抓取的对象被放置在背景简单的干净环境中,从而简化了对象定位任务,而在相对复杂的环境中,它们的能力相当有限。传统的目标检测方法利用机器学习方法来训练基于手工制作的2D描述符的分类器。然而,由于手工制作的描述符的限制,这些分类器显示出有限的性能。随着深度学习,2D检测和2D实例分割能力大大提高,从而在更复杂的环境中提供对象检测。目前的机器人抓取方法大多针对已知物体,估计物体姿态是成功抓取的最准确、最简单的方法。在计算6D对象姿态方面存在各种方法,从2D输入到3D输入,从传统方法到深度学习方法,从有纹理的对象到无纹理或遮挡的对象。在本文中,我们将这些方法分为基于对应关系的方法、基于模板的方法和基于投票的方法,其中只有特征点、整个输入和每个元单元参与计算6D对象姿态。早期的方法通过进行部分配准来解决3D域中的这个问题。随着深度学习的发展,只使用RGB图像的方法可以提供相对高精度的6D物体姿态,这大大提高了抓取能力。

当我们有定位的目标对象时,进行抓取估计。针对二维平面抓取,将抓取方法分为抓取接触点的评估方法和定向矩形的评估方法。针对6DoF抓取,将方法分为基于局部点云的方法和基于完全形状的方法。基于局部点云的方法意味着我们没有目标对象的相同3D模型。在这种情况下,存在两种方法,即估计候选抓取的抓取质量的方法和从现有抓取转移抓取的方法。基于完整形状的方法是指对完整形状进行抓取估计。当目标物体已知时,可以计算6D物体姿态。当目标形状未知时,可以从单视点云中重建目标形状,并对重建的完整三维形状进行抓取估计。随着上述方面的共同发展,可以抓取的对象的种类、抓取的鲁棒性和抓取场景的可承受复杂性都有了很大的提高,这在工业和国内应用中提供了更多的应用。针对上述任务,已有一些工作[Sahbani et al.,2012;Bohg et al.,2014;Caldera et al.,2018]专注于一项或几项任务,但仍缺乏对这些任务的全面介绍。本文对这些任务进行了详细的回顾,这些任务的分类如图所示。4。据我们所知,这是第一篇综述,广泛总结了基于视觉的机器人抓取的进展,并预示着新的方向。我们相信,这一贡献将成为机器人社区的一个有见地的参考。

本文的其余部分安排如下。第2节回顾了对象定位的方法。第3节回顾了6D物体姿态估计的方法。第4节回顾了抓取估计的方法。各节还审查了相关数据集、评估指标和比较。最后,第5节总结了挑战和未来方向。

2.物体定位

大多数机器人抓取方法首先需要目标物体在输入数据中的位置。这涉及三种不同的情况:没有分类的对象定位、对象检测和对象实例分割。没有分类的对象定位只输出目标对象的潜在区域,而不知道它们的类别。对象检测提供了目标对象及其类别的边界框。对象实例分割进一步提供目标对象的像素级或点级区域及其类别。

2.1没有分类的物体定位

在这种情况下,任务是在不知道目标物体类别的情况下找到目标物体的潜在位置。有两种情况:如果知道目标对象的具体形状,可以拟合基本体来获得位置。如果不能保证目标物体的形状,可以进行显著物体检测(SOD)来找到目标物体的显著区域。基于2D或3D输入,表1中总结了这些方法。

无分类的二维定位:这种方法处理二维图像输入,通常是RGB图像。根据物体的轮廓形状是否已知,方法可分为形状基元拟合方法和显著物体检测方法。无分类二维物体定位的典型功能流程图如图5所示。

拟合2D形状基元:目标对象的形状可以是日食、多边形或矩形,这些形状可以被视为形状基元。通过拟合方法,可以定位目标物体。这类方法的一般过程通常包括封闭轮廓提取和基元拟合。OpenCV中集成了许多用于基元拟合的算法[Bradski和Kaehler,2008],如拟合椭圆[Fitzgibbon et al.,1996]和拟合多边形[DDouglas和Peucker,1973]。这种方法通常用于二维平面机器人抓取任务,从固定角度观察物体,并用一些已知的形状约束目标物体。

二维显著物体检测:与形状基元相比,显著物体区域可以用任意形状表示。2D显著对象检测(SOD)旨在定位和分割给定图像中最具视觉特征的对象区域,这更像是一项没有对象分类的分割任务。非深度学习SOD方法利用低级特征表示[Jiang et al.,2013;Zhu et al.,2014;Peng et al.,2016]或依赖于某些启发式方法,如颜色对比[Cheng et al.,2014],背景先验[Wei et al.,2012]。其他一些方法进行过分割过程,生成区域[Shi et al.,2015]、超像素[Yang et al.,2013;Wang et al.,2016]或对象建议[Guo et al.,2017b],以辅助上述方法。自2015年以来,基于深度学习的SOD方法已显示出优于传统解决方案的性能。通常,它们可以分为三大类,即基于多层感知器(MLP)的方法、基于全卷积网络(FCN)的方法和基于胶囊的方法。基于MLP的方法通常提取图像的每个处理单元的深度特征,以训练用于显著性得分预测的MLP分类器。赵等人[赵等人,2015]提出了一种统一的多上下文深度学习框架,该框架涉及全局上下文和局部上下文,将它们输入到用于前景/背景分类的MLP中,以对图像中对象的显著性进行建模。张等人【张等人,2016】提出了一种显著目标检测系统,该系统为无约束图像输出紧凑的检测窗口,并提出了一个基于最大后验(MAP)的子集优化公式,用于过滤边界框建议。基于MLP的SOD方法不能很好地捕捉关键的空间信息,并且耗时。受全卷积网络(FCN)[Long et al.,2015]的启发,许多方法直接输出整体显著性图。刘和韩【刘和韩,2016】提出了一种称为DHSNet的端到端显著性检测模型,该模型可以同时细化粗显著性图。侯等人[Hou et al.,2017]引入了跳跃层结构的短连接,在每一层提供了丰富的多尺度特征图。刘等人[Liu et al.,2018a]提出了一种称为PiCANet的逐像素上下文注意力网络,该网络为每个像素生成注意力图,每个注意力权重对应于每个上下文位置的上下文相关性。随着胶囊网络的兴起【Hinton et al.,2011;Sabour et al.,2017;Sabour等人,2018】,提出了一些基于胶囊的方法。刘等人[Liu et al.,2019c]将部分-对象关系引入到显著对象检测中,该方法由胶囊网络实现。Qi等人[Qi et al.。2019b]提出了CapSalNet,该方法包括多尺度胶囊注意力模块和用于显著对象检测的多跨层连接。读者可以参考一些调查[Borji et al.,2019;Wang et al.,2019e]来全面理解2D显著对象检测。

讨论:无分类的二维物体定位广泛应用于机器人抓取任务,但处于初级阶段。在工业场景中,机械零部件通常具有固定的形状,其中许多可以通过拟合形状图元进行定位。在其他一些抓取场景中,利用背景先验或颜色契约来获得要抓取的显著对象。在Dexnet 2.0[Mahler et al.,2017]中,目标对象被放置在具有绿色的工作空间上,并且使用颜色背景相减可以很容易地对它们进行分割。

无分类的三维定位:这种方法处理三维点云输入,通常是机器人抓取任务中从单视图深度图像重建的局部点云。根据对象的3D形状是否已知,方法也可以分为拟合3D形状基元的方法和显著3D对象检测的方法。无分类的三维物体定位的典型功能流程图如图6所示。

拟合三维形状基元:目标对象的形状可以是球体、圆柱体或长方体,这些形状可以被视为三维形状图元。存在许多旨在拟合3D形状基元的方法,如基于RANdom-SAmple Consensus(RANSAC)[Fischler和Bolles,1981]的方法、类霍夫投票方法[Rabbani和Van Den-Huevel,2005]以及其他聚类技术[Rusu等人,2009b;Goron等人,2012]。这些方法处理不同类型的输入,并已应用于建模、渲染和动画等领域。针对对象定位和机器人抓取任务,输入数据是部分点云,其中对象是不完整的,目标是找到可以构成3D形状基元之一的点。一些方法[Jiang和Xiao,2013;Khan等人,2015]检测物体边界处的平面并对其进行组装。姜等人[Jiang and Xiao,2013]和Khan等人[Khan et al.,2015]探索了室内场景中的3D结构,并使用长方体估计了它们的几何形状。Rabbani等人[Rabbani和Van Den Heuvel,2005]提出了一种用于点云中圆柱体自动检测的有效Hough变换。一些方法[Rusu等人,2009b;Goron等人,2012]在分割场景后进行原始拟合。Rusu等人[Rasu等人,2009b]使用稳健的形状基本模型与三角形网格的组合来创建最适合机器人抓取的混合形状表面表示。Goron等人[Goron等人,2012]提出了一种在杂乱场景中定位圆柱形和箱形对象的最佳参数的方法。他们通过使用一组内部滤波器和Hough投票,提高了RANSAC拟合在处理杂波时的稳健性。它们提供了与抓取估计相关的稳健结果和模型。读者可以参考调查【Kaiser et al.,2019】了解更多细节。

三维显著对象检测:与二维显著对象检测相比,三维显著对象的检测消耗了多种三维数据,如深度图像和点云。尽管上述2D显著对象检测方法已经实现了优越的性能,但在一些复杂的场景中,它们仍然具有挑战性,其中深度信息可以提供很大的帮助。RGB-D显著性检测方法通常利用来自RGB-D图像的手工制作或基于深度学习的特征,并以不同的方式将其融合。彭等人[Peng et al.,2014]提出了一种简单的融合策略,该策略通过结合深度诱导的显著性来扩展基于RGB的显著性模型。Ren等人[Ren等人,2015a]利用归一化深度先验和全局上下文表面方向先验进行显著对象检测。Qu等人[Qu et al.,2017]训练了一个基于CNN的模型,该模型将不同的低水平显著性线索融合到层次特征中,用于检测RGB-D图像中的显著对象。Chen等人[Chen et al.,2019a;Chen和Li,2019]利用了具有不同融合结构的基于两个流的细胞神经网络模型。Chen和Li[Chen和Li,2018]进一步提出了一种用于RGB-D显著目标检测的渐进互补感知融合网络,该网络比早期融合方法[Hou et al.,2017]和晚期融合方法[Han et al.,2018]更有效。Piao等人[Piao等人,2019]提出了一种用于显著性检测的深度诱导多尺度递归注意力网络(DMRANet),该网络尤其在复杂场景中具有显著的性能。Pang等人[Pang等人,2020]提出了一种分层动态滤波网络(HDFNet)和混合增强损失。李等人[Li et al.,2020]提出了一种跨模态加权(CMW)策略,以鼓励RGB和深度通道之间的全面交互。这些方法显示了RGB-D SOD的显著性能。针对3D点云输入,提出了许多方法来检测完整对象模型的显著性图[Zheng et al.,2019],而我们的目标是从3D场景输入中定位显著对象。Kim等人【Kim等人,2008】描述了一种使用3D点云和RGB图像提取室外场景中显著区域的分割方法。Bhatia等人[Batia等人,2013]提出了一种自上而下的方法来提取室内场景的三维点云中的显著对象/区域。它们首先分离重要的平面区域,并提取残留点云中存在的孤立对象。然后基于轮廓的较高曲率复杂度对每个对象的显著性进行排序。

讨论:三维物体定位广泛应用于机器人抓取任务中,但也处于初级阶段。在Rusu等人[Rasu等人,2009b]和Goron等人[Goron等人,2012]中,拟合3D形状基元已成功应用于机器人抓取任务。在Zapata-Impata等人【Zapata-Impata等人,2019】中,首先使用高度约束过滤掉背景,并通过使用RANSAC拟合平面过滤掉表格【Fischler和Bolles,1981】。对剩余的点云进行聚类,最终实现K对象的云。还有一些其他方法可以通过使用现有的全三维点云拟合背景点来去除背景点。这些方法已成功应用于机器人抓取任务。

2.2物体检测

对象检测的任务是检测某一类对象的实例,可以将其视为定位任务加分类任务。通常,目标物体的形状是未知的,并且很难实现精确的显著区域。因此,规则边界框用于一般的对象定位和分类任务,并且对象检测的输出是具有类标签的边界框。根据是否使用区域建议,方法可分为两阶段方法和一阶段方法。表2中分别总结了针对2D或3D输入的这些方法。

2D对象检测:2D对象检测是指通过计算2D图像中的目标对象的2D边界框和类别来检测它们。二维检测最流行的方法是生成目标建议并进行分类,这是两阶段方法。随着深度学习网络,特别是卷积神经网络的发展,两阶段方法得到了极大的改进。此外,还提出了大量的一级方法,这些方法以高速实现了高精度。二维物体检测的典型功能流程图如图7所示。

两阶段方法:两阶段方法可以称为基于区域提案的方法。大多数传统方法都是利用滑动窗口策略首先获得边界框,然后利用边界框的特征描述进行分类。提出了大量手工制作的全局描述符和局部描述符,如SIFT[Lowe,1999]、FAST[Rosten和Drummond,2005]、SURF[Bay et al.,2006]、ORB[Rublee et al.,2011]等。基于这些描述符,研究人员训练分类器,如神经网络、支持向量机(SVM)或Adaboost,进行2D检测。传统的检测方法存在一些不足。例如,滑动窗口应该是为特定对象预定义的,而手工制作的功能对于强分类器来说不够有代表性。随着深度学习的发展,可以使用深度神经网络计算区域建议。OverFeat[Sermanet et al.,2013]训练了一个全连接层,以预测假设单个对象的定位任务的框坐标。Erhan等人[Erhan等人,2014]和Szegedy等人[Szegedy et al.,2014]从网络生成区域建议,该网络的最后一个完全连接层同时预测多个盒子。此外,深度神经网络比手工制作的特征提取更具代表性的特征,并且使用CNN[Crizhevsky et al.,2012]特征训练分类器大大提高了性能。RCNN[Girshick et al.,2014]使用选择性搜索(SS)[Uijlings et al.,2013]方法生成区域建议,使用CNN提取特征,并使用SVM训练分类器。通过使用Fast R-CNN中的感兴趣区域(ROI)特征向量直接回归边界框来取代这种传统分类器[Girshick,2015]。更快的R-CNN[Ren et al.,2015b]是通过用区域建议网络(RPN)取代SS而进一步提出的,RPN是一种全卷积网络(FCN)[Long et al.,2015],可以专门针对生成检测建议的任务进行端到端训练。其他两阶段方法也采用了这种设计,如R-FCN[Dai et al.,2016c]、FPN[Lin et al.,2017a]。一般来说,两阶段方法实现了更高的精度,而需要更多的计算资源或计算时间。

单阶段方法:单阶段方法也可以称为基于回归的方法。与两阶段方法相比,单阶段流水线跳过单独的对象建议生成,并在一次评估中预测边界框和类分数。YOLO[Remon等人,2016]进行联合网格回归,同时预测多个边界框和这些框的类概率。YOLO不适合小对象,因为它只为每个网格回归两个边界框。SSD[Liu et al.,2016]预测滑动窗口产生的一组固定锚框的类别得分和框偏移。与YOLO相比,SSD更快、更准确。YOLOv2[Remon和Farhadi,2017]还采用滑动窗口锚进行分类和空间位置预测,以实现比YOLO更高的召回率。RetinaNet[Lin et al.,2017b]通过重塑标准交叉熵损失提出了焦点损失函数,以便检测器在训练过程中更多地关注硬的、错误分类的例子。RetinaNet实现了相当的准确性,具有高检测速度的两级检测器。与YOLOv2相比,YOLOv3[Remon和Farhadi,2018]和YOLOv4[Bochkovskiy et al.,2020]通过一系列改进得到了进一步改进,在不牺牲速度的情况下表现出了很大的性能改进,并且在处理小对象时更具鲁棒性。也存在一些不使用锚边界框的无锚方法,如FCOS[Tianet al.,2019b]、CornerNet[Law和Deng,2018]、ExtremeNet[Zhou et al.,2019,b]、CenterNet[Zhouet al.,201,9a;段等人,2019和CentripetalNet[Dong et al.,2020。对这些工作的进一步审查可以参考最近的调查[邹等人,2019;赵等人,2019年;刘等人,2020a;Sultana等人,2020年b]。

讨论:二维物体检测方法广泛应用于二维平面机器人抓取任务中。本部分可参考第4.1节。

三维物体检测:三维物体检测的目的是找到目标物体的模型三维边界框,即找到一个完整的目标物体所占据的三维边界框。三维物体检测在室外场景和室内场景中进行了深入的探索。针对机器人抓取任务,我们可以通过RGB-D数据获得场景的二维和三维信息,并可以使用通用的三维物体检测方法。与2D对象检测任务类似,两阶段方法和一阶段方法都存在。两阶段方法是指基于区域建议的方法,一阶段方法是基于回归的方法。三维物体检测的典型功能流程图如图8所示。

两阶段方法:传统的三维检测方法通常针对具有已知形状的物体。将三维物体检测问题转化为检测和6D物体姿态估计问题。提出了许多手工制作的3D形状描述符,如Spin Images[Johnson,1997]、3D形状上下文[Frome et al.,2004]、FPFH[Rusu et al.,2009a]、CVFH[Aldoma et al.,2011]、SHOT[Salti et al.,2014],它们可以定位对象建议。此外,可以通过局部配准来实现目标物体的精确6D姿态。第3.1节介绍了这一部分。然而,这些方法在一般的3D对象检测任务中面临困难。针对一般的三维物体检测任务,三维区域建议得到了广泛的应用。传统的分类器训练方法,如支持向量机,基于三维形状描述符。提出了滑动形状[Song和Xiao,2014],其在3D空间中滑动3D检测窗口并从3D点云中提取特征以训练示例SVM分类器[Malisiewicz等人,2011]。随着深度学习的发展,可以有效地生成3D区域建议,并且可以使用深度神经网络的特征来回归3D边界框,而不是训练传统的分类器。三维物体建议的生成方法多种多样,大致可分为三种,分别是基于截头体的方法[Qi et al.,2018;Xu et al.,2019;王和贾,2019]、基于全局回归的方法[Song和Xiao,2016;Chen et al.,2017;Liang et al.,2019b]和基于局部回归的方法。基于Frustum的方法使用成熟的2D对象检测器生成对象建议,这是一种简单的方法。Frustum PointNets[Qi et al.,2018]利用2D CNN对象检测器来获得2D区域,并且提升的截头体状3D点云成为3D区域建议。根据基于PointNet的提案中分割点的特征回归模型3D边界框[Qi et al.,2017a]。PointFusion[Xu et al.,2018]利用Faster RCNN[Ren et al.,2015b]首先获得图像裁剪,并对相应图像和原始点云的深度特征进行密集融合,以回归3D边界框。FrustumConvNet[Wang和Jia,2019]还利用从2D区域建议中提取的3D区域建议,并为每个区域建议生成一系列截头体。

基于全局回归的方法从从单个或多个输入中提取的特征表示生成3D区域建议。深度滑动形状[Song和Xiao,2016]提出了第一个3D区域建议网络(RPN),该网络使用3D卷积神经网络(ConvNets)和第一个联合对象识别网络(ORN)来提取3D中的几何特征和2D中的颜色特征,以回归3D边界框。MV3D[Chen et al.,2017]使用鸟瞰图表示点云,并使用2D卷积来生成3D建议。通过多视图数据的ROI池化获得的区域特征被融合以联合预测3D边界框。MMF[Liang et al.,2019b]提出了一种用于二维和三维物体检测的多任务多传感器融合模型,该模型使用多传感器融合特征生成少量高质量的三维检测,并应用ROI特征融合来回归更准确的二维和三维盒子。第A2部分[Shi et al.,2020b]通过将点云提供给编码器-解码器网络来预测对象内的零件位置并生成3D建议。提出了一种RoI感知点云池来聚合每个3D建议的零件信息,并提出了一个零件聚合网络来细化结果。PV-RCNN[Shi et al.,2020a]利用具有3D稀疏卷积的体素CNN[Graham和van der Maaten,2017;Graham et al.,2018]进行特征编码和建议生成,并通过体素集抽象和关键点到网格RoI特征抽象提出了体素到关键点场景编码以进行建议细化。PV-RCNN在户外场景数据集上取得了显著的3D检测性能。基于局部回归的方法意味着生成逐点的3D区域建议。PointRCNN[Shi et al.,2019]从输入点云中提取逐点特征向量,并从通过分割计算的每个前景点生成3D建议。然后进行点云区域池化和规范的三维边界框细化。STD[Yang et al.,2019c]设计了球形锚点和为锚点分配标签的策略,以生成准确的基于点的建议,并提出了PointsPool层来生成用于最终框预测的密集建议特征。VoteNet[Qi et al.,2019a]提出了一种深度hough投票策略,从采样的3D种子点生成3D投票点。对3D投票点进行聚类以获得将被进一步细化的对象提案。MLCVNet[Siee et al.,2020c]提出了考虑对象之间上下文信息的多级上下文投票网。H3DNet[Zhang et al.,2020b]预测了一组混合的几何图元,如三维边界框的中心、人脸中心和边缘中心,并将三维对象检测公式化为回归和聚合这些几何图元。然后利用匹配和细化模块对对象建议进行分类并对结果进行微调。与仅点云输入的VoteNet[Qi et al.,2019a]相比,ImVoteNet[Chi et al.,2020]从2D图像中额外提取几何和语义特征,并将2D特征融合到3D检测流水线中,在室内场景数据集上实现了显著的3D检测性能。

单阶段方法:单阶段方法直接预测类概率,并使用单阶段网络回归对象的三维阿莫尔边界框。这些方法不需要区域建议生成或后处理。VoxelNet[Zhou和Tuzel,2018]将点云划分为等距的3D体素,并将每个体素内的一组点转换为统一的特征表示。通过卷积中间层和区域建议网络,得到了最终的结果。与VoxelNet相比,SECOND[Yan等人,2018b]应用稀疏卷积层[Graham等人,2018]来解析紧凑体素特征。PointPillars[Lang et al.,2019]将点云转换为稀疏伪图像,并通过2D卷积主干将其处理为高级表示。检测头使用来自主干的特征来预测对象的3D边界框。TANet[Liu et al.,2020c]提出了一个三重注意力(TA)模块和一个粗-细回归(CFR)模块,该模块侧重于硬对象的3D检测和对噪声点的鲁棒性。HVNet[Ye et al.,2020]提出了一种混合体素网络,该网络在逐点水平上融合不同尺度的体素特征编码器(VFE),并投影到多个伪图像特征图中。上述方法主要是基于体素的3D单阶段检测器,Yang等人【Yang et al.,2020b】提出了一种称为3DSSD的基于点的3D单阶对象检测器,该检测器包含下采样过程中的融合采样策略、候选生成层和具有3D中心度分配策略的无锚回归头。他们在准确性和效率之间取得了良好的平衡。Point GNN[Shi和Rajkumar,2020]利用点云上的图神经网络,设计了一种具有自动配准机制的图神经网,可以在一次拍摄中检测多个对象。DOPS[Najibi等人,2020]提出了一种利用3D稀疏U-Net的对象检测流水线[Graham和van der Maaten,2017]和图卷积模块。他们的方法可以联合预测物体的三维形状。Associate-3Ddet[Du et al.,2020]学习将从真实场景中提取的特征与来自类概念模型的更具鉴别性的特征相关联。关于3D物体检测的全面综述可以参考调查[Guo et al.,2020]。

讨论:三维物体检测只呈现目标物体的一般形状,不足以进行机器人抓取,而且主要用于自动驾驶领域。然而,所估计的3D边界框可以提供近似的抓取位置并为碰撞检测提供有价值的信息。

2.3对象实例分割

(略)

3.物体位姿估计

在一些2D平面抓取中,目标对象被约束在2D工作空间中并且不堆积,6D对象姿态可以表示为2D位置和平面内旋转角度。这种情况相对简单,并且基于匹配的2D特征点或2D轮廓曲线来很好地解决。在其他2D平面抓取和6DoF抓取场景中,最需要6D物体姿态,这有助于机器人了解目标物体的3D位置和3D方向。6D物体姿态将物体从物体坐标变换为相机坐标。在本节中,我们主要关注6D物体姿态估计,并将6D物体姿势估计分为三种,即基于对应关系、基于模板和基于投票的方法。在对每种方法的回顾中,既回顾了传统方法,也回顾了基于深度学习的方法。

(略)

4.Grasp估计

抓取估计意味着在相机坐标中估计6D抓取器姿态。如前所述,抓握可以分为2D平面抓握和6DoF抓握。对于2D平面抓取,其中抓取从一个方向受到约束,6D抓取器姿势可以简化为3D表示,其包括2D平面内位置和1D旋转角度,因为高度和沿其他轴的旋转是固定的。对于6DoF抓取,抓取器可以从不同角度抓取物体,6D抓取器姿势对于进行抓取至关重要。在本节中,详细介绍了2D平面抓取和6DoF抓取的方法。

4.1二维平面抓取

二维平面抓取的方法可分为评估抓取接触点的方法和评估定向矩形的方法。在2D平面抓取中,抓取接触点可以唯一地定义抓取器的抓取姿态,而不是6DoF抓取中的情况。2D定向的矩形也可以唯一地定义抓取器的抓取姿势。这些方法总结在表9中,典型的功能流程图如图17所示。

评估抓取接触点的方法:这类方法首先对候选抓取接触点进行采样,并使用分析方法或基于深度学习的方法来评估成功抓取的可能性,这是基于分类的方法。机器人抓取的经验方法是在已知某些先验知识(如物体几何形状、物理模型或力分析)的前提下进行的。抓取数据库通常覆盖有限的对象,经验方法在处理未知对象时会遇到困难。Domae等人[Domae等人,2014]提出了一种方法,该方法在单个深度图上估计抓取随机放置在仓中的物体的可抓取性度量。首先提取候选抓取区域,并通过卷积一个接触区域掩码图像和一个碰撞区域掩码图像来计算可抓取性。基于深度学习的方法可以帮助评估候选抓握接触点的抓握质量。Mahler等人[Mahler等人,2017]提出了DexNet 2.0,该2.0计划使用合成点云和分析抓取度量进行稳健抓取。他们首先从深度图像中分割当前兴趣点,并生成多个候选抓取。然后使用抓握质量CNN网络来测量抓握质量,并且将选择具有最高质量的抓握质量作为最终抓握。他们的数据库有超过5万次抓取,抓取质量测量网络取得了相对令人满意的性能。基于深度学习的方法还可以通过估计逐像素的抓握可供性来帮助估计最可能的抓握接触点。机器人可供性[Do et al.,2018b;Ard´on et al.,2019;Chu et al.,2019]通常旨在预测机器人操作的对象部分的可供性,这更像是一个分割问题。然而,存在一些方法[Zeng et al.,2018;Cai et al.,2019]预测关于抓取原始动作的像素可供性。这些方法为每个像素生成抓取质量,并且执行具有最高可供性值的一对点。曾等人[Zeng et al.,2018]提出了一种利用全卷积网络推断四种不同抓握原始动作可供性的密集像素概率图的方法。蔡等人[Cai et al.,2019]提出了一种像素级可供性解释器网络,该网络基于与曾等人类似的全卷积残差网络来学习反足抓取模式。[Zeng et al.,2018]。这两种方法都不分割目标对象并预测每个像素的逐像素可供性图。这是一种在不抽样抓取候选者的情况下直接估计抓取质量的方法。Morrison等人【Morrison et al.,2018】提出了生成抓取卷积神经网络(GGCNN),该网络预测每个像素的抓取质量和姿态。此外,Morrison等人【Morrison et al.,2019】提出了一种多视角拾取(MVP)控制器,该控制器使用主动感知方法基于抓取姿态估计的分布来选择信息丰富的视角。他们利用实时GG-CNN[Morison et al.,2018]进行视觉抓取检测。王等人[Wang等人,2019d]提出了一种全卷积神经网络,该网络将原始输入图像编码为特征,并对这些特征进行解码,以生成每个像素的机器人抓取特性。与通过神经网络生成多个抓取候选者的基于分类的方法不同,它们的逐像素实现通过一个前向传播直接预测多个抓取候选项。

评估定向矩形的方法:姜等人[Jiang et al.,2011]首先提出使用定向矩形来表示抓取器配置,他们使用了两步程序,该程序首先使用计算速度快的某些特征来修剪搜索空间,然后使用高级特征来准确选择好的抓取。Vohra等人[Vohra et al.,2019]提出了一种抓取估计策略,该策略估计点云中的对象轮廓,并预测图像平面中的抓取姿态以及对象骨架。估计每个骨架点的抓取矩形,并使用与抓取矩形部分和对象质心对应的点云数据来确定最终的抓取矩形。他们的方法很简单,不需要掌握配置采样步骤。针对基于定向矩形的抓取配置,深度学习方法逐渐以三种不同的方式应用,即基于分类的方法、基于回归的方法和基于检测的方法。这些方法中的大多数都使用了机器人抓取的五维表示[Lenz等人,2015],机器人抓取是具有位置、方向和大小的矩形:(x,y,θ,h,w)。

基于分类的方法训练分类器来评估候选掌握,并将选择得分最高的一个。Lenz等人[Lenz等人,2015]是第一个将深度学习方法应用于机器人抓取的人。他们提出了一个具有两个深度网络的两步级联系统,其中第一个网络的顶部检测结果由第二个网络重新评估。第一个网络生成一小组定向矩形作为候选者抓取,这些矩形将与轴对齐。第二个网络使用从彩色图像、深度图像和表面法线中提取的特征对这些候选者进行排序。选择排名靠前的矩形并执行相应的抓取。Pinto和Gupta[Pinto和Gupta,2016]通过对图像块进行采样并预测抓取角度来预测抓取位置。他们训练了一个基于CNN的分类器,以估计给定输入图像块的不同抓取方向的抓取可能性。Park和Chun[Park和Chun,2018]提出了一种基于分类的多阶段空间变换网络(STN)机器人抓取检测方法。他们的方法允许对中间结果进行部分观察,例如对许多抓握配置候选者的抓握位置和方向。基于分类的方法的过程是直接的,并且准确度相对较高。然而,这些方法往往相当缓慢。基于回归的方法训练模型,以直接产生位置和方向的掌握参数,因为统一网络的性能将优于两个级联系统[Lenz等人,2015]。Redmon和Angelova[Remon和Angelova,2015]提出了一种更大的神经网络,该网络在不使用标准滑动窗口或区域建议技术的情况下执行单阶段回归以获得可抓取的边界框。张等人【张等人,2017】利用了一种结合RGB特征和深度特征的多模式融合架构来提高抓取检测精度。Kumra和Kanan[Cumra和Kanan,2017]利用了像ResNet[He et al.,2016]这样的深度神经网络,并进一步提高了抓取检测的性能。Kumra等人[Kumra et al.,2019]提出了一种新的生成残差卷积神经网络(GR ConvNet)模型,该模型可以从n通道图像输入生成稳健的对足抓取。一些方法不是全局回归抓取参数,而是使用基于ROI(感兴趣区域)或逐像素的方式。张等人【张等人,2018b】利用输入图像中的ROI,并基于ROI特征回归抓取参数。

基于检测的方法利用参考锚盒,参考锚盒用于一些基于深度学习的对象检测算法[Ren et al.,2015b;Liu et al.,2016;Redmon et al.,2016],以帮助生成和评估候选抓取。有了关于预期把握大小的先验知识,回归问题得到了简化[Depierre等人,2020]。郭等人[Guo et al.,2017a]提出了一种将视觉和触觉相结合的混合深度架构。他们引入了轴线对齐的参考框。他们的网络产生一个质量分数和方向,作为离散角度值之间的分类。Chu等人[Chu et al.,2018]提出了一种架构,该架构预测多个候选抓取而不是单个输出,并将方向回归转换为分类任务。方位分类包含质量分数,因此他们的网络预测把握回归值和离散方位分类分数。Park等人[Park等人,2018]提出了一种旋转集成模块(REM),用于使用旋转网络权重的卷积进行机器人抓取检测。周等人[Zhou et al.,2018]设计了一种定向锚盒机制来提高抓取检测的准确性,并采用端到端全卷积神经网络。他们只使用一个具有多个方向的锚盒,而不是多个尺度或长宽比[Guo et al.,2017a;Chu et al.,2018]进行参考抓取,并预测了每个定向参考盒的五个回归值和一个抓取质量分数。Depierre等人[Depierre et al.,2020]通过在回归预测和得分评估之间添加直接相关性,进一步扩展了Zhou等人[Zhou et al.,2018]。他们提出了一种新的DNN结构,该结构具有评估给定位置的可抓取性的记分器,并引入了一种将抓取参数的回归与可抓取性得分相关的新损失函数。

还针对杂乱的场景提出了一些其他方法,在这些场景中,机器人需要知道一个物体是否在物体堆中的另一个物体上才能成功抓取。郭等人[Guo et al.,2016a]提出了一种共享卷积神经网络来进行物体发现和抓取检测。张等人【张等人,2018a】提出了一种多任务卷积机器人抓取网络,以解决抓取检测和物体检测与物体堆中关系推理相结合的问题。张等人的方法[Zhang et al.,2018a]由几个深度神经网络组成,分别负责生成局部特征图、抓取检测、对象检测和关系推理。相比之下,Park等人[Park等人,2019a]提出了一种单一的多任务深度神经网络,该网络通过简单的后处理产生关于抓取检测、物体检测和物体之间关系推理的信息。

比较和讨论:本节评估了二维平面抓取的方法,其中包括数据集、评估指标和最近方法的比较。

数据集和评估指标存在一些用于2D平面抓取的数据集,如表10所示。其中,Cornell-Grasping数据集[Jiang et al.,2011]是使用最广泛的数据集。此外,数据集具有按图像划分和按对象划分。逐图像分割随机分割图像,用于测试该方法在多大程度上可以推广到以前看到的对象的新位置。按对象分割将同一对象的所有图像放入相同的交叉验证分割中,并用于测试该方法在多大程度上推广到新对象。针对基于点的抓取和基于定向矩形的抓取[Jiang et al.,2011],存在两种评估抓取检测性能的指标:点指标和矩形指标。前者将预测的抓取中心与地面实况抓取中心之间的距离作为阈值进行评估。它在确定距离阈值方面有困难,并且不考虑抓取角度。如果抓取角度在30以内,后一种度量标准认为抓取是正确的◦ 并且预测的抓取A和地面实况B的Jaccard指数J(A,B)=|AåB|/|AŞB|大于25%。

Comparisons:表11中对广泛使用的Cornell-Grasping数据集上的定向矩形的评估方法进行了比较[Jiang et al.,2011]。从表中可以看出,最先进的方法在该数据集上实现了非常高的精度。最近的工作[Depierre et al.,2020]开始在Jacquard Gravity数据集[Depierreet al.,2018]上进行实验,因为它有更多的图像,抓握也更多样。

4.2 6DoF Grasp

6DoF抓取的方法可分为基于局部点云的方法和基于完整形状的方法。表12中总结了这些方法。

基于局部点云的方法:这类方法可以分为两种。第一种方法估计候选抓取的抓取质量,第二种方法从现有抓取转移抓取。基于局部点云的方法的典型功能流程图如图18所示。

候选抓握质量的估计方法:这种方法是指仅通过分析输入的局部点云来估计6DoF抓握姿态。大多数这类方法[Bohg和Kragic,2010;Pas和Platt,2015;Zapata-Impata et al.,2019;ten-Pas et al.,2017;Liang et al.,2019a]首先对大量候选抓握进行采样,然后利用各种方法来评估抓握质量,这是一种基于分类的方式。而一些新颖的方法[Qin et al.,2020;赵et al.,2020a;Ni et al.,20;Mousavian et al.。2019]以单镜头的方式隐式和直接预测6DoF抓取姿势来估计抓取质量,这是一种基于回归的方式。

Bohg和Kragic[Bohg和Kragic,2010]应用形状上下文的概念[Bongnie et al.,2002]来提高抓握点分类的性能。他们使用了监督学习方法,并使用标记的合成图像来训练分类器。Pas等人[Pas和Platt,2015]首先使用了一个几何必要条件来对一大组高质量抓取假设进行采样,这些假设将使用对足抓取的概念进行分类。Zapata-Impata等人【Zapata-Impata等人,2019】提出了一种在给定未知物体的部分单视点云的情况下找到最佳抓握点对的方法。他们定义了用于评估一对接触点的排名指标的改进版本[Zapata Impata et al.,2017],该指标由使用中的机械手的形态参数化。

3D数据具有不同的表示,如多视图图像、体素网格或点云,并且每个表示都可以用相应的深度神经网络进行处理。这些不同类型的神经网络已经应用于机器人抓取任务。GPD[10n-Pas等人,2017]首先生成对感兴趣区域(ROI)的候选把握。这些候选抓取然后被编码到堆叠的多通道图像中。最后使用四层卷积神经网络对每个候选进行评估以获得分数。Lou等人[Lou等人,2019]提出了一种算法,该算法首先在整个3D空间上均匀采样以生成候选抓取,使用3D CNN预测抓取稳定性,以及使用候选抓取姿势预测抓取可达性,并获得最终抓取成功概率。PointnetGPD[Liang et al.,2019a]对候选抓握进行随机采样,并使用3D深度神经网络PointNet[Qi et al.,2017a]通过直接点云分析评估抓握质量。在生成训练数据集的过程中,通过结合力闭合度量和抓握扳手空间(GWS)分析来评估抓握质量[Kirkpatrick等人,1992]。Mousavian等人[Moussavian et al.,2019]提出了一种称为6-DoF-GraspNet的算法,该算法使用变分自动编码器对抓取建议进行采样,并使用抓取评估器模型对采样的抓取进行细化。Pointnet[Qi et al.,2017b]用于生成和评估抓取。Murali等人[Murali等人,2019]通过引入以抓取器信息和场景的原始点云为条件的学习碰撞检查器,进一步改进了6-DoF-GraspNet,这在杂乱的场景中提供了更高的成功率。

Qin等人[Qin et al.,2020]提出了一种称为S4G的算法,该算法利用Pointnet[Qi et al.,2017b]用合成数据训练的单次抓取建议网络,高效预测阿莫尔抓取建议。每个抓取建议都用稳健性得分进行进一步评估。S4G的核心新颖见解是,他们学会了通过回归提出可能的把握,而不是使用类似滑动窗口的风格。S4G直接生成抓取建议,6-DoF-GraspNet使用编解码方式。Ni等人[Ni et al.,2020]提出了Pointnet抓取,这也是一种直接预测所有抓取的姿势、类别和分数的端到端方法。此外,赵等人【赵等人,2020a】提出了一种称为REGNet的端到端单次抓取检测网络,该网络将一个单视点云作为并行抓取器的输入。该网络包括三个阶段,即选择具有高把握置信度的正点的分数网络(SN)、对所选正点生成一组把握建议的把握区域网络(GRN)和基于局部把握特征对检测到的把握进行细化的细化网络(RN)。REGNet是3D空间中最先进的抓取检测方法,其性能优于GPD[ten-Pas et al.,2017]、PointnetGPD[Liang et al.,2019a]和S4G[Qin et al.,2020]等几种方法。方等人【方等人,2020】提出了一个名为GraspNet-1Billion的大规模抓握姿势检测数据集,该数据集包含97280幅超过十亿个抓握姿势的RGB-D图像。他们还提出了一种端到端抓取姿态预测网络,该网络以解耦的方式学习前进方向和操作参数。

从现有点云转移把握的方法:这种方法从现有点云中转移把握,意味着如果我们知道它们来自一个类别,就可以从观察到的单视点云到现有的完整点云找到对应关系。在大多数情况下,目标对象与现有数据库中的对象并不完全相同。如果一个对象来自数据库中涉及的类,则将其视为类似对象。在定位目标对象之后,可以利用基于对应关系的方法将抓握点从相似且完整的3D对象转移到当前局部视图对象。这些方法通过观察物体而不估计其6D姿态来学习抓取,因为当前目标物体与数据库中的物体并不完全相同。基于分类法、分割等,使用不同类型的方法来寻找对应关系。Andrew等人[Miller et al.,2003]提出了一种基于分类法的方法,将对象分类为每个规范抓取都应该抓取的类别。Nikandrova和Kyrki[Nikandrova and Kyrki,2015]提出了一种概率方法,用于特定任务的稳定抓取类别内形状变化的物体。考虑到概率环境中的形状不确定性,最优抓取被认为是最有可能与任务兼容和稳定的抓取。他们的方法需要新对象的部分模型,并且在训练过程中很少使用模型和示例掌握。Vahrenkamp等人[Vahrenkamp等人,2016]提出了一种基于零件的抓取规划方法,以生成适用于多个熟悉对象的抓取。根据物体模型的形状和体积信息对其进行分割,并用语义和抓取信息对物体部分进行标记。提出了一种抓取可转移性度量,以评估成功的计划抓取如何应用于同一对象类别的新对象实例。Tian等人[Tianet al.,2019a]提出了一种将抓取配置从先前的示例对象转移到新对象的方法,该方法假设新对象和示例对象具有相同的拓扑结构和相似的形状。他们考虑几何和语义形状特征对对象进行3D分割,使用主动学习计算示例对象的每个部分的抓取空间,并在模型部分和新对象的相应抓取之间建立双射接触映射。Florence等人[Florence等人,2018]提出了密集对象网,该网络建立在自监督密集描述符学习的基础上,并将密集描述符作为机器人操作的表示。他们可以在可能变形的配置中抓取对象上的特定点,在混乱中抓取具有实例特异性的对象,或者在类中的对象之间转移特定的抓取。Patten等人[Patten等人,2020]提出了DGCM-Net,这是一种用于基于增量经验的机器人抓取的密集几何对应匹配网络。他们应用度量学习对特征空间中附近具有相似几何结构的对象进行编码,并通过最近邻居搜索检索看不见对象的相关经验。DGCM-Net还使用与视图相关的归一化对象坐标空间来重建3D-3D相关性,以将抓取配置从检索到的样本转换为看不见的对象。他们的方法可以通过将抓取选择引导到与对象功能使用相关的对象部分来扩展到语义抓取。

比较与讨论评:估候选抓握质量的方法因其是获得6D抓握姿势的直接方式而备受关注。针对6DoF抓取,二维平面抓取的评价指标并不适用。常用的度量是REGNet提出的有效抓取率(VGR)[赵等人,2020a]。VGR定义为对足和无碰撞抓取与所有抓取的商。通常用于评估的抓取数据集是YCB视频[Xiang et al.,2018]数据集。与最近方法的比较如表13所示。

从现有抓取物转移抓取物的方法在高级机器人操作任务中具有潜在用途。不仅掌握可以转移,操作技能也可以转移。许多从演示中学习掌握的方法[Berscheid et al.,2019;Yang et al.,2019b]通常使用这类方法

基于完整形状的方法:基于局部点云的方法适用于未知对象,因为这些方法没有相同的3D模型可供使用。针对已知物体,可以估计其6D姿态,并且可以将在完整的3D形状上估计的6DoF抓取姿态从物体坐标转换为相机坐标。在另一个视角中,相机坐标下的3D完整物体形状也可以从观察到的单视点云中完成。并且可以基于在相机坐标中完成的3D物体形状来估计6DoF抓取姿势。我们认为这两种方法是基于完全形状的方法,因为6DoF抓取姿态是基于完全物体形状估计的。基于完整形状的6DoF抓取方法的典型功能流程图如图19所示。

估计6D物体姿态的方法如果目标物体如第3节所述,并且6DoF抓取姿态可以通过离线预计算或在线生成获得,则可以根据RGB-D数据准确估计6D对象姿态。这是用于抓取系统的最常用的方法。如果数据库中存在6DoF抓取姿势,则可以从知识库中检索当前6DoF抓握姿势,或者通过与现有抓握进行比较对其进行采样和排序来获得当前6DoF抓握姿势。如果数据库中不存在6DoF抓取姿态,则使用分析方法来计算抓取姿态。分析方法在确定抓取量时考虑运动学和动力学公式[Sahbani等人,2012]。力闭合是完成抓取任务的主要条件之一,三维物体的力闭合抓取合成方法很多。其中,多面体对象首先被处理,因为它们由有限数量的平面组成。将力闭合条件简化为面法线之间角度的测试[Nuyen,1987]或使用线性模型推导抓握特征的分析公式[Ponce等人,1993]。为了处理通常形状更复杂的常用物体,提出了观察不同接触点的方法[Ding et al.,2001]。这些方法试图在3D物体表面上找到接触点,以确保力闭合,并通过根据预定义的抓取质量标准最小化目标能量函数来计算最佳抓取[Mirtich和Canny,1994]。然而,搜索抓取解空间是一个相当耗时的复杂问题。然后提出了一些启发式技术,通过根据预定义的过程生成一组抓取候选者[Borst等人,2003],或者通过定义一组规则来生成起始位置[Miller等人,2003].来减少搜索空间。一些机器人抓取模拟器,如GraspIt!【Miller和Allen,2004年】,协助生成最佳抓握姿势,以进行成功抓握。Andrew和Peter[Miller和Allen,2004]提出了GraspIt!,其是用于机器人抓取的通用模拟器。抓住它!支持加载任意几何体的对象和障碍物,以填充完整的模拟世界。它允许用户交互式地操纵机器人或物体,并在它们之间建立联系。Xue等人【Xue et al.,2009】实现了基于GraspIt!计划高质量的抓取。Le´on等人[Le´on et al.,2010]介绍了OpenGRASP,一个用于模拟抓握和灵巧操作的工具包。它提供了一个整体环境,可以处理与机器人抓取相关的各种因素。这些方法成功地掌握了情况,调查中可以找到详细的综述[Sahbani等人,2012]。

传统的和基于深度学习的6D物体姿态估计算法都被用于辅助机器人抓取任务。亚马逊采摘挑战中提出的大多数方法[Zeng et al.,2017b]首先利用了通过部分配准估计的6D姿态。曾等人[Zeng et al.,2017b]提出了一种方法,该方法使用全卷积神经网络对场景的多个视图进行分割和标记,然后将预扫描的3D对象模型与分割结果进行拟合,以获得6D对象姿态。此外,Billings和Johnson Roberson[Billings和JohnsonRoberson,2018]提出了一种使用卷积神经网络(CNN)管道联合完成物体姿态估计和抓握点选择的方法。Wong等人[Wong et al.,2017]提出了一种将基于RGB的对象分割和基于深度图像的部分配准相结合的方法,以获得目标对象的姿态。他们提出了一种新的模型配准质量评分指标,并进行了多假设配准,实现了1cm位置误差和<5的精确姿态估计◦ 角度误差。使用这种精确的6D物体姿势,以高的成功率进行抓握。一些基于深度学习的6D物体姿态估计方法,如DenseFusion[Wang et al.,2019b],也说明了在执行实际机器人抓取任务时的高成功率。

进行形状补全的方法:也存在一种方法,对局部点云进行三维形状补全,然后估计抓取量。3D形状完成提供了来自部分观测的物体的完整几何形状,并且在完成的形状上估计6DoF抓握姿势更精确。这类方法中的大多数都是从局部点云中估计物体几何结构[Varley等人,2017;Lundell等人,2019;Van der Merwe等人,2019年;Watkins-Valls等人,2019,Tosun等人,2020],以及其他一些方法[Wang等人,2018a;Yan等人,2018b;Yan et al.,2019;Gao和Tedrake,2019;Sajjan等人,2019]利用RGB-D图像。其中许多[Wang et al.,2018a;Watkins-Valls et al.,2019]还将触觉信息结合起来进行更好的预测。

Varley等人【Varley等人,2017】提出了一种通过形状完成实现机器人抓取规划的架构。他们利用3D卷积神经网络(CNN)来完成形状,并为不需要抓握的物体创建了一个快速网格,为需要抓握物体创建了详细的网格。抓取量最终在GraspIt中的重建网格上进行估计![Miller和Allen,2004]并且执行具有最高质量的抓握。Lundell等人[Londell等人,2019]提出了一种形状完成DNN架构来捕获形状不确定性,以及一种利用形状不确定性来提出鲁棒抓取的概率抓取规划方法。Merwe等人[Van der Merwe等人,2019]提出了PointSDF来学习部分观看对象的有符号距离函数隐式曲面,并提出了一种隐式学习几何感知点云编码的抓取成功预测学习架构。Watkins-Valls等人【Watkins-Valls等人,2019】还结合了深度和触觉信息,创建了丰富准确的3D模型,可用于机器人操作任务。他们利用深度和触觉作为输入,并将它们直接输入到模型中,而不是使用触觉信息来细化结果。Tosun等人[Tosun等人,2020]利用抓取建议网络和学习的三维形状重建网络,利用第二网络的三维重建结果对第一网络生成的候选抓取进行细化。上述方法主要利用深度数据或点云作为输入。

王等人[Wang et al.,2018a]通过结合视觉和触觉观察,以及从大规模形状库中学习的常见物体形状的先验知识,感知准确的3D物体形状。他们首先应用具有学习形状先验的神经网络从单视图彩色图像中预测物体的3D形状,并使用触觉来细化形状。Yan等人[Yan等人,2018a]提出了一种深度几何感知抓取网络(DGGN),该网络首先从RGB-D输入中学习6DoF抓取。DGGN有一个形状生成网络和一个结果预测网络。Yan等人[Yan et al.,2019]进一步提出了一种自监督形状预测框架,该框架重建全三维点云作为机器人应用的表示。他们首先使用对象检测网络来获得以对象为中心的颜色、深度和遮罩图像,这些图像将用于生成检测对象的3D点云。然后使用抓取评论家网络来预测抓取。Gao和Tedrake[Gao和Tedrake,2019]提出了一种新的混合对象表示,该表示由语义关键点和密集几何体(点云或网格)组成,作为感知模块和运动规划器之间的接口。利用基于学习的关键点检测和形状完成方面的进步,可以从原始传感器输入中感知密集的几何形状和关键点。Sajjan等人[Sajjan等人,2019]提出了ClearGrasp,这是一种深度学习方法,用于从单个RGB-D图像中估计透明物体的精确3D几何结构,用于机器人操作。ClearGrasp使用深度卷积网络来推断曲面法线、透明曲面的遮罩和遮挡边界,这将细化场景中所有透明曲面的初始深度估计。

比较和讨论当精确的3D模型可用时,可以实现6D物体姿态,这提供了对目标物体的抓取生成。然而,当现有的3D模型与目标模型不同时,6D姿态会有很大的偏差,这将导致抓取失败。在这种情况下,我们可以完成局部视点云,并对其进行三角测量,以获得完整的形状。抓取可以在重建的和完整的3D形状上生成。开发了各种抓取模拟工具包,以便于抓取生成。针对6D物体姿态估计方法,存在一些挑战。首先,这种方法高度依赖于对象分割的准确性。然而,训练一个支持广泛对象的网络并不容易。同时,这些方法要求3D对象与注释模型的对象足够相似,从而可以找到对应关系。在通常发生遮挡的杂乱环境中,为对象计算高质量的抓取点也是一项挑战。针对进行形状完成的方法,也存在一些挑战。信息的缺乏,尤其是与相机相反方向的几何形状,极大地影响了完成精度。然而,使用多源数据将是未来的一个方向。

5.挑战和未来方向

本文从目标定位、目标姿态估计和抓取估计三个关键方面综述了基于视觉的机器人抓取的相关工作。这项调查的目的是让读者能够获得一张关于如何在给定初始原始数据的情况下检测成功抓握的全面地图。每一节都介绍了各种细分方法,以及相关的数据集和比较。与现有文献相比,我们对如何实现基于视觉的机器人抓取检测系统进行了端到端的综述。尽管提出了许多智能算法来辅助机器人抓取任务,但在实际应用中仍然存在挑战,如数据采集中的信息不足、训练数据量不足、抓取新物体的普遍性以及抓取透明物体的困难。第一个挑战是数据采集中的信息不足。目前,用于决定抓取的主要输入是来自一个固定位置的一个RGB-D图像,这缺乏向后的信息。当我们没有完整的对象几何体时,很难决定抓取。针对这一挑战,可以采取一些战略。第一种策略是利用多视图数据。更广泛的透视数据要好得多,因为局部视图不足以获得目标对象的全面知识。可以采用基于机械臂姿态的方法[Zeng et al.,2017b;Blomqvist et al.,2020]或slam方法[Dai et al.,2017]来合并多视图数据。也可以明确选择最佳抓取视图,而不是融合多视图数据[Mrison et al.,2019]。第二种是涉及多传感器数据,如触觉信息。存在一些工作[Lee等人,2019;Falco等人,2019年;Hogan等人,2020]已经涉及触觉数据来帮助机器人抓取任务。

第二个挑战是训练数据量不足。如果我们想建立一个足够智能的抓取检测系统,对训练数据的要求是非常大的。开放抓取数据集的数量非常少,而且所涉及的对象大多是实例级的,与我们日常生活中的对象相比太小了。针对这一挑战,可以采取一些战略。第一种策略是利用模拟环境生成虚拟数据[Tremblay et al.,2018]。一旦建立了虚拟抓取环境,就可以通过从各个角度模拟传感器来生成大量的虚拟数据。由于模拟数据与实际数据之间存在差距,因此提出了许多领域自适应方法[Bousmalis等人,2018;Fang等人,2018年;赵等人,2020b]。第二种策略是利用半监督学习方法[Mhajan等人,2020;Yokota等人,2020]来学习掌握和合并未标记的数据。第三种策略是利用自监督学习方法生成6D物体姿态估计的标记数据[Deng et al.,2020]或抓取检测[Szuki et al.,2020]。第三个挑战是把握小说对象的普遍性。除了评估6D物体姿态的方法外,上述抓取估计方法在处理新物体时都具有一定的通用性。但这些方法大多在经过训练的数据集上运行良好,并且对新对象的性能降低。除了提高上述算法的性能外,还可以采用一些策略。第一种策略是利用类别级6D对象姿态估计。大量的工作[Wang et al.,2019c;Park et al.,2020;Wang等人,2019a;Chen et al.,2020a]开始处理类别级对象的6D对象姿态估计,因为在实例级对象上已经实现了高性能。第二种策略是在抓取检测系统中包含更多的语义信息。在各种形状分割方法的帮助下[Yu et al.,2019a;Luo et al.,2020],可以使用对象的部分而不是完整的形状来减少候选抓握点的范围。还可以估计表面材料和重量信息,以获得更精确的抓取检测结果。

第四个挑战在于抓住透明物体。透明物体在我们的日常生活中很普遍,但对于当今的深度传感器来说,捕捉它们的3D信息相当困难。有一些开创性的工作以不同的方式解决了这个问题。GlassLoc[Zhou et al.,2019c]被提出用于使用全光学传感对透明杂波中的透明物体进行抓取姿态检测。KeyPose[Liu等人,2020b]对透明物体进行了多视图3D标记和关键点估计,以估计其6D姿态。ClearGrap[Sajjan et al.,2019]从用于机器人操作的单个RGB-D图像中估计透明物体的精确3D几何形状。这一领域将进一步研究,以使掌握在日常生活中更加准确和稳健。